Modélisation Statistique

n

µ0σ2

0

95%

H0

H1H1=¯

H0

n(X1, . . . , Xn)H0

H1Tn

H00≤α≤1

Tn

Pqα/2≤Tn≤q1−α/2| H0= 1 −α

qα/2q1−α/2α/2 1−α/2

TnH0TnH1

|Tn|P

−→

H1

+∞E[|Tn|]−→

H1

+∞,

Tn

TnR R+

PH0|H0= 1 −αPH0|H0=α.

TnH1

R= ]− ∞, qα/2[∪]q1−α/2,+∞[

A= [qα/2, q1−α/2]Tn

Tn∈ R =⇒Tn

H0Tn

H1R H0

H1

Tn∈ A =⇒TnH0

H0

H0

Tn

H0

H1

n(X1, . . . , Xn)

N(µ, σ2)

µ0

µ=µ0

H0: “µ=µ0”

H1: “µ6=µ0”

Tn=√n¯

Xn−µ0

σ∼

H0N(0,1).

TnH0

N(0,1) H1¯

Xn∼ N(µ1, σ2/n)

µ16=µ0

Tn∼

H1N√n(µ1−µ0)

σ,1

TnH1Tn

−∞ µ0> µ1+∞µ0< µ1

TnH01−α

Tn

1−α

P−u1−α/2≤Tn≤u1−α/2| H0= 1 −α

u1−α/21−α/2N(0,1)

A= [−u1−α/2, u1−α/2].

|Tn| H1

R= ]− ∞,−u1−α/2[∪]u1−α/2,+∞[.

H0: “µ≤µ0”H1: “µ>µ0”

µ=µ0

Tn+∞

µ < µ0Tn−∞ H0

A= ]− ∞, u1−α]

R= ] u1−α,+∞[.

H0

H1

H0: “µ=µ0”H0: “µ≤µ0”

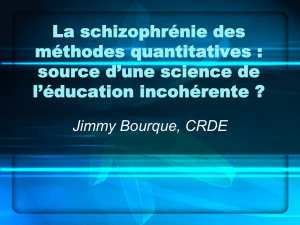

−4 −2 0 2 4

0.0 0.1 0.2 0.3 0.4

Distribution de

Tn sous H0

Divergence de

Tn sous H11− α

α

2

α

2

−4 −2 0 2 4

0.0 0.1 0.2 0.3 0.4

Distribution de

Tn sous H0

Divergence de

Tn sous H1

1− α

α

H0: “µ=µ0”

α/2

H0: “µ≤µ0”

α

α0≤α≤1

Tn

H0

Pqα/2≤Tn≤q1−α/2| H0= 1 −α

qα/2q1−α/2TnH0

A= [qα/2, q1−α/2]

H0H0

1−β β H0

β

H0

H0

α

0.05 βH1α

H0H0

H01−α β

H0α1−β

p

H0

p

p α Tn

H0: “µ=µ0”

Tn∼

H0N(0,1),

p=P|Z| ≥ |Tn| | H0= 2(1 −Φ(|Tn|))

6

6

7

7

8

8

9

9

10

10

11

11

12

12

1

/

12

100%