TABLE DES MATIÈRES

i

TABLE DES MATIÈRES

INTRODUCTION 1

NOTION DE MODÈLE 1

LIMITES DES PRÉDICTIONS D'UN MODÈLE 2

ORIGINES ET ÉVOLUTION DE LA THERMODYNAMIQUE 4

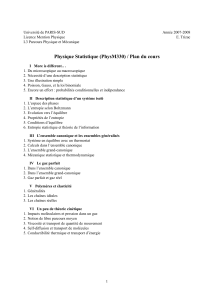

PLAN DU COURS 6

FORCE, TRAVAIL, ÉNERGIE 9

NOTION DE FORCE 9

Les forces décrivent les interactions entre les objets 9

Modèle d'une force 9

Propriété des forces 10

Définition d'une force 10

FORCE ET MOUVEMENT 10

Cinématique 10

Dynamique 11

PRESSION 12

TRAVAIL 13

Exemple : l'allongement d'un ressort 13

PUISSANCE 14

ÉNERGIE 15

Définitions 15

Énergie cinétique 15

Énergie potentielle 16

Énergie mécanique 17

Exemple d'énergie potentielle 17

Principe du minimum d'énergie potentielle 17

Exemple de conservation de l'énergie mécanique 18

FORCES CONSERVATIVES ET DISSIPATIVES 20

Forces dissipatives 20

Forces conservatives 20

EXERCICES 20

TEMPÉRATURE ET CHALEUR 23

NOTION DE TEMPÉRATURE 23

Échelle de Kelvin 24

Interprétation statistique de la température absolue 25

Comparaison socio-économique du modèle du gaz parfait 25

NOTION DE GAZ RÉEL 26

Équation de van der Waals 26

Isothermes d'Andrews, phases liquide et gazeuse (succès du modèle) 27

Phase solide (limite du modèle) 29

Retour aux gaz parfaits 29

Comparaison socio-économique du modèle du gaz réel 30

CHALEUR 31

Modèle classique 31

Calorimétrie 31

CHALEUR SPÉCIFIQUE DES GAZ PARFAITS 32

ii

Chaleur spécifique molaire 32

Chaleur spécfique des gaz parfaits 33

VARIABLES ET ÉQUATION D'ÉTAT D'UN GAZ PARFAIT 33

EXERCICES 34

SYSTÈMES, TRANSFORMATIONS ET ÉCHANGES THERMODYNAMIQUES 37

DÉFINITIONS 37

TRAVAIL EN THERMODYNAMIQUE 38

Définition 38

Premier exemple de transfert d'énergie : l'étirement d'un ressort 38

Second exemple de transfert d'énergie : la compression d'un gaz 40

LA CHALEUR EN THERMODYNAMIQUE 41

Définition 41

Propriétés 41

Analogie du modèle avec une population 42

CLASSFICATION DES TRANSFORMATIONS 44

Transformations réversibles 44

Transformations irréversibles 44

PREMIER PRINCIPE DE LA THERMODYNAMIOUE 45

INTRODUCTION 45

DÉMONSTRATION DE L'EXISTENCE DU PREMIER PRINCIPE 45

Énoncé pour les transformations ouvertes adiabatiques 45

Énoncé pour les transformations fermées (cycles) 46

Énoncé du premier principe pour les transformations ouvertes 47

Énergie interne 48

Mouvement perpétuel de première espèce 49

APPLICATIONS AUX GAZ PARFAITS 49

Énergie interne d'un gaz parfait 49

Relation de Mayer 51

Travail pour une transformation isotherme (réversible) d'un gaz parfait 52

Équation des adiabatiques réversibles d'un gaz parfait 53

Analogie du modèle avec le comportement des nomades 54

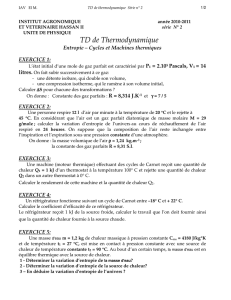

EXERCICES 55

SECOND PRINCIPE DE LA THERMODYNAMIQUE 57

INTRODUCTION 57

Définitions 58

LE SECOND PRINCIPE SELON KELVIN ET CLAUSIUS 59

Équivalence des deux formulations 60

Conséquences 61

L'ÉNERGIE LIBRE 62

Analogie entre l'énergie libre et l'énergie potentielle 65

Application aux gaz parfaits 66

Cas particulier d'un système isolé 67

Analogie du modèle avec le comportement des nomades 68

LE SECOND PRINCIPE SELON CARNOT 68

Introduction 68

Premier cas : travail fourni par le système (

0

<

W ) 69

Second cas : travail reçu par le système ( 0

>

W ) 71

RENDEMENT 72

iii

Cycle de Carnot 72

La machine de Carnot comme modèle 76

Analogie de ce modèle avec le comportement des nomades 77

Théorème de Carnot 77

Machine frigorifique et pompe à chaleur 79

THÉORÈME DE CLAUSIUS 81

Relation relative à deux thermostats 81

Relation relative à n thermostats 82

L'ENTROPIE 84

Changements d'entropie dans les transformations réversibles d'un gaz

parfait 87

Relation entre l'entropie et l'énergie libre 90

L'entropie des systèmes isolés 92

Exemple d'évolution spontanée de systèmes isolés 93

Entropie de l'univers 94

Analogie du modèle classique de l'entropie avec le comportement des

nomades 96

EXERCICES 96

Entropie et énergie libre des gaz parfaits 96

Phase condensée idéale 98

Transformations cycliques, rendement 98

Conséquences du second principe 99

PROBABILITÉS ET STATISTIQUE : UNE BRÈVE INTRODUCTION 101

HISTORIQUE 101

QUELQUES CONSIDÉRATIONS UTILES DANS LE DOMAINE DES

PROBABILITÉS 101

Propriétés des probabilités 102

Moyenne et variance 103

Probabilités conditionnelles, dépendance, indépendance 104

Distribution binomiale 106

Comment interpréter un écart ? 107

NOTIONS ÉLÉMENTAIRES DE MÉCANIQUE STATISTIQUE 111

INTRODUCTION À LA MÉCANIQUE STATISTIQUE 111

Classi

fi

cation des systèmes 112

PRINCIPES DE LA MÉCANIQUE STATISTIQUE POUR UN SYSTÈME

MICROCANONIQUE 112

La chaleur est un transfert désordonné d'énergie 112

Le travail est un transfert ordonné d'énergie 114

À un état macroscopique correspond un ou plusieurs microétats 114

L'évolution du système obéit à des lois de probabilité 117

Signification statistique de l'entropie 117

EXEMPLES SIMPLES D'INTERPRÉTATION STATISTIQUE DE L'ENTROPIE 119

Détente libre d'un gaz (expérience de Joule) 119

Mélange de deux gaz 123

Augmentation du désordre de vitesse des systèmes isolés ; processus

d'égalisation de température 124

Fluctuations statistiques 124

SYSTÈMES CANONIQUES 126

iv

Distribution de Boltzmann 126

Analogie du modèle de la distribution de Boltzmann avec le comportement

des nomades 128

Calcul de l'entropie statistique du système canonique 129

Expression de l'entropie à partir de la fonction de partition 131

Entropie statistique d'un gaz parfait monoatomique 132

Additivité de l'entropie statistique - Indiscernabilité des particules 135

TROISIÈME PRINCIPE DE LA THERMODYNAMIQUE 137

Modèle de l'oscillateur harmonique 138

Analogie avec les nomades 140

EXERCICES 141

Systèmes microcanoniques 141

Systèmes canoniques 141

THÉORIE DE L'INFORMATION 143

INTRODUCTION 143

Diagramme de communication 144

MESURE DE L'INFORMATION QUAND LES SYMBOLES SONT

ÉQUIPROBABLES 146

Potentiel et entropie d'information 146

Exemple d'information potentielle 149

Entropie d'information et entropie thermodynamique 151

Capacité temporelle d'un canal 153

LES SYMBOLES NE SONT PAS ÉQUIPROBABLES 155

Potentiel et entropie d'information 155

Dé

fi

nition générale d'une entropie 156

Exemple d'information potentielle 157

PROPRIÉTÉS DE L'ENTROPIE 161

Optimisation du potentiel informatif 163

Information potentielle d'un langage 168

TRANSMISSION DE L'INFORMATION 169

Information de deux sources indépendantes 170

Information de deux sources dépendantes 171

PROPRIÉTÉS DES ENTROPIES RELATIVES ET CONDITIONNELLES 176

Exemple de la propriété d'additivité de l'entropie 179

Exemple de transmission avec bruit sans perte d'information 180

Théorème d'unicité 182

Dé

fi

nition du canal discret et constant 183

Capacité d'un canal avec bruit 184

Exemple de calcul de la capacité d'un canal bruité 185

TRANSMISSION PAR UN CANAL SANS BRUIT – CODAGE DE SOURCE 187

Premier exemple 187

Ef

fi

cacité d'un codeur 191

Codage uniforme 192

Codages non uniformes 193

Condition d'existence d'un codage instantané 194

Code complet 196

Démonstration de l'existence d'une borne inférieure de

n

197

Théorème fondamental de Shannon pour un canal sans bruit 199

Conséquence du théorème de Shannon pour un canal sans bruit 201

v

Construction du code de Shannon 202

Code de Huffman 204

Code absolument optimal 206

TRANSMISSION PAR UN CANAL BRUITÉ – CODAGE DE CANAL 206

Exemple de réduction de l'erreur de transmission par répétition du signal 207

Théorème fondamental du codage avec bruit 209

Discussion 210

EXERCICES 211

Calcul de logarithmes en base 2 211

Optimisation du potentiel informatif 211

Transmission sans codage et sans bruit 212

Sans codage et avec bruit 213

Avec codage et sans bruit 214

Avec codage et avec bruit 216

ANNEXES 219

FORMULE DE STIRLING 219

RECHERCHE D'EXTREMA LIÉS 219

CAPACITÉ EN INFORMATION D'UN CANAL BRUITÉ 220

Exemples 224

Il reste un problème… 226

1

/

5

100%