Théorie des probabilités continue[modifier]

Théorie des probabilités

Un article de Wikipédia, l'encyclopédie libre.

Aller à : Navigation, rechercher

Pour les articles homonymes, voir Interconnexions entre la théorie des probabilités et la

statistique.

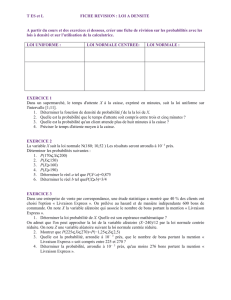

Courbes de probabilité.

La théorie des probabilités est l'étude mathématique des phénomènes caractérisés par le hasard

et l'incertitude. Les objets centraux de la théorie des probabilités sont les variables aléatoires, les

processus stochastiques, et les événements: ils traduisent de manière abstraite des événements

non déterministes ou des quantités mesurées qui peuvent parfois évoluer dans le temps d'une

manière apparemment aléatoire. En tant que fondement mathématique des statistiques, la théorie

des probabilités est essentielle à la plupart des activités humaines qui nécessitent une analyse

quantitative d'un grand nombre de mesures. Les méthodes de la théorie des probabilités

s'appliquent également à la description de systèmes complexes dont on ne connait qu'en partie

l'état, comme en mécanique statistique. Une grande découverte de la physique du XXe siècle fut

la nature probabiliste de phénomènes physiques à une échelle microscopique, décrite par la

mécanique quantique.

Sommaire

[masquer]

1 Historique

o 1.1 Théorie des probabilités discrète

o 1.2 Théorie des probabilités continue

2 Principes fondamentaux

3 La théorie des probabilités aujourd'hui

4 Lois de probabilité

5 Convergence de variables aléatoires

6 Le calcul stochastique

o 6.1 Chaîne de Markov

o 6.2 Équations différentielles stochastiques

7 Voir aussi

o 7.1 Articles connexes

o 7.2 Liens externes

Historique[modifier]

La théorie mathématique des probabilités trouve ses origines dans l'analyse de jeux de hasard par

Gerolamo Cardano au XVIe siècle, et par Pierre de Fermat et Blaise Pascal au XVIIe. Bien qu'un

simple pile ou face ou un lancer de dés soit un événement aléatoire, en les répétant de

nombreuses fois on obtient une série de résultats qui va posséder certaines propriétés statistiques,

que l'on peut étudier et prévoir. Deux résultats mathématiques fondamentaux à ce propos sont la

loi des grands nombres et le théorème de la limite centrale.

Initialement, la théorie des probabilités considérait surtout les événements discrets, et ses

méthodes étaient principalement combinatoires. Mais des considérations analytiques ont forcé

l'introduction de variables aléatoires continues dans la théorie. Cette idée prend tout son essor

dans la théorie moderne des probabilités, dont les fondations ont été posées par Andreï

Nikolaevich Kolmogorov. Kolmogorov combina la notion d'univers, introduite par Richard von

Mises et la théorie de la mesure pour présenter son système d'axiomes pour la théorie des

probabilités en 1933. Très vite, son approche devint la base incontestée des probabilités

modernes.

Théorie des probabilités discrète[modifier]

La théorie discrète des probabilités s'occupe d'événements dans le cadre d'un univers fini ou

dénombrable.

Exemples: lancer de dés, expériences avec des paquets de cartes, et marche aléatoire.

Définition classique: Initialement, la probabilité d'un événement était définie comme le nombre

de cas favorables pour l'événement, divisé par le nombre total d'issues possibles à l'expérience

aléatoire.

Par exemple, si l'événement est obtenir un nombre pair en lançant le dé, sa probabilité est

donnée par , puisque trois faces sur six ont un nombre pair.

Définition moderne : La définition moderne commence par un ensemble appelé univers, qui

correspond à l'ensemble des issues possibles à l'expérience dans la définition classique. Il est

noté . Ensuite, on a besoin d'une fonction f définie sur Ω, qui va associer à

chaque élément de Ω sa probabilité, satisfaisant donc les propriétés suivantes :

1.

2.

On définit ensuite un événement comme un ensemble d'issues, c'est-à-dire un sous-ensemble de

Ω. La probabilité d'un évènement E est alors définie de manière naturelle par :

Ainsi, la probabilité de l'univers est 1, et la probabilité de l'événement impossible (l'ensemble

vide) est 0.

Pour revenir à l'exemple du lancer de dés, on peut modéliser cette expérience en se donnant un

univers Ω = {1;2;3;4;5;6} correspondant aux valeurs possibles du dé, et une fonction f qui à

chaque associe .

Théorie des probabilités continue[modifier]

La théorie des probabilités continue s'occupe des événements qui se produisent dans un

univers continu (par exemple la droite réelle).

Définition classique: La définition classique est mise en échec lorsqu'elle est confrontée au cas

continu (cf. paradoxe de Bertrand).

Définition moderne Si l'univers est la droite réelle , alors on admet l'existence d'une fonction

appelée fonction de répartition , qui donne pour une variable aléatoire

X. Autrement dit, F(x) retourne la probabilité que X soit inférieur ou égal à x.

La fonction de répartition doit satisfaire les propriétés suivantes :

1. est une fonction croissante et continue à droite.

2.

3.

Si est dérivable, alors on dit que la variable aléatoire X a une densité de probabilité

.

Pour un ensemble , la probabilité que la variable aléatoire X soit dans est définie

comme :

Si la densité de probabilité existe, on peut alors la réécrire :

Tandis que la densité de probabilité n'existe que pour les variables aléatoires continues, la

fonction de répartition existe pour toute variable aléatoire (y compris les variables discrètes) à

valeurs dans .

Ces concepts peuvent être généralisés dans les cas multidimensionnel sur et d'autres univers

continus.

Principes fondamentaux[modifier]

La probabilité d'un événement donné A, , est représentée par un nombre compris entre 0 et

1. L'événement impossible a une probabilité de 0 et l'événement certain a une probabilité de 1. Il

faut savoir que la réciproque n'est pas vraie. Un événement qui a une probabilité 0 peut très bien

se produire dans le cas où un nombre infini d'événements différents peut se produire. Ceci est

détaillé dans l'article Ensemble négligeable.

Quelques notions ou propriétés fondamentales

Évènement

Probabilité

probabilité de A

probabilité de ne pas

avoir A

probabilité d'avoir A ou

B

probabilité

conditionnelle de A,

sachant B

probabilité d'avoir A et

B

est la réunion de A et B. est l'intersection de A et de B. est appelé la

probabilité conditionnelle de A sachant B. C'est la probabilité d'avoir A quand on sait que l'on a

B. Par exemple, pour un dé à 6 faces la probabilité d'avoir un 2 (A) quand on sait que le résultat

est pair (B) est égal à car la probabilité d'avoir à la fois un 2 et un nombre pair est

égal à 1/6 et la probabilité d'avoir un nombre pair est égal à 1/2. Ici on remarque que

car on a toujours un nombre pair quand on a 2.

La théorie des probabilités aujourd'hui[modifier]

Article détaillé : axiomes des probabilités.

Article détaillé : espace probabilisé.

Certaines distributions peuvent être un mélange de distributions discrètes et continues, et donc

n'avoir ni densité de probabilité ni fonction de masse. La distribution de Cantor constitue un tel

exemple. L'approche moderne des probabilités résout ces problèmes par l'utilisation de la théorie

de la mesure pour définir un espace probabilisé et aboutir aux axiomes des probabilités

développés par Kolmogorov

Un espace probabilisé comporte trois parties:

un univers Ω: L'univers est l'ensemble de tous les résultats possibles de l'évenement

aléatoire. Par exemple pour un dé a 6 faces l'univers est Ω ≡ {1, 2, 3, 4, 5, 6}.

un ensemble d'événements : C'est une tribu sur les événements Ω. Cet ensemble

contient tous les résultats possibles de l'événement au sens large. Par exemple pour un dé

à 6 faces il contient la possibilité d'avoir un 1 ou un 2: {1, 2}, la possibilité de ne rien

sortir comme résultat: l'ensemble vide , la possibilité de sortir n'importe quel face du dé

{1, 2, 3, 4, 5, 6}. En général en probabilité on se contente de prendre la tribu borélienne.

À titre d'exemple la tribu borélienne pour le résultat d'un dé à 4 faces est donné (celle

pour le dé à 6 faces est encore plus grande mais suit le même principe):

{ø, {1}, {2}, {3}, {4}, {1,2}, {1,3}, {1,4}, {2,3}, {2,4}, {3,4}, {1,2,3}, {1,2,4}, {1,3,4},

{2,3,4}, {1,2,3,4}}. On remarque que cette tribu contient l'ensemble vide ø et

Ω={1,2,3,4}. Ceci est le cas pour toutes les tribus.

une mesure : Cette mesure ou probabilité est la probabilité de réaliser l'un des éléments

de . Cette probabilité est comprise entre 0 et 1 pour tous les éléments de , c'est le

premier axiome des probabilités. Par exemple pour un dé a 6 faces: la probabilité d'avoir

{1} est 1/6, la probabilité de Ω={1, 2, 3, 4, 5, 6}, tirer n'importe laquelle des 6 faces, est

1 (ceci est aussi toujours le cas, c'est le deuxième axiome des probabilités), la probabilité

de l'ensemble vide ø est 0. Ceci est toujours le cas, c'est également une conséquence des

axiomes des probabilités.

Dans cette optique, pour des événements deux à deux disjoints (c'est-à-dire, d'intersection deux à

deux vide) A1, A2, A3…, la probabilité de leur union apparaît comme la somme de leurs

probabilités, ou, avec les notations mathématiques,

C'est le troisième et dernier axiome des probabilités. Par exemple, et toujours pour un dé à 6

faces, la probabilité de tirer un 1 ou un 2

En plus de permettre une meilleure compréhension et une unification des théories discrètes et

continues des probabilités, l'approche de la théorie de la mesure nous permet aussi de parler de

probabilités en dehors de , notamment dans la théorie des processus stochastiques. Par

exemple pour l'étude du mouvement brownien, la probabilité est définie sur un espace de

fonctions.

Lois de probabilité[modifier]

Article détaillé : Loi de probabilité.

Certaines variables aléatoires sont fréquemment rencontrées en théorie des probabilités car on les

retrouve dans de nombreux processus naturels ; leur loi a donc une importance particulière. Les

lois discrètes les plus fréquentes sont la loi uniforme discrète, la loi de Bernoulli, ainsi que les

lois binomiale, de Poisson et géométrique. Les lois uniforme continue, normale, exponentielle et

gamma sont parmi les plus importantes lois continues.

6

6

7

7

8

8

1

/

8

100%