4 Conditions d`optimalité

Prenom Nom

4 Conditions d’optimalité

[Cette méthode] ne trompe jamais et peut s’étendre à des

questions très belles.

P. de Fermat (1601-1665).

On ne trouvera point de Figures dans cet Ouvrage. Les

méthodes que j’y expose ne demandent ni constructions, ni

raisonnements géométriques ou méchaniques, mais seulement

des opérations algébriques, assujetties à une marche régulière et

uniforme. Ceux qui aiment l’Analyse verront avec plaisir la

Méchanique en devenir une nouvelle branche, et me sauront gré

d’en avoir étendu ainsi le domaine.

J.-L. de la Grange.Méchanique Analytique. [339 ; 1788,

pages XI-XII]

Considérons le problème d’optimisation sous forme générale

(PX)min f(x)

x∈X,

dans lequel on minimise une fonction f:X→Rdéfinie sur une partie Xd’un espace

euclidien E. On note h·,·i le produit scalaire de cet espace vectoriel et

n:= dim E

sa dimension (finie).

Rappelons quelques notions relatives au problème (PX), qui ont été introduites

aux sections 1.1 et 1.2 et qui seront continuellement utilisées dans ce chapitre. L’en-

semble Xsur lequel on minimise fest appelé l’ensemble admissible du problème. Un

minimum (global) de ce problème est un point x∗∈Xtel que

∀x∈X:f(x∗)6f(x).(4.1)

On dit que x∗∈Xest un minimum local de (PX)s’il existe un voisinage Vde x∗tel

que

∀x∈X∩V:f(x∗)6f(x).(4.2)

On parle de minimum global (resp. local) strict si l’on a inégalité stricte dans l’ex-

pression (4.1) (resp. (4.2)), lorsque x6=x∗.

137

Prenom Nom

138 4. Conditions d’optimalité

Les conditions d’optimalité sont des équations, des inéquations ou des propriétés

que vérifient les solutions de (PX)(conditions nécessaires, CN) ou qui assurent à

un point d’être solution de (PX)(conditions suffisantes, CS). Elles traduisent ainsi

l’expression (4.2) de l’optimalité locale en une forme analytique plus directement

utilisable. Ces conditions sont utiles pour de nombreuses raisons, par exemple :

pour vérifier l’optimalité éventuelle d’un point x∈X, voir si c’est un minimum,

un maximum ou un point stationnaire (voir plus loin pour la définition de ce

terme),

pour calculer analytiquement des solutions de (PX),

pour mettre en œuvre des méthodes numériques permettant de trouver des solu-

tions (PX),

pour définir des tests d’arrêt des itérations dans les algorithmes de résolution

de (PX).

On parlera de conditions du premier ordre (notées CN1 ou CS1, selon qu’il s’agit

de conditions nécessaires ou suffisantes) lorsque celles-ci ne font intervenir que les

dérivées premières de fet des fonctions définissant l’ensemble admissible. Quant aux

conditions du second ordre (notées CN2 ou CS2), elles ne font intervenir que les

dérivées premières et secondes de ces fonctions.

Nous commencerons par une condition nécessaire d’optimalité du premier ordre

très générale puisqu’elle concerne le problème (PX); elle est de nature géométrique

(section 4.1). C’est cette condition qui sera ensuite traduite en une forme analy-

tique pour les problèmes sans contrainte (section 4.2), les problèmes avec contraintes

d’égalité (section 4.3) et enfin les problèmes avec contraintes d’égalité et d’inégalité

(section 4.4). Dans cette dernière section, c’est le lemme de Farkas qui permet de faire

cette traduction. Les résultats obtenus dans ce dernier cas permettent de retrouver

les résultats précédents. Dès lors, le lecteur pressé et courageux pourra passer directe-

ment de la section 4.1 à la section 4.4. Rien ne sera perdu quant au contenu, mais on

gagnera en compréhension en se penchant sur les situations plus simples décrites aux

sections 4.2 et 4.3.

Connaissances supposées. Notion de cône dual et lemme de Farkas. Les conditions

du deuxième ordre pour le problème avec contraintes d’égalité et d’inégalité (sec-

tion 4.4.4) requièrent la connaissance de la dualité linéaire, qui ne sera vue qu’au

chapitre 18 ! Cette dernière section peut être passée en première lecture.

4.1 Une condition nécessaire d’optimalité géométrique

4.1.1 Cônes tangent et normal

Dans cette section, on suppose que Edésigne un espace vectoriel normé de dimen-

sion finie. Sa norme est notée k · k.

Le cône tangent est un concept essentiel pour l’écriture des conditions d’optimalité.

Il sert à linéariser l’ensemble admissible au point optimal x∗, comme on le fait avec le

critère en optimisation sans contrainte pour exprimer l’optimalité de x∗:f′(x∗) = 0.

Nous utiliserons essentiellement la notion de tangence suivante. On note

R++ := {x∈R:x > 0}.

Prenom Nom

4.1. Une condition nécessaire d’optimalité géométrique 139

Définitions 4.1 (cône tangent) Soient X⊂Eet x∈E. On dit que le vecteur

d∈Eest tangent àXen x(au sens de Bouligand [76 ; 1932]) s’il existe une suite

{dk} ⊂ Eet une suite {tk} ⊂ R++ telles que

dk→d, tk↓0, x +tkdk∈X. (4.3)

On note TxXl’ensemble des vecteurs tangents à Xen xet on l’appelle le cône

tangent (pour le distinguer d’autres notions de cône tangent, on l’appelle parfois le

cône contingent). 2

La définition précédente a une interprétation géométrique simple : pour que la

direction dsoit tangente à Xen x, il faut qu’elle soit limite de directions dk, telles

que x+R++dkrencontre Xen un point qui se rapproche de xlorsque k→ ∞. Le

passage à la limite est essentiel, sous peine d’appauvrir radicalement TxXet de le

rendre ainsi inutilisable. Il ne suffirait pas en effet de prendre comme cône tangent,

ce que l’on nomme le cône radial en x

Tr

xX:= {d∈E:x+td ∈Xpour tout t > 0petit}.(4.4)

Par exemple, si X={x∈R2:x2

16x262x2

1}et x= 0,Tr

xX=∅, alors que

TxX=R× {0}. Le cône tangent diffère donc en général de Tr

xXou de l’adhérence

de celui-ci. Il en sera aussi souvent ainsi lorsque Xest défini par des égalités non

linéaires. Toutefois (voir l’exercice 4.2)

Xest convexe =⇒TxX=Tr

xX.

On verra aussi que si Xest donné par des contraintes fonctionnelles d’égalité et

d’inégalité et si des conditions de qualification des contraintes sont vérifiées, le cône

tangent se calcule aisément en utilisant les gradients des contraintes fonctionnelles

actives en x(voir la section 4.4.2).

La définition 4.1 d’une direction tangente est facile à interpréter, mais elle n’est

pas la plus opérationnelle. Il s’avérera plus utile de faire jouer le rôle principal à la

suite {xk}, où xk=x+tkdk, plutôt qu’à la suite {dk}. Il revient en fait au même de

dire que d∈TxXsi, et seulement si, il existe des suites {xk} ⊂ Eet {tk} ⊂ Rtelles

que

{xk} ⊂ X, tk↓0et xk−x

tk→d. (4.5)

Forcément, xk→x. Voici un premier exemple d’utilisation de cette définition équiv-

alente.

Proposition 4.2 TxXest un cône fermé.

Démonstration. Soit {dk} ⊂ TxX, avec dk→d. Il faut montrer que d∈TxX.

Pour tout k>1, il existe une suite {xk,j }j⊂Xet une suite {tk,j }j↓0telles que

(xk,j −x)/tk,j →dklorsque j→ ∞. On construit à présent des suites par le procédé

diagonal. Pour tout i>1, on détermine d’abord kitel que kdki−dk61

iet ensuite ji

tel que k(xki,ji−x)/tki,ji−dkik61

iet tki,ji61

i. Clairement {xki,ji}i⊂X,tki,ji↓0

et (xki,ji−x)/tki,ji→dlorsque i→ ∞, si bien que d∈TxX.2

Prenom Nom

140 4. Conditions d’optimalité

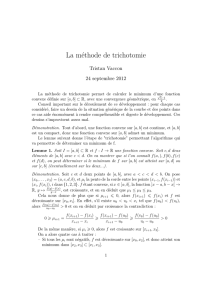

On vérifie que

x /∈X=⇒TxX=∅,

x∈int X=⇒TxX=E,

x∈intr X=⇒TxX= (aff X)−(aff X).

Les cas non triviaux se présentent donc lorsque xest sur la frontière de X. On trou-

vera à la figure 4.1 quelques exemples de cônes tangents. Notons que TxXn’est pas

x3

Nx3X3

X1

Nx1X1

Tx1X1

x1

x2

X2

X3

Nx2X2

0

0

Tx3X3

Tx2X2

0

Fig. 4.1. Cônes tangent (en bleu clair) et normal (en rose) à quelques ensembles (en haut)

nécessairement convexe (mais il est convexe si Xest convexe, voir l’exercice 4.2). En

voici un contre-exemple.

Exemple 4.3 L’ensemble non convexe X:= {x∈R2:x2

16x2

2}a son cône tangent

en (0,0) qui s’écrit T(0,0)X={d∈R2:|d1|6|d2|} et qui n’est pas convexe. 2

On note que TxXne dépend de Xque dans un voisinage de x: si l’on modifie X

en dehors d’un voisinage de x, on ne change pas TxX(il suffit de ne retenir dans la

propriété (4.5) que les xkqui sont dans ce voisinage). D’autre part, TxXne dépend

pas de la manière utilisée pour définir X. En particulier, si Xest défini par des

contraintes fonctionnelles (voir plus loin), le cône tangent ne dépend pas du choix des

fonctions utilisées pour le définir.

Définitions 4.4 (cône normal) Soient Eun espace euclidien (produit scalaire noté

h·,·i), X⊂Eet x∈E. On dit que p∈Eest normal àXen xsi

∀d∈TxX:hp, di60.(4.6)

On note NxXl’ensemble des vecteurs normaux à Xen xet on l’appelle le cône

normal.2

Cette définition du cône normal est simple mais un peu restrictive selon Rockafellar

[456 ; 1993 ; p. 193], qui l’appelle cône normal régulier ; elle suffira pour notre propos.

Prenom Nom

4.1. Une condition nécessaire d’optimalité géométrique 141

Clairement, le cône normal est le dual négatif du cône tangent :

NxX= (TxX)−=−(TxX)+(4.7)

et, contrairement à TxX,NxXest donc toujours convexe (point 1 de la proposi-

tion 2.32). D’après le point 5 de la proposition 2.32, un cône est contenu dans son

bidual et donc

TxX⊂(NxX)−.(4.8)

On montre que (voir l’exercice 4.2)

Xconvexe =⇒TxX= (NxX)−.

Si Xn’est pas convexe, TxXpeut ne pas être convexe (exemple 4.3) ; donc l’égalité

ci-dessus peut ne pas avoir lieu car (NxX)−est toujours convexe (point 1 de la

proposition 2.32). Remarquons aussi que, lorsque Xest convexe, on retrouve le cône

normal défini à la section 2.5.4 (voir l’exercice 4.2).

4.1.2 Une condition d’optimalité du premier ordre

Commençons donc par considérer le problème général

(PX)min f(x)

x∈X,

où Xest une partie de E. La condition nécessaire d’optimalité du premier ordre

suivante met en évidence l’utilité des notions de cônes tangent et normal.

Théorème 4.5 (CN1) Si x∗est un minimum local de (PX)et si fest dérivable

en x∗, on a

∀d∈Tx∗X:f′(x∗)·d>0.(4.9)

Ceci s’écrit aussi

∇f(x∗)∈(Tx∗X)+ou −∇f(x∗)∈Nx∗X, (4.10)

où ∇f(x∗)est le gradient de fen x∗pour le produit scalaire de E,(·)+désigne

le dual pour ce même produit scalaire et Nx∗Xest le cône normal à Xen x∗.

Démonstration. Soit d∈Tx∗Xnon nul (la relation (4.9) est triviale si d= 0). Alors

il existe des suites {xk} ⊂ Xet {tk} ↓ 0telles que dk:= xk−x∗

tk→d. Pour kgrand,

xk=x∗+tkdk∈Xest voisin de x∗, si bien que par l’optimalité locale,

pour kgrand : f(x∗+tkdk)>f(x∗).

Si fest dérivable en x∗,f(x∗+tkdk) = f(x∗) + f′(x∗)·(tkdk) + o(ktkdkk), donc

06f′(x∗)·dk+o(ktkdkk)

tk

=f′(x∗)·dk+o(ktkdkk)

ktkdkkkdkk.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

1

/

60

100%