Des millions d`images pour la stéganalyse : inutile ! 1

2,3 2,3,4 1,2,3

1

2

3

4

N

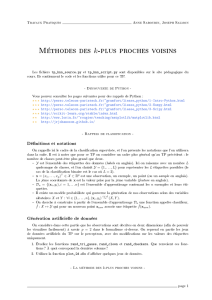

x y

=−→

sum

avg =

sum

Napp

Napp

ili∈

{cover = 1, stego =−1}z

z

iavg

avg i

ili

sum

z=sign(avg .i)

si li=z alors aucune mise `a jour

si li6=z alors = + li.i

sum =sum +

L

L

red red

L

hii∈ {1..L}

hi( ) : red → {stego, cover}

RNred → {−1,1}

z

z=sign(

L

X

i=0

(hi( )))

hi

cn

ii

i∈ {1..5}n

n∈ {1..dred}dred

S

S

S

d(

k K −means

C

ii∈ {1.. C}

C

i

x

yj

j

x y j

j∈1..C

x

j=arg

i

min

i∈{1..C}(d(i,x))

j

1

x y

C

i

N

CN

C L

dred C.L.dred

N= 1.8

T aux de pr´ediction =Nb labels correctement pr´edits

Nb total de tests

O(N.L.d2

red)

O(N.L.dred)

L

dred

L= 100

dred = 2000

C

i

C

6

6

1

/

6

100%