Convergence de l`algorithme du perceptron { }

Convergence de l’algorithme du perceptron

On considère un perceptron correspondant à une fonction

{

}

: 1,1

p

f

→ −

ℝ

déterminée par

1 1

1

1 si 0

( , , ) 1 sinon

p p

p

x x

f x x

ω ω θ

+ + + ≥

=

−

⋯

…

Rq : La fonction est à valeurs dans

{

}

1,1

−

au lieu de

{

}

0,1

pour faciliter l’exposé, mais cela ne change rien

au fond de l’étude…

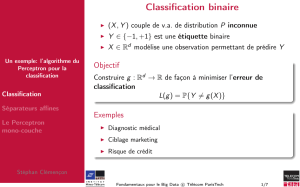

On se donne un ensemble d’apprentissage

{

}

1 1

( , ), ,( , )

N N

A x y x y=…

avec pour chaque

{

}

1, ,

i N

∈

…

,

1

( , , )

i i i p

p

x x x

= ∈

… ℝ

et

{

}

1, 1

i

y

∈ −

la réponse attendue par le perceptron.

Déf : On dit que la base d’apprentissage

A

est linéairement séparable s’il existe des coefficients

{

}

1

( , , ) \ (0, ,0)

p

p

ω ω

∈

… ℝ …

et

θ

∈

ℝ

tel que

1 1

1 , sgn( )

i i i

p p

i N y x x

ω ω θ

∀ ≤ ≤ = + + +

⋯

en posant

1 si 0

sgn( ) 0 si 0

1 si 0

x

x x

x

≥

= =

− <

Pour alléger les notations, on va poser

0

θ ω

=

et convenir

0

1

i

x

=

pour chaque

{

}

1, ,

i N

∈

…

de sorte que les

expressions

1 1 p p

x x

ω ω θ

+ + +

⋯

s’écrivent plus légèrement

0 0 1 1

p p

x x x

ω ω ω

+ + +

⋯

La définition du perceptron se ramène alors la détermination d’un vecteur synaptique

1

0 1

( , , , )

p

p

ω ω ω ω

+

= ∈

… ℝ

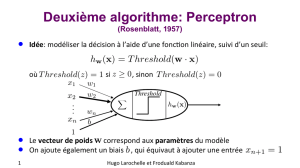

L’algorithme d’apprentissage du perceptron est alors le suivant :

On choisit arbitrairement un vecteur synaptique

0 1

n

ω

+

∈

ℝ

.

Tant que les réponses produites ne sont pas toutes correctes :

on choisit un exemple

( , )

i i

x y

dans la base d’apprentissage.

Si la réponse produite par le perceptron sur cet exemple est incorrecte Alors

on modifie chaque poids synaptiques par la relation :

1

:

t t i i

j j j

y x

ω ω

+

= +

Fin Si

Fin Tant que

Théorème :

Si la base d’apprentissage est linéairement séparable, cet algorithme s’arrête et détermine donc un

perceptron solution.

dém. :

Puisque la base est linéairement séparable, il existe un vecteur

0 1

( , , , )

p

ω ω ω ω

∗ ∗ ∗ ∗

=

…

non nul tel que

0 1 1

1 , sgn( )

i i

i p p

i N y x x

ω ω ω

∗ ∗ ∗

∀ ≤ ≤ = + + +

⋯

Pour alléger les notations, introduisons

(

)

.|.

le produit scalaire canonique sur

1

p

+

ℝ

. On a donc

(

)

1 , sgn |

i

i

i N y x

ω∗

∀ ≤ ≤ =

avec rappelons-le

1

(1, , , )

i i i

p

x x x

=

…

.

Posons

(

)

1

min | 0

i

i n

xδ ω

∗

≤ ≤

= >

et

1

max

i

i n

M x

+

≤ ≤

= ∈

ℝ

Si par l’absurde, l’algorithme précédent ne s’arrête pas, il construit une suite infinie de vecteurs

( )

t

t

ω

∈

ℕ

avec la

propriété

1

t t i i

y x

ω ω

+

= +

lorsque la réponse du percepton défini par le vecteur synaptique

t

ω

n’est pas bonne sur l’exemple

( , )

i i

x y

.

D’une part

(

)

(

)

(

)

(

)

(

)

(

)

1

| | | | sgn | |

t t i i t i i

y x x x

ω ω ω ω ω ω ω ω ω

+ ∗ ∗ ∗ ∗ ∗ ∗

= + = +

donc

(

)

(

)

(

)

(

)

1| | | |

t t i t

x

ω ω ω ω ω ω ω δ

+ ∗ ∗ ∗ ∗

= + ≥ +

puis par récurrence

(

)

(

)

0

| |

t

t

ω ω ω ω δ

∗ ∗

≥ +

(1)

D’autre part

(

)

2 2 2

12 |

t t i t i i

y x x

ω ω ω

+

= + +

Or

( | ) 0

i t i

y x

ω

≤

car la réponse fournie par le perceptron donné par le vecteur synaptique

t

ω

est supposée

incorrecte sur l’exemple

( , )

i i

x y

et donc

2 2 2 2

1 2

t t i t

x M

ω ω ω

+

≤ + ≤ +

puis par récurrence

2 2

0 2

t

tM

ω ω≤ +

(2)

Par l’inégalité de Cauchy-Schwarz

( | )

t t

ω ω ω ω

∗ ∗

≤

donc (1) et (2) donnent

(

)

2

0 0 2

|

t tM

ω ω δ ω ω

∗ ∗

+ ≤ +

ce qui est incompatible avec un passage à la limite à l’infini : par exemple en divisant par

t

avant de faire tendre

t

vers

+∞

, on obtient

0

δ

≤

qui est contraire aux hypothèses de travail.

1

/

2

100%