Algorithme d`AdaBoost

MasterM2–Parcoursrecherche UPMC ModuleMIAD

Algorithmed’AdaBoost

1. A

LGORITHMEDE

P

ERCEPTRON

L’apprentissaged’unmodèleperceptronconsisteàdéterminerautomatiquementses

paramètresàpartird’unebaseétiquetéed’exemplesd’apprentissage.L’algorithmeestle

suivant(poursimplifieronconsidèrequeWestunvecteurligneetquelesxsontdesvecteurs

colonnes):

•D=(x

i

,y

i

)i=1..Nensembled’apprentissage,oùy

i

=C(x

i

)

•initialiserw,onnotecevecteurinitialw(0)

•t=0

•àt,choisiraléatoirementunexemplexdansD,onlenommex

t

osix(t)estcorrectementclassé,i.ey

t

(w(t).x

t

)>0

alorsw(t+1)=w(t)

osix(t)estmalclassé,i.e.y

t

(w(t).x

t

)<0

alorsw(t+1)=w(t)+ εy

t

x

t

t=t+1

•jusqu’à(critèred’arrêtsatisfait).

Oùεestlepasdegradient,c’estunevaleurpositivenonnulle,engénéralrelativementfaible

(parexemple1/N).Onutilisedifférentscritèresd’arrêts(plusd’erreurdeclassificationdepuis

uncertaintemps,taatteintunevaleurmaximale,etc).

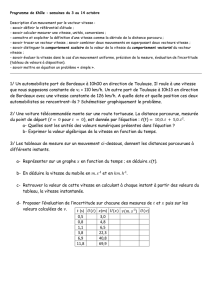

1.1 Fairetournerl’algorithmesurleproblèmedu«ET»logiquedansle casoùw(0)=

(w

0

=2;w

1

=2;w

2

=2),enitérantsurlabased’apprentissage(4exemples),prendreε = 1.

On se place dans le cas de classification bi-classe et on considère un ensemble

d’apprentissage {(x

i

, y

i

)}

i∈{1,…,m}.

On veut trouver l’hyperplan séparant les exemples avec

l’algorithmeduperceptron

1

.Onsupposepourcelaqueleproblèmeestlinéairementséparable

etqu’ilexistedoncunedroitedevecteurdirecteurw*quiséparelesexemples.Oninitialiseà

nullevecteurpoidsduperceptronàl’itération1,i.e.w(1)=0etonconsidèrequetousles

exemplessontàl’intérieurd’uneboulederayonR,i.e.∀i,||x

i

||≤R.

Aprèstitérations,onvafairekcorrectionsduvecteurpoids(t≥k)i.e.w(k)=w(k-1)+x

t

.y

t

1.2Exprimerladistanceentrelevecteurpoidsw(k)etw(1),||w(k)-w(1)||²,enfonctiondew(k-

1),x

t

.y

t

etw(1)

1.3Endéduireque||w(k)-w(1)||²≤k.R²

1

CethéorèmedeconvergenceestdeNovikoff,1966.

MasterM2–Parcoursrecherche UPMC ModuleMIAD

1.4Exprimerleproduitscalaireentrelevecteurpoidsw(k)et

*w*w

,<w(k),

*w*w

>,en

fonctiondew(k-1),x

t

.y

t

et

*w*w

.

1.5Onpose

=*w*w

xymin

ii

i

ρ

,montrerque<

w

(

k

),

*w*w

>

≥

k.

ρ

.

1.6Direpourquoia-t-on<

w

(

k

),

*w*w

>

≤

||

w

(

k

)||?

1.7Endéduireque||

w

(

k

)||²

≥

k

²

.

ρ

².

1.7Endéduiredesquestions2.2et2.6que

2

2

ρ

R

k≤etqu’ilfautdoncauplus

2

2

ρ

R

correctionsauperceptronpourtrouverladroiteséparatrice.Onnote

xlepluspetitentier

majorantx.

2. A

DABOOST

Lisez les trois premières pages (jusqu’à Generalization Error non compris) de l’article joint :

•Robert E. Shapire. Theoritical Views of Boosting. EuroCOLT’99, 1999.

2.1

Décriresuccinctementl’algorithmed’Adaboosttelqu’ilestprésentédansl’article.

2.2QuelrôlejoueladistributionD

t

?

2.3Commentestobtenuel’hypothèsefinaleH?

2.4Lafonctionf,correspondàlaminimisationdequellefonctionobjective?Etquelestle

lienentrefetH?

2.5Quelleestlajustificationpourbornerl’erreurempiriqueparlafonctionexponentielleà

l’équation(2)?Représentergraphiquementlesdeuxfonctionsexponentiellesetl’erreurde

classification.

2.6Montrerque

∑∏

∑

>

−−

=

it

)x(hy

i

)x(fy

ittiii

eZ)i(De

m

1

12

1

α

Où

∑

−

=

i

)x(hy

tt

itit

e)i(DZ

α

2.7

Parrécursion,endéduireque

MasterM2–Parcoursrecherche UPMC ModuleMIAD

∏

∑=

−

tt

i

)x(fy

Ze

m

ii

1

2.8

DériverZ

t

parrapportàα

t

etdirepourquellevaleurdeα

t

,Z

t

est-ilmaximum?

2.9

En supposant que

∑

≠

∼

=≠=

iit

t

y)x(h:i tiitDit

)i(D)y)x(h(P

ε

et pour l’expression des α

t

trouvéeen2.8montrerque

)(Z

ttt

εε

−= 12

2.10

Comment l’auteur conclut à partir de l’inégalité (A) (dans le papier) que l’erreur

empirique de mauvaise classification de f sur la base d’apprentissage décroit

exponentiellementvers0?

2.11

Quelestl’intérêtdel’algorithmeAdaboostmisenavantparl’auteuràcestadedu

papier?

1

/

3

100%