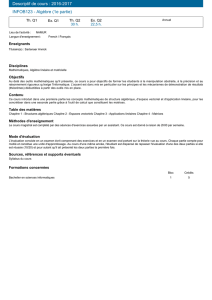

Algèbre linéaire propédeutique — version abrégée

Algèbre linéaire propédeutique

— version abrégée —

Ioan Manolescu

December 19, 2016

Contents

1 Espaces vectoriels 4

1.1 Définitionsetexemples.............................. 4

1.2 Sous-espacesvectoriels .............................. 5

1.3 Base, dimension finie, dimension . . . . . . . . . . . . . . . . . . . . . . . . . 9

1.3.1 Familles libres, génératrices . . . . . . . . . . . . . . . . . . . . . . . 9

1.3.2 Dimension finie; théorèmes essentiels . . . . . . . . . . . . . . . . . . 12

1.3.3 Sous-espaces vectoriels de dimension finie; rang . . . . . . . . . . . . 14

1.3.4 Représentation d’un vecteur dans une base . . . . . . . . . . . . . . . 14

1.4 Application: suites définies par récurrence . . . . . . . . . . . . . . . . . . . 16

2 Applications linéaires et matrices 22

2.1 Applications linéaires: généralités . . . . . . . . . . . . . . . . . . . . . . . . 22

2.1.1 Imageetnoyau .............................. 24

2.1.2 Inverses des applications linéaires . . . . . . . . . . . . . . . . . . . . 26

2.1.3 Applications linéaires en dimension finie . . . . . . . . . . . . . . . . 26

2.2 Introduction aux matrices . . . . . . . . . . . . . . . . . . . . . . . . . . . . 27

2.2.1 Opérations sur les matrices . . . . . . . . . . . . . . . . . . . . . . . 28

2.2.2 Matrices inversibles . . . . . . . . . . . . . . . . . . . . . . . . . . . . 29

2.2.3 Latransposition.............................. 30

2.2.4 Formes particulières . . . . . . . . . . . . . . . . . . . . . . . . . . . 31

2.2.5 Puissance des matrices . . . . . . . . . . . . . . . . . . . . . . . . . . 32

2.2.6 Les matrices comme outil de modélisation . . . . . . . . . . . . . . . 32

2.3 Applications linéaires et matrices . . . . . . . . . . . . . . . . . . . . . . . . 38

2.3.1 Représentation des applications linéaires par des matrices . . . . . . . 38

2.3.2 Addition et multiplication par un scalaire . . . . . . . . . . . . . . . . 40

2.3.3 Composition vs. multiplication; inverse . . . . . . . . . . . . . . . . . 41

2.3.4 Image, noyaux et rang des matrices . . . . . . . . . . . . . . . . . . . 42

2.3.5 Changementdebase ........................... 44

2.3.6 Matricessemblables............................ 45

2.4 Systèmeslinéaires................................. 46

2.4.1 Opérations sur les lignes; forme échelonnée . . . . . . . . . . . . . . . 48

2.4.2 Pivot de Gauss pour la résolution des systèmes linéaires . . . . . . . . 50

2.4.3 Pivot de Gauss pour le calcul de l’inverse . . . . . . . . . . . . . . . . 55

2.4.4 Familles de vecteurs et pivot de Gauss . . . . . . . . . . . . . . . . . 56

1

CONTENTS

3 Matrices diagonalisables; valeurs et vecteurs propres 59

3.1 Valeurs et vecteurs propres . . . . . . . . . . . . . . . . . . . . . . . . . . . . 59

3.2 Matrices diagonalisables . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 61

3.2.1 Lien avec les vecteurs propres . . . . . . . . . . . . . . . . . . . . . . 61

3.2.2 Application: matrices de Leslie . . . . . . . . . . . . . . . . . . . . . 65

3.3 Ledéterminant .................................. 67

3.3.1 Définition et propriétés de base . . . . . . . . . . . . . . . . . . . . . 67

3.3.2 Déterminant et inversibilité . . . . . . . . . . . . . . . . . . . . . . . 68

3.3.3 Opérations sur lignes; pivot de Gauss . . . . . . . . . . . . . . . . . . 69

3.3.4 Compléments ............................... 70

3.4 Polynôme caractéristique . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 71

3.4.1 Application: recherche de vecteurs propres . . . . . . . . . . . . . . . 71

– 2 –

Avant-Propos

Ces notes accompagnent le cours d’algèbre linéaire propédeutique donné au semestre

d’automne des années 2015-2016 à l’Université de Fribourg.

Le but du cours est double. Il vise principalement de familiariser les étudiants avec

l’algèbre linaire, en accentuant les aspects pratiques comme le calcul matriciel, la résolution

des systèmes linéaires et les notions de valeur et de vecteur propres. Un deuxième but est de

faire découvrir aux étudiants le fonctionnement des mathématiques, à savoir la construction

d’une théorie à partir d’axiomes. Ce processus vise à créer un cadre abstrait qui permet

de décrire des problèmes issus de la réalité. Trouver un cadre abstrait, général, plutôt que

d’en créer un pour chaque problème rencontré, cela nous permet d’apercevoir des connexions

entre différents problèmes et d’en offrir des solutions plus robustes.

Enfin, dans le développement de toute science, arrive un moment où, pour dépasser les

approches ad-hoc, il est nécessaire de construire un cadre théorique qui permet une étude

systématique. Les sciences plus “mathématiques” comme la physique ou l’informatique tra-

vaillent déjà dans un tel cadre. Dans les sciences traditionnellement plus empiriques (biologie,

médecine, économie etc.) ce cadre est en train de se former par les travaux de modélisation

de plus en plus fréquentes. Ainsi, il est essentiel pour les scientifiques en formation de se

confronter à une construction abstraite, comme celle présentée dans ce cours.

Cette version du polycopié résume les définitions et les résultats essentiels du cours; elle

correspond à ce qui est présenté en classe. Ainsi, ce sont uniquement les preuves simples et

illustratrices qui y sont présentées. Ceux qui sont intéressés par les preuves plus complexes

peuvent consulter la version complète du polycopié. Les exercices sont destinés à offrir une

compréhension plus profonde du cours et sont facultatifs. Ils sont différents des exercices des

séries qui consistent surtout en exemples concrets.

Toutefois, le polycopié n’est pas censé remplacer le cours donnée en classe; il se veut

plutôt un complément, qui permet aux étudiants de revoir certains points.

3

Chapter 1

Espaces vectoriels

Alors que la notion de nombre nous semble très naturelle, celle de vecteur peut nous paraitre

artificielle. Pourtant, la nécessité d’additionner des objets plus complexes que des simples

nombres apparait naturellement quand on essaye de modéliser mêmes des phénomènes sim-

ples. Les vecteurs (et la notion d’espace vectoriel) offre le cadre pour ce type d’opérations.

En physique, on travail avec des forces (ou encore avec des vitesses, accélérations, etc.)

qu’on peut additionner pour obtenir une force totale. Une telle force n’est pas un simple

nombre, elles est formé d’un nombre (le module) accompagné d’une direction spatiale; celle-

ci ayant une importance cruciale pour comprendre l’effet de la force. En effet, la somme

de deux forces de module 1dépend fortement de leur directions. Suivant l’angle entre les

directions, la force totale peut avoir un module compris entre 0et 2.

Un autre point de vu est le suivant: imaginons une situations ou plusieurs ressources

non-interchangeables sont disponibles. Dans cette situation, un avoir n’est pas un simple

nombre, mais une collection de nombres (un pour chaque ressource). Les avoirs de plusieurs

individus, comme les forces en physique, peuvent être additionnés pour obtenir un avoir total,

lui aussi représenté par une collection de nombres.

Dans les deux exemples, on rencontre des quantités représentées par plus qu’un nombre,

mais qu’on peut additionner avec des règles similaires à ceux qu’on utilise pour additionner

des nombres. De plus, dans les deux cas, on peut aussi multiplier les quantités en questions

par des nombres. Ces deux opérations (et les règles qui les accompagnes) sont les spécificités

des espaces vectoriels.

En plus de leur intérêt comme outil de modélisation, les espaces vectoriels (avec la théorie

afférente de l’algèbre linéaire) offre un cadre pour donner de solutions simples et élégantes à

différents problèmes pratiques (voir les exemples à venir).

1.1 Définitions et exemples

On va étudier ici seulement les espaces vectoriels sur le corps des nombres réels R.

Définition 1.1. Soient Eun ensemble non-vide et + : E2→Eet ·:R×E→Edes

opérations (c.-à-d. des fonctions). On dit que Eest un espace vectoriel (e.v.)(i)si les

propriétés suivantes sont satisfaites pour tout éléments x, y, z ∈Eet λ, µ ∈R:

4

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

1

/

76

100%