Voir

La cognition auditive et la perception de la parole

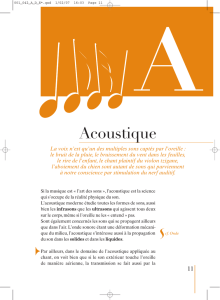

3.1.Le son et ses caractéristiques

Le son suppose une énergie émettrice ainsi qu'un support à la grande différence des ondes

électromagnétiques. Contrairement à la modalité visuelle, le son est quelque chose qui se déplace

via un support matériel, généralement l'air (il peut y avoir d'autres types de support tel que l'eau).

Il s'agit ici d'un phénomène mécanique: des ondes mécaniques nous parviennent grâce au

déplacement des molécules d'air.

Toute onde sonore se caractérise par deux paramètres

1) Amplitude: lié à la quantité de pression exercée sur le récepteur. Elle détermine l'impression

d'intensité subjective d'un son. Ces variations de pression d'air sont traduites par le décibel.

2) Longueur d'onde: quelque part associée à des nuances de sons différents en terme de

fréquence: deux ondes se distinguent en fonction de leur longueur d'onde. Un son de haute

fréquence sera perçu comme aigu, et un son de basse fréquence sera perçu comme grave. La

longueur d'onde est représentée en fonction de l'amplitude et du temps. Au plus la longueur

d'onde est élevée, au plus la fréquence sera élevée. Ça va déterminer notre impression

perceptive de hauteur du son. Elle se traduit en Hertz. L'oreille humaine peut percevoir des

sons compris entre 20 et 20000HZ et a une meilleure sensibilité au centre de cette gamme.

3) Il y a un troisième paramètre qui peut intervenir: le décalage de phase. Deux ondes sonores

peuvent présenter la même amplitude et la même fréquence, mais être en décalage de phase.

Il existe des sons purs (une seule onde), qui n'existent pas dans notre environnement, et des sons

complexes, qui sont composés d'une onde de base (fréquence fondamentale, F0) accompagnée d'une

série d'autres ondes, appelées harmoniques.

Ce sont les caractéristiques de ces harmoniques qui déterminent le timbre.

3.2.Bases neurologiques de l'audition

3.2.1. Description de l'appareil auditif

Le pavillon permet de concentrer les ondes sonores dans l'appareil ou conduit auditif. Par

exemple, lorsqu'on entend pas bien, on a tendance à agrandir la fonction du pavillon.

Le tympan: les ondes sonores sont ensuite menées jusqu'à cette fine membrane. Le tympan

se situe à la frontière entre oreille externe et oreille moyenne.

L'oreille moyenne est composée de petits osselets: le marteau, l'enclume et l'étrier, qui est à

proximité d'une autre membrane qui signe le passage entre oreille moyenne et oreille

interne, et qui se nomme fenêtre ovale. Leur fonction principale semble avoir un rôle

d'amplification des ondes sonores.

L'oreille interne est composée de deux grandes structures: la cochlée et les canaux semi

circulaires. Ils sont tous deux remplis de liquide, et la fonction des canaux semi circulaires

est de donner des informations sur l'environnement.

La cochlée est une spirale, composée d'une membrane interne qui flotte dans un liquide, c'est la

membrane basilaire. A l'extrémité de ce circuit se trouve une autre membrane, qui sert de

« sécurité », c'est la fenêtre ronde. La membrane basilaire est le siège des cellules réceptrices.

Les ondes sonores se traduisent par des vibrations des molécules de l'air. En conséquence, le

tympan émet un mouvement vibratoire, et ces ondes sont transmises et amplifiées par les osselets

pour être transmis à la fenêtre ovale. Là, elles provoquent un mouvement du liquide se trouvant à

l'intérieur de la cochlée. Sur la membrane basilaire se trouve toute une série de cellules, mais les

plus importantes sont dites ciliées, qui se comptent au nombre de 15000, et qui sont situées sur la

paroi externe de la membrane. Structurellement, elles sont coiffées d'un cil microscopique, qui se

trouve baigné dans le liquide environnant. Elles traduisent l'activité mécanique en impulsion

électrique.

Les vibrations des molécules d'air vont donc se propager dans le liquide, provoquant son

déplacement, et ces cellules vont le capter. Elles vont alors transmettre l'information vers d'autres

cellules qui se rassemblent dans le nerf auditif.

L'agencement de ces cellules réceptrices se trouvant sur la membrane basilaire n'est pas aléatoire,

car les sons de haute fréquence vont venir exciter les régions basales, alors que les sons de basse

fréquence viennent exciter la partie apicale.

Après que l'activité mécanique soit transformée en impulsion électrique par les cellules ciliées, cette

information sera acheminée par les axones vers le cortex cérébral, en passant par toute une série de

structures.

3.2.2. Les voies auditives

Le nerf auditif sort de la membrane basilaire et va rejoindre dans un premier temps les noyaux

cochléaires. L'information va être relayée au niveau des noyaux olivaires.

Il y a deux types de projection:

1) Certaines informations rejoignent les noyaux olivaires du même côté.

2) Certaines informations se croisent (pas en quantité égale).

Par conséquent, ce que l'on perçoit au niveau de l'oreille droite va être envoyé dans l'hémisphère

gauche et inversement.

Des noyaux olivaires, l'information est relayée vers les colliculi supérieurs (qui sont proches de la

structure du thalamus). On peut alors penser qu'ils auront un rôle dans les mécanismes attentionnels,

ainsi que dans la localisation des bruits de l'environnement, sachant qu'il faut intégrer les

informations visuelles et auditives.

L'information est ensuite projetée vers les corps genouillés médians, puis dans les régions à la

frontière du lobe temporal et pariétal: le cortex auditif primaire.

Par rapport à l'amplitude et aux fréquences, on s'est rendu compte que l'organisation du cortex

auditif n'était pas organisée de manière aléatoire, mais de façon tonotopique.

La fréquence est représentée dans un axe parallèle à la surface du cortex auditif, tandis que

l'amplitude est traduite par des réseaux de neurones spécialisés dans un agencement des plus basses

amplitudes vers des plus hautes amplitudes dans la profondeur du tissu cortical. L'amplitude est

représentée perpendiculairement.

Cela laisse penser que le cortex auditif traite les informations en tenant compte de ces deux

paramètres.

3.3.Le signal de la parole

« Comment les sons de la parole sont-ils produits ? »

Comme nous l'avons vu précédemment, produire les sons de la parole, c'est produire des vibrations

des molécules d'air.

Pour les sons de la parole, il y a une région du larynx très importante: les cordes vocales. L'air est

projeté des poumons dans la trachée artère, acheminé dans le larynx, puis dans le pharynx, pour

arriver dans la cavité buccale ou nasale.

En plus des cordes vocales, il y a d'autres organes importants pour la phonation; la langue (la

manière dont elle se module à l'intérieur de la cavité buccale par exemple), ainsi que l'ensemble de

la cavité buccale qui va moduler les différents sons que nous pouvons produire.

A notre naissance, nous sommes capables de produire une quantité de sons différents, mais cette

habileté est amenée à se perdre: nous ne produisons plus que les sons des langues que nous avons

acquises. Notre système perceptif se module en fonction des sons de l'environnement auxquels nous

sommes confrontés.

Phonétique et phonologie

Phonétique: étude des sons de la parole en fonction de leur caractéristiques articulatoires

(phonétique articulatoire, comment produire les sons) ou physiques (phonétique acoustique).

On s'intéresse aux phones en général.

Phonologie: relève plus de la linguistique, dans la mesure où les sons que nous produisons

peuvent construire des mots et des entités signifiantes. Elle s'intéresse aux entités minimales

signifiantes de la parole: les phonèmes. On passe dans un champ qui est du domaine de la

signification, même si on s'intéresse aux entités minimales.

Le phonème est l'unité de base de la parole. C'est la plus petite unité du signal qui véhicule une

signification. Il suffit de changer un seul phonème dans un énoncé pour en changer la signification.

La manière de prononcer les phonèmes varie en fonction de la façon d'articuler, du timbre de la

voix, des différences entre homme et femme, du dialecte utilisé,... Cela amène à des différences

dans la réalité acoustique, néanmoins, nous sommes assez performants pour aller au-delà de ces

variations.

Allophones: les différents phones qui correspondent à un même phonème.

Lorsqu'on examine les phonèmes (les phonèmes étant une représentation abstraite), on remarque

que ce sont des choses auxquelles le locuteur n'a pas accès directement. L'objectif que vise la

perception, c'est d'aller au-delà de ces variations multiples, pour en extraire des choses pertinentes.

Les phonèmes sont spécifiques de la langue. En outre des variations acoustiques possibles, ils sont

caractérisés par des choses invariantes.

Les voyelles et consonnes sont souvent classées en fonction de leurs propriétés articulatoires.

Les voyelles

Antériorité

Aperture (degré d'ouverture de la cavité buccale)

Labialité (lèvres arrondies ou pas)

Nasalité (oui on non).

Ces différents paramètres sont généralement représentés dans des triangles vocaliques, où différents

paramètres acoustiques ou phonétiques sont représentés.

De gauche à droite: voyelles dites antérieures, et à l'autre extrémité les postérieures.

Axe vertical: degré d'aperture

Pour les consonnes, il y a essentiellement deux paramètres articulatoires:

1) Le lieu d'articulation

2) Le mode d'articulation: certaines par occlusion, d'autres par modulation particulière des

organes phonatoires.

Les spectrogrammes:

Les caractéristiques du signal sont analysées au moyen d'un spectrogramme.

Il traduit graphiquement les variations d'intensité du signal en fonction de la fréquence

(ordonnée) et du temps (abscisse).

Par le spectrogramme, on remarque que les choses sont relativement continues, il y a très peu de

silence. Il y a des concentrations d'énergie (les formants). En analysant ces concentrations dans le

temps et en fonction de la fréquence, on va trouver une certain nombre de choses qui vont permettre

de trouver des différences entre les phonèmes.

En général, le spectrogramme est une représentation tridimensionnelle.

Les formants (typiques du signal de parole) permettent de distinguer l'ensemble des voyelles

F0: fondamentale

Fréquence de F1: aperture, cavité pharyngale

Fréquence de F2: antériorité, cavité buccale

Fréquence de F3: labialité, cavité labiale

=> Les harmoniques

3.4.Les processus de segmentation

Lorsqu'on examine le signal, on se rend compte qu'il n'y a pas de pause entre les mots, pas de

silence pour indice pour le système perceptif.

Chaque fois qu'il y a une occlusion, là il y a forcément une fermeture du conduit vocal.

Comment arrivons nous à regrouper les sons de l'environnement ? A les localiser (à gauche, à

droite, en haut, en bas,...). Attribuer à une même source sonore ce qui lui revient. On peut segmenter

dans cet ensemble d'onde sonores ce qui émane d'une personne qui parle ou de plusieurs personnes

qui parlent.

On suppose que c'est dans ces représentations spectrographiques que le système perceptif va puiser

des informations.

Schéma: les syllabes partagent la même voyelle mais diffèrent par la consonne initiale.

Premières: consonnées voisée.

Deuxièmes: elles diffèrent par le lieu d'articulation Elles sont non voisées (on dit également

« sourdes »).

La transition du formant: pour « ba » et « pa », la transition se fait vers le bas, pour « da » et « ta »,

elle se redresse et pour « ga » et « ka », elle est en l'air.

La transition du formant est un indice que le système perceptif peut exploiter.

Le voisement est une concentration d'énergie acoustique et varie d'une langue à l'autre:

Pour les consonnes voisées, il y a une petite différence d'intensité et un signal de

prévoisement (c'est la petite bande présente juste avant la partition). C'est la libération de

l'occlusion.

Le délai de voisement (VOT) est l'indice principal du voisement. Il traduit l'idée qu'il y a un

décalage dans le temps, une intervalle entre le relachement de l'air bloqué par le conduit vocal avant

l'ouverture de la bouche et le déclenchement des vibrations des cordes vocales. Ce décalage peut

être positif, négatif ou nul (synchronisation entre deux événements)

Les consonnes occlusives sourdes (/p/) se caractérisent par des délais de voisement longs, les

occlusives sonores (/b/) par des délais de voisement courts.

La richesse des informations présentes dans le signal permet de résoudre les problèmes d'absence

d'invariance et de linéarité dans le signal:

1) Absence d'invariance: grande variabilité présente dans le signal acoustique et qui dépend du

contexte phonétique adjacent qui caractérise ces deux ou trois syllabes. Le signal qui

correspond à une unité donnée n'est pas totalement invariant.

Les transitions formantiques pointent vers quelque chose qui n'apparait pas dans le

spectrogramme: c'est le site (ou locus). Puisque ces transitions formantiques reflètent

et pointent vers le point d'émission, le système perceptif va se baser sur le site ou

locus. Pour « da », « di » ou « du », la transition formantique au niveau du deuxième

formant pointe vers 1800Hz. Le site ou locus résoud le problème d'absence

d'invariance.

Le degré d'encodage: certains phones sont plus encodés que d'autres, dès lors qu'ils

dépendent du contexte phonétique adjacent. Les voyelles sont les plus stables, alors

que les consonnes occlusives (à l'opposé) sont les plus sensibles à cette absence

d'invariance. Entre les deux, les consonnes fricatives, où il n'y a pas de fermeture du

conduit vocal à proprement parler, mais il y a modulation des organes phonatoires.

L'énergie acoustique continue néanmoins à être libérée.

2) Absence de linéarité: le signal de parole est en réalité caractérisé par le fait que nous co-

articulons les phonèmes successifs. Au moment où on commence à articuler un mot, et qu'en

l'écoutant on entend trois sons successifs, dans le signal ces trois phonèmes successifs se

recouvrent l'un l'autre. L'information relative à chaque phonème se trouve mélangée,

enchevêtrée dans le signal. Pour certains, c'est un avantage pour le système perceptif: si il

traite séquentiellement le signal, il a déjà de l'information sur ce qui précède et sur ce qui va

suivre.

3.5.Les processus de catégorisation perceptive

Notre système perceptif est également caractérisé par le fait qu'il développe rapidement un système

optimal pour la catégorisation perceptive: c'est la perception catégorielle.

Si on analyse un système acoustique, il y a des variations continues au niveau des différentes

composantes, en termes de composition spectrale. Le système perceptif ne semble pas fonctionner

comme cela: il a une manière de traiter les informations où il minimise le bruit en faveur de la

qualité du signal.

Perception catégorielle: on prend un contraste basé sur un trait phonétique (le lieu ou le mode

d'articulation, le voisement,...). Pour le constraste Ba/Da, il y a une composition spectrale au niveau

de F1 et de F2 qui est représentée sur les spectrogrammes. C'est la transition du second formant.

Avec les outils dont on dispose, on peut créer entre le Ba et le Da toute une série de stimuli

intermédiaires simplement en modifiant l'orientation de la transition de façon à créer un continuum

acoustique.

Avec ces stimuli, on réalise deux expériences qui mobilisent deux types de tâches particulières:

1) Une tâche d'identification: on présente les 11 stimuli créés de façon aléatoire à travers un

casque, et le sujet doit identifier ce qu'il perçoit (est-ce un /ba/ ? Oui ou non). Dans le

continuum acoustique (abscisse), à une extrémité il y a un vrai /ba/ et à l'autre un vrai /da/.

Si on fonctionne à la manière d'un appareil acoustique qui analyse ces différences, on doit

s'attendre à ce que l'identification du /ba/ soit maximale à une extrémité, puis de dégrade

progressivement pour arriver à une performance totalement nulle. En réalité, nous

catégorisons: la performance est au maximum pour les quatre premiers pas, et à l'autre

extrémité du continuum, la performance est à 0%. Au milieu, il y a une grande chute, où les

sujets répondent au hasard (50%): c'est la frontière catégorielle (entre le 5 et le 7), où la

courbe d'identification chute brutalement d'un niveau d'identification optiam à un niveau

d'identification nul.

2) Une tâche de discrimination: elle consiste à présenter deux stimuli de ce continuum

acoustique (voir trois selon le paradigme). Le paradigme AX, qui est le plus utilisé, demande

au sujet de dire si le second stimulus est identique au premier (est-ce que X=A ?). Le sujet

doit donc discriminer entre les deux syllabes. La variante, le paradigme ABX, où on

présente deux stimuli successifs identiques ou différents, puis le stimulus x, et le sujet doit

dire si x est égal à A ou à B. En réalité, toutes les paires sont différentes. Aux extrémités du

continuum, les sujets répondent au niveau du hasard (50%) et au centre, leur discrimination

est optimale. (S5 à S7). La discrimination entre catégories est meillere que la discrimination

à l'intérieur de ces catégories.

6

6

7

7

8

8

9

9

10

10

1

/

10

100%