Théorème 1 - Mathématiques | Académie de Dijon

L’articulation probabilités-statistiques

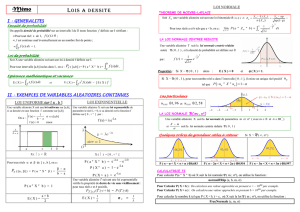

Journées de l’inspection - Octobre 2009 Page 1 Robert FERACHOGLOU

Statistiques et probabilités au lycée

« Le loto, c'est un impôt sur les gens qui ne comprennent pas les statistiques. » (Anonyme)

I – INTRODUCTION

1. Un apprentissage dans la continuité

Quelques éléments de statistique descriptive ont été introduits au collège, une initiation au

calcul des probabilités a été menée en classe de 3ème depuis la rentrée 2008. Le programme de

classe de 2nde s’inscrit dans la continuité de ce travail pour ce qui est du contenu. Le tableau sy-

noptique suivant résume l’évolution des connaissances.

Classe de 6ème

Classe de 5ème

Classe de 4ème

Classe de 3ème

Organisation

et gestion de

données

Organiser des données en

choisissant un mode de

représentation adapté.

Lire et interpréter des in-

formations à partir d’une

représentation graphique.

Représentations usuelles :

tableaux, diagrammes en

bâtons, circulaire, …,

cartésien.

Classes, effectifs, fré-

quences.

Tableaux de données :

lecture, interprétations,

élaboration, représenta-

tions graphiques.

Diagrammes, histo-

grammes.

Moyenne pondérée.

Caractéristiques de posi-

tion : médiane, quartiles.

Approche des caractéris-

tiques de dispersion : éten-

due.

Notion de probabilité.

Le programme de Seconde ne va guère plus loin sur les notions nouvelles dans ce qui est dé-

sormais désigné par « analyse des données », en institutionnalisant la connaissance des caracté-

ristiques de position et de dispersion (moyenne, médiane, quartiles).

Il introduit cependant un nouveau champ de réflexion conceptuelle sur les données, avec une ap-

proche de l’échantillonnage statistique. Cette approche avait déjà été initiée de façon qualitative

avec le programme de 2000, nous allons plus loin dans ce domaine avec la mise en évidence

d’éléments chiffrés de la fluctuation (notion d’intervalle de fluctuation au seuil de 95%).

Enfin, le programme de 2009, introduit les premiers éléments du calcul de probabilité, ce qui

est une première en classe de seconde ! Le recours à la simulation d’expériences aléatoires ren-

force et crédibilise le lien avec les statistiques, beaucoup plus que dans le programme précédent

où ces simulations étaient souvent négligées dans les pratiques, faute peut-être de trouver un an-

crage suffisant avec les autres domaines étudiés.

2. Regard sur les objectifs du programme de Seconde

Ces objectifs, relativement ambitieux, sont clairement résumés dans le libellé du programme :

« Objectifs visés par l’enseignement des statistiques et probabilités à l’occasion de résolutions

de problèmes

dans le cadre de l’analyse de données, rendre les élèves capables :

de déterminer et interpréter des résumés d’une série statistique ;

de réaliser la comparaison de deux séries statistiques à l’aide d’indicateurs de position et

de dispersion, ou de la courbe des fréquences cumulées ;

dans le cadre de l’échantillonnage :

faire réfléchir les élèves à la conception et la mise en œuvre d’une simulation ;

sensibiliser les élèves à la fluctuation d’échantillonnage, aux notions d’intervalle de fluc-

tuation et d’intervalle de confiance et à l’utilisation qui peut en être faite. »

3. Commentaires

Les objectifs affichés s’articulent autour de la statistique purement descriptive (ou : analyse

des données), qui utilise des outils mathématiques issus de la géométrie et de l’analyse, et des

L’articulation probabilités-statistiques

Journées de l’inspection - Octobre 2009 Page 2 Robert FERACHOGLOU

liens entre la statistique et les phénomènes aléatoires : l’étude de ces phénomènes se fonde sur la

notion de probabilité, comprise comme une valeur idéale de fréquence, et dont la théorie ex-

plique certains phénomènes constatés (la fluctuation d’échantillonnage) mais aussi donne un

cadre théorique rigoureux pour, à partir de ces données statistiques, formuler une prévision ou

prendre un décision. Ce deuxième aspect est plus complexe, car il met l’accent sur l’imbrication

entre statistiques et probabilités ; les statistiques permettent d’accepter ou de réfuter un modèle

théorique, les probabilités expliquent les écarts statistiques constatés et donnent des garde-fous

pour la statistique inférentielle, c’est-à-dire la statistique de la prévision ou de la décision.

Cette articulation entre statistiques et probabilités n’est pas un artifice, elle correspond à un

cheminement historique et épistémologique conjoint dans le développement de ces deux disci-

plines. Dans le bagage culturel du futur « citoyen », l’enjeu avéré du programme est de donner à

chacun un jugement le plus sain possible sur l’information chiffrée, avec l’appui d’un « bon sens

de l’aléatoire ». C’est un objectif ambitieux, d’autant plus que la France affiche un triste retard

en la matière, notamment par rapport aux pays anglo-saxons ; le retard est culturel, les perles

journalistiques relatives aux sondages et à leur interprétation, le flou affiché dans la « con-

fiance » des bulletins météo, en sont quelques traces visibles ; le retard est également visible

dans l’enseignement où, non seulement on a dressé au fil des années un rideau de fer entre statis-

tiques et probabilités (les incitations fortes des différents programmes, et notamment celui de

2000, ont peu infléchi les pratiques), mais encore on a établi une hiérarchie de fait entre ces deux

disciplines, au détriment des statistiques trop souvent considérées comme des mathématiques au

rabais. Les statistiques restent trop souvent dans la société un amas de chiffres obscurs que l’on

peut manipuler de façon machiavélique – ce qui n’est pas toujours faux – pour rendre opaque une

vérité ou la déformer. Les citations abondent dans ce sens ; en voici trois :

« Il y a trois sortes de mensonges : les mensonges, les sacrés mensonges et les statistiques. »

(Mark Twain)

« La statistique est la première des sciences inexactes. » (Jules de Goncourt)

« Faites attention, la statistique est toujours la troisième forme du mensonge. » (Jacques Chirac)

Chacun pourra tester son propre sens de l’aléatoire dans l’exemple qui suit. On a consigné ci après

quatre séries de 100 chiffres 0 ou 1, dont une seule a été obtenue de façon aléatoire. Il s’agit de dé-

terminer laquelle.

Série 1

Série 2

Série 3

Série 4

1

1

1

1

1

1

1

0

1

1

0

1

0

1

1

1

0

1

0

0

1

1

0

0

1

0

0

1

0

1

1

1

0

0

1

0

0

1

0

1

1

1

1

1

1

1

1

1

1

1

1

1

0

1

0

1

1

0

0

0

0

1

0

1

0

0

0

1

0

1

0

1

0

1

0

0

0

1

0

1

1

1

1

1

0

1

1

1

1

1

1

1

0

1

1

0

1

1

0

1

1

0

1

1

0

0

0

1

0

0

1

0

1

1

0

0

0

1

0

0

1

1

0

0

0

1

1

1

1

1

0

1

1

1

0

1

0

0

0

1

1

1

1

0

1

0

1

1

0

1

1

1

1

0

1

0

1

1

0

1

1

1

0

1

1

1

0

0

1

1

1

0

0

1

1

0

0

1

1

0

1

1

0

0

1

0

1

0

1

0

1

1

0

0

1

0

1

0

1

0

1

1

1

0

1

1

0

1

0

1

1

0

1

0

0

0

1

0

1

1

0

1

0

0

1

1

0

1

1

0

0

1

0

0

1

1

0

1

1

0

1

1

0

1

1

1

1

1

1

1

0

0

1

0

1

0

0

1

1

1

0

1

0

1

1

0

1

1

0

1

0

1

0

1

1

0

1

1

0

1

0

1

1

1

1

0

1

1

1

1

0

0

1

0

0

1

0

0

1

0

1

0

1

0

1

0

0

1

1

1

1

0

1

0

1

0

0

1

1

1

1

1

1

1

1

1

1

1

0

0

1

0

0

0

1

0

1

1

1

0

0

1

1

0

1

0

0

1

1

1

0

1

1

0

1

0

0

1

1

1

0

0

1

1

1

1

1

1

1

1

0

1

1

0

0

1

0

0

0

1

0

1

0

1

0

0

0

1

1

0

0

1

0

1

0

0

0

1

1

0

Nombre de 0 :

18

Nombre de 0 :

51

Nombre de 0 :

48

Nombre de 0 :

42

Nombre de 1 :

82

Nombre de 1 :

49

Nombre de 1 :

52

Nombre de 1 :

58

Nombre de blocs

25

Nombre de blocs

62

Nombre de blocs

66

Nombre de blocs

53

L’articulation probabilités-statistiques

Journées de l’inspection - Octobre 2009 Page 3 Robert FERACHOGLOU

Commentaires

La première idée est de regarder la fréquence d’apparition des chiffres, ce qui permet d’éliminer la

première série, qui comporte trop de 1. Le nombre de 1 est en effet une variable aléatoire qui suit

une loi binomiale de paramètres 100 et 0,5 ; sa moyenne est

50m

et son écart-type

5

. Sa loi

est proche d’une loi normale ayant les mêmes paramètres, pour laquelle environ 95 % des échantil-

lons aléatoires sont contenus dans l’intervalle

2 , 2mm

, c’est-à-dire [40, 60]. Au seuil de

95%, on peut donc réfuter le caractère aléatoire de la série 1, et accepter celui des séries 2, 3, 4.

On peut également considérer le nombre de blocs, c'est-à-dire de suite de termes analogues dans

chacune des séries. Formellement, si

1

X

, …,

100

X

sont les 100 variables de Bernoulli donnant la va-

leur des 100 chiffres, cela consiste à introduire comme compteurs de blocs les variables

1 100

()

ii

Y

ainsi définies :

11Y

et pour

2 100i

,

1

i

Y

si

1ii

XX

et

0

i

Y

si

1ii

XX

.

Alors

100

1i

i

SY

représente le nombre total de blocs.

On a

1

( ) 1EY

et pour

2 100i

,

1

() 2

i

EY

, donc

( ) 1 99 0,5 50,5ES

; c’est le nombre

moyen de blocs.

De plus,

1

( ) 0VY

et pour

2 100i

,

1

() 4

i

VY

et les

i

Y

sont indépendantes, donc

( ) 99 0,25 24,75VS

. Cela fournit :

( ) 5S

.

Pour environ 95% des échantillons aléatoires, le nombre de blocs est donc compris entre 40,5 et

60,5, ce qui permet de réfuter le caractère aléatoire des séries 2 et 3 : elles ont trop de blocs pour être

obtenues par hasard. (En fait, ces séries ne comportent pas de séries de chiffres consécutifs de lon-

gueur supérieure à 3 : c’est également extrêmement rare.)

II – LA STATISTIQUE DESCRIPTIVE

1. Appréhender une série statistique

Une série statistique livre un ensemble de données brutes. Lorsqu’elles sont nombreuses, ces

données demandent d’être résumées pour en tirer un enseignement. Les graphiques et les para-

mètres constituent les principaux résumés, visuels et numériques. Deux points sont essentiels

dans la formation des élèves :

s’habituer à poser des questions a priori, comme par exemple : « quel résumé semble le

plus pertinent pour une étude donnée ? », « quels paramètres sont intéressants à calcu-

ler ? » ;

s’entraîner à comprendre et interpréter les résumés, qu’ils soient visuels ou numériques,

et les exploiter pour en tirer un élément de réponse.

Le programme insiste sur la nécessité de travailler le plus souvent possible sur des données ré-

elles ; la mise à disposition de fichiers numériques permettra un travail sur ordinateur, d’autant

plus justifié que ces données seront nombreuses et complexes. Le document ressource préconise

le recours à quelques fichiers qui serviront de fil rouge. Par exemple le fichier de l’INSEE sur les

36723 communes françaises, disponible sur le site http://www.insee.fr/fr/ppp/bases-de-

donnees/recensement/populations-legales/france-departements.asp, permet de mener des travaux

intéressants sur des exemples de représentations graphiques, des tris, des calculs de fréquences,

des calculs de paramètres et leur interprétation, des comparaisons de populations, d’étudier les

effets de différents regroupements, d’utiliser le cumul des fréquences, de prélever des échantil-

L’articulation probabilités-statistiques

Journées de l’inspection - Octobre 2009 Page 4 Robert FERACHOGLOU

lons, d’observer la fluctuation d’échantillonnage, de découvrir la loi de Benford, d’introduire les

rudiments du calcul des probabilités, ….

2. Résumer une série statistique

a) Position du problème

Une série statistique numérique offre un premier résumé visuel naturel tel que l’histogramme

(ou le diagramme en bâton, en barres, …). Ce graphique pose la question de trouver un résu-

mé numérique adéquat, à l’aide de paramètres chiffrés traduisant trois notions visuelles :

- la tendance centrale (centre de gravité, valeur « sommitale », valeurs de partage) ;

- la dispersion des données ;

- la forme du graphique (aplatissement, asymétrie).

Seules les deux premières notions sont envisagées au lycée ; il n’est pas inintéressant pour un

professeur d’en étudier un aspect théorique, qui ne sera pas présenté aux élèves.

b) Lien théorique entre tendance centrale et dispersion

On identifie la série statistique

1

x

, …,

n

x

au vecteur

1

( , ..., )

n

x x x

d’un espace euclidien de

dimension n, identifié à

n

.

Une valeur centrale est par définition une constante c telle que le vecteur constant

( , ,...; )c c c c

est proche de

x

, au sens suivant : la distance entre

x

et

c

doit être minimale.

La valeur de cette distance minimale est, toujours par définition, la dispersion associée à la

valeur c.

On peut envisager cela avec quelques distances classiques dans

n

:

1

( , ) ii

in

d x y Max x y

;

1

1

( , ) ii

in

D x y Max x y

n

;

11

( , ) ii

in

d x y x y

;

11

1

( , ) ii

in

D x y x y

n

;

1

2

2

21

( , ) ( )

ii

in

d x y x y

1

2

2

21

1

( , ) ( )

ii

in

D x y x y

n

(d2 est la distance eucli-

dienne) ;

1

1

( , ) ( ) p

p

p i i

in

d x y x y

1

1

1

( , ) ( ) p

p

p i i

in

D x y x y

n

pour p entier,

1p

.

Les trois résultats suivants donnent le paramètre de tendance centrale et la dispersion asso-

ciée, relativement à trois de ces distances, parmi les plus classiques.

Théorème 1

( , )d x c

est minimal lorsque c est égal à la moyenne des valeurs extrêmes de la série. La

valeur de ce minimum est la demi-étendue de la série.

La démonstration est immédiate.

Théorème 2

1( , )D x c

est minimal lorsque c est égal à la médiane Me de la série. La valeur de ce mini-

mum est l’écart moyen à la médiane (EMM).

La démonstration du premier résultat peur être conduite en cycle terminal de la série S pour

une série ayant 3 ou 4 valeurs, admise pour les séries d’ordre supérieur.

L’articulation probabilités-statistiques

Journées de l’inspection - Octobre 2009 Page 5 Robert FERACHOGLOU

Théorème 3

2( , )D x c

est minimal lorsque c est égal à la moyenne

x

de la série.

La valeur de cette distance euclidienne minimale est l’écart-type de la série.

Ce résultat, hors de portée des élèves de lycée, se justifie de deux façons :

- analytiquement, en étudiant le minimum de

2

1()

i

in

x x x

;

- géométriquement, en remarquant que la distance euclidienne dérive d’un produit sca-

laire, et que la distance minimale de

x

à la droite vectorielle engendrée par

c

, qui est

aussi engendrée par le vecteur

(1,...,1)u

, est minimale pour le projeté orthogonal sur

cette droite vectorielle. Ainsi

c

doit être le projeté orthogonal de

x

sur

u

; il est calcu-

lé par les conditions :

( ,..., )c c c

et

..c x c c

.

On en tire :

2

1... . .

n

cx cx c x c c nc

.

D’où :

1... n

xx

cx

n

(moyenne de la série).

La dispersion associée est la distance minimale correspondante, soit :

1

2

2

21

1

( , ) ( )

i

in

D x x x x s

n

(c’est l’écart-type de la série).

Ainsi, le couple (moyenne, écart-type) joue-t-il un rôle privilégié parmi les paramètres.

c) Que choisir en classe ?

L’aspect théorique précédent ne doit pas être soulevé en classe ; il a cependant le mérite

de montrer que les résumés numériques fonctionnent par deux : un paramètre de tendance

centrale et l’indicateur de dispersion qui lui mathématiquement associé. Il faut également re-

tenir que les valeurs extrêmes de la série ainsi que le seul paramètre de dispersion qui est of-

ficiellement au programme de seconde, à savoir l’étendue, ne doivent pas être méprisés

même s’ils sont relativement grossiers : ils interviennent en liaison avec la distance

d

. Ces

paramètres ont d’ailleurs une importance réelle dans les séries statistiques où intervient un si-

nistre, voire une catastrophe ; ainsi les plans d’occupation des sols doivent tenir compte des

hauteurs maximales des cours d’eau plutôt que de leur hauteur moyenne, les normes sis-

miques des bâtiments que l’on construit prennent la mesure des plus grandes magnitudes

constatées des séismes, etc.

D’autre part, il est important de montrer aux élèves que, pour une série numérique,

moyenne et médiane peuvent être très différentes, et de les entraîner à réfléchir à la perti-

nence du choix des paramètres. La moyenne est très usuelle, mais elle est peu robuste relati-

vement à des valeurs extrêmes très élevées ; ainsi le salaire moyen en France est relativement

trompeur pour rendre compte du revenu des habitants. Les paramètres d’ordre et leur repré-

sentation (médiane, quartiles, déciles, boîtes de dispersion) sont souvent plus appropriés. De

plus ces paramètres donnent du sens à la fonction cumulative des fréquences, dont

l’équivalent probabiliste est la fonction de répartition d’une variable aléatoire.

III – DÉFINIR UNE LOI DE PROBABILITÉ

1. Expérience aléatoire et modélisation

a) Qu’est-ce que modéliser ?

Modéliser une expérience aléatoire, c’est définir les résultats possibles (appelés « résultats »

ou « issues » ou encore « événements élémentaires »)

1

x

, …,

n

x

, que l’on supposera être en

nombre fini en classe de seconde, et leur affecter une suite de nombres

1

p

, …,

n

p

tous positifs

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

1

/

22

100%