ce que vous devez savoir - Les

Université Jean Monnet

L. P. Gestion de la Production Industrielle

1

STATISTIQUES

I. Théorie des tests statistiques :

1) L’idée :

Pour contrôler une production, on peut contrôler un à un chacun des objets produits. En

général on ne le fait pas, car cela revient très cher et, sur une production très importante, la tâche est

suffisamment ennuyeuse pour qu’elle soit mal faite : il reste des défauts après contrôle. On préférera

contrôler une partie des pièces et en déduire la qualité générale. On utilise alors des procédures de

test, dont beaucoup sont normalisées.

Le test va nous donner un résultat probable (donc avec un risque de se tromper !) peu coûteux.

Mais il faut avoir une propriété à tester, appelée ici une hypothèse (par exemple : ‘plus de 99% des

produits sont corrects’, ou bien ‘la longueur moyenne des tiges est 123 mm’).

2) Méthodologie des tests d’hypothèse :

Il nous faut, au départ, une hypothèse à tester. Nous la mettrons toujours sous une forme

précise (par exemple : ‘99% des produits sont corrects’ à la place de ‘plus de 99% des produits sont

corrects’), de façon à pouvoir calculer des probabilités précises. On l’appelle classiquement H0. On lui

associe généralement l’hypothèse alternative, notée H1.

Il nous faut aussi savoir quelle confiance accorder au test. On donne en général un risque,

plus précisément le risque de rejeter l’hypothèse, alors même qu’elle est vraie. Notons le r.

On détermine ensuite une procédure et un nombre (ou une série de nombres), à calculer au

cours du test (à partir des résultats du test). Notons x ce nombre.

A l’aide de ces éléments, nous déterminerons, en appliquant les techniques de calcul de

probabilités, une zone de valeurs pour le nombre x, zone dans laquelle il se trouve avec la probabilité

1-r si l’hypothèse H0 est vraie (donc H0 étant vraie, le risque que x ne se trouve pas dans la zone est r).

Le test théorique peut alors être énoncé ( x est dans la zone : on accepte H0 ; x n’est pas dans la zone :

on rejette H0).

Par exemple, on veut tester le fait que 99% des pièces sont correctes en fin de fabrication, en

prenant au hasard 10 pièces. L’hypothèse à tester est H0 : « 99 % des pièces sont bonnes »,

l’hypothèse alternative est « moins de 99% des pièces sont bonnes ». La procédure est « échantillon

de 10 pièces », le nombre x sera le nombre de pièces incorrectes, parmi les 10. Enfin, on va prendre

un seuil de risque de 5% (seuil très classique). Sachant que 1% des pièces sont incorrectes (hypothèse

H0), on peut calculer la probabilité de trouver k pièces mauvaises parmi les 10 (cf. II) :

k

0

1

2

3

4

5

6

7

8

9

10

Pr( X = k ) (%)

90,4

9,1

0,4

0,01

0

0

0

0

0

0

0

(les probabilités pour k supérieur ou égal à 4 ne sont pas parfaitement nulles, mais infimes : de 2 10-3

à 10-18 – dans ce tableau, X est la variable aléatoire « nombre de pièces incorrectes » qui modélise x).

On cherche ensuite une zone de valeur dans laquelle on a au moins 95% de chance de trouver x.

Le choix de cette zone sera guidé par une ‘heuristique’ (c. a d. une méthode qui guide la recherche).

Ici, il est évident que nous serons inquiets si x est important, et satisfaits si x vaut 0. Donc on cherche

un intervalle [0 , n], avec n le plus faible possible. Le tableau montre que [ 0 , 1 ] convient : x sera

dans cet intervalle avec une probabilité au moins égale à 95% (en fait 99,5%), et on a un risque

inférieur à 5% que x n’y soit pas alors même que le taux de pièces incorrectes est de 1%.

2

Le test théorique est donc : Compter le nombre x de pièces incorrectes dans l’échantillon. Si x

vaut 0 ou 1 on accepte l’hypothèse, sinon on la rejette.

Remarquons que le test est un peu faible, car on ne rejettera l’hypothèse (99% des pièces sont

bonnes) que si l’on trouve 2 pièces incorrectes sur 10, c’est à dire 20% de pièces incorrectes. Pour

améliorer l’efficacité du test, il faudrait prendre bien plus de 10 pièces dans l’échantillon.

3) Risques de première et de deuxième espèce :

Le risque dont la valeur est donnée ( r ) est la probabilité de rejeter H0 alors même qu’elle est

vraie. On l’appelle le risque de première espèce. Il existe en effet un autre risque, le risque de

deuxième espèce, qui est le risque d’accepter H0 alors que cette hypothèse est fausse. Ce risque est

plus difficile à calculer, et n’est pas un nombre comme r, car la probabilité d’accepter H0 alors qu’elle

est fausse dépend du degré de fausseté de H0.

Par exemple, dans l’exemple du 2), on peut calculer, pour chaque valeur de la proportion p

de pièces correctes, la probabilité d’accepter H0 (c’est à dire de trouver 0 ou 1 pièce incorrecte). Par

exemple, pour p = 0.98, on a les valeurs suivantes :

k

0

1

Plus de 2

Pr( X = k ) (%)

81,7

16,7

1,6

Et donc on a 98,4% de risque d’accepter H0 . Le risque de deuxième espèce est de 98,4% pour 2

fois trop de pièces défectueuses, ce qui nous montre que notre test est sans utilité puisqu’on est

presque sûr d’accepter deux fois trop de pièces défectueuses.

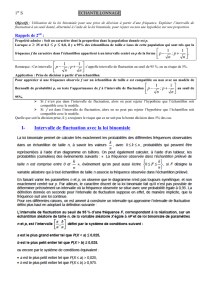

On peut définir une fonction ‘risque de deuxième espèce’, en fonction de p : R(p) = Pr( X = 0) +

Pr( x = 1) = p9 ( 10 –9 p ) (où p varie de 0 à 1). Sa courbe est :

et l’on voit que le risque de deuxième espèce ne devient faible que pour des valeurs de p de l’ordre de

0,6 (moins de 5% si p < 0,6058). Ce qui nous confirme que le test choisi n’est pas efficace.

4) Fonction de puissance d’un test :

Dans la plupart des tests que nous rencontrerons, nous pourrons, comme ci – dessus,

déterminer, en fonction d’un paramètre lié à l’hypothèse, une fonction ‘risque de deuxième espèce’, et

son complémentaire, la fonction de puissance du test. Elle donne, pour chaque valeur du paramètre la

probabilité d’acceptation de H0. Notre intérêt est qu’elle soit presque égale à 1 lorsque l’hypothèse est

satisfaite et presque nulle lorsque l’hypothèse est fausse, donc qu’elle varie abruptement dans la zone

où l’on passe de ‘H0 est vraie’ à ‘H0 est fausse’.

Pour 80% de pièces correctes (donc 20% de

déchets, la probabilité de réussite du test est

proche de 0,4 (40%).

Pour 60% de pièces correctes (donc 40% de

déchets, la probabilité de réussite du test est

proche de 0,05 (5%).

3

Par exemple, pour contrôler le taux de moins de 1% de pièces défectueuses, on utilisera un

échantillon de 100 pièces .Par la même méthode que ci dessus on trouve que le test est : si le nombre

de pièces défectueuses k est inférieur ou égal à 3, on accepte l’hypothèse (donc on considère les

pièces comme acceptables en général) ; si k>3 on rejette H0, donc on décide qu’il y a trop de pièces

défectueuses (Le seuil de risque est toujours de 5%). La fonction de puissance a comme courbe :

On voit qu’on passe assez rapidement de

0 à 100% de réussite au test, et que ce

test n’a aucune chance de réussir

lorsque p vaut 0,8. Dans le test avec 10

pièces, on avait encore 40% de chances

de réussites pour p = 0,8.

Un test sur 200 pièces donnera une courbe encore plus abrupte, et restant pratiquement à 0

plus longtemps.

5) Le test du Khi – deux :

C’est un test d’adéquation d’une répartition de population statistique à un modèle

probabiliste. Autrement dit, l’hypothèse testée est que la population considérée a une répartition en

classes analogue à un tirage au hasard d’une variable aléatoire suivant la loi modèle.

Par exemple, le nombre d’appel au service de maintenance d’une entreprise, jour par jour, a

été recensé, et on a trouvé :

Nombre d’appels

0

1

2

3

4

5

6

Plus de 6

Nombre de jours

12

45

51

32

16

10

6

11

Une des modélisations classique des événements peu fréquents se fait par la loi de Poisson.

La moyenne étant 2,83 appels, on sera tenté de modéliser par la loi P( 2,83). Pour tester cette

hypothèse, nous répartissons les 183 jours suivant la loi de poisson (nombre théorique = 183

Pr(X=nombre d’appels ) :

Nombre d’appels

0

1

2

3

4

5

6

Plus de 6

Nombre théorique

10,9

30,9

43,7

41,2

29,2

16,5

7,8

2,8

Les nombres sont différents, mais une répartition aléatoire suit souvent de très loin le modèle.

Il faut estimer si la différence est anormale ou pas. Pour cela on calcule le nombre :

8,2

8,211

8,7

8,76

5,16

5,1610

2,29

2,2916

2,41

2,4132

7,43

7,4351

9,30

9,3045

9,10

9,1012 22222222

2

On mesure ainsi un écart entre la valeur modèle et la valeur réelle, élevé au carré pour

donner de l’importance aux grands écarts, mais divisé par la valeur théorique pour équilibrer (un

écart fort sur une classe importante est moins significatif que si la classe a un effectif théorique

faible). On trouve

2 = 42,78. Noter que l’essentiel de la valeur de

2 est donnée par la classe plus de

6.

Le nombre 42,78 est ensuite comparé à un nombre test fonction du nombre de classes étudiées (ici 8,

donc 7 ‘degrés de liberté’, puisque la connaissance de 7 des nombres théoriques permet de trouver le

8e, car le total 183 est connu) et du seuil de risque choisi (prenons le classique 5%). Les tables de la

loi du

2 donnent

2théorique = 14,06. 42,78 étant supérieur, le test échoue, et on peut conclure que le

modèle avec la loi de Poisson ne convient pas.

Le test se construit ainsi : On considère l’hypothèse H0 : ‘Les données recueillies

correspondent à la réalisation d’une variable aléatoire connue’. L’hypothèse alternative est H1 : ‘Les

4

données recueillies ne correspondent pas’. Notons r le risque. On répartit les données en différentes

classes, en comptabilisant le nombre de cas où les données sont dans chaque classe. Une réalisation

d’un modèle donné donne des effectifs de classe qui différent légèrement des valeurs théoriques (ne

serait – ce que parce que les effectifs de classes sont des entiers). Le calcul du nombre :

théoriqueeffectif

théoriqueeffectifréeleffectif

2

2

nous donne une idée de la ‘distance’ entre la réalisation et le modèle. Si les données sont très proches

du modèle, le 2 sera faible, et si elles sont notablement différentes, le 2 sera fort. On s’attend donc à

avoir 2 faible lorsque H0 est vraie. On prend alors comme zone d’acceptation de l’hypothèse un

intervalle [ 0 , a ] dans lequel 2 sera avec la probabilité 1 – r.

Sous l’hypothèse H0 , la loi de 2 est complexe, mais s’approxime très bien lorsque les classes n’ont

pas des effectifs trop faibles (on considère que 5 est un minimum). La loi utilisée est la loi du 2 à

( n – p ) degrés de liberté où n est le nombre de classes, et p le nombre d’effectifs théoriques que l’on

peut calculer en connaissant les autres. On donne généralement la loi du 2 par des tables qui donnent,

pour un risque r et un nombre n de degrés de libertés donnés la valeur a telle que Pr{ 2n > a } = r. On

a ainsi la limite de l’intervalle d’acceptation, et on peut appliquer le test :

2calculé < a : Le test réussit ; Le modèle peut être utilisé.

2calculé > a : Le test échoue ; Avec le risque r de se tromper, on peut affirmer que le modèle ne

convient pas

Attention :

L’échec du test ne permet pas d’affirmer avec certitude que le modèle ne s’applique pas (il

existe des réalisations extrêmes d’une loi donnée). Le fait qu’il réussisse ne prouve pas que le

modèle est sûrement le bon (il a pu réussir alors que ce n’était pas cette loi qui convenait).

Mais en général on peut s’appuyer sur ce test pour confirmer une intuition, ou, comme dans

l’exemple ci – dessus, rejeter un modèle à priori.

Si les classes sont trop petites (en particulier pour des classes vides), on regroupe plusieurs

classes, de façon a obtenir des effectifs supérieurs à 5. Dans l’exemple ci – dessus, il convient

de regrouper les classes 6 et plus de 6, et le 2théorique devient (pour 6 ddl) 12,59 alors que le

2calculé vaut 22,21. La conclusion est la même, mais la pratique est plus saine.

De nombreux logiciels calculent, pour des tables à deux dimensions, des seuils de

signification (par exemple dans les tris croisés des logiciels de statistiques). Le test est celui

de l’indépendance des données, et on souhaite montrer qu’elle est fausse, donc que le test

échoue. Ils ne donnent pas de conclusion de test (faute d’avoir le seuil de risque), mais

donnent une probabilité annoncée comme un seuil de confiance. En fait, il s’agit du seuil de

confiance ( 1 – r ) pour lequel la valeur test a est juste égale au résultat 2calculé . La méthode

est donc à interpréter avec précaution, mais il est facile de voir qu’un seuil de confiance très

proche de 100% donne une bonne raison de penser que les variables sont dépendantes.

II. Théorie de l’échantillonnage :

1) L’idée :

Dans de nombreux cas il est impossible d’avoir un résultat statistique exact ; soit la

population n’est pas accessible (répartition des poissons dans le lac Léman), soit elle évolue dans le

temps (qualité d’une production industrielle), soit le recensement complet est impossible (étrangers en

situation irrégulière) ou illusoire (personnes sans domicile fixe). On ne testera alors qu’une partie La

théorie de l’échantillonnage montre qu’une analyse d’une partie bien choisie de la population peut

donner de bons résultats.

Une difficulté existe cependant : le choix de l’échantillon. La façon de choisir les individus de

l’échantillon peut influer sur le résultat (faire un sondage sur la santé des français par téléphone donne

un résultat de meilleure santé que dans la réalité car les personnes très malades sont à l’hôpital ; On

5

dit que l’échantillon est biaisé). Nous ne traiterons que des échantillons pris au hasard dans la

population (la façon de choisir est hors de notre étude).

Nous allons étudier différents cas (proportion dans une population, moyenne d’un caractère,

etc.). Pour cela nous considérerons d’abord la population parfaitement connue, et nous en déduirons

la façon dont se comportent les échantillons (qui peuvent varier dans de grandes proportions). Dans

un deuxième temps, nous essaierons de prédire, à partir de la connaissance d’un échantillon, les

caractéristiques inconnues d’une population.

2) Estimation d’une proportion :

On teste des individus. S’ils répondent à un ou plusieurs critères (dimensions, poids, aspect,

etc. ), ils sont conformes. Attention, dans ce cadre, le mot ‘conforme’ n’a pas le sens habituel, il veut

simplement dire ‘qui correspond au critère donné’. Nous allons d’abord étudier ce qui se passe dans

les échantillons.

2 . 1 ) Cas général :

Dans une population d’effectif N, P individus sont conformes. On prend un

échantillon d’effectif n et on s’intéresse à la variable aléatoire Q : nombre d’individus conformes dans

l’échantillon. On a :

n

N

knPN

k

P

C

CC

kQP

)(

( Loi hypergéométrique )

Cette loi est très peu maniable, sauf si N est petit (ça arrive!). Elle se simplifie par

approximation lorsque n est petit par rapport à N. Retenons cependant que :

pn

N

P

nQ

(où p est la proportion d’individus conformes) et V(Q) =

1

1

NnN

ppn

On montre que, lorsque N est grand, et grand par rapport à n, la loi hypergéométrique est proche

d’une loi binomiale. On retrouve alors les valeurs caractéristiques

pnQ

et V(Q) = n p ( 1 – p ).

2 . 2 ) Echantillon petit par rapport à la population :

Lorsque N est très grand par rapport à n (classiquement N > 10 n ) et n n’est pas trop

réduit, on peut approximer la loi de probabilité de Q par une loi binomiale B( n , p ), où p est la

proportion d’individus conformes de la population :

P Q k B n p k C p p p P

N

n

k k n k

( ) ( , )( ) ( )

1 avec

Par exemple, si 35% des français possèdent une voiture de marque française, sur 20

personnes interrogées au hasard, le nombre de celles qui ont une voiture française pourra varier de 0

à 20, avec les probabilités suivantes :

Nombre

0

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

Proba

(en %)

0

0,2

1

3,2

7,4

12,7

17,1

18,4

16,1

11,6

6,9

3,4

1,4

0,4

0,1

0

0

0

0

0

0

Les probabilités marquées 0 ne sont pas strictement nulles, elles sont inférieures à 0,05%.

Ces cas sont donc très improbables.

On voit que les valeurs possibles de Q sont nombreuses, même si l’on ne considère que les

relativement probables (de 4 à 10, la probabilité dépasse 5%, une chance sur 20). Il est important de

se souvenir que les valeurs possibles du nombre de conformes dans l’échantillon peuvent être très

variables (C’est ce que l’on appelle la dispersion d’échantillonnage)

6

6

7

7

8

8

9

9

1

/

9

100%

![1 Estimateurs (inspirés de [1]) 2 Estimateurs du maximum de](http://s1.studylibfr.com/store/data/000902399_1-b3fad4126456d0451d3a3a71ba072ca5-300x300.png)