Chapitre III.6

CHAPITRE III

SUITES D’EXPERIENCES ALEATOIRES

III.1. Le modèle

Nous commençons par introduire un modèle abstrait, qui généralise le jeu « pile ou face ».

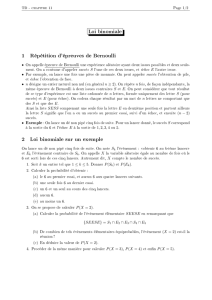

III.1.a. Le modèle abstrait – le processus de Bernoulli

Considérons une suite d’essais d’une même expérience aléatoire que l’on répète indéfiniment

de telle sorte que les conditions soient toujours identiques et que les résultats des différents

essais soient sans influence mutuelle. Supposons que l’expérience n’a que deux résultats

possibles, succès ou échec, et la probabilité du succès soit un nombre p dans l’intervalle [0,1].

Nous appelons une telle suite d’essais un processus de Bernoulli. Il s’agit d’un cas particulier

simple du concept plus général (étudié au Ch.V.) de suite d’expériences aléatoires

indépendantes.

Il est commode d’écrire 1 ou 0 au lieu de « succès » ou « échec ». On peut donc décrire les

résultats d’une suite d’expériences par une suite de 0 et de 1 que l’on notera (Xi) où Xi vaut 0

ou 1 suivant que la i-ième expérience est un échec ou un succès. On dit que (Xi) est une suite

de variables aléatoires indépendantes (voir Ch. IV. pour la définition formelle des variables

aléatoires et Ch. V. pour la définition de l’indépendance).

L’espace fondamental d’un essai est l’ensemble {0,1}. Le processus de Bernoulli dépend d’un

seul paramètre p, la probabilité du succès, et on a

P(Xi = 1) = p et P(Xi = 0) = 1 – p

Définition : On dit que Xi suit une loi de Bernoulli de paramètre p où p est la probabilité de

succès. On écrit

Xi ∼ Bernoulli( p ) ou Xi ∼ B(1, p )

Xi est appelé variable aléatoire de Bernoulli ou plus brièvement variable de Bernoulli.

Si on fait un nombre d’essais N < ∞, l’ensemble fondamental du processus de Bernoulli est

donné par E = {0,1}N. E est l’ensemble de toutes les suites finies de longueur N (ou de N-

uplets) de 0 et de 1, donc card(E) = 2N. En utilisant l’indépendance des essais on trouve que la

probabilité d’une suite est donnée par

P(X1 = x1 , X2 = x2 ,…, XN = xN ) = pnombre de 1(1 – p)nombre de 0 =p #1(1 – p)#0 = p #1(1 – p)N - #1

où xi ∈ {0,1}. En particulier, si p = ½, chaque suite a la même probabilité 1/2N.

Dans le cas où le nombre d’expériences est infini l’ensemble fondamental du processus de

Bernoulli est donné par E = {0,1}IN. E est l’ensemble de toutes les suites infinies indexées

par 0 et 1. On peut montrer que E n’est pas dénombrable, et la probabilité de toute suite (xi)

donnée est nulle ! Bien entendu cela ne signifie pas que la probabilité de tout événement est

nulle.

III.1.b. Exemples

Exemple 1 : Pile ou face

On jette une pièce N fois. On pose Xi = 1 si le résultat du ième jet est pile et Xi = 0 si le résultat

du ième jet est face. Pour une pièce non biaisée p = ½.

Exemple 2 : Problèmes d’urne – tirages avec remise

Une urne contient m boules dont k sont blanches et l = m – k sont noires. On tire N fois une

boule avec remise. On pose Xi = 1 si la ième boule est blanche et Xi = 0 si la ième boule est

noire. On a p = k/m.

Exemple 3 :

Dans chaque unité de temps un appel arrive dans un central téléphonique avec une probabilité

égale à p. On pose Xi = 1 si un appel arrive dans la ième unité du temps et Xi = 0 sinon.

Exemple 4 :

Les transistors fabriqués par une machine sont affectés d’un défaut avec probabilité p. L’état

d’un transistor est indépendant de celui des précédents ou suivants. On pose Xi = 1 si le

transistor a un défaut et Xi = 0 sinon.

Exemple 5 :

On exécute une suite d’épreuves indépendantes. La probabilité qu’un certain événement A est

réalisé dans une épreuve est égale à p = P(A). On pose Xi = 1 si A est réalisé et Xi = 0 sinon.

III.2. La loi binomiale

III.2.a. Le nombre de succès

On définit

SN = X1 + … + XN

où Xi prend des valeurs dans {0,1}. Donc SN est égal au nombre de succès pendant les N

premières expériences. La loi de SN est donnée par

P(SN = k) = CkN pk(1 – p)N – k.

Pour établir cette loi il faut d’abord remarquer que chaque suite de longueur N comportant k

succès a pour probabilité pk(1 – p)N – k. Evidemment il y a CkN possibilités de placer k succès

parmi les N tirages.

Notons, qu’une application de la formule du binôme de Newton (voir Ch. I.2.d.), donne que la

somme de tous les P(SN = k) est 1 :

()

00

() (1) (1)1

NN N

kk Nk

NN

kk

PS k C p p p p

−

==

== − =+− =

∑∑ .

Définition : On dit que SN suit une loi binomiale de paramètres (N, p ) où N désigne le

nombre d’expériences et p est la probabilité de succès dans un essai. On écrit

SN ∼ B(N, p )

SN est appelé variable aléatoire binomiale ou plus brièvement variable binomiale.

Exemple 1: On tire (avec remise) 5 boules dans une urne contenant 10 blanches, 15 noires et

25 rouges. Quelle est la probabilité de tirer 3 boules blanches ?

Solution : On décide ici que le tirage d’une boule blanche est un succès et que le tirage d’une

boule rouge ou d’une boule noire est un échec. Ainsi la probabilité p de succès pour chaque

tirage est p = 10/50 = 1/5. Les tirages s’effectuant avec remise, nous sommes dans le cadre

des tirages indépendants, i.e. d’un processus de Bernoulli. Le nombre S5 de boules blanches

tirées lors de 5 tirages avec remise suit donc une loi binomiale de paramètres N = 5 et p = 1/5.

Alors

P(S5 = 3) = C35 (1/5)3(4/5)2 = 32/625

Exemple 2: Un système de communication comporte 5 composants. Chacun d'entre eux

fonctionnera, indépendamment des autres, avec une probabilité 0.7. Le système total pourra

fonctionner si au moins la moitié de ces composants sont opérationnels. Calculer la

probabilité que le système ne fonctionne pas.

Solution : Soit X le nombre de composants opérationnels. X est une variable aléatoire

binomiale de paramètres 5 et 0.7. La probabilité que le système ne fonctionne pas est donnée

par

P(X=0) + P(X=1) + P(X=2) = C05*0.70*0.35 + C15*0.71*0.34 + C25*0.72*0.33 = 0.16308

III.2.b. Stabilité

Soient SM et SN deux variables aléatoires binomiales de paramètres (M, p) et (N, p). Si les N

expériences de Bernoulli sont indépendantes des M expériences de Bernoulli, on dit que les

variables aléatoires binomiales SM et SN sont indépendantes. Dans ce cas la somme SM + SN

est égale au nombre de succès pendant une suite des N + M expériences de Bernoulli de

paramètre p. Par conséquent, on a

SM + SN = SM+N .

Cette propriété est appelée stabilité.

Proposition : Soient SM et SN deux variables aléatoires binomiales indépendantes de

paramètres (M, p ) et (N, p ). Alors SM + SN suit une loi binomiale de paramètres (M + N, p ),

i.e.

P(SM + SN = k) = CkM+N pk(1 – p)M+N – k.

Au chapitre V on donnera une définition plus précise de l’indépendance de deux variables

aléatoires : Soient SM et SN deux variables aléatoires binomiales de paramètres (M, p) et (N, p).

On dit que SM et SN sont indépendants si et seulement si

P(SM = k et SN = l) = P(SM = k) ⋅ P(SN = l)

pour tout k = 0,…,M et l = 0,…,N .

III.3. La loi géométrique et loi binomiale négative

On considère un processus de Bernoulli de paramètre p. On s’intéresse au nombre T d’essais

jusqu’au premier succès.

III.3.a. Loi du temps du 1er succès

On introduit un temps aléatoire T, défini comme temps du 1er succès dans une suite infinie

d’expériences de Bernoulli, i.e. T = min(k : Xk = 1) = min(k : Sk = 1), où Sk = X1 + … + Xk.

Nous vérifierons ci-dessous que ce temps est fini avec probabilité 1. Pour tout k notons Ak

l’événement { Xk = 1}. L’événement {T = k} est égal à (A1)c ∩ … ∩ (Ak-1)c ∩ Ak. On calcule

alors la loi de probabilité de T.

P(T = 1) = p ,

P(T = 2) = (1 – p) ⋅ p ,

P(T = k) = (1 – p)k – 1 ⋅ p

d’où l’on peut déduire, par exemple, que

P(T > k) = ∑j > k P(T = j) = ∑j > k (1 – p)j – 1 ⋅ p = (1 – p)k.

En particulier, P(T = ∞) = lim k→∞ P(T > k) = lim k→∞ (1 – p)k = 0 si p > 0.

Donc P(T < ∞) = 1, i.e., avec probabilité 1, le temps T est fini.

Définition : On dit que T suit une loi géométrique de paramètre p où p est la probabilité de

succès dans un essai. On écrit

T ∼ Geom(1, p )

T est appelé variable aléatoire géométrique ou plus brièvement variable géométrique.

Exemple : On jette un dé équilibré jusqu’à un « 6 » sort. Quelle est la probabilité qu’on lance

le dé au plus trois fois ?

Solution : Soit T le temps jusqu’à un « 6 » sort. On a T ∼ Geom(1, 1/6). La probabilité

cherchée est

P(T ≤ 3) = P(T =1) + P(T =2) + P(T =3) = 1/6 + 5/6 ⋅1/6 + 5/6 ⋅ 5/6 ⋅1/6 = 91/216 ≅ .4212962963.

On pourra aussi calculer cette probabilité en passant par le complémentaire :

P(T ≤ 3) = 1 - P(T > 3) = 1- (5/6)3 = 1 - 125/216 = 91/216.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

1

/

17

100%