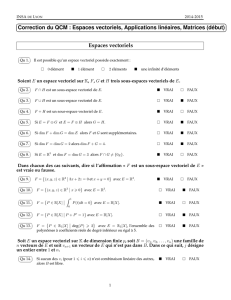

Structure de K-espace vectoriel (ou d`espace vectoriel sur K)

E

F E

F F

E

E0E

E{OE}E

E E

E

E E

n[X] [X]

2 3 3

3

E

E v 6= 0Ev v

E E v

Vect (P)E E

PE E P

PE

P Vect (P)

EP

p×n

(A|b)n⇐⇒ b /∈ Vect (Col1(A), ..., Coln(A)) M(p, 1,)

(A|b)n⇐⇒ b∈ Vect (Col1(A), ..., Coln(A)) M(p, 1,)

E

E E FE

E E

E1v=Vect ({v})

n

n

n

E

EVect ({v1, v2})v1, v2E

v1, v2Vect ({v1, v2})E

2E=2

E=

E=

2E=2

2E=2

4 2

1[X]E= [X]

E

E E

E E

E

F1,· · · , FnE

F1+· · · +Fn={(v1+· · · +vn)∈E|v1∈F1,· · · , vn∈Fn}E

F1,· · · , Fn

F=f∈ | ∀x∈, f(x) = Acos(x−ϕ), A, ϕ ∈A>0

E=

F=Vect ({cos,sin}) = cos + sin

Vect ({v1, v2}) = v1+v2

Vect ({v1,· · · , vn}) = v1+· · · +vn

P1,· · · ,PnE

Vect (P1∪ · · · ∪ Pn) = Vect (P1) + · · · +Vect (Pn)

F1+· · · +Fn=Vect (F1∪ · · · ∪ Fn)

F1+F2

F E F +F=F

F G E G ⊂F F +G=F

E

E

F=F1+· · · +FnE F1,· · · , FnE

v F v1+· · · +vnv1∈F1,· · · , vn∈Fn

F=F1⊕···⊕Fn

E= [X]4[X]

4[X] = 1[X]⊕ Vect (X2+X0, X3−X)⊕(X4+ 2X3+X2−X)

P=a0X0+a1X+a2X2+a3X3+a4X4

4[X]

P=P1+P2+P3P1∈1[X]P2∈ Vect (X2+X0, X3−X)P3∈(X4+ 2X3+X2−X)

b0, b1, α, β, γ

P= (b0X0+b1X) + α(X2+X0) + β(X3−X)+γ(X4+ 2X3+X2−X)

(b0, b1, α, β, γ)

b0+α=a0

b1−β−γ=a1

α+γ=a2

β+2γ=a3

γ=a4

5 5

P P =P1+P2+P3P1∈1[X]

P2∈ Vect (X2+X0, X3−X)P3∈(X4+ 2X3+X2−X)

E

F G E E =F⊕G

v E vF+vG(vF, vG)∈F×G

E=F⊕G⇐⇒ F+G=E

F∩G={OE}

F=f∈ | fG=f∈ | f

F E G E {F, G}E

E

{F, G}E

E v ∈E vF+vG(vF, vG)∈F×G

PrF,G F G PrF,G(v) = vF

PrG,F G F PrG,F (v) = vG

SF,G F G SF,G(v) = vF−vG

SG,F G F SG,F (v) = vG−vF

F G

2 3 n

P S

P ◦ P =P S ◦ S =IdE

S P P ◦ P ◦ · · · ◦ P =P

E

E

SG,F =−SF,G 2PF,G − SF,G =IdE.

P S {F, G}

E u, v ∈E λ ∈

P(u+v) = P(u) + P(v)P(λu) = λP(u)

S(u+v) = S(u) + S(v)S(λu) = λS(u)

P S

E

E6={OE}

n > 0F={e1,· · · , en} ⊂ EVect (F) = E

FE

F E F

ekF F

F \ {ek}

∀F ∀ek∈ F ek/∈ V (F \ {ek})

ek∈ V (F \ {ek})F \{ek}

F

F={v1,· · · , vp} ⇐⇒ ∀ (λ1,· · · , λp)6= (0,· · · ,0) λ1v1+· · · +λpvp6= 0E

λ1v1+· · ·+λpvp= 0Ev1,· · · , vp

0v1+· · · + 0 vp= 0E

λ1v1+· · · +λpvp= 0E(λ1,· · · , λp) = (0,· · · ,0)

Fv /∈ V (F)F ∪ {v}

F={v1,· · · , vp} ⇐⇒ V (F) = v1⊕ · · · ⊕ vp

F={v1,· · · , vr} ⊂ E, G={w1,· · · , ws} ⊂ V (F)s>r=⇒ G

r r

s6rG G

s6r

s r

E6={OE}

E6={OE}

6

6

1

/

6

100%