UNIVERSITE DE DOUALA

Faculté des Sciences Economiques et de Gestion Appliquée

(FSEGA)

Département des techniques quantitatives

Année académique 2012/2013

COURS ANALYSE DES DONNEES

CF4 - ECOMO4 - FICO4 - MARKETING4

Par M. NANA YAKAM André

Email : nanayakam@gmail.com

Programme :

1. Méthodologie d’analyse des données

2. Analyse univariée

3. Analyse bivariée

4. Analyse multivariée

Bibliographie :

− Qu’est ce que l’analyse de données ? Jean-Pierre FENELON, édition LEFONEN

− Initiation à l’analyse des données, Jean de Lagarde, édition DUNOD

− Analyse des données multidimensionnelles, Patrice Bertier & J M Bouroche,

Presses Universitaire de France

− Statistique appliquée à la gestion, Vincent GIARD, édition ECONOMICA

− Analyse statistique des données : application et cas pour le marketing, H.

Fernneleau, édition Ellipses

2

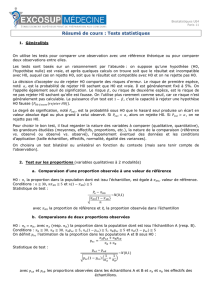

CHAPITRE I :

METHODOLOGIE D’ANALYSE DES DONNEES

INTRODUCTION

L’analyse de données est un processus d’extraction des connaissances à partir des données (ECD). Elle vise

à décrire, à résumer et à interpréter des phénomènes dont le caractère essentiel est la variabilité. Elle

fournit de la manière la plus rigoureuse possible des éléments d'appréciation utiles à l'explication ou à la

prévision de ces phénomènes. L’analyse des données fournit à toutes les personnes confrontées à

l'interprétation de résultats d'observation ou d'expérimentation, un outil d'interprétation adapté aux

conditions particulières de leur domaine d'activité.

Avant de se lancer dans le processus d’analyse des données, l’analyste doit avoir un problème bien délimité

à résoudre. Il ne se lance pas dans l’analyse sans avoir une idée des objectifs de son opération et des moyens

informationnels et technologiques dont il dispose. Par exemple, il cherche des liens entre certains phénomènes.

Une fois le problème posé, la première phase vise à cibler, même de façon grossière, l’espace des données

qui va être exploré. L’analyste définit de ce fait des zones de prospection, étant persuadé que certaines régions

seront probablement vite abandonnées si elles ne recèlent aucun ou peu d’intérêt. L’acquisition met en œuvre

des méthodes pour collecter les données potentiellement utiles selon le point de vue de l’analyste.

NB : La collecte des données est la phase la plus déterminante en analyse de données, car toute analyse,

aussi sérieuse soit-elle, faite sur de données erronées ou de mauvaise qualité est biaisée d’avance et ne peut

aboutir qu’à des conclusions erronées. Par ailleurs, Le processus d’ECD n’est pas linéaire car il arrive aussi que

l’on revienne, après analyse, rechercher de nouvelles données.

A l’issue de la phase de collecte de données, il convient de les nettoyer. Par exemple, si l’une des variables

retenues s’avère peu ou mal renseignée, on peut ne pas la prendre en considération. On peut également

explicitement chercher à limiter le nombre d’enregistrements que l’on souhaite traiter. On construit alors un

filtre idoine, comme un échantillonnage selon une procédure de tirage aléatoire simple ou systématique par

exemple.

Après cette phase de pré-traitement des données, l’analyste est, a priori, en possession d’un stock de

données contenant potentiellement l’information ou la connaissance recherchée. C’est en ce moment qu’il peut

commencer son analyse. Selon que l’analyse porte sur une, deux ou plus de deux variables, et en fonction de la

nature de ces variables, de nombreux outils statistiques sont à la disposition de l’analyste pour résoudre son

problème. Le schéma suivant résume la méthodologie d’analyse des données ainsi que les outils qui seront

développés dans ce cours.

3

ORIGINE ET METHODES DE COLLECTE DES DONNEES

1. ORIGINE

Les données utilisées en statistiques peuvent provenir d’un recensement, d’une enquête statistique, des

données administratives ou d’un entrepôt de données d’une organisation.

a) Recensement

Le recensement est une opération statistique d’observation exhaustive de tous les éléments d’une

population. Les données individuelles de tous les éléments de la population sont prises en compte pour le

caractère étudié. C’est le cas par exemple des clients d’une banque, des salariés d’une entreprise, …

b) Enquête statistique

Une enquête statistique est la collecte de données sur une partie ou la totalité des unités d'une population à

l'aide de concepts, de méthodes et de procédures bien définis.

Le sondage en est l’une de ces méthodes, qui

permet de construire un échantillon et qui ne prélève qu’une partie des informations existantes

.

c) Données administratives

Les organismes et les Etats recueillent des données administratives dans le cadre de leurs activités

quotidiennes, ces données peuvent être utilisées à titre de substitut pour une enquête par sondage ou pour

un recensement.

d) Entrepôt de données

Grâce à l’évolution informatique, avec la fabrication des ordinateurs ayant des grandes capacités de

stockage, les entreprises, les institutions et les organisations conservent de nos jours, des quantités

importantes d’information dans leurs bases de données. Ces entrepôts de données renferment à n’en point

douter des informations dont la fouille par les techniques d’analyse de données peut permettre d’apporter

des réponses, même aux questions les complexes que se poses ces organisations.

Remarque : Les sources potentielles peuvent être regroupée en deux : Soit les données existent déjà

quelque part et elles sont accessibles, au quel cas il faut aller à sa recherche, sinon nous devons les

collecter nous même auprès des individus concernés.

Origine et Collecte des Données

Prétraitement, Codification, Mise

des données en tableaux

Analyse descriptive

(Analyse Univariée)

- Estimation des paramètres de

tendance centrale

(moyenne, mode,

médiane)

Analyse Bivariée

- Estimation et signification des

paramètres de Dispersion (variance,

écart type, intervalle

interquartile)

- Graphiques

- Tests d’inférence sur une variable

- ANOVA à un facteur

- Test d’association,

- Test de Corrélation

- Autres tests

- ANOVA à 2 facteurs

- Modélisation (modèle de

régression, …)

Analyse Multivariée

- Modélisation (modèle de

régression multiple)

- Analyse Factoriel (ACP,

AFC, ACM, Analyse

discriminante)

- Prévision

- Prévision

Problème à résoudre

4

2. METHODES DE COLLECTE DES DONNEES

La collecte des données vise à répondre aux questions suivantes : Quels sont les individus à prendre en

compte dans mon étude ? Où vais-je les retrouver ? Par quel moyen ? Combien en faut-il ? Comment vais-je les

sélectionner ? Les réponses à ces questions varient selon que les données sont dans des entrepôts de données ou

alors s’il faut les collecter auprès des individus concernés.

Très souvent, les données issues des bases de données et des enquêtes statistiques ne sont pas toutes

exploitables. On est parfois amené à procéder à une sélection pour choisir l’échantillon propice pour l’analyse.

Parmi ces méthodes d’échantillonnage nous pouvons citer :

− Echantillonnage aléatoire simple : l’échantillon est choisi de telle sorte que chaque unité de la

population ait la même probabilité d’être sélectionnée dans l’échantillon et que chaque échantillon

de même taille ait la même probabilité d’être tiré.

−

Echantillonnage Systématique :

On souhaite sélectionner n individus parmi N sujets numérotés de 1 à

N. pour ce faire, On calcule le pas :

n

N

p=

, puis on tire un nombre aléatoire entre 1 et Ent(p), c’est du

premier individu choisi. Les autres seront obtenus en ajoutant Ent(p) au numéro précédemment choisi.

−

Échantillonnage avec probabilité proportionnelle à la taille : Si la base de sondage renferme

de l'information sur la taille de chaque unité (comme le nombre de filles) et si la taille de ces

unités varie, on peut utiliser cette information dans le cadre de la sélection de l'échantillonnage

afin d'en accroître l'efficacité.

−

Échantillonnage stratifié : on divise la population en groupes homogènes appelés strates, qui

sont mutuellement exclusifs (comme l'âge, la ville de résidence, le revenu, etc.) puis on

sélectionne à partir de chaque strate des échantillons indépendants. On peut utiliser n'importe

quelle des méthodes d'échantillonnage pour sélectionner l'échantillon à l'intérieur de chaque strate.

3. PRETRAITEMENT DES DONNEES

Les données issues des entrepôts ou des enquêtes ne sont pas nécessairement toutes exploitables par des

techniques d’analyse de données. Les données acquises peuvent être de types différents pour la même variable,

on peut avoir les données manquantes ou aberrantes. Dans certaines situations, les données exigent une

transformation telle qu’un centrage par rapport à la moyenne ou une normalisation. La préparation consiste à

homogénéiser les données et à les disposer en tableau lignes/colonnes. Car il s’agit presque toujours de la

structure la mieux adaptée à l’exploitation des données. Les principales opérations de préparation peuvent être

listées comme suit :

a) Sélection de ligne/colonne.

Elle s’effectue sur des données qui sont déjà sous forme tabulaire. Il s’agit de définir un filtre qui permet de

sélectionner un sous-ensemble de lignes ou de colonnes. L’objectif étant, soit de réduire le nombre de données

soit de sélectionner les lignes ou colonnes les plus pertinentes par rapport aux préoccupations de l’utilisateur.

Les techniques mises en œuvre dans ce but relèvent des méthodes statistiques d’échantillonnage. Cette

sélection peut également s’effectuer selon des conditions exprimées par l’utilisateur. Par exemple, il peut ne

garder que les attributs dont la moyenne est supérieure à un seuil donné ou ne conserver que les attributs qui ont

un lien statistique significatif avec un attribut particulier.

5

b) Le traitement des données manquantes ou aberrantes.

Certaines données peuvent être absentes ou aberrantes et gêner ainsi l’analyse. Il convient alors de définir des

règles pour gérer ces données manquantes et les valeurs aberrantes ou anormales.

i.) Valeurs manquantes

Lorsqu’on est en face d’une donnée manquante, une des solutions consiste à supprimer l’observation

correspondante, quand on en a suffisamment. On peut aussi envisager d’estimer cette dernière. De nombreuses

solutions sont proposées, comme le remplacement, dans le cas des variables qualitatives et quantitatives

continues, de toute donnée manquante par la valeur la plus fréquente de la variable concernée. On peut

également chercher à estimer ces valeurs manquantes par des méthodes d’induction comme la régression pour

les variables quantitatives.

ii.) Valeurs aberrantes

Selon la méthode de l’intervalle de confiance, est considérée comme valeur aberrante pour une variable

quantitative X donnée, toutes les données dont la valeur est extérieure à l’intervalle

[

]

XX

XX

σσ

96.1;96.1 +−

où

X

est la moyenne de X et X

σ

son écart type.

La valeur détectée comme aberrante est ramenée à la limite haute ou basse de cet intervalle de confiance. On

peut également chercher à l’estimer par des méthodes régression.

c) Les transformations de variables

Il s’agit de transformer un attribut A en une autre variable A’ qui serait, selon les objectifs de l’étude, plus

appropriée. Différentes méthodes sont pratiquées comme la discrétisation qui consiste à transformer des attributs

continus en découpant le domaine de valeurs de ces attributs en intervalles afin d’obtenir des attributs qualitatifs.

On peut également centrer les valeurs des variables continues par rapport à la moyenne et réduire par l’écart

type. Ce traitement leur confère certaines propriétés mathématiques intéressantes lors de la mise en œuvre de

méthodes d’analyse des données multidimensionnelles.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

1

/

36

100%