POLYCOPIÉ DE COURS DE STATISTIQUE ET ÉCONOMÉTRIE

MODÈLE LINÉAIRE

M. BONNEU, E. LECONTE

Université des Sciences Sociales

Place Anatole France

31042 Toulouse

2

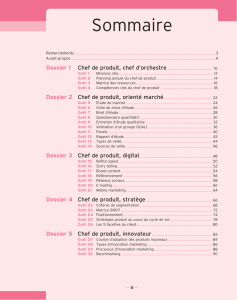

Table des matières

Introduction 5

1 Outils algébriques et probabilistes 11

1.1 Eléments d’algèbre linéaire . . . . . . . . . . . . . . . . . . . . . . . . . . . . 11

1.1.1 Matrices.................................. 11

1.1.2 Espaceseuclidiens ............................ 16

1.1.3 Dérivation matricielle . . . . . . . . . . . . . . . . . . . . . . . . . . 20

1.2 Vecteursaléatoires ................................ 20

1.2.1 Rappels sur les variables aléatoires réelles (v.a.r.) . . . . . . . . . . . . 20

1.2.2 Vecteuraléatoire ............................. 23

1.2.3 Changement de variable . . . . . . . . . . . . . . . . . . . . . . . . . 26

1.3 Loi normale dans IRn(Gaussienne) ....................... 28

1.3.1 Diverses caractérisations . . . . . . . . . . . . . . . . . . . . . . . . . 28

1.3.2 Non corrélation et indépendance . . . . . . . . . . . . . . . . . . . . . 29

1.3.3 Lois de distribution des formes quadratiques . . . . . . . . . . . . . . 31

2 Modèle linéaire 35

2.1 Formulation du modèle linéaire . . . . . . . . . . . . . . . . . . . . . . . . . . 35

2.1.1 Ecriture matricielle . . . . . . . . . . . . . . . . . . . . . . . . . . . . 36

2.1.2 Hypothèses du modèle linéaire . . . . . . . . . . . . . . . . . . . . . . 36

2.2 Estimateur des moindres carrés ordinaires (MCO) . . . . . . . . . . . . . . . . 37

2.2.1 Définition de l’estimateur MCO du paramètre β............. 37

2.2.2 Propriétés de l’estimateur MCO ˆ

β.................... 39

2.2.3 Estimation de la variance résiduelle σ2.................. 39

2.3 Interprétation géométrique . . . . . . . . . . . . . . . . . . . . . . . . . . . . 41

2.3.1 Représentation des individus . . . . . . . . . . . . . . . . . . . . . . . 41

2.3.2 Espace des variables . . . . . . . . . . . . . . . . . . . . . . . . . . . 41

2.3.3 Coefficient de corrélation multiple (empirique) ou coefficient de déter-

mination ................................. 43

2.3.4 Interprétation et critique de l’utilisation de R2.............. 43

3 Induction statistique dans le modèle linéaire 47

3.1 Modèle linéaire gaussien . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 47

3

4TABLE DES MATIÈRES

3.1.1 Définition................................. 47

3.1.2 Estimateur maximum de vraisemblance EMV ou MLE ........ 48

3.1.3 Loi de probabilité des estimateurs . . . . . . . . . . . . . . . . . . . . 48

3.1.4 Estimation par intervalle de confiance (IC) . . . . . . . . . . . . . . . 51

3.1.5 Prévision pour une valeur future x0= (x1

0, . . . , xp

0)0........... 54

3.2 Testsd’hypothèses ................................ 54

3.2.1 Estimation sous contrainte linéaire . . . . . . . . . . . . . . . . . . . . 54

3.2.2 Test de student de signification d’un coefficient βj........... 55

3.2.3 Test de Fisher de signification de plusieurs coefficients . . . . . . . . . 56

3.2.4 Test de Fisher d’une hypothèse linéaire générale . . . . . . . . . . . . 57

3.3 Critiques du modèle linéaire gaussien . . . . . . . . . . . . . . . . . . . . . . 58

3.3.1 Testdelinéarité.............................. 58

3.3.2 Analysedesrésidus............................ 60

3.3.3 Détection de valeurs aberrantes ou influentes . . . . . . . . . . . . . . 64

3.3.4 Sélection des variables exogènes . . . . . . . . . . . . . . . . . . . . . 65

4 Modèles linéaires gaussiens particuliers 71

4.1 Analyse de variance à un facteur . . . . . . . . . . . . . . . . . . . . . . . . . 72

4.1.1 Exemple ................................. 72

4.1.2 Approche intuitive de l’analyse de variance . . . . . . . . . . . . . . . 73

4.1.3 Estimation des paramètres . . . . . . . . . . . . . . . . . . . . . . . . 75

4.1.4 Testd’hypothèses............................. 77

4.2 Analyse de variance à deux facteurs . . . . . . . . . . . . . . . . . . . . . . . 78

4.2.1 Exemple ................................. 78

4.2.2 Modélisation statistique et estimation . . . . . . . . . . . . . . . . . . 79

4.2.3 Testsd’hypothèses............................ 80

4.2.4 Interprétation de l’interaction de deux facteurs . . . . . . . . . . . . . 83

4.3 Analysedecovariance .............................. 87

4.3.1 Modélisation avec interaction . . . . . . . . . . . . . . . . . . . . . . 87

4.3.2 Testsd’hypothèses............................ 90

5 Généralisation du modèle linéaire gaussien 91

5.1 Moindres carrés généralisés . . . . . . . . . . . . . . . . . . . . . . . . . . . . 92

5.1.1 Estimateur des moindres carrés généralisés . . . . . . . . . . . . . . . 92

5.1.2 Estimateur des moindres carrés pondérés . . . . . . . . . . . . . . . . 95

5.1.3 Autocorrélation des résidus . . . . . . . . . . . . . . . . . . . . . . . . 96

5.2 Régressionstochastique.............................. 98

5.2.1 Modèles linéaires conditionnels . . . . . . . . . . . . . . . . . . . . . 99

5.2.2 Approximation d’une v.a. ypar un vecteur aléatoire x.......... 99

Bibliographie 105

Tables statistiques 107

Introduction

En économétrie, quand on est en présence de plusieurs variables, le but n’est pas uniquement

de les étudier en tant que variables aléatoires, mais essentiellement de modéliser leurs relations.

Cadre de ce cours : MODELES EXPLICATIFS

Expliquer une variable endogène yquantitative par pvariables exogènes, dites expli-

catives.

Les données se présentent sous la forme du tableau suivant :

Variables y

endogène x1··· xp

u.s. 1 y1x1

1xp

1

.

.

..

.

..

.

..

.

.

u.s. i yix1

ixp

i

.

.

..

.

..

.

..

.

.

u.s. n ynx1

nxp

n

u.s. : unité statistique représentant un individu d’une population ou le temps.

x1, . . . , xp: variables quantitatives ou qualitatives exogènes.

y: variable quantitative endogène.

Exemple 1.

On considère 101 succursales d’une entreprise. L’objectif est d’expliquer le chiffre d’affaire

de chaque succursale au moyen de variables telles que : marge commerciale, charge salariale,

nombre de vendeurs,...Les données sont stockées dans un fichier informatique sous la forme

suivante :

5

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

84

84

85

85

86

86

87

87

88

88

89

89

90

90

91

91

92

92

93

93

94

94

95

95

96

96

97

97

98

98

99

99

100

100

101

101

102

102

103

103

104

104

105

105

106

106

107

107

108

108

109

109

110

110

111

111

112

112

113

113

114

114

115

115

116

116

117

117

118

118

1

/

118

100%