α - Pacea

Éléments de statistique

Frédéric Santos, <[email protected]>

M1 AbP, Université de Bordeaux

Édition 2015–2016

Contenu du cours

1.Généralités............................. 1

§1.1.Objectifs et pratique de la statistique, 1. — §1.2.Statistique et informatique, 2. —

§1.3.Échantillonnage, 2. — §1.4.Typologie des variables, 3.

2. Quelques éléments de probabilité . . . . . . . . . . . . . . . . . . 4

§2.1.Variable aléatoire, 4 (Cas d’une loi discrète, 4. Cas d’une loi continue, 4). — §2.2.

Fonction de répartition, 5 (Cas d’une loi discrète, 5. Cas d’une loi continue, 5). — §2.3.

Moments, 5. — §2.4.La loi normale, 6.

3.LelogicielR............................ 6

§3.1.Généralités, 6. — §3.2.Tableurs : règles de saisie des données, 7. — §3.3.Gestion des

packages, 9. — §3.4.L’interface graphique, 9.

4. Statistique descriptive . . . . . . . . . . . . . . . . . . . . . . . 10

§4.1.Cas de variables quantitatives continues, 10 (Résumés numériques, 10. Représentations

graphiques, 12). — §4.2.Cas de variables qualitatives, 13. — §4.3.Cas de variables quanti-

tatives discrètes, 14. — §4.4.Quantiles empiriques, 14. — §4.5.Liaison entre deux variables

numériques, 15.

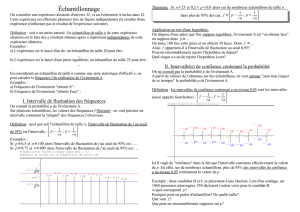

5. Statistique inférentielle . . . . . . . . . . . . . . . . . . . . . . 16

§5.1.Retour sur la loi normale, 16. — §5.2.Notion d’intervalle de confiance, 17. — §5.3.

Intervalle de confiance pour la moyenne, 18. — §5.4.Intervalle de confiance pour la variance,

20. — §5.5.Principe des tests d’hypothèses paramétriques, 20 (Objectifs, 20. Heuristique des

tests d’hypothèses, 21. Principe de fonctionnement, 21. Risques d’erreur, 21. La p-valeur d’un

test, 22). — §5.6.Tests paramétriques usuels, 23 (Comparaison de la moyenne à une valeur

de référence, 23. Comparaison de deux variances, 24. Comparaison des moyennes de deux

échantillons indépendants, 25. Comparaison des moyennes de deux échantillons appariés, 27).

—§5.7.Tests de normalité, 27. — §5.8.Équivalents non-paramétriques des tests usuels, 28.

—§5.9.Test d’indépendance du χ2, 28.

Références.............................. 31

1. Généralités

Pour l’ensemble du cours, on pourra consulter les ouvrages généraux [Fro07], [Pag10] et [GDM11].

§1.1. Objectifs et pratique de la statistique

La statistique fréquentiste 1offre toute une collection de méthodes visant à analyser des en-

sembles d’observations de manière objective et reproductible — c’est-à-dire que deux analystes

différents, en menant la même étude avec les mêmes outils, devront trouver les mêmes résultats.

Ces méthodes sont généralement fortement liées au calcul des probabilités et à l’algèbre linéaire.

Cette discipline a connu un essor considérable au cours du XXesiècle, en particulier après la

seconde guerre mondiale, puis ensuite avec l’arrivée de moyens informatiques performants.

1. C’est le point de vue dit classique en statistique, s’opposant à la statistique bayésienne, non évoquée dans ce

cours. Cette dernière laisse une place à la subjectivité et à l’intuition du chercheur.

1

2Généralités

Elle est aujourd’hui omniprésente dans tous les secteurs d’activité :

— sciences bio-médicales (études cas-témoins pour la détermination de facteurs de risque,

certification des médicaments génériques, statistique en génomique et génétique, ...) ;

— économie (modèles financiers, risques en assurance, ...) ;

— marketing (études de satisfaction clientèle, impact de campagnes publicitaires, ...) ;

— télécommunications (traitement du signal) ;

— physique et sciences de l’univers (dont la physique statistique est un domaine central) ;

— sciences humaines (modèles démographiques, sociologie quantitative, ...) ;

— sécurité sanitaire, sûreté de fonctionnement en milieu industriel (EDF, Airbus, ...) ;

— écologie et climatologie (rôle majeur dans l’étude du réchauffement climatique), etc.

§1.2. Statistique et informatique

Aujourd’hui, de nombreux logiciels de statistique performants permettent de mener des ana-

lyses poussées de manière rapide, même sur de gros volumes de données. Dans ce cours, seul le

logiciel Rsera utilisé. Voici cependant d’autres logiciels couramment employés :

— PAST : un logiciel gratuit spécialement destiné aux problématiques paléontologiques et

préhistoriques, associé à une épaisse et très pédagogique documentation [HH05] ;

— Gnumeric : un tableur libre et gratuit incluant de nombreuses fonctionnalités statistiques

avancées ;

— Statistica, logiciel payant propriétaire édité par StatSoft (déconseillé) ;

— Excel et son greffon XLStat, édités par Microsoft (déconseillé) ;

— SAS et SPSS, logiciels payants propriétaires, très utilisés dans l’industrie et le monde de la

finance, un peu moins dans le milieu de la recherche à cause de leur prix très élevé.

§1.3. Échantillonnage

On appelle population le groupe (a priori inaccessible dans sa totalité), ou encore le type, d’ob-

jets sur lequel porte notre étude. Un élément de la population est classiquement appelé individu,

voire parfois unité.

Mis à part le cas très particulier des recensements — étude sur population complète — une

étude statistique ne peut jamais être menée sur la totalité de la population, que ce soit pour des

raisons de coût ou simplement de faisabilité. Un échantillon est un sous-ensemble d’individus de la

population, réellement accessibles à l’expérimentateur — et dans le cas des études archéologiques,

cet échantillon est souvent très réduit.

Quelques exemples :

— dans une étude, la population peut par exemple être l’ensemble de tous les Néandertaliens,

l’ensemble de tous les statisticiens 2, ou les ampoules d’un certain type en sortie d’une

chaîne d’usine ;

— un individu sera alors un Néandertalien, un statisticien, ou une ampoule ;

— on ne peut hélas accéder à tous les Néandertaliens ayant existé, pas plus qu’on ne peut se

permettre d’étudier toutes les ampoules produites par une usine : une étude statistique ne

porte que sur un nombre restreint d’individus. L’échantillon, liste réeelle des objets entrant

en compte dans l’étude, peut donc être un ensemble de 12 squelettes néandertaliens, ou 20

statisticiens pris au hasard dans l’annuaire de la Société française de statistique, ou 100

ampoules capturées à l’issue de la chaîne de production.

Une étude statistique suit le schéma suivant :

1. Il s’agit avant tout de choisir et collecter un échantillon d’individus suffisamment repré-

sentatif de la population globale : c’est l’objet de la théorie des sondages — qui ne sera

pas étudiée ici, puisque l’archéologue ne peut évidemment maîtriser son échantillonnage :

il travaille avec ce qu’il trouve !

2. Les mauvais esprits pourront toujours se plaire à faire remarquer qu’il n’y a pas grande différence entre ces

deux populations.

15 octobre 2015 3

Figure 1 – Différentes étapes dans une étude statistique

2. On décrit ensuite l’échantillon et on en extrait le maximum d’informations pour résumer

ses caractéristiques : c’est l’objet de la statistique descriptive, ou exploratoire.

3. Enfin, on cherche à savoir à quel point les caractéristiques de l’échantillon peuvent être

représentatives des caractéristiques (inconnues !) de la population globale : il s’agit de « re-

monter » depuis l’échantillon vers la population. On parle alors de statistique inférentielle 3.

Définition 1 (Fluctuation d’échantillonnage). — On appelle fluctuation d’échantillonnage le fait

qu’un échantillon ne représente qu’imparfaitement la population sous-jacente.

Si un institut de sondage veut savoir comment vont voter les Français lors de la prochaine

élection, une stratégie (sommaire) peut être d’appeler 100 Français au hasard pour leur demander

leur intention de vote. À l’issue de cette étude, l’institut trouvera par exemple 15% d’intention de

vote pour le candidat A, 38% pour le candidat B, et 47% pour le candidat C. Mais si l’institut

recommence immédiatement l’expérience avec 100 autres personnes choisies au hasard, il est très

improbable qu’il observe exactement les mêmes pourcentages d’intention de vote sur le second

échantillon : il observera peut-être respectivement 18%, 37% et 45% sur ce second échantillon.

Ce phénomène est précisément la fluctuation d’échantillonnage 4, autrement dit, le fait que les

caractéristiques de l’échantillon (choisi au hasard) ne soient pas parfaitement égales à celles de la

population dans son ensemble.

L’objectif de la statistique inférentielle peut être perçu comme l’évaluation de l’impact de la

fluctuation d’échantillonnage relativement aux différences réelles : si l’institut de sondage effectue

deux enquêtes à deux semaines d’intervalle, les différences observées dans les intentions de vote

relèvent-elles de la simple fluctuation d’échantillonnage au sein d’une population qui, globalement,

n’a pas changé d’avis ? Ou au contraire, relèvent-elles d’une véritable évolution de l’opinion pu-

blique dans son ensemble ? C’est cette question que doit trancher la statistique, avec un risque

associé à la prise de décision.

§1.4. Typologie des variables

Classiquement, on récolte sur chaque individu une ou plusieurs informations, considérées comme

des réalisations de variables aléatoires pouvant être de différents types :

— variables quantitatives continues : longueur d’un tibia sur un squelette néandertalien, durée

de vie d’une ampoule ;

— variables quantitatives discrètes : âge d’un étudiant en années, nombre de dents restées

intactes sur un squelette ;

— variables qualitatives hiérarchisées, ou ordinales : état de conservation du squelette (bon,

moyen, mauvais), opinion politique des étudiants (de la plus à gauche à la plus à droite) ;

— variables qualitatives non hiérarchisées : présence ou absence de carie sur une dent, orien-

tation des jambes dans une sépulture (Nord, Ouest, ...).

3. Du latin inferre, littéralement « porter dans », traduisant l’objectif de « porter dans la population » les

informations découvertes dans l’échantillon.

4. Le concept de fluctuation d’échantillonnage a toujours été un ressort comique assez classique, comme en

témoigne l’aphorisme du grand philosophe Jean-Claude Van Damme : « Selon les statistiques, il y a une personne

sur cinq qui est déséquilibrée. S’il y a quatre personnes autour de toi et qu’elles te semblent normales, c’est pas

bon ». Dans un autre genre, certaines tribulations de Perceval et Karadoc dans la série Kaamelott doivent également

beaucoup à cette notion.

4Quelques éléments de probabilité

2. Quelques éléments de probabilité

«Toute connaissance dégénère en probabilité. » — David Hume

§2.1. Variable aléatoire

Le concept est en général bien vulgarisé par les spécialistes du traitement du signal qui utilisent

le terme de source. Intuitivement, on peut voir cela comme une source générant aléatoirement des

valeurs, mais dont le comportement est encadré par une loi, c’est-à-dire la probabilité d’obtenir

chaque valeur ou ensemble de valeurs. En d’autres termes, même si « individuellement » on ne peut

prévoir le résultat d’une réalisation de la variable aléatoire, on sait comment devraient globalement

se répartir les valeurs issues d’un grand nombre de réalisations 5.

2.1.1. Cas d’une loi discrète. — Si une variable aléatoire Xne peut générer qu’un nombre

fini de valeurs x1, x2, , xn(comme dans le cas d’un lancer de dé, où on obtient aléatoirement

un nombre entre 1 et 6), sa loi est totalement déterminée par les probabilités d’obtention de chaque

valeur, notées piX xi. Il va de soi que chaque piest compris entre 0et 1, et que la somme

de toutes les probabilités piest égale à 1.

Par exemple, dans le cas du lancer d’un dé équilibré, toutes les valeurs entre 1 et 6 sont

équiprobables. Alors, si Xest le résultat du lancer :

X1X2X6 1 6

Cela signifie que le dé est bien conçu, de telle façon qu’aucune valeur n’est théoriquement plus

probable qu’une autre (on parle de loi uniforme). Il est impossible de prédire de manière fiable le

résultat d’un lancer de dé, mais on sait par contre qu’en le lançant un grand nombre de fois, on

devrait avoir sensiblement autant de 1, que de 2, ..., que de 6.

Si on truque légèrement le dé en y intégrant une bille de plomb afin de déplacer son centre de

gravité, on peut par exemple imaginer que la loi de Xdeviendra :

X1 1 2 ; X2X3X6 1 10

2.1.2. Cas d’une loi continue. — Si Xpeut générer n’importe quel nombre réel (comme

dans le cas d’une loi normale, cf. infra), une énumération exhaustive des probabilités d’obtention

de chaque valeur est évidemment impossible. La loi de Xest dans ce cas définie par la probabilité

d’obtention d’une valeur comprise entre deux nombres quelconques aet b: la connaissance de

X a, b pour tous réels aet bdétermine la loi de Xde manière unique.

En particulier, on dit que Xadmet la fonction fpour densité si on a :

X a, b

b

a

f u du

avec f1(l’aire totale sous la courbe de la fonction fest 1).

Le lecteur familier avec la théorie de l’intégration en déduira que la probabilité pour Xde

prendre une valeur située entre aet best donnée par l’aire sous la courbe de fsur l’intervalle

a, b . D’où le nom de « densité » : la forme de fdétermine les valeurs où il est probable ou peu

probable de « tomber ».

Définition 2. — On dit que la série x1, , xnest composée de valeurs indépendantes et

identiquement distribuées (i.i.d.), si elles sont issues de la même distribution de probabilité (elles

suivent la même loi). Dans la vie concrète, cela signifie qu’elles sont obtenues de manière indé-

pendante par itération de la même expérience. Par exemple, 10 lancers de dé avec le même dé

équilibré constituent une série de valeurs i.i.d. (selon la loi uniforme).

5. Ce qui signe la différence entre l’aléatoire et l’anarchique ou l’imprévisible.

15 octobre 2015 5

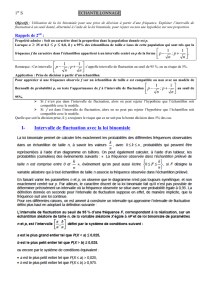

Figure 2 – Densité d’une loi N0,1: les valeurs les plus probables pour cette loi sont situées

dans l’intervalle 2,2.

§2.2. Fonction de répartition

La loi d’une variable aléatoire Xest déterminée de manière unique par sa fonction de répartition

FX, définie par :

FXtX t

Il s’agit donc d’une fonction donnant les probabilités cumulées de prendre n’importe quelle valeur

jusqu’à un seuil tdonné.

2.2.1. Cas d’une loi discrète. — Par exemple, dans le cas d’un lancer de dé équilibré :

FX1X1X1 1 6

FX2X2X1ou X2 1 6 1 6 1 3

FX3X3X1ou X2ou X3 1 6 1 6 1 6 1 2

.

.

.

FX6X6 1

2.2.2. Cas d’une loi continue. — Si Xadmet fpour densité, on a :

FXt X t X , t

t

f u du

Il s’agit ici de l’aire sous la courbe de fsur l’intervalle , t , ce qui représente bien, d’après

ce qui précède, la probabilité de prendre n’importe quelle valeur inférieure à t. Sur la figure 3,

l’aire coloriée sous la courbe représente la probabilité de prendre n’importe quelle valeur jusqu’à

1: il s’agit de F1.

Une propriété évidente des fonctions de répartition est qu’elles sont croissantes et toujours

comprises entre 0 et 1.

§2.3. Moments

Définition 3 (Espérance). — On définit l’espérance de X, notée X, comme le résultat moyen

que l’on peut s’attendre à obtenir à l’issue de l’expérience aléatoire : c’est une valeur moyenne

théorique qui n’a pas forcément toujours de sens concret.

Dans le cas d’une loi discrète, avec les notations ci-dessus, on a X xipi; et dans le cas

d’une loi continue à densité f, on a Xxf x dx.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

1

/

31

100%