Apprentissage Bayésien

Apprentissage Bayésien 2

Apprentissage Bayésien

o Introduction

oThéorème de Bayes

o“Maximum Likelihood Estimation”

o Classifieur Bayésien optimal et Bayes naif

oRéseaux Bayésiens

Apprentissage Bayésien 3

Introduction

o L’apprentissage Bayésien permet de faire des

prédictions en se basant sur des probabilités.

o Il offre un cadre pour le raisonnement à base de

probabilités ;

o Avantages avec l’approche Bayésienne :

Les données peuvent être bruitées ;

Il est possible de proposer une connaissance « a

priori » avant de construire une hypothèse ;

Les prédictions sont pondérées par des probabilités ;

Apprentissage Bayésien 4

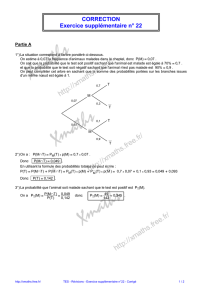

Théorème de Bayes

Définitions.

Nous avons un espace d’hypothèses H, et un ensemble

de données D. Nous définissons les 3 probabilités

suivantes :

1. P(h) la probabilité que h soit l’hypothèse correcte sans avoir vu

aucune donnée. P(h) est dite “prior probability” de h.

Exemple : Chance qu’il pleuve est 80% si on est prêt de la mer

et à la latitude X (aucune donnée n’est vu).

2. P(D) la probabilité de voir les données de D.

3. P(D|h) est la probabilité des données sachant h (likelihood).

Apprentissage Bayésien 5

Le théorème

Le théorème de Bayes relie la probabilité à posteriori

d’une hypothèse h sachant des données, avec les trois

probabilités mentionnées avant :

P(h|D) = P(D|h) . P(h) / P(D)

Évidence

Posterior

probability Prior

probability

Likelihood

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

1

/

33

100%