Reproductibilité d’un examen : généralités C

6

Correspondances en pelvi-périnéologie - n° 3, vol. III - juillet/août/septembre 2003

Reproductibilité

d’un examen : généralités

n

n

P. Glémain*

C

ONDITIONS DE REPRODUCTIBILITÉ

Un examen est reproductible si les résultats varient

peu au cours de la répétition. D’une façon générale,

un examen comporte une méthode de mesure ins-

trumentale (physique ou chimique), une procédure

d’examen plus ou moins complexe, un individu sur

lequel la mesure est effectuée et un évaluateur. En

biologie, en médecine, en biostatistique, le terme

“reproductibilité” associe la notion de précision

d’une mesure à celle de variabilité intra-indivi-

duelle. La première n’est pas seulement d’origine

instrumentale, mais correspond à l’ensemble de la

procédure de mesure. C’est la précision, la fidélité

d’une balance, qui montre le même résultat lors-

qu’on place le même poids plusieurs fois sur le

même plateau. La seconde est liée à la nature de ce

qui est évalué lorsque des variations sont possibles

entre les répétitions. En biologie, il faut donc tenir

compte des variations spontanées observées chez

les individus au cours du temps (variations intra-

individuelles).

J

USTESSE ET REPRODUCTIBILITÉ

Un examen peut être reproductible mais faux ; une

mesure est dite exacte si elle indique la vraie valeur

de la grandeur mesurée. S’il s’agit d’une simple

pesée, l’exactitude de la balance est vérifiée à l’aide

d’un poids étalon. D’une façon générale, pour véri-

fier la justesse d’une méthode, il faut rapporter les

résultats à une méthode de référence connue et

déjà évaluée ou à la connaissance de la vraie valeur.

Il faut aussi que toute la gamme des mesures pos-

sibles soit étalonnée, sous peine d’avoir des

mesures fausses pour les valeurs extrêmes, a priori

les plus intéressantes en pathologie.

La confusion entre justesse et reproductibilité peut

exister dans certains travaux. C’est le cas, par

exemple, si l’on effectue successivement plusieurs

mesures de pression de clôture chez les mêmes

patientes, en utilisant différents modèles de

sondes. On étudie alors la reproductibilité entre

diverses méthodes (ou sondes). Mais cela pourrait

être aussi une tentative d’étude de la justesse.

Quelle méthode (ou sonde) donne la pression

sphinctérienne la plus juste ? Il va de soi que, la

vraie valeur de la pression sphinctérienne n’étant

pas connue, un tel objectif est illusoire. La méthode

statistique appropriée ne serait pas celle des corré-

lations mais celle de Bland et Altman (1, 2), dans le

cadre d’un essai clinique du type de la loi Huriet (en

raison de la répétition des examens, inutile pour les

patients). La reproductibilité de la mesure de la

pression de clôture, avec le même modèle de

sonde, serait étudiée en évaluant plusieurs fois de

suite la pression chez les mêmes patientes.

I

NTÉRÊT DE LA REPRODUCTIBILITÉ

La reproductibilité d’un examen est d’un intérêt

majeur. Il peut s’agir de mesures de paramètres

physiques, d’évaluations de paramètres quantita-

tifs ou semi-quantitatifs, de scores de symptômes

ou, enfin, d’examens cliniques effectués à plusieurs

reprises sur le même patient.

Mise en évidence

d’une évolution sous traitement

Si la reproductibilité est bonne, les variations mises

en évidence par la répétition de l’examen pourront

être rapportées à l’effet thérapeutique ou, du

moins, à une évolution dans le temps. Cette évolu-

tion pourra être interprétée et testée statistique-

ment. Si la méthode n’est pas reproductible, les

fluctuations de la mesure risquent de masquer les

variations liées à l’effet thérapeutique.

Accord de plusieurs examinateurs

sur le signe étudié

Cet accord est important pour la définition d’un

patient, son inclusion éventuelle dans un essai thé-

rapeutique et son évaluation définitive.

Défaut de reproductibilité et défaut

d’exactitude

Un défaut de reproductibilité est plus grave qu’un

défaut d’exactitude. Si une mesure est fausse mais

reproductible et si l’erreur, l’écart à la réalité, est

toujours la même sur l’ensemble de la gamme de

mesure, il suffit d’effectuer une correction pour

* Nantes,

e-mail : [email protected]

“La nature est écrite dans

le grand livre de l'univers,

qui se tient toujours ouvert

devant nos yeux (...). Il est

écrit dans la langue

mathématique, et les

caractères sont des figures

géométriques. Si on ne sait

pas déchiffrer cet alphabet,

il est humainement

impossible de comprendre

quoi que ce soit à

l'univers.”

Galilée

“Il existe trois sortes de

mensonges : les mensonges,

les sacrés mensonges, et les

statistiques."

Disraeli

dossier

7

Correspondances en pelvi-périnéologie - n° 3, vol. III - juillet/août/septembre 2003

rendre la méthode utilisable. À l’inverse, une

méthode non reproductible, non précise, est diffici-

lement utilisable en raison de l’importance des

variations et de leur caractère aléatoire.

R

EPRODUCTIBILITÉ D

’

UN PARAMÈTRE

QUANTITATIF

:

COEFFICIENT DE VARIATION

ET ERREUR RELATIVE

(9)

Reproductibilité de la méthode

instrumentale

Lorsqu’il s’agit de variables biologiques (PSA,

glycémie, hémoglobinémie, créatininémie...), la

reproductibilité peut être testée en effectuant plu-

sieurs mesures des mêmes prélèvements d’une

série de patients. En pratique, chaque tube de

sang est séparé en deux ou plusieurs petits tubes

(alicots), qui seront ensuite analysés séparément

selon une procédure statistique adaptée (indé-

pendance des mesures, méconnaissance des

valeurs précédentes, randomisation...). La variabi-

lité entre les répétitions aboutira au calcul d’un

coefficient de variation (CV). Il faut s’assurer que

l’ensemble de la gamme des valeurs possibles a

été évalué. En effet, la variabilité de la mesure

peut ne pas être la même pour tous les niveaux de

mesure. Ce phénomène peut poser un problème

lorsque la variabilité est plus élevée pour les

mesures extrêmes, celles qui nous intéressent en

pathologie. Si l’erreur de mesure est indépen-

dante du niveau de la variable, le terme d’“erreur

relative” (ER) peut être utilisé.

La valeur du CV ou de l’ER doit rester inférieure à

10 % ou, mieux, à 5 %. En pratique, il vaut mieux

travailler sur les moyennes de 2 ou 3 évaluations

de la même variable biologique sur le même sujet

plutôt que sur une seule.

Lorsqu’il s’agit de paramètres physiques, telles

la débitmétrie, la pression (8), la mesure du

volume de la prostate ou d’un résidu en échogra-

phie, la reproductibilité de la méthode instrumen-

tale est plus difficile à tester : il faut utiliser des

dispositifs expérimentaux (8) permettant de vali-

der les procédures de mesure. Dans tous les cas,

il est au minimum possible d’effectuer un calcul

d’incertitude, comme en physique. Si la précision

d’une mesure de longueur en échographie est de

l’ordre de 5 % (incluant le positionnement du cur-

seur), l’incertitude mathématique sur le volume

calculé du résidu ou du volume (D1 x D2 x D3 x

0,53, en cm pour obtenir le volume en ml) est de

l’ordre de 15 %.

Reproductibilité de la procédure

de mesure

La reproductibilité de la procédure de mesure doit

aussi être prise en compte car elle est source de

variations lors des répétitions. Il peut s’agir de

variations du “zéro” de référence lors des mesures

de pression ou de variations du positionnement

de l’échographe lors de la répétition des mesures

par le même examinateur ou par un autre. Il est

donc vraisemblable que la précision des mesures

de volumes soit de l’ordre de 20 % ou plus.

Les variations intra-individuelles

Elles sont souvent les plus importantes en biolo-

gie et en médecine. Il s’agit des fluctuations, des

variations d’un paramètre biologique, d’une per-

formance, autour de la valeur moyenne d’un indi-

vidu.

Reprenons l’exemple de la débitmétrie (7).

Admettons que la précision de la méthode phy-

sique soit de l’ordre de 1 %. Si on effectue deux ou

trois débitmétries successives chez le même

patient, on sait que les variations seront plus

importantes. Celles-ci ont plusieurs origines : effet

de l’habitude, modifications psychologiques,

variation du remplissage vésical, en volume ou en

vitesse... Si le délai entre deux mesures est plus

important, des variations spontanées, saison-

nières ou non, peuvent se faire sentir. Le phéno-

mène de régression vers la moyenne peut interve-

nir (3, 4, 6, 10, 12) en améliorant une performance

faible et en diminuant une performance élevée.

Enfin, signalons qu’il peut y avoir des difficultés à

identifier le débit maximum parmi les artéfacts ou

les pics anormaux d’une courbe de débitmétrie.

Finalement, si on dispose de plusieurs mesures

du débit maximum, laquelle choisir pour inclure

un patient ou servir de référence dans un essai cli-

nique ? Le problème n’est pas réglé, sauf à relé-

guer le débit en critère secondaire. Il ne faut sûre-

ment pas choisir le meilleur ou le moins bon, en

raison du risque de régression vers la moyenne.

La première solution gênerait la démonstration de

l’amélioration, la seconde la favoriserait. En théo-

rie, et par analogie avec les critères biologiques, la

solution juste au plan biostatistique consisterait à

établir la moyenne de deux évaluations du débit

maximum obtenues dans des conditions proches

(contexte, volumes, horaires...). Une autre solu-

tion serait de ne prendre qu’un seul débit, pourvu

qu’il soit obtenu dans de bonnes conditions, sans

se poser de questions supplémentaires.

D’une façon générale, une précision élevée sera

RÉFÉRENCES BIBLIOGRAPHIQUES

1. Altman DG, Bland JM. Measure-

ment in medecine : the analysis of

method comparison studies. The Sta-

tistician 1983 ; 32 : 307-17.

2. Bland JM, Altman DG. Statistical

methods for assessing agreement bet-

ween two methods of clinical measur-

ment. The Lancet 1986 ; 307-10.

3. Bland JM, Altman DG. Regression

towards the mean. Br Med J 1994 ;

308 : 1499.

4. Bland JM, Altman DG. Some

examples of regression towards the

mean. Br Med J 1994 ; 309 : 780.

5. Cam K, Senel F, Akman Y, Erol A.

The efficacy of an abbreviated model of

international prostate symptom score

in evaluating benign prostatic hyper-

plasia. Br J Urol 2003 ; 91 : 186-9.

6. Galton F. Regression towards

mediocrity in hereditary stature. J

Anthropological Institute 1886 ; 15 :

246-63.

7. Grise P, Sibert L, Pfister C.

Dysurie et adénome de la prostate :

renseignements fournis par la débit-

métrie. Progrès en Urol 1999 ; 9 : 146-50.

8. Lenormand L, Glémain P, Cordon-

nier JP, Brunel P, Karam G, Buzelin

JM. Exactitude des mesures obtenues

par une nouvelle sonde rectale à bal-

lonnet à air. Prog Urol 2001 ; 11 : 127-

31.

9. Papox L. Qualité des critères de

jugements. In : Essais cliniques.

Théorie, pratique et critique. G. Bou-

venot, M. Vray, Flammarion Méde-

cine-Sciences, Paris, 1994, 364 pages,

Chapitre III, pp. 25-38.

10. Prescott RJ, Garraway WM.

Regression to the mean occurs in

measuring peak urinary flow. Br J

Urol 1995 ; 76 : 611-3.

11. Rambeaud JJ, Terrier N, Rozet F,

Mongiat-Artus P, Muszinski R, Teillac

P. Validation d’une échelle visuelle

analogique (EVA) dans l’évaluation

clinique de la sévérité de l’HBP en

médecine générale. Premiers résul-

tats de la phase transversale de

l’étude EVAMIX. Abstract N° 035 au

96econgrès de l’AFU, Paris 2002. Prog

Urol 2002 ; 12 (suppl. 1) : 10A.

12. Sech SM et al. The so-called “pla-

cebo effect” in benign prostatic hyper-

plasia treatment trials represents

partially conditional regression to

the mean induced by censoring. Uro-

logy 1998 ; 51 : 242-50.

Reproductibilité des explorations en pelvi-périnéologie

8

Correspondances en pelvi-périnéologie - n° 3, vol. III - juillet/août/septembre 2003

demandée à un examen chargé de montrer une

variation (effet thérapeutique, par exemple) pour

un critère dont la variabilité entre les individus est

faible. Lorsque la variabilité intra- ou interindivi-

duelle est élevée, le problème de la précision ins-

trumentale est relégué au second plan. C’est le cas

de la débitmétrie et, vraisemblablement, des

chaînes de mesures de pression en urodynamique.

R

EPRODUCTIBILITÉ D

’

UN PARAMÈTRE

QUALITATIF OU SEMI

-

QUANTITATIF

:

LA CONCORDANCE

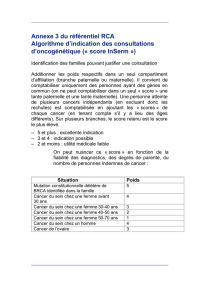

Le problème peut être posé ainsi : quelle est la

concordance entre deux médecins devant décider,

selon un ensemble de critères, s’il y a ou non un

signe, une pathologie, dans un groupe de

patients ? On peut alors se demander si telle ou

telle classification des prolapsus, des inconti-

nences, des dyssynergies est reproductible. Un

simple test, comme la manœuvre de Bonney, peut

ainsi être évalué.

On s’intéresse alors à la proportion de réponses

concordantes entre les deux médecins. Mais atten-

tion, cela n’est pas suffisant, car une partie des

concordances est le simple fait du hasard ! Il faut en

tenir compte dans le calcul définitif de la concor-

dance. Parmi les indices proposés, celui qui est le

plus souvent utilisé est le test Kappa de Cohen (voir

tableau).

C

AS PARTICULIER DE LA REPRODUCTIBILITÉ DES

SCORES DE SYMPTÔMES

Un score de symptômes comprend tout d’abord

une transformation de chacun des symptômes en

une échelle semi-quantitative, puis une addition de

l’ensemble des valeurs ainsi obtenues. C’est une

globalisation des symptômes. La validation d’un

score passe par plusieurs étapes (linguistique, bio-

métrique...). Mais, même ainsi validé, le score pose

des problèmes intrinsèques de reproductibilité.

Si un score est utilisé comme critère principal de

jugement, sa variation au cours du traitement est la

base de l’évaluation. Par exemple, pour un essai cli-

nique dans le domaine de l’HBP, des patients sont

inclus avec un score fonctionnel, l’IPSS, d’au moins

13. On mesure la variation de ce score au terme

d’une année de traitement. Admettons que l’on

puisse connaître la reproductibilité de l’IPSS

autoadministré ou présenté par le médecin. Qui

nous garantit que, derrière la même valeur de

l’IPSS, il y a la même répartition des symptômes ? Il

faut donc, devant un score total stable, vérifier ce

qui se passe derrière, et finalement revenir au

symptôme puisque l’amélioration de l’un a pu com-

penser, mathématiquement, l’aggravation de

l’autre. De plus, l’évolution du score total ne permet

pas de comparer les patients entre eux puisqu’elle

peut être le fait de symptômes différents.

Et cette situation risque encore de s’aggraver, avec

la tendance actuelle qui vise à réduire le nombre

d’items pris en compte dans un score (5) ou à le

remplacer par une seule question et une échelle

visuelle analogique (11). Cette façon de procéder ne

permettra même plus de remonter au symptôme.

Q

UESTIONS PRÉALABLES

À LA REPRODUCTIBILITÉ D

’

UN EXAMEN

Le passé pèse encore lourdement sur nos concep-

tions. Pour Galilée, il fallait “mesurer ce qui peut

être mesuré et rendre mesurable ce qui ne peut

l’être”. Depuis cet aphorisme, la science (occiden-

tale) n’accorde sa confiance qu’à des données

quantitatives réputées objectives. Et si, de plus, la

mesure est reproductible, on atteint le merveilleux.

Pourtant, le naturaliste Buffon, pour ne citer que lui,

à la fin du XVIIIesiècle, remit en cause cet idéal

mathématique. Il soutint en effet que les problèmes

posés par l’histoire naturelle étaient trop com-

plexes pour être résolus uniquement par les mathé-

matiques ; l’observation et la comparaison étaient

des méthodes appropriées à la biologie. On peut

ajouter que la sémiologie est une méthode adaptée

à la médecine. Pourtant, cette hégémonie du chiffre

persiste encore dans de nombreux domaines, dont

les sciences humaines et la médecine. Cela relève

parfois plus du scientisme que d’une démarche

scientifique. Ainsi, à côté de vrais paramètres quan-

titatifs comme le poids, la taille, la glycémie ou le

débit maximum, on a vu apparaître des échelles

visuelles ou verbales, des scores mélangeant diffé-

rents symptômes (comme un panier qui contien-

drait des choux, des carottes, des navets...), des

classifications en stades, des échelles de qualité de

vie... Ces artifices ont permis à des critères qualita-

tifs de mauvaise réputation d’accéder à la notoriété

du quantitatif, d’être plus faciles à manipuler par les

cliniciens et à travailler par les statisticiens (labou-

rage de données). Ainsi, tout le monde trouve son

compte dans le “tout quantitatif”. Mais, ces scores

s’éloignent de la réalité clinique. Ce sont de mau-

vais critères de substitution. Leur reproductibilité

n’est même plus un problème. Il est préférable de

travailler sur les symptômes. n

Degré d’accord Valeur de Kappa

Très bon ≥ 0,80

Bon 0,60 – 0,80

Moyen 0,40 – 0,60

Médiocre 0,20 – 0,60

Mauvais ≤ 20

Très mauvais (nul) 0

dossier

1

/

3

100%