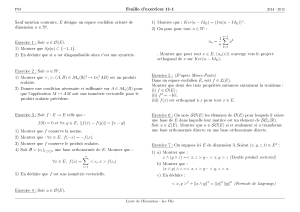

Résumé du cours

ERE

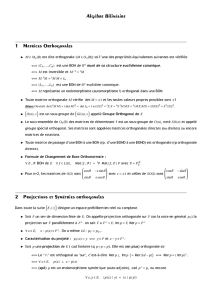

h·,·i:E×E→R

x, y ∈Ehx, yi

x, y ∈E

hx, yi=hy, xi ∀x, y ∈E.

x∈E

y7→ hx, yiy, y0∈E α ∈R

hx, y +αy0i=hx, yi+αhx, y0i.

x∈E x 6= 0

hx, xi>0.

kxk=phx, xi

x∈E

Rn

hX, Y i=tXY =

n

X

1

xiyi,kXk=v

u

u

t

n

X

1

x2

i.

E=C([a, b], R)

hf, gi=Zb

a

f(t)g(t)dt.

h·,·i RE

x= 0 hx, xi= 0 hx, xi ≥ 0x∈E

kx+yk2=kxk2+ 2hx, yi+kyk2,kαxk2=α2kxk2

h·,·i

x= 0 ⇐⇒ ∀yhx, yi= 0 ⇐⇒ kxk= 0.

h·,·i Rk·k

|hx, yi| ≤ kxkkykx y

x= 0 x6= 0

htx +y, tx +yi

h·,·i Rk·k k·k

E d(x, y) = kx−yk

hx, yi=1

4kx+yk2− kx−yk2.

Ch·,·i

x6= 0

hx, xi>0,hix, ixi>0,

hix, ixi=i2hx, xi=−hx, xi,

ECE

h·,·i:E×E→C

x, y ∈Ehx, yi

x, y ∈E

hx, yi=hy, xi.

hy, xia+ib =a−ib a, b ∈R

hx, xi=hx, xi hx, xi ∈ R

x∈E

y7→ hx, yiy, y0∈E α ∈C

hx, y +αy0i=hx, yi+αhx, y0i.

x∈E x 6= 0

hx, xi>0.

kxk=phx, xi

x∈E

Cn

hX, Y i=tXY =

n

X

i=1

xiyi.

h·,·i CE

hx+αx0, yi=hx, yi+αhx0, yi.

x= 0 hx, xi= 0 hx, xi ≥ 0x∈E

kx+yk2=kxk2+ 2<hx, yi+kyk2,kαxk2=|α|2kxk2

C

R

h·,·i Ck·k k·k

<hx, yi=1

4kx+yk2− kx−yk2.

=hx, yi=<ihx, yi=<hyx, yi

hx, yi=1

4kx+yk2− kx−yk2+ikix +yk2−ikix −yk2.

KR C

K E K ∈

{R,C}E, h·,·iE E

E F ⊆E

F E F

E

kx+yk2+kx−yk2= 2kxk2+ 2kyk2.

kxk1=|x1|+|x2|R2C2

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

1

/

29

100%