UE 6-3 Alg`ebre, Semestre 6, ann´ee 2016-2017

Correction de l’examen final

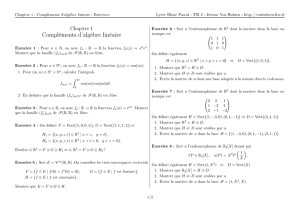

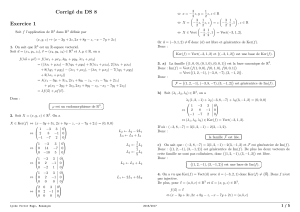

Exercice 1 :

1. On remarque que

u3=e1+e2−2e3,

u2=e2−e3,

u1+u2= 2e3.

On a donc trouv´e une forme ´echelonn´ee pour la famille (u1, u2, u3). On

en d´eduit que c’est une base de R3. Notons (e∗

1, e∗

2, e∗

3) la base duale

de la base canonique de R3. On voit imm´ediatement que, si on pose

u∗

3=e∗

1

on a u∗

3(u1) = u∗

3(u2) = 0 et u∗

3(u3) = 1. Pour trouver u∗

1et u∗

2,

remarquons que, si on prend

u∗

1=αe∗

1+1

2e∗

2+1

2e∗

3,

u∗

2=βe∗

1+1

2e∗

2−1

2e∗

3,

on a imm´ediatement u∗

1(u1) = 1, u∗

1(u2) = 0 et u∗

2(u1) = 0, u∗

2(u2) = 1.

On trouve les constantes αet βen imposant que u∗

1(u3) = u∗

2(u3) = 0.

Ces deux conditions nous donnent α= 1/2 et β=−3/2.

2. Les vecteurs u1et u2sont lin´eairement ind´ependants. Ils engendrent

donc un espace de dimension 2, autrement dit un hyperplan dans R3.

Cet hyperplan est le noyau d’une forme lin´eaire. Or, u1, u2∈Ker(u∗

3)

donc F= Vect(u1, u2)∈Ker(u∗

3). Comme Fet Ker(u∗

3) sont tous

deux de dimension 2, les deux espaces sont ´egaux :

F= Ker(u∗

3).

3. L’application φ:R3→R2d´efinie par φ(x)=(u∗

1(x), u∗

2(x)) est lin´eaire

et surjective : φ(u1) = (1,0) et φ(u2) = (0,1) forment une base de R2.

En utilisant le th´eor`eme du rang, on a donc dim(Ker(φ)) = dim(R3)−

1

dim(R2) = 3 −2 = 1. Or u3∈Ker(φ) donc, comme G= Vect(u3) est

de dimension 1, on a G= Ker(φ) :

G= Vect(u3) = Ker(φ) = Ker(u∗

1)\Ker(u∗

2).

Exercice 2 :

1. φ√2est un morphisme d’anneaux. Son noyau est donc un id´eal de

Q[X]. Comme Q[X] est principal, Ker(φ√2)=(P0) avec P0∈Q[X].

Nous allons montrer que (`a multiplication pr`es par un ´el´ement de Q∗),

P0=X2−2. En effet, on a clairement que X2−2∈Ker(φ√2). Donc

P0|(X2−2). Si X2−2 ´etait r´eductible dans Q[X], il admettrait un

diviseur de degr´e 1 dans Q[X], ce qui impliquerait que X2−2 admet

une racine dans Q, ce qui est impossible car ses racines sont ±√2

et aucune n’est dans Q. Comme P0|(X2−2), on a donc que P0est

constant ou associ´e `a X2−2. La premi`ere option est impossible P06= 0

car P0|(X2−2) et si P0=λ6= 0, P0(√2) = λ6= 0. On a donc montr´e

que P0est associ´e `a X2−2 donc qu’on peut prendre P0=X2−2 (car

ils engendrent le mˆeme id´eal) :

Ker(φ√2) = (X2−2).

2. Ceci d´ecoule en fait d’un r´esultat plus g´en´eral : Dans un anneau prin-

cipal A, si Iest un id´eal premier non nul, Iest maximal. Ici, soit Jun

id´eal de Q[X] tel que (P0)⊂J⊂Q[X]. Il existe Q∈Q[X] , Q6= 0 tel

que J= (Q). Comme P0∈J, on a Q|P0. Comme P0est irr´eductible,

ceci ne laisse que deux possibilit´es : soit Qest asoci´e `a P0, auquel cas

J= (P0), soit Qest une unit´e et J= (Q) = Q[X]. Ceci montre que

(P0) est maximal. L’anneau Q[√2] = Im(φ√2est donc un corps.

3. Soit x∈Q[√2]. Il existe, par d´efinition, un polynˆome P∈Q[X] tel que

x=P(√2). Effectuons la division euclidienne de Ppar P0=X2−2:

P= (X2−2)Q+R

avec R=bX +a, (a, b)∈Q2, un polynˆome de degr´e 1 et Q∈Q[X].

On a alors

x=P(√2) = 0 ×Q(√2) + R(√2) = a+b√2.

4. On voit facilement que l’application x7→ xsatisfait x+y=x+ypour

tous x, y ∈Q[√2]. (elle est mˆeme Q-lin´eaire). Pour montrer qu’on a

xy =xy pour tous x, y ∈Q[√2], ´ecrivons

x=a+b√2, y =a0+b0√2.

2

On a alors

xy = (aa0+ 2bb0)+(ab0+ba0)√2

xy = (aa0+ 2bb0)−(ab0+ba0)√2

xy = (a−b√2)(a0−b0√2)

= (aa0−2bb0)+(ab0+ba0)√2.

Et donc xy =xy. On a clairement

1 = 1 + 0√2=1−0√2=1.

Donc x7→ xest un morphisme d’anneaux dont l’image est clairement

contenue dans Q[√2]. Remarquons au passage que x=xdonc cette

application est une involution. En particulier, elle est bijective.

5. Si x∈Q, on a x=x+ 0√2 = x−0√2 = x. Notons P=anXn+

. . . +a1X+a0∈Q[X]. On a P(α) = 0 donc

0 = P(α)

=anαn+. . . +a1α+a0

=anαn+. . . +a1α+a0

=anαn+. . . +a1α+a0

=P(α),

ce qui montre que αest aussi une racine de P.

6. On proc`ede comme pour les nombres complexes. On a

(1 + √2)(1 + √2) = (1 + √2)(1 −√2) = 1 −2 = −1.

Donc

1

1 + √2=(1 + √2)

−1=√2−1.

En identifiant, on trouve a=−1 et b= 1.

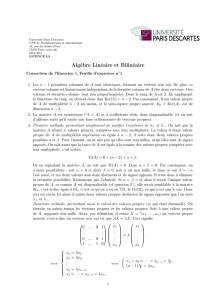

Exercice 3 :

Premi`ere partie

3

1. Proc´edons comme sugg´er´e par l’indication.

χAα(x) = det(Aα−xI3)

=

−1−x0α+ 1

1−2−x0

−1 1 α−x

=

−1−x0α+ 1

−1−x−2−x0

0 1 α−x

(C1←C1+C2)

=−(1 + x)

1 0 α+ 1

1−2−x0

0 1 α−x

=−(1 + x)

1 0 α+ 1

0−1−x−1−x

0 1 α−x

(L2←L2−L1+L3)

=−(1 + x)

−1−x−1−x

1α−x

= (1 + x)2

1 1

1α−x

= (1 + x)2(α−1−x).

2. Les racines du polynˆomes caract´eristique sont donc −1 (double) et

α−1 (simple) si α6= 0. Et si α= 0, −1 est racine triple de χAα.

3. Tout d’abord si α6= 0, la racine α−1 ne pose pas de probl`eme car

elle est simple. Regardons ce qu’il se passe pour l’espace propre E−1.

On r´esout

Aα

x

y

z

=−

x

y

z

,

On ´etudie donc le syst`eme

−x+ (α+ 1)z=−x

x−2y=−y

−x+y+αz =−z⇔

(α+ 1)z= 0

x=y

−x+y+ (α+ 1)z= 0 ⇔((α+ 1)z= 0

x=y

Si α6=−1, on voit que z= 0 et donc

E−1= Vect

1

1

0

4

est de dimension 1 donc toujours inf´erieure `a la multiplicit´e de −1

dans χAα.Aαn’est pas diagonalisable.

Si α=−1, par contre,

E−1= Vect

1

1

0

,

0

0

1

.

est de dimension 2 ´egale `a la multiplicit´e de −1 dans χAα. Et donc,

dans ce cas (et dans ce cas uniquement) Aαest diagonalisable.

4. Si α=−1, Aαest diagonalisable. Son polynˆome minimal est donc

scind´e `a racines simples et ses racines sont les valeurs propres de Aα:

ΠA−1= (X+ 1)(X+ 2).

Si α6∈ {0,−1},Aαest non-diagonalisable donc son polynˆome min-

imal n’est pas `a racines simples. Comme il divise le polynˆome car-

act´eristique (th´eor`eme de Cayley-Hamilton) et qu’il doit admettre

chaque valeur propre de Aαcomme racine, ceci ne laisse qu’une seule

possibilit´e, qu’il soit ´egal (au signe pr`es) au polynˆome caract´eristique

: ΠAα= (X+ 1)2(X−α+ 1).

Traitons finalement le cas α= 0. On a, de la mˆeme mani`ere que ce qui

pr´ec`ede, (X+1)|ΠA0et ΠA0|χA0(X)=(X+1)3. On ne peut pas avoir

ΠA0=X+ 1 car A0n’est pas diagonalisable. On v´erifie ´egalement

que (A0+I3)26= 0 (cf. seconde partie) donc ΠA06= (X+ 1)2, ce qui

ne laisse que la possibilit´e ΠA0= (X+ 1)3.

Seconde partie

1. L’espace propre de Aa ´et´e d´etermin´e dans la question 3 de la premi`ere

partie. L’espace caract´eristique N−1correspondant `a la valeur pro-

pre −1 est de dimension 3 (= la multiplicit´e de la racine −1 dans le

polynˆome caract´eristique), ceci ne laisse que la possibilit´e N−1=R3.

5

6

6

7

7

8

8

9

9

1

/

9

100%