polycopié - Pages personnelles à TELECOM Bretagne

Notes de Cours de Probabilit´es.

Thierry CHONAVEL

T´el´ecom Bretagne

thierry.chonav[email protected]

Juin 2000

1

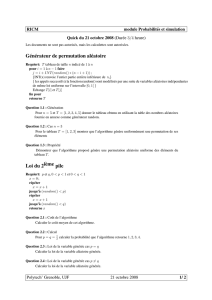

Table des mati`eres

1 Introduction. 4

2 Espace probabilis´e. 4

3 Probabilit´e sur un ensemble fini ou d´enombrable. 5

4 Probabilit´e sur un ensemble non d´enombrable. 6

4.1 Exemple...................................... 6

4.2 Mesures de probabilit´e absolument continues. . . . . . . . . . . . . . . . . 6

5 Probabilit´e conditionnelle. 7

6 Ev`enements ind´ependants. 7

7 Variable al´eatoires r´eelles. 8

7.1 D´efinition..................................... 8

7.2 Loi d’une variable al´eatoire. . . . . . . . . . . . . . . . . . . . . . . . . . . 9

7.3 Fonction de r´epartition. . . . . . . . . . . . . . . . . . . . . . . . . . . . . 9

8 Int´egration des variables al´eatoires. 10

8.1 Principe...................................... 10

8.2 Moments des variables al´eatoires. . . . . . . . . . . . . . . . . . . . . . . . 11

8.3 Fonction caract´eristique. . . . . . . . . . . . . . . . . . . . . . . . . . . . . 11

9 Couples de variables al´eatoires. 12

9.1 Loiconjointe. .................................. 13

9.2 Loismarginales.................................. 14

9.3 Int´egration des fonctions d’un couple de variables al´eatoires. . . . . . . . . 14

2

9.4 Changement de variables. . . . . . . . . . . . . . . . . . . . . . . . . . . . 15

9.5 Matrice de covariance. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 15

10 Esp´erance conditionnelle et loi conditionnelle. 16

10.1 Th´eor`eme de projection. . . . . . . . . . . . . . . . . . . . . . . . . . . . . 16

10.2 R´egression lin´eaire et affine. . . . . . . . . . . . . . . . . . . . . . . . . . . 16

10.3 Esp´erance conditionnelle. . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17

10.4Loiconditionnelle. ............................... 18

11 Variables al´eatoires ind´ependantes. 19

12 Vecteurs gaussiens. 19

12.1 Loi d’un vecteur gaussien. . . . . . . . . . . . . . . . . . . . . . . . . . . . 19

12.2 Esp´erance conditionnelle dans le cas gaussien. . . . . . . . . . . . . . . . . 20

13 Convergence des variables al´eatoires. 21

13.1 Convergence en probabilit´e. . . . . . . . . . . . . . . . . . . . . . . . . . . 21

13.2 Convergence en moyenne d’ordre α- Loi faible des grands nombres. . . . . 21

13.3 Convergence presque sˆure - Loi forte des grands nombres. . . . . . . . . . . 22

13.4 Convergence en loi - Th´eor`eme limite-centrale. . . . . . . . . . . . . . . . . 22

13.5 Relations entre les diff´erents types de convergence. . . . . . . . . . . . . . . 23

14 Quelques lois de probabilit´es classiques. 23

14.1Loisdiscr`etes................................... 23

14.2Lois`adensit´es. ................................. 25

3

1 Introduction.

Dans de nombreuses exp´eriences, le r´esultat n’est pas connu `a l’avance. Une telle exp´erience

est appel´ee exp´erience al´eatoire. Ce caract`ere al´eatoire peut ˆetre du `a une connaissance

plus ou moins incompl`ete des relations de cause `a effet qui conduisent au r´esultat de

l’exp´erience, ou de celle des valeurs de param`etres qui r´egissent ces relations, ou encore

au fait que les relations qui permettraient de pr´evoir le r´esultat sont trop complexes pour

qu’il puisse effectivement ˆetre calcul´e.

Dans de nombreuses exp´eriences, on a cependant quelque id´ee `a priori du caract`ere plus

ou moins vraisemblable des diff´erents r´esultats possibles. On peut alors convenir d’expri-

mer cette vraisemblance en affectant aux diff´erents r´esultats des grandeurs num´eriques,

cens´ees repr´esenter des mesures de leur vraisemblance. La manipulation de ces grandeurs

num´eriques pourra alors fournir de nouvelles informations sur l’exp´erience. La th´eorie des

probabilit´es vise `a formaliser ces id´ees intuitives.

Il est `a noter que le fait d’associer un mod`ele probabiliste `a une exp´erience n’indique

pas si le choix de ce mod`ele est pertinent, i.e. si les vraisamblences que l’on associe aux

r´esultats sont r´eellement repr´esentatives de cette exp´erience. Ce dernier point constitue

plutˆot un aspect de la th´eorie des statistiques, qui sera envisag´ee en deuxi`eme ann´ee.

Ce polycopi´e reprend dans ses grandes lignes des notes de cours utilis´ees `a l’´ecole depuis

de nombreuses ann´ees [10]. On compl´etera utilement le cours de probabilit´e par la lecture

du polycopi´e de th´eorie de la mesure [11] distribu´e par ailleurs. La th´eorie des probabilit´es

s’inscrit en effet naturellement dans le cadre de la th´eorie de la mesure. De plus, la th´eorie

de la mesure est tr`es utilis´ee dans l’ensemble des math´ematiques de l’ing´enieur.

2 Espace probabilis´e.

On appelle espace probabilisable (ou espace mesurable) la donn´ee d’un couple (Ω,B),

o`u Ω est un ensemble, et Bune tribu de parties de Ω, c’est `a dire un ensemble de

parties de Ω, contenant Ω, et stable pour les op´erations de compl´ementation et de r´eunion

d´enombrable : Ω∈ B

A∈ B ⇒ Ac∈ B

(An)n=1,+∞∈ B ⇒ ∪n=1,+∞An∈ B.

(1)

Lorsque Ω est fini ou d´enombrable, on choisit souvent (mais pas n´ecessairement) comme

tribu l’ensemble P(Ω) des parties de Ω. Lorsque Ω = R, on choisit g´en´eralement la tribu

bor´elienne de R, not´ee B(R) qui est la plus petite tribu (au sens de l’inclusion) qui contient

les intervalles de Rde la forme [a, b] (ou de fa¸con ´equivalente de la forme [a, b[, ou encore

de la forme ] − ∞, a], ...).

La plus petite tribu qui contient un ensemble donn´e de parties de Ω est appel´ee la tribu

engendr´ee par cet ensemble. Notons que l’intersection de plusieurs tribus est encore une

4

tribu. Par suite, la tribu engendr´ee par un ensemble est l’intersection des tribus qui le

contiennent.

On appelera ´ev`enement associ´e `a une exp´erience al´eatoire une condition portant sur le

r´esultat de cette exp´erience. En fait, on convient d’identifier cet ´ev`enement `a l’ensemble

des valeurs de Ω pour lesquelles la condition qui d´efinit cet ´ev`enement est r´ealis´ee. Ainsi,

un ´ev`enement Eest identifi´e `a l’ensemble

{ω∈Ω; la condition Eest satisfaite pour le r´esultat ω}.

La donn´ee d’une tribu peut donc ˆetre vue comme la sp´ecification d’une classe d’´ev`enements

particuli`ere. Quand les ´el´ements de Ω d´efinissent des singletons {ω}qui appartiennent `a

B,{ω}est parfois appel´e ´ev`enement ´el´ementaire.

On verra que l’on ne peut pas toujours mod´eliser une exp´erience al´eatoire en se donnant

simplement une mesure de la vraisemblance de chacun des r´esultats possibles, mais que

cela peut ˆetre fait en se donnant celle des ´ev`enements d’une tribu. La notion de me-

sure de probabilit´e permet de donner une forme math´ematique `a la notion intuitive de

vraisemblance d’un ´ev`enement.

Un espace probabilis´e est donn´e par un triplet (Ω,B, P ), o`u (Ω,B) est un espace pro-

babilisable, et Pune mesure de probabilit´e sur B, i.e. une application d´efinie sur Bet

`a valeurs dans [0,1], telle que

P(Ω) = 1,

∀(An)n=1,+∞,avec Ai∩Aj=∅pour i6=j, P (∪n=1,+∞An) = Pn=1,+∞P(An).

(2)

Cons´equences. On v´erifie que ∀A, B ∈ B

A⊂B⇒P(A)≤P(B),

P(A∪B) = P(A) + P(B)−P(A∩B),

(3)

et plus g´en´eralement, pour une famille (An)n=1,N quelconque , la formule de Poincarr´e

indique que

P(∪n=1,N An) = Pn=1,N P(An)−Pi<j P(Ai∩Aj) + Pi<j<k P(Ai∩Aj∩Ak)

. . . + (−1)N−1P(∩n=1,N An).

(4)

Notons enfin qu’une mesure de probabilit´e est enti`erement caract´eris´ee par les valeurs

qu’elle prend sur une famille g´en´eratrice de la tribu sur laquelle elle est d´efinie.

3 Probabilit´e sur un ensemble fini ou d´enombrable.

Pour fixer les id´ees, supposons que Ω = {1,2, ..., N}, ou Ω = N. Dans ce cas, on prend

souvent B=P(Ω). La donn´ee d’une suite de nombres positifs (pk)k∈Ω, avec Pkpk= 1

5

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

1

/

28

100%