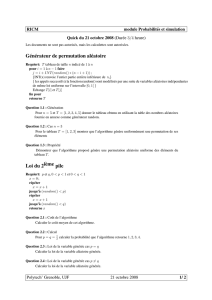

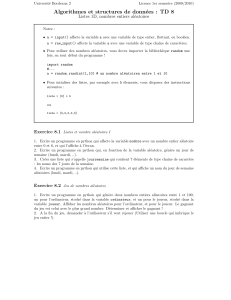

Le fichier pdf du TD 5.

M´ethodes inverses

Travaux dirig´es

S´

eance 5 — Coombinaison de distributions gaussiennes

Semaine du 9 mars 2009

Rappels et Compl´ements

Soit Xune variable al´eatoire continue.

•Une densit´edeprobabilit´eassoci´ee `aXest une fonction fX(x) telle que

P(b≥X≥a)=8b

a

fX(x)dx

est la probabilit´equeXprenne une valeur xcomprise entre aet br´eels. On a $b

afX(x)dx ≥0et

$∞

−∞ fX(x)dx =1.

•La densit´e de probabilit´ee cumul´ee (cdf) associ´ee `aXest la fonction

FX(x)=P(x≥X)=8x

−∞

fX(u)du;

ainsi la densit´e de probabilit´edeXest la d´eriv´ee de la cdf : fX(x)=F

X(x).

•L’esp´erance de la variable al´eatoire continue Xest d´efinie par

E(X)=8∞

−∞

xf

X(x)dx.

•Si Y=g(X) est une fonction de la variable alatoire X,alorsYest aussi une variable al´eatoire et son

esp´erance est donn´ee par

E(Y)=8∞

−∞

yf

Y(y)dy =8∞

−∞

g(x)fX(x)dx.

•La variance de la variable al´eatoire Xest d´efinie par

var(X)=Ep[X−E(X)]2Q.

•L’´ecart-type de la variable al´eatoire Xest la racine carr´ee de sa variance :

σ(X)=0var(X).

•Le k-i`eme moment de la variable al´eatoire Xest d´efini par E(Xk).

•La fonction g´en´eratrice des moments de Xest d´efinie par MX(t)=E(etX ). Ses d´eriv´ees successives

sont ´egales aux moments : M(k)

X(t)=E(Xk).

•La fonction caract´eristique de Xest d´efinie par ΦX(t)=E(eitX ). Sa transform´ee de Fourier est la

densit´e de probabilit´e, et ses d´eriv´ees successives permettent aussi de d´eterminer les moments.

0. Questions prliminaires

•Montrer que E(αX)=αE(X), o`uαest un scalaire.

•Montrer que E(X+Y)=E(X)+E(Y), o`uXet Ysont des variables al´eatoires ayant la mˆeme densit´e

de probabilit´e.

•Montrer que E[X−E(X)] = 0.

•Montrer que var(X)=E(X2)−[E(X)]2.

1. On rappelle que la loi gaussienne correspond `aladensit´e de probabilit´esuivante: f(x)= 1

σ√2πe−(x−x0)2

2σ2.

Soient deux variables al´eatoires ind´ependantes Xet Y,repr´esent´ees par deux distributions de proba-

bilit´e gaussiennes fX(x)etfY(y).

•D´eterminer la densit´e de probabilit´ejointefXY (x, y).

•D´eterminer le nombre Ket les matrices A et C tels que fXY (x, y)=Ke−1

2ATC−1A.Cestla

matricedecovariance.Lorsquelesvariablesal´eatoires sont ind´ependantes, elle est diagonale.

2. Quand les variables al´eatoires ne sont pas ind´ependantes, la matrice de covariance est une matrice

sym´etrique non-diagonale et ses ´el´ements diagonaux sont les variances des variables al´eatoires. Soit la

matrice C = w2−2

−25

W. Calculer la matrice diagonale D et celle de changement de base S, telles

que C = SDST. Que dire alors des composantes du vecteur SA ?

3. Soit fX1X2(x1,x

2)ladensit´e de probabilit´ejointedesvariablesal´eatoires X1et X2.Quesontles

densit´es de probabilit´e marginales fX1(x1)etfX2(x2)?

4. La covariance de deux variables al´eatoires X1et X2est d´efinie par

cov(X1,X

2)=8∞

−∞ 8∞

−∞

[x1−E(X1)][x2−E(X2)] fX1X2(x1,x

2)dx1dx2,

et les ´el´ements de la matrice de covariance sont donn´es par

Cij =8∞

−∞ 8∞

−∞

[xi−E(Xi)][xj−E(Xj)] fXiXj(xi,x

j)dxidxj,

o`uiet jvalent 1 ou 2.

•Montrer que cov(X, X)=var(X).

•Montrer que si Xet Ysont deux variables al´eatoires ind´ependantes, cov(X, Y )=0.

•On rappelle que cov(X, X)=var(X)=ED[X−E(X)2i=E(X2)−[E(X)]2. Montrer que cette

propri´et´epeutseg´en´eraliser pour X1et X2deux variables al´eatoires quelconques, cov(X1,X

2)=

E([X1−E(X1)][X2−E(X2)]) = E(X1X2)−E(X1)E(X2).

5. Soient X1et X2deux variables al´eatoires gaussiennes, d’´ecart-types respectifs σ1et σ2,etfX1X2(x1,x

2)

la densit´edeprobabilit´ejointedeX1et X2.Onpr´ecise que cette densit´ededistributionjointe

peut se mettre sous la forme vue `a la question 1, avec une matrice de covariance Cnon diagonale

et un facteur Kdonn´eparK−1=2π0var(X1)var(X2)−cov(X1,X

2)2.D´eterminer les courbes

fX1X2(x1,x

2) = constante, dans le plan (x1,x

2) en posant cov(X1,X

2)=rσ1σ2,o`urest appel´e

le coefficient de corr´elation (1 ≥|r|).

1

/

2

100%