PDF 1.1 Mo M2.1 - Sequence 4

MASTER II ECONOMIE ET GESTION

Spécialité Management des Organisations de la Neteconomie

MODULE D01 - Séquence 4

INTRODUCTION

I. DU MANAGEMENT DE L'INTELLIGENCE ORGANISATIONNELLE

1.1. De l'émergence du concept de benchmarking

1.2. A sa mise en oeuvre

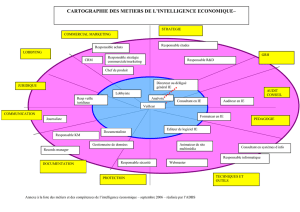

II. AU MANAGEMENT DE L'INTELLIGENCE COLLECTIVE

2.1. De l'émergence du concept d'intelligence collective

2.2. A sa mise en oeuvre

CONCLUSION

BIBLIOGRAPHIE

SITOGRAPHIE

QUIZ 1

QUIZ 2

APPLICATION 1

APPLICATION 2

APPLICATION 3

DIAPORAMA

Auteur : M. Alain DEPPE

MANAGEMENT DE L'INFORMATION ET COMPETITIVITE DES

ORGANISATIONS

Séquence 4 : Du Management de l'Intelligence Organisationnelle au Management

de l'Intelligence Collective

Objectif général :

- Comprendre l'importance de l'économie de l'information dans les dynamiques

de changement organisationnel et de reconfiguration identitaire

Objectifs intermédiaires :

- Reconnaître et caractériser les différents types de benchmarking

- Mettre en place une opération méthodologique de benchmarking au sein de l'entreprise

en respectant les différentes étapes

- Distinguer les différentes formes de l'Intelligence Collective

- Percevoir la nécessité d'une évolution du comportement de l'entreprise et de ses acteurs

INTRODUCTION

La logique de compétition internationale sous-tendue par la globalisation se traduit par

des modifications en profondeur de l'environnement économique. Dans ce cadre, nous avons

vu que l‛information était perçue à la fois comme un capital (à la valeur économique évaluable

et croissante), comme un nouveau matériau stratégique (permettant des gains de

productivité) et surtout comme un facteur de stabilité (utilisé à la fois comme une

arme défensive pour trouver les parades aux menaces et comme une arme

offensive d‛influence pour tirer profit des opportunités qui se présentent). Le traitement,

la gestion et le partage d‛informations ne se limitent plus seulement à l'intégration des

TIC dans les pratiques managériales ou à la mise en place de cellules de veille. Ces

opérations sont devenues des axes prioritaires de développement qui passent

nécessairement par un traitement optimal de l‛information stratégique pour favoriser

la décision et la mise en place de stratégies de changement. Le règlement des

difficultés inhérentes aux échanges entre les individus a conduit les organisations à opérer

une révolution des pratiques à partir desquelles, tout d'abord, l'intelligence humaine a révélé

la capacité qu'ont les individus à mutualiser leurs savoir faire. De là à penser que

le développement des connexions interpersonnelles pouvait générer corrélativement

un accroissement de l'intelligence organisationnelle, il n'y avait qu'un pas allègrement

franchi au cours des années 90 par les entreprises qui ont bien saisi les enjeux de

la compétitivité et de la performance au sein de la société de l'information. Après

avoir présenté, dans une première partie, les fondements et les outils du Management

de l'Intelligence Organisationnelle (MIO), la séquence développera, dans une deuxième

partie, les différentes dimensions du Management de l'Intelligence Collective (MIC).

I. DU MANAGEMENT DE L'INTELLIGENCE ORGANISATIONNELLE

Si les fondements du MIO apparaissent déjà en filigrane, au début du XXe siècle, dans

les travaux de Taylor (l'observation empirique des comportements et des

performances individuelles permet d'établir un référentiel des compétences à partir

des meilleures pratiques identifiées dans l'entreprise et de systématiser au sein

de l'organisation un modèle d'efficacité généralisable), chacun s'accorde à considérer

que cette technique a été développée, sous le nom de benchmarking, au début des années

80, dans la sphère industrielle puis importée dans la sphère publique par l'Ecole du New

Public Management.

1.1. De l'émergence du concept de benchmarking

A l'ère du numérique, les changements rapides dans l'environnement de

l‛entreprise réclament une réactivité immédiate ; c‛est pourquoi il convient d'en connaître

les caractéristiques et les outils de sa mise en œuvre

1.1.1. Le développement du concept

La paternité du concept de benchmarking semble revenir, si l'on en croit la

littérature managériale, à la société américaine Rank Xerox.

1.1.1.1. La propagation du concept

Durement attaquée, au milieu des années 70, par la concurrence japonaise (Canon,

Minolta, Ricoh, Sharp), la société Rank Xerox (leader mondial des photocopieurs au milieu

des années 70 avec plus de 80 % de part de marché) perd, en moins de cinq années, la

moitié de ses parts de marché (elle passe de 82 % à 41 % entre 1976 et 1981).

L'analyse menée sur

la compétitivité des produits concurrents (aussi bons et moins chers) par Robert

Camp (Directeur chez Xerox du programme intitulé « Product quality and

features comparisons ») montre que la réponse que Rank Xerox doit apporter à cette

situation problématique se situe au niveau du processus de production lui même.

Elle constate, en particulier, que l‛un des éléments sur lequel s'appuient les

concurrents japonais est l‛échange sur les "best practices" qui s'effectuent entre

entreprises d‛activités différentes appartenant au même "

keiretsu

". Plutôt que de

réfléchir seules dans leur coin sur leurs pratiques managériales, les entreprises

japonaises avaient compris l'intérêt d'accroître leur intelligence organisationnelle au travers

la capitalisation des expériences de leurs partenaires en identifiant celui ou ceux

qui réalisaient de la manière la plus performante un processus ou une tâche, en les

observant et en adaptant ensuite ce processus à leur propre organisation (encadré 1).

Confronté à une situation financière critique, Xerox décide alors de réagir et de

s'intéresser, à son tour, aux meilleures pratiques de ses partenaires et de la concurrence

et de se comparer aux meilleures entreprises dans ses différentes fonctions ou métiers.

La société décide, pour accroître l'efficacité de son propre MIO, de se comparer

aux entreprises réputées pour exceller dans un des maillons de sa chaîne de valeur

(une société de vente d‛articles de sport par correspondance, L.L. Bean, qui excellait pour

la gestion des commandes, l'entreprise Toyota pour le pliage des tôles, et d'autres

encore reconnues pour leur expertise dans tel ou tel processus managérial).

Dès 1981, la pratique du benchmarking (néologisme fabriqué à partir de la contraction de

deux locutions qui sont

bench testing

- banc d'essai - et

marking

- notation -) fut appliquée

à l ‛ensemble des activités du groupe sous la forme d'un processus d'évaluation continu

des méthodes des entreprises leaders.

Xerox ne s'est pas contenté, en l'occurrence, d'importer un modèle conceptuel performant

au sein de son dispositif organisationnel ou de dupliquer une méthode qui a fait ses

preuves. Grâce à elle, le concept de benchmarking a fait acte de propagation nomade

dans l'ensemble des sociétés américaines en partie grâce à Robert Camp qui

définit simplement la discipline comme « la recherche des méthodes les plus

performantes pour une activité donnée, permettant de s‛assurer une supériorité ».

L‛emploi effectif

du benchmarking

s'est généralisé à

tous les secteurs,

tant au niveau

géographique qu'à

celui des domaines

d'application.

Le benchmarking

implique toutefois

de connaître sa

propre organisation

avant de vouloir se

renseigner sur

celles des autres.

Il suppose donc que

l'entreprise réalise

une analyse très

détaillée de son

propre processus

et détermine les

indicateurs

(encadré 2) qui

vont lui permettre

de mesurer ses propres performances et de les comparer.

Ces indicateurs (benchmarks pour se comparer soi-même avec le ou les meilleurs dans

le domaine concerné ou scoregards pour mesurer la performance de l'entreprise par rapport

à des objectifs prédéfinis) devront à la fois correspondre aux pratiques internes

de l'entreprise et à celles du secteur d'activité dans lequel elle se trouve. Leur sélection

est du domaine de responsabilité du décideur. Son objectif sera d'assurer la comparabilité

qui sera de fait elle-même un indicateur de base dans la mise en place de la démarche

du benchmarking.

Ce type d'activités est à la base même de la définition des politiques marketing de

la démarche opérationnelle. Le benchmarking, discipline apparue récemment dans

les entreprises, est ainsi souvent considéré comme une extension, voire une généralisation

de la démarche marketing et des analyses concurrentielles et/ou des pratiques de

veille afférentes comme le montre le tableau ci-dessous (tableau 1)

Cette approche met en évidence le lien étroit entre les pratiques mercaticiennes et

la démarche des benchmarkers pour lesquelles les analyses concurrentielles

apparaissent comme un trait d'union.

Tableau 1 - Le benchmarking, extension de la démarche marketing

Recherche marketing Analyse concurrentielle Benchmarking

Objectif

global

Analyser les marchés,

leur segmentation,

l'impact des produits

Analyser les stratégies des

concurrents (à leur insu)

Analyser ce que font les

meilleurs, pourquoi et

avec quels résultats

Principal objet

d'étude

Les besoins des clients Les stratégies concurrentes Les méthodes qui répondent

aux besoins des clients

Champ

d'application

Les produits et services Le marché et les produits Les méthodes aussi bien

que les produits

Limites

Porte essentiellement sur

la façon dont les besoins

des clients sont satisfaits Les activités du marché Pas de limites : benchmarking

interne, concurrentiel, ou

fonctionnel

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

1

/

70

100%