Reconnaissance de Forme Statistique

Reconnaissance de Forme Statistique

James L. Crowley

Deuxième Année ENSIMAG Troisième Bimestre 2001/2002

Séance 1 27 mars et 2 avril 2002

Reconnaissance, Probabilité et la Règle de Bayes

Plan de la séance :

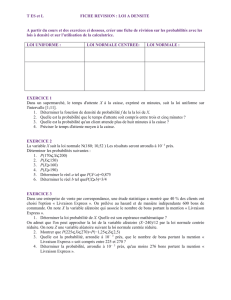

Notations...............................................................................2

Introduction et quelques définitions..................................3

Les Observations.................................................................4

La classification..................................................................5

La probabilité d'un évenement..........................................7

Définition Fréquentielle.......................................................7

Définition Axiomatique. ......................................................7

La probabilité de la valeur d'une variable aléatoire.................8

Exemple : Les statistiques de pixel couleurs......................... 10

Probabilité a posteriori : Le cas de variable discret.............. 12

La Règle de Bayes............................................................13

La règle de Bayes avec une ratio d'histogrammes................. 15

La Loi Normale.................................................................16

Estimations des moments d'une densité................................ 17

La Loi Normale................................................................ 19

Estimation d’un vecteur de variables aléatoires..................... 19

Notes des Cours sur Web :

http://www-prima.imag.fr/Prima/Homepages/jlc/Courses/Courses.html

Sources :

"Statistical Pattern Recognition", K. Fukunaga, Academic Press, 1990.

"Pattern Recognition and Scene Analysis", R. E. Duda and P. E. Hart, Wiley, 1973.

Reconnaissance, Probabilité et la Règle de Bayes Séance 1

Notations

x

→ Un vecteur

DNombre de dimensions de X

→

wkLa classe k

k Indice d'une classe

K Nombre de classes

MkNombre d'exemples de la classe k.

MNombre totale d'exemples de toutes les classes

pk, p(wk) Probabilité a priori de rencontrer un membre de la classe k.

X

→ , Y

→ Une observation (un vecteur aléatoire).

P(X

→) Probabilité d'une observation X

→

pk(X

→) Probabilité d'une observation X

→ pour la classe wk

pk(X

→) = p(X

→ | wk)

P(X

→) = ∑

k=1

K p(X

→ | wk) p(wk)

qk(X

→) La probabilité a posteriori de wk étant donnée X

→

qk(X

→) = P(wk | X

→ ) = p(X

→ | wk ) p(wk)

p(X

→) = p(X

→ | wk ) p(wk)

∑

k=1

K p(X

→ | wk) p(wk)

1-2

Reconnaissance, Probabilité et la Règle de Bayes Séance 1

Introduction et quelques définitions.

La reconnaissance de forme est la science des méthodes de classification de

phénomènes.

Phénomène : tout ce qui est objet d'expérience possible. Tout ce qui se manifeste

par l'intermédiaire des sens. (ref : Critique de la Raison Pure, I. Kant, 1781)

Une observation : une constatation attentive des phénomènes.

Pour des machines, des observations sont fournies par les capteurs.

Forme n. f. : A. Apparence, aspect visible. 1) ... 2) apparence extérieure donnant

à un objet ou à un être sa spécificité.

B. Réalisation particulières et concrète d'un fait général 1) Manière

variable dont une notion, une idée, un événement, une action se

présente.

Les méthodes statistique de la reconnaissance de forme traite les observations sous

forme de vecteur de caractéristiques.

Caractéristiques : (En anglais : Feature) Signes ou ensembles de signes distinctifs.

Une ensemble de propriétés.

{ x1, x2 ... xn}.

En notation vectorielle :

X

→ =

x1

x2

...

xn

La formation des vrais objets physiques est sujette aux influences aléatoires.

Pour les objets d'une classe, wk, les propriétés des objets individuels sont,

les valeurs aléatoires. On peut resume ceci par une somme d'une forme

"intrinsèque" x

→ plus ces influences aléatoires individuelles, B

→i.

X

→ = x

→ + B

→i

1-3

Reconnaissance, Probabilité et la Règle de Bayes Séance 1

Toutes les techniques étudiées dans ce cours suppose un bruit additif.

L'influence aléatoire individuelle, B

→i est spécifique à un individuel par rapport de

son classe et indépendant des observations.

En notation vectorielle :

X

→ =

X1

X2

...

Xn

=

x1

x2

...

xn

+

B1

B2

...

Bn

Les Observations

Les propriétés sont observées au travers des capteurs.

Ceci donne une observation (un phénomène) sous forme d'une ensemble de

caractéristiques : { Y1, Y2 ... Yn}.

Y

→=

Y1

Y2

...

Yn

Les observations sont corrompues par un bruit, B

→o.

Y

→ = X

→ + B

→o

Le bruit est, par définition, imprévisible. Il est aléatoire.

Donc les caractéristiques observées sont des vecteurs aléatoires.

La corruption des observations par un bruit aléatoire est fondamentale aux capteurs

physiques.

Parce que des caractéristiques sont des vecteurs à N dimensions, nous allons faire

appel aux méthodes de la géométrie des espaces à N dimensions pour construire les

techniques de reconnaissance.

1-4

Reconnaissance, Probabilité et la Règle de Bayes Séance 1

Exemple : Le spectre des plantes observées par un satellite.

Une image satellite est composée de pixels s(x, y). Chaque pixel compte le nombre

de photons issus d’une surface carrée de la terre (ex. 10 m2.).

Les photons sont captés au travers des filtres spectraux. Ceci donne une vecteur de

caractéristiques pour chaque pixel.

x

→ : Le spectre des pigments des feuilles pour une espece.

B

→i : Les variations du spectre intrinsèque dues aux variations d'age ou

d'humidité. B

→i est spécifique à un individu. Il ne change pas entre les observations.

X

→ = x

→ + B

→i : Le spectre des pigments des feuilles pour un individu

B

→o : Les variations d'observations dues à l'angle du soleil et les effets de

filtrage de la lumière par l'atmosphère (humidité, pollution etc).

La classification

La classification est une capacité fondamentale de l'intelligence.

Comprendre : Faire entrer dans une catégorie.

Les perceptions brutes (les phénomènes) sont comprise par l'association aux

catégories mentales (les concepts).

La capacité de classer les phénomènes est caractéristique à toute espèce vivante.

Reconnaissance : Le fait de reconnaître, d'identifier un objet, un être comme tel.

Reconnaître : A. Saisir un objet par la pensée, en reliant entre elles, des images,

des perceptions. Identifier par la mémoire, le judgement ou l'action.

1. Penser un objet présent comme ayant déjà été saisi par la pensée.

2. Juger un objet ou un concept comme compris dans une catégorie.

Identifier : Reconnaître un individu

Classer : Reconnaître un membre d'une catégorie, ou d'une classe.

Classe: n. f. 2) Ensemble d'individus ou d'objets qui ont des caractères communs.

ensemble n. m. : un groupe.

1-5

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

1

/

22

100%