Forêts aléatoires et sélection de variables : analyse des données

Forˆets al´eatoires et s´election de variables : analyse des

donn´ees des enregistreurs de vol pour la s´ecurit´e

a´erienne

Baptiste Gregorutti

To cite this version:

Baptiste Gregorutti. Forˆets al´eatoires et s´election de variables : analyse des donn´ees des

enregistreurs de vol pour la s´ecurit´e a´erienne. Statistiques [math.ST]. Universit´e Pierre et

Marie Curie - Paris VI, 2015. Fran¸cais. <NNT : 2015PA066045>.<tel-01146830>

HAL Id: tel-01146830

https://tel.archives-ouvertes.fr/tel-01146830

Submitted on 29 Apr 2015

HAL is a multi-disciplinary open access

archive for the deposit and dissemination of sci-

entific research documents, whether they are pub-

lished or not. The documents may come from

teaching and research institutions in France or

abroad, or from public or private research centers.

L’archive ouverte pluridisciplinaire HAL, est

destin´ee au d´epˆot et `a la diffusion de documents

scientifiques de niveau recherche, publi´es ou non,

´emanant des ´etablissements d’enseignement et de

recherche fran¸cais ou ´etrangers, des laboratoires

publics ou priv´es.

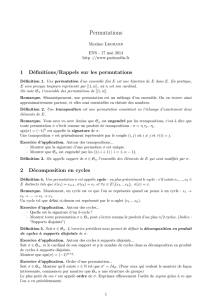

École Doctorale de Science Mathématiques de Paris Centre

Thèse de doctorat

Discipline : Mathématiques

Spécialité : Statistique

présentée par

Baptiste Gregorutti

Forêts aléatoires et sélection de variables :

analyse des données des enregistreurs de vol

pour la sécurité aérienne

Soutenue le 11 mars 2015 devant le jury composé de :

M. Gérard Biau Univ. Pierre et Marie Curie directeur

M. Michel Broniatowski Univ. Pierre et Marie Curie examinateur

M. Bertrand Iooss EDF R&D rapporteur

M. Pierre Jouniaux Safety Line encadrant

M. Bertrand Michel Univ. Pierre et Marie Curie co-directeur

Mme Florence Nicol ENAC examinateur

M. Jean-Michel Poggi Univ. Paris-Sud Orsay rapporteur

M. Fabrice Rossi Univ. Paris 1 Panthéon-Sorbonne examinateur

M. Philippe Saint Pierre Univ. Pierre et Marie Curie co-directeur

2

Laboratoire de statistique théorique et appliquée (LSTA)

Université Pierre et Marie Curie (Paris 6)

Boîte 158, Tours 15-25, 2ème étage

4 place Jussieu

75252 Paris Cedex 05

Safety Line

15 rue Jean-Baptiste Berlier

75013 Paris

École Doctorale de Sciences Mathématiques de Paris Centre

Université Pierre et Marie Curie (Paris 6)

Boîte 290, Tours 15-25, 1er étage

4 place Jussieu

75252 Paris Cedex 05

Remerciements

L’environnement dans lequel j’ai évolué durant ces trois années de thèse a été idéal. C’est

sans aucun doute grâce à la disponibilité de mes directeurs de thèse ainsi qu’à l’intérêt

qu’ils ont porté à mon travail et à Safety Line.

Je remercie tout d’abord Gérard qui a bien voulu m’accepter parmi ses thésards

chanceux. Il a su être présent à chaque fois que j’en avais besoin, et ce malgré ses diverses

responsabilités, notamment à la tête du LSTA. Ses conseils précieux et ses remarques

franches m’ont permis de valoriser mon travail et ont été d’une grande aide lors de la

rédaction de ce manuscrit.

Je suis sincèrement reconnaissant envers Bertrand et Philippe qui ont su me guider au

quotidien, notamment dans la façon d’aborder le problème difficile qui m’était posé. Je les

remercie pour les réunions constructives autour de la machine à café où ils m’ont appris la

rédaction d’un article de recherche, chose qui ne m’était pas acquise au départ. Gérard,

Bertrand et Philippe, je peux affirmer que, grâce à vous, je suis fier de ce manuscrit.

J’espère avoir l’occasion de continuer à travailler avec vous dans le futur.

Une thèse CIFRE est le fruit d’un partenariat entre un laboratoire de recherche et une

entreprise. La réussite de cette thèse est de ce fait également due aux conditions que m’a

donné Pierre au sein de Safety Line. Merci, Pierre, pour m’avoir fait confiance et m’avoir

permis de participer, à mon humble niveau, au développement de Safety Line. J’ai tout

particulièrement apprécié travailler avec toi dans les locaux de 10 m2à l’incubateur de

Telecom Paristech : une table, une chaise et un ordinateur portable, nous n’avions besoin

de rien de plus... Durant ces trois années, j’ai pu voir de près ce qu’est le fonctionnement

d’une startup et les nombreuses difficultés rencontrées. Malgré les embuches, tu as su

garder le cap – trait de caractère tout à fait cohérent avec ta formation de pilote de ligne

– et tu as su mené Safety Line là où elle est actuellement. Tu m’as beaucoup appris, tant

humainement que professionnellement. Pour tout cela, je te remercie.

Je remercie également Jean-Michel Poggi et Bertrand Iooss pour m’avoir fait l’honneur

de rapporter ma thèse. Merci pour votre lecture attentive, pour vos remarques construc-

tive ainsi que pour l’intérêt que vous portez à mes travaux.

Merci à Michel Broniatowski, Florence Nicol et Fabrice Rossi pour avoir accepté de

participer à mon jury. Je suis particulièrement reconnaissant envers Michel Broniatowski

de m’avoir orienté vers Gérard au moment où j’étais à la recherche d’un sujet de thèse.

Je tiens à remercier toutes les personnes que j’ai côtoyé au LSTA pendant ces trois

années et particulièrement les doctorants. Un grand merci aux “Biau-men”, Benjamin,

Clément et Erwan pour les excellents moments passés ensemble. Merci à Cécile pour son

4

humour sans failles. Merci aux actuels résidents du bureau 204, Assia, Roxane, Quyen,

Matthieu et les anciens Sarah L., Sarah O., Aurélie, Manu, Virgile et Abdullah. Plus

généralement, je remercie Mokhtar, Amadou, Alexis, Svetlana, Boris ainsi que Jean-

Patrick, Agathe, Stéphane, Olivier L., Olivier W., Étienne, Fanny sans oublier Louise,

Corinne et Pascal.

J’adresse mes sincères remerciements aux collègues, qui contribuent à la formidable

ambiance qui règne chez Safety Line. Merci à Karim, Éric, Claude, Kristof (pour avoir

eu l’idée d’acheter des mini paniers de basket), Cyrille, Saad, Marouane, Anthony, Ana

et Bertrand. Une mention toute particulière à mes voisins de bureau, indéniablement les

meilleurs, Begaiym, Cindie et Robin-Marie-Camille. Un énorme Big Up à Nora, chef

com’, pour sa bonne humeur et pour les parties de basket endiablées. Je pense aussi

à toutes les personnes que j’ai rencontrées depuis trois ans, notamment Didier, Pascal,

Sébastien, David, Anne-Claire, Alexis, Melissa et Julie.

Pour conclure, je souhaite remercier ma famille et mes amis pour leur soutien. Merci

à mes parents et à mes frangines Anaëlle et Jeanne pour leurs encouragements. Enfin, je

remercie Marie pour son amour. Merci d’avoir accepté de mettre de côté notre vie sociale

pendant les longs mois de la rédaction de ma thèse. Merci de m’avoir toujours soutenu

dans les moments difficiles. Merci pour tout ce que nous avons partagé ensemble ces huit

dernières années et pour ce que nous partagerons ensemble dans le futur.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

84

84

85

85

86

86

87

87

88

88

89

89

90

90

91

91

92

92

93

93

94

94

95

95

96

96

97

97

98

98

99

99

100

100

101

101

102

102

103

103

104

104

105

105

106

106

107

107

108

108

109

109

110

110

111

111

112

112

113

113

114

114

115

115

116

116

117

117

118

118

119

119

120

120

121

121

122

122

123

123

124

124

125

125

126

126

127

127

128

128

129

129

130

130

131

131

132

132

133

133

134

134

135

135

136

136

137

137

138

138

139

139

140

140

141

141

142

142

143

143

144

144

145

145

146

146

147

147

148

148

149

149

150

150

151

151

152

152

153

153

154

154

155

155

156

156

157

157

158

158

159

159

160

160

161

161

162

162

163

163

164

164

165

165

166

166

167

167

168

168

169

169

170

170

171

171

172

172

173

173

174

174

175

175

176

176

177

177

1

/

177

100%

![Expo Recherche Tabou [MOUEDDEN]](http://s1.studylibfr.com/store/data/003583782_1-0458da97a2d3f8ac30f3585bd5693870-300x300.png)