2 Chaînes de Markov

MODÉLISATION ALÉATOIRE

Notes de Cours

ENSIBS 2013/2014

Table des matières

1 Introduction 2

2 Chaînes de Markov 3

2.1 Définition ............................................. 3

2.2 Matrice de transition ...................................... 4

2.3 Classes d’équivalence de l’espace des états ......................... 7

2.4 Nature des états d’une chaîne ................................. 9

2.4.1 Periodicité ......................................... 9

2.4.2 Etats transients - Etats récurrents .......................... 11

2.5 Notion de mesure invariante .................................. 15

2.6 Notion de mesure réversible .................................. 15

2.7 Comportement asymptotique d’une chaîne de Markov .................. 16

2.8 Calcul de la loi stationnaire pour une chaîne à espace d’états fini . . . . . . . . . . . . 17

2.9 Calcul de lois limites ....................................... 18

1

ENSIBS

Cours 1

1 Introduction

On donne ici quelques généralités sur les processus aléatoires. L’étude des processus consiste

à explorer la structure d’un famille de variables aléatoires X(t) à valeurs dans un espace S, où t

est un paramètre parcourant un espace T.

On note indifféremment X(t) ou Xtou {X(t),t∈T}ou encore {Xt,t∈T}.

Test appelé l’espace d’indice ; par abus de langage, on parle de l’espace des temps.

Lorsque Test une ensemble dénombrable (par ex. N), on parle de processus à temps discret.

Si Test un ensemble dense (par ex. R), on parle de processus à temps continu.

La dimension de Tpeut être supérieure à 1. Par exemple, X(t) peut être la hauteur d’une vague

en un point t=(t1,t2) avec t1=longitude et t2=latitude. La dimension de Test donc ici égale à 2.

L’espace Sdans lequel X(t) prend ses valeurs est appelé l’espace des états.

S’il est dénombrable, le processus est dit à espace d’états discrets. S’il est continu, le processus

est dit à espace d’états continu.

Un processus aléatoire est caractérisé par la nature :

•de l’espace des états,

•de l’espace des temps,

•de la relation de dépendance entre les Xt.

Une suite de réalisations de la v.a. X(t) sur un ensemble de valeurs t0,t1,t2,... de l’espace des

temps est appelée une trajectoire.

Quelques exemples de processus

Processus stationnaire à accroissements indépendants

Un processus stochastique {X(t),t∈T}est dit à accroissements indépendants si les v.a. :

X(t0),X(t1)−X(t0),X(t2)−X(t1),··· ,X(tn)−X(tn−1) sont indépendantes pour toutes suites de

temps t0,t1,t2,··· ,tncroissante.

Si la distribution des accroissements X(t+h)−X(t) ne dépend que de la longueur hde ceux-ci et

non du temps t, on dit que le processus est stationnaire.

Martingales

Définition 1 – On dit que {X(t),t∈T}est une martingale si, E(|X(t)|)< +∞ pour tout tet si pour

tout t1<t2< · · · < tn+1,

E[X(tn+1)|X(tn)=an,X(tn−1)=an−1,··· ,X(t1)=a1]=an,∀a1,···,an.

2

MODÉLISATION ALÉATOIRE

Processus de Markov

Soit {X(t),t∈T}un processus aléatoire. Si pour tout t>s, la valeur de X(t) sachant X(s), ne

dépend pas des Xu,u<t, le processus est un processus de Markov. Ainsi le comportement

futur du processus alors que l’on connaît son état présent, ne dépend pas des états qu’il a visités

précedemment.

On dira donc qu’un processus est de Markov ou Markovien, si pour tout t1<t2<...<tn<t:

Pr(a<X(t)≤b|X(t1)=x1,...,X(tn)=xn)=Pr(a<X(t)≤b|X(tn)=xn).

L’étude des processus de Markov passe par l’étude des probabilités suivantes :

P(X(t)∈A|X(s)=x),t>s,A⊂R,

i.e. l’étude des probabilités que le processus étant en xà la date ssoit dans Aà la date t. Il

s’agit des probabilités de transition. Elles décrivent les mouvements de la chaîne. Lorsque le

processus de Markov est à espace d’états discrets, on l’appelle chaîne de Markov.

Si l’espace des états est continu, le processus de Markov est appelé diffusion.

Nous allons étudier essentiellement dans la suite, des processus à temps discrets et à valeurs sur

un espace d’états discret : les chaînes de Markov. Puis, nous considèrerons ces mêmes processus

dans le cas temps continu.

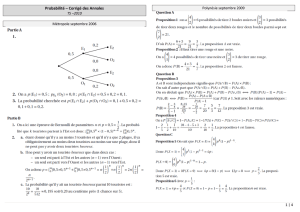

2 Chaînes de Markov

2.1 Définition

Définition 2 – On appelle chaîne de Markov à temps discrets {Xn,n∈N}, tout processus aléatoire

à valeurs dans un espace d’états dénombrable et tel que :

P(Xn=xn|Xn−1=xn−1,...,X0=x0)=P(Xn=xn|Xn−1=xn−1),

pour tout xn,xn−1,...,x0de l’espace des états.

On a noté Xnpour X(n).

L’événement {Xn=i}signifie la chaîne est dans l’état ià l’instant n.

Par définition, l’état dans lequel se trouve la chaîne à un instant donné, ne dépend que de sa po-

sition au tout dernier instant et non de toute la trajectoire (l’histoire) du processus (suite entière,

complète, des états occupés précédant le dernier état occupé).

La chaîne sera caractérisée par les probabilités de passage d’un état vers un autre qu’on appelle

probabilités de transition.

On s’intéresse donc à la probabilité que la chaîne soit à l’état jà l’instant msachant qu’elle était

3

ENSIBS

à l’état ià l’instant n.

On note : pn,m

i,jcette probabilité.

pn,m

i,j=P(Xm=j|Xn=i),m>n.

Pour passer de ien j, la chaîne effectue un certain nombre de mouvements, des pas ou encore

des transitions.

La probabilité de transition en un pas de ivers js’écrit : pn,n+1

i j et si cette probabilité ne dépend

pas de n, on dit que la chaîne est stationnaire ou encore homogène.

2.2 Matrice de transition

Les probabilités de transition d’un état vers un autre en un mouvement – notée : pi,j– peuvent

être organisées en une matrice carrée éventuellement de dimension infinie que l’on appelle ma-

trice de transition ou matrice de Markov et que l’on note en général P.

P=

p0,0p0,1p0,2···

p1,0p1,1p1,2···

p2,0p2,1p2,2···

.

.

..

.

..

.

.

pi,0pi,1pi,2···

.

.

..

.

..

.

.

Si le nombre d’états possibles de la chaîne est fini, la dimension de la matrice est ce nombre d’états.

Les quantités pi,j, probabilité de transition de l’état ivers l’état jen une transition satisfont les

conditions :

pi,j≥0, pour tout i,j∈{0,1,2,...},

+∞

X

j=0

pi,j=1,i=0,1,2,..., la somme des termes en ligne vaut 1.

Une chaîne de Markov sera donc entièrement définie par la donnée de la matrice de transition et

par sa position (son état) à l’instant initial.

Si l’état initial et la matrice de transition Psont connus, on peut décrire les trajectoires possibles

de la chaîne. On note maintenant p(n)

i,jla probabilité que la chaîne se déplace de l’état ià l’état j

en ntransitions.

On adopte la convention suivante :

p(0)

i,j=

0 pour i6= j

1 pour i=j

Si la chaîne est homogène :

p(n)

i,j=P(Xm+n=j|Xm=i) (ne dépend pas de m).

4

MODÉLISATION ALÉATOIRE

On peut énoncer le théorème suivant :

Théorème 1 – On considère une chaîne de Markov sur un espace d’états inclus dans N, de matrice

de transition Pde termes pi,j.

Alors :

p(n)

i,j=

+∞

X

k=0

p(r)

i,kp(s)

k,j,(1)

quelque soit les entiers ret stels que n=r+s.

L’équation (1) est appelée équation de Chapman–Kolmogorov.

Preuve : Par définition de la probabilité conditionnelle :

p(n)

i,j=P(Xm+n=j|Xm=i)=P(Xm+n=j,Xm=i)/P(Xm=i).

Supposons n=r+set appliquons le théorème des probabilités totales en considérant l’état de la

chaîne à l’instant m+ret en introduisant un état intermédiaire k.

Il vient :

P(Xm+n=j,Xm=i)=X

k∈N

P(Xm+r+s=j,Xm+r=k,Xm=i)

=X

k∈N

P(Xm+r+s=j|Xm+r=k,Xm=i)P(Xm+r=k,Xm=i)

=X

k∈N

P(Xm+r+s=j|Xm+r=k)P(Xm+r=k|Xm=i)P(Xm=i)

=X

k∈N

p(s)

k,jp(r)

i,kP(Xm=i)

Ce qui démontre le résultat.

Notons P(n)la matrice dont les éléments sont les probabilités de transition de ivers jen n

transitions c’est-à-dire les termes p(n)

i,j.

D’après le théorème :

p(n)

i,j=

+∞

X

k=0

p(n−1)

i,kpk,j.

Cette quantité s’interprète comme le produit de la ligne ide la matrice matrice P(n−1) avec

la colonne jde la matrice P. C’est donc le résultat d’un produit matriciel classique et on a :

P(n)=P(n−1)P. Il vient alors par récurrence : P(n)=P(n−2)P2=P(n−3)P3=... =P(0)Pn=Pn

puisque P(0) =I, la matrice identité. Les probabilités de transition d’un état vers un autre en

nmouvements sont donc simplement obtenues en élevant la matrice Pà la puissance n. D’une

manière générale, le théorème nous permet donc d’écrire : Pn=Ps·Pr.

Cours 2

Supposons que l’on dispose de la distribution initiale des états c’est-à-dire des probabilités

5

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

1

/

20

100%