Modèles de Markov

Maitrise d’informatique - Bioinformatique

Cours 4

Mod`eles de Markov

H´el`ene Touzet

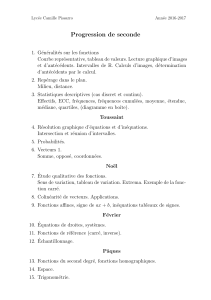

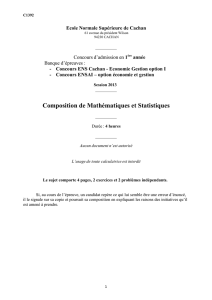

Le casino malhonnˆete

1 d´e normal : probabilit´e de 1/6 par chiffre

1 d´e pip´e : le 6 a une probabilit´e de 0.5 et

les autres faces de 0.1

passage du d´e normal au d´e pip´e :

probabilit´e 0.05

passage du d´e pip´e au d´e normal :

probabilit´e 0.1

Probl`eme

`

A partir de l’observation d’une partie, trouver

les endroits o`u le jeu se fait avec le d´e pip´e.

2

R´egions hydrophobes dans les

prot´eines

zones caract´eris´ees par un fort biais de

composition :

hydrophobe →Ile, Leu, Val, Phe

pi, fr´equence d’apparition de chaque acide

amin´e dans une zone

hydrophobe

qi, fr´equence d’apparition de chaque acide

amin´e dans une prot´eine

m, longueur moyenne d’une r´egion non

hydrophobe

n, longueur moyenne d’une r´egion hydrophobe

Probl`eme

Trouver les r´egions hydrophobes dans une s´equence

prot´eique

3

normal

dé

pipé

dé 0,9

0,95

0,050,1

1

2

3

4

5

6

1

2

3

4

5

6

1/6

1/6

1/6

1/6

1/6

0,1

0,1

0,1

0,1

0,1

0,5

1/6

4

Processus markovien

(ou chaˆıne markovienne)

Les ´ev´enements ne sont pas ind´ependants.

L’´ev´enement en i+ 1 d´epend de celui en i,

et uniquement de celui-ci.

m´emoire limit´ee

Un mod`ele de Markov est donc d´etermin´e par

un ensemble fini d’´etats π0, . . . , πl

un ensemble de probabilit´es de transition

akl =P(πi+1 =l/πi=k)

Probabilit´e d’acc`eder `a l’´etat lalors que l’on est dans

l’´etat k

5

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

1

/

28

100%