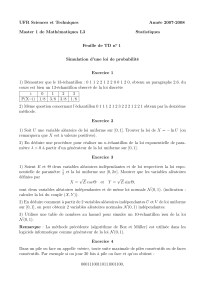

Indépendance d`événements et de variables aléatoires

(Ω,F,P)

A B

P(A∩B) = P(A)P(B).

(Ai)i∈IF

∀J⊂I, J , P\

i∈J

Ai=Y

i∈J

P(Ai).

A, B P(B)>0

PB(A) := P(A|B) = P(A∩B)

P(B).

A B

PB:F → [0,1]

A7→ PB(A)

A B P(B)>0

A B ⇐⇒ PB(A) = P(A).

Ω = [0,1] P=λ

An:= [

16l62n−12(k−1)

2n,2k−1

2n

n∈N

A B A BcAc

B AcBc

(Ai)i∈I

(Bi)i∈I

Bi=AiBi=Ac

i

(Bi)i∈I

n

ϕ(n) = nY

p|n,p∈P 1−1

p

P

(An)n

PnP(An)<∞P(lim supnAn) = 0

PnP(An) = ∞(An)nP(lim supnAn) = 1

{lim sup An}={Ani.s.} ♦

P( ) = p∈]0,1[

An:= {n}lim sup

n

An:= { }.

P( ) = 1.

Z{Zi}iZ0= 0 i > 0

(Zi+1 =Zi+ 1 p

Zi+1 =Zi−1q= 1 −p

p6=1

2An:= {2n}

P(An) = 2n

npn(1 −p)n∼(4p(1 −p))n

√πn 6am

C

a < 1 0

{Zi}i

(Ai)i∈IP

∀J⊂I, J , ∀Ai∈ Ai,P\

j∈J

Aj=Y

j∈J

P(Aj).

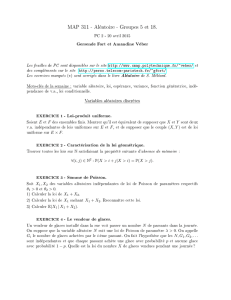

(Xi)i∈I

Xi: (Ω,F,P)→(Ei,Ei)

(Xi)i∈I(σ(Xi))i∈I

X, Y

X Y

∀A∈ E,∀B∈ F,P(X∈A, Y ∈B) = P(X∈A)P(Y∈B)

C D E F

P(X∈A, Y ∈B) = P(X∈A)P(Y∈B)∀(A, B)∈ C × D.

∀f: (E, E)→(R,B(R)) ∀g: (F, F)→(R,B(R))

E(f(X)g(Y)) = E(f(X))E(g(Y)).

∀f: (E, E)→(R,B(R)) ∀g: (F, F)→(R,B(R)) f(X)g(Y)

Rd

(X1, X2, . . . , Xd)P(X1,...,Xd)

(Rd,B(Rd)) PX1⊗ ··· ⊗ PXd

(X1, X2, . . . , Xd)Rr1, . . . , Rrd

∀(t1, . . . , td)∈Rr1× ··· × Rrd, ϕ(X1,...,Xd)(t1, . . . , td) = ϕX1(t1)···ϕXd(td)

r1=··· =rd= 1

F(X1,...,Xd)(t1, . . . , td) = FX1(t1)···FXd(td)

ϕXiFXiXi

U V

[0,1] X=√−2 log Vcos(2πU)Y=√−2 log Vsin(2πU)

{Xn}nF

RnXnRn:= Pn

j=1 {Xj>Xn}{Rn}n

P(Rn=k) = 1

n∀k∈ {1,2, . . . , n}.

(Ω,F,P){Ti}i∈N

Cn=σ[

p>n

TpC∞=\

n∈NCn.

C∞

{Xi}i∈N

Xi: (Ω,F)→(Ei,Ei)

Ti=σ(Xi) := {X−1

i(A) : A∈ Ei} F

{Xn}n

{Xn}n

{Xn}nn→ ∞

A:= {ω∈Ω : limnXn(ω)} ∈ C∞

♦

{Ti}i∈NC∞

A∈ C∞

P(A)∈ {0,1}.

C∞

A:= {Ani.s.}∈A∞An=σ(An) = {∅, An, Ac

n,Ω} {An}n

P(A)∈ {0,1}

{An}nP(lim sup An) = 0 PnP(An)<∞

X, Y

PX+Y=PX? P YϕX+Y=ϕX·ϕY

{Xn}nN(m, σ2)X∼ N(m, σ2/n)S2

n∼χ2(n)X⊥S2

n

X Y L2X+Y⊥X−Y X Y

{Xn}nSn:= Pn

i=1 Xi

X1

Sn

n

P

−−−−→

n→∞

E(X).

X

Sn

n

p.s.

−−−−→

n→∞

E(X).

[0,1] 0 1

f:Rd→Rd>1

I=Z1

0···Z1

0

f(t1, . . . , tn)d(t1, . . . , tn).

X= (X1,··· , Xn) [0,1]dI=E[f(X1,··· , Xn)]

1

N

N

X

i=1

f(X(ωi)) p.s.

−−−−→

N→∞ I.

X2m:= E(X)

σ2= Var(X)

Sn−nm

σ√n

L

−−−−→

n→∞ N(0,1).

limn→∞ e−nPn

k=0

nk

k!=1

2

P

{Zn:n∈N}N(pij )

pij =P(Zn+1 =j|Zn=i) = p∗i

j, i >1

δ0j, i = 0 j>0

p∗i

j:= P(Pi

k=0 Yk=j){Yk}kP

1

/

4

100%