Combien les nombres entiers ont-ils de facteurs

Combien les nombres entiers ont-ils de facteurs premiers ?

Denis CHOIMET

Université de Brest

Jeudi 4 mai 2017

Table des matières

1 Introduction 1

2 Le théorème de Hardy-Ramanujan 4

2.1 Probabilités sur un ensemble fini . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4

2.2 Heuristiqueduthéorème................................... 4

2.3 Lethéorème.......................................... 5

3 La méthode des moments 7

3.1 Rappels sur la convergence en loi . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 7

3.2 Convergence en loi et moments . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 8

3.3 Lois de probabilité caractérisées par leurs moments . . . . . . . . . . . . . . . . . . . . 9

3.4 Lethéorèmefondamental .................................. 11

4 Le théorème d’Erdös-Kac 12

4.1 Un théorème central limite non équidistribué . . . . . . . . . . . . . . . . . . . . . . . 12

4.2 Lethéorème.......................................... 13

4.2.1 Étape1 ........................................ 15

4.2.2 Étape2 ........................................ 16

4.2.3 Étape3 ........................................ 17

Dans toute la suite :

•la notation log désigne le logarithme népérien,

•la lettre pdésigne toujours un nombre premier.

Les paragraphes 1 et 2 de ce texte sont élémentaires, et reprennent en gros le contenu de l’exposé donné

à Brest. Les paragraphes 3 et 4 utilisent nettement plus de matériel en probabilités et en analyse fonc-

tionnelle.

1 Introduction

Dans un article de 1917 ([9]) souvent considéré comme l’acte de naissance de la « théorie probabiliste

des nombres », G. H. Hardy et S. Ramanujan s’intéressent au nombre ω(n)de diviseurs premiers deux

à deux distincts d’un entier n≥2. Ainsi :

ω(26)=1et ω(24·36·52)=3.

On ne tient donc pas compte des multiplicités des facteurs premiers dans cette définition. Il est évident

que la fonction ωprésente de grandes irrégularités : elle vaut 1en toute puissance d’un nombre premier,

tandis que par exemple

ω(p1p2. . . pr) = r

1

si p1, . . . , prsont des nombres premiers deux à deux distincts. Le bon sens nous inciterait donc tout au

plus à espérer des régularités en moyenne de cette fonction. Or, une estimée en moyenne de la fonction

ωn’est pas difficile à obtenir : on écrit

X

n≤x

ω(n) = X

n≤xX

p|n

1 = X

pm≤x

1,

où la dernière somme est indexée par les couples (p, m)formés d’un nombre premier pet d’un entier

m≥1tels que pm ≤x. De là,

X

n≤x

ω(n) = X

p≤xX

p|m≤x

1 = X

p≤xx

p=xX

p≤x

1

p+O(x).

Pour aller plus loin, nous allons utiliser une estimée donnée par Mertens en 1874 (voir [10] p. 351),

non-triviale mais qui reste élémentaire 1:

X

p≤x

1

p= log log x+O(1) (1)

On obtient alors X

n≤x

ω(n) = xlog log x+O(x).(2)

Ainsi, la moyenne de ωsur les entiers ≤xest sensiblement égale à log log x.

Remarque 1. Il est intéressant de regarder ce que devient ce résultat lorsqu’on tient compte des multiplicités. Posons

donc

Ω(n) =

r

X

i=1

αr

si n=Qr

i=1 pαi

i, les piétant premiers et deux à deux distincts et les αides entiers ≥1. Ainsi, Ω(n)est le nombre de

facteurs premier de n, chacun étant compté un nombre de fois égal à sa multiplicité. On a cette fois

X

n≤x

Ω(n) = X

pαm≤x

1 = X

p≤xx

p+x

p2+. . .,

la somme Ppαm≤xétant étendue aux triplets (p, α, m)– où pest premier et α, m ∈N∗– vérifiant pαm≤x. De là,

X

n≤x

Ω(n)≤X

n≤x

ω(n) + X

p≤xx

p2+x

p3+. . .=X

n≤x

ω(n) + xX

p

1

p(p−1) ,

la dernière somme écrite étant finie. On a donc

X

n≤x

Ω(n) = xlog log x+O(x),(3)

ce qui montre que le comportement en moyenne des fonctions ωet Ωest le même. Plus précisément, on a

1

xX

n≤x

(Ω(n)−ω(n)) = O(1),(4)

estimée qui nous sera utile plus loin.

Il n’est pas difficile d’obtenir une majoration simple de ω(n), en utilisant deux fonctions arithmétiques

usuelles ainsi qu’une nouvelle estimée non-triviale, mais élémentaire toujours, de Tchebychev (1850).

Nous poserons

π(x) = X

p≤x

1et θ(x) = X

p≤x

log p.

Ainsi, π(x)est le nombre d’entiers premiers ≤x. L’estimée de Tchebychev peut s’écrire

Ax

log x≤π(x)≤Bx

log x,

où Aet Bsont deux constantes >0. Là encore, nous renvoyons à [10] p. 345 pour la preuve, obtenue

essentiellement en étudiant finement les diviseurs premiers de certains coefficients binomiaux. On en

déduit facilement deux résultats qui vont nous être utiles :

1. On entend par là qu’elle n’utilise pas de méthodes de variable complexe.

2

(i) log pn∼log nquand n→+∞, où pndésigne le n-ième nombre premier,

(ii) limx→+∞π(x)

θ(x) log x= 1.

Remarque 2. L’estimée de Tchebychev est précisée par le fameux Théorème des Nombres Premiers

de Hadamard et de la Vallée Poussin, selon lesquel π(x)∼x

log xquand x→+∞. L’énoncé (ii)dit que

ce théorème s’exprime aussi sous la forme θ(x)∼x.

Démonstration. Tout d’abord, l’estimée de Chebychev donne log x∼log π(x), d’où log pn∼log π(pn) = log n. Ensuite,

on a bien sûr θ(x)≤π(x) log xd’où

lim

x→+∞

θ(x)

π(x) log x≤1.

En sens inverse, fixons α∈]0,1[. On a

θ(x)≥X

xα<p≤x

log p≥αlog xX

xα<p≤x

1 = αlog x(π(x)−π(xα))

d’où θ(x)

π(x) log x≥α1−π(xα)

π(x)

et donc, grâce à l’estimée de Tchebychev :

lim

x→+∞

θ(x)

π(x) log x≥α.

En faisant tendre αvers 1, on obtient

1≤lim

x→+∞

θ(x)

π(x) log x≤lim

x→+∞

θ(x)

π(x) log x≤1,

d’où le résultat.

Revenons à la fonction ω. Nous noterons (pn)n≥1la suite strictement croissante des nombres premiers.

Le cas où ω(n)est aussi grand que possible devant nest celui où n=p1. . . pr(on considère ici n

comme fonction de r). On a alors

log n=

r

X

i=1

log pi=θ(pr)(ii)

∼π(pr) log pr=rlog pr

(i)

∼rlog r.

On en déduit que log log n∼log r, d’où finalement, pour les ncomme ci-dessus 2:

ω(n) = r∼log n

log log n.

Ainsi, l’ordre de grandeur « maximal » de ω(n)est log n

log log n.

On va voir dans la suite (paragraphe 2) que ces deux résultats (comportement en moyenne et borne

supérieure) sont très loin d’épuiser la question : ce qu’on découvert Hardy et Ramanujan, c’est que ω(n)

est génériquement beaucoup plus petit que cette borne : non pas de l’ordre de log n

log log n, mais plutôt de

l’ordre de log log n(pour n= 1080,log n

log log n'35 et log log n'5!). Le paragraphe 4 étudie ensuite les

« fluctuations » par rapport à la moyenne de ω(n), et établit un remarquable théorème central limite

dû à Erdös et Kac, dans un contexte de variables aléatoires dépendantes. Auparavant, on aura fait

(paragraphe 3) tous les rappels nécessaires sur la notion de convergence en loi, et présenté la méthode

des moments qui est l’ingrédient essentiel de la preuve du théorème d’Erdös-Kac.

2. Dans le cas général, si n=Qr

i=1 pαi

iet N=p1· · · pr, on a

ω(n) = ω(N)≤Clog N

log log N≤Clog n

log log npour nassez grand.

3

2 Le théorème de Hardy-Ramanujan

2.1 Probabilités sur un ensemble fini

Nous n’aurons besoin ici que de notions très élémentaires de probabilités. Fixons un entier n≥1.

L’intervalle d’entiers [[1, n]] sera noté Ωndans la suite. À toute partie Ade Ωn, on associe le réel

Pn(A) = |A|

n.

L’application Pn:P(Ωn)→[0,1] ainsi définie s’appelle la probabilité uniforme sur Ωn. Elle possède les

propriétés suivantes :

(i)Pn(∅) = 0 et Pn(Ωn)=1,

(ii)A∩B=∅⇒Pn(A∪B) = Pn(A) + Pn(B).

Une variable aléatoire définie sur Ωnest simplement une application X: Ωn→R. On lui associe deux

grandeurs :

•son espérance, définie par

En(X) = 1

n

n

X

i=1

X(i) = X

x

xPn(X=x),

la somme étant étendue à l’ensemble (fini) des valeurs de X,

•sa variance, définie par

Vn(X) = E(X−En(X))2=En(X2)−En(X)2.

Nous aurons besoin d’une inégalité fondamentale, due à Bienaymé et Tchebychev, qui exprime de façon

quantitative que la variance donne une information sur la dispersion d’une variable aléatoire autour

de son espérance :

Pn(|X−En(X)| ≥ ε)≤Vn(X)

ε2.

En particulier, si Cest une constante strictement positive,

Pn(|X−En(X)| ≥ CVn(X)1/2)≤C−2.

Par exemple, en prenant C= 10, l’inégalité de Bienaymé-Tchebychev dit que Xse trouvera avec

probabilité ≥99% dans l’intervalle hEn(X)−10σn(X),En(X) + 10σn(X)i, où σn(X) := Vn(X)1/2

s’appelle l’écart-type de X.

2.2 Heuristique du théorème

À tout nombre premier p, on associe la fonction indicatrice des multiples de p, définie par

δp:N∗→ {0,1}, n 7→ 1si p|n

0sinon.

On a alors

ω(n) = X

p≤n

δp(n)

la somme étant étendue à l’ensemble des nombres premiers inférieurs ou égaux à n.

Restreinte à l’ensemble Ωn, la fonction δpest une variable aléatoire de Bernoulli, de paramètre

Pn(δp= 1) = 1

nCardni∈Ωn/p|io=1

nn

p.

Si nest grand, on a donc Pn(δp= 1) '1

p, de sorte que la restriction de δpàΩnsuit « presque » la loi

de Bernoulli de paramètre 1

p. Par ailleurs, si on se donne des nombres premiers deux à deux distincts

4

p1, . . . , pr, un entier est divisible par tous les pisi et seulement s’il est divisible par leur produit. Par

conséquent, si nest grand, on a

Pn(δp1= 1, . . . , δpr= 1) = 1

nCardni∈Ωn/p1. . . pr|io

=1

nn

p1. . . pr'1

p1. . . pr

'Pn(δp1= 1) ···Pn(δpr= 1).

Ainsi, les δpinduisent des variables aléatoires sur Ωnqui sont, lorsque nest grand, « approximativement

indépendantes ». De là, l’idée de « tricher » et de considérer, en oubliant momentanément les δp, une

suite (Xp)de variables aléatoires indexée par les nombres premiers, définies sur un même espace

probabilisé (Ω,A,P), indépendantes, et telles que Xpsuive la loi de Bernoulli de paramètre 1

p. En

posant

Sn=X

p≤n

Xp,

on définit une variable aléatoire qui a des chances de se comporter, du point de vue probabiliste, comme

ωsur Ωn. L’espérance de Snvaut en:= Pp≤n1

pet sa variance 3vn:= Pp≤n1

p1−1

p, toutes deux

équivalentes à log log nquand n→+∞en vertu de l’estimée (1) de Mertens. D’après l’inégalité de

Bienaymé-Tchebychev, on aura

Sn= log log n+θn(log log n)1/2,

où θnest une variable aléatoire qui sera, avec forte probabilité, « pas trop grande ».

2.3 Le théorème

Théorème 1 (Hardy-Ramanujan).Pour toute suite (γn)de réels strictement positifs tendant vers

+∞, on a

Pn|ω−log log n| ≥ γn(log log n)1/2→0quand n→+∞,

c’est-à-dire

1

nCard ni∈Ωn.|ω(i)−log log n| ≥ γn(log log n)1/2o→0quand n→+∞,

Remarque 3. Le théorème de Hardy-Ramanujan reste valable si on remplace ωpar la fonction Ωdéfinie à la remarque

1, et qui compte le nombre de diviseurs premiers comptés avec multiplicité d’un entier. En effet, on a par l’inégalité de

Markov et (4) :

Pn(|Ω−ω| ≥ γn(log log n)1/2)≤En(|Ω−ω|)

γn(log log n)1/2=O1

γn(log log n)1/2→0,

d’où

Pn|Ω−log log n| ≥ γn(log log n)1/2≤Pn|ω−log log n| ≥ γn

2(log log n)1/2+Pn|Ω−ω| ≥ γn

2(log log n)1/2→0.

Le théorème de Hardy-Ramanujan implique en particulier que, pour tout ε > 0,

Pn

ω

log log n−1≥ε→0,

autrement dit que ω

log log nconverge vers 1en probabilité. Nous sommes donc en présence d’une loi

faible des grands nombres. La preuve que nous allons donner du théorème n’est pas celle de [9], mais

celle, beaucoup plus simple, donnée par P. Turán en 1934 ([14]).

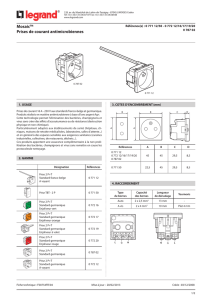

Sur la figure suivante, on a représenté la fonction ωainsi qu’une bande de largeur (log log n)1/2(« l’écart-

type ») autour de sa « moyenne » log log n.

3. Rappelons que la variance est additive sur les variables aléatoires indépendantes.

5

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

1

/

18

100%