Théorie de l`information

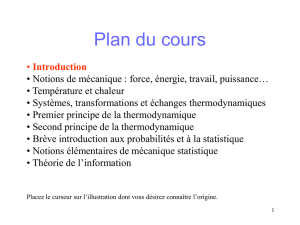

Introduction

Introduction

à la théorie de l’information

à la théorie de l’information

David Rousseau

David Rousseau

Doctorant première année au LISA

Doctorant première année au LISA

Pr Ag

Pr Ag de Physique à l’Université d’Angers

de Physique à l’Université d’Angers

Organisation de l’exposé

Organisation de l’exposé

Cadre et historique de la théorie de l’information

Les principaux outils

Les théorèmes fondamentaux

Exemples d’applications en relation avec les activité du LISA

Comment est née

Comment est née

la théorie de l’information ?

la théorie de l’information ?

•A l’origine une réflexion sur les techniques de

communication.

•Claude Shannon pose en 1948 les fondements

mathématiques des communications numériques.

A quoi sert la théorie de

A quoi sert la théorie de

l’information

l’information ?

Vous disposez d ’une source de données.

• Quelle est la quantité d ’information et de redondance ?

• Quel est le taux de compression maximal sans pertes d’information ?

• Quelle est la complexité de ces données ?

Vos données traversent un système où règnent des perturbations

• Quel est l’effet des perturbations sur l’information ?

• Quel est le taux de transmission maximal sans pertes d ’information ?

Paradigme de Shannon

Paradigme de Shannon

Source

Source Destinataire

Destinataire

Canal

Canal

Perturbations

Perturbations

message

message

Exemples illustrant le paradigme :

• cas d’une source analogique : la parole

• cas d’une source numérique : l ’écriture

• cas d’une séparation temporelle : lecture d ’un CD gravé

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

1

/

27

100%