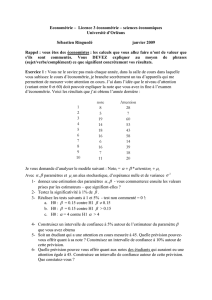

Corrigé

X

(Pθ)θ∈I

θ

θ n (X1, ..., Xn)

X

Tn=f(X1, ..., Xn)θ Tn

θ

p B

Tn=

n

P

i=1

Xi

n

n

xi

t20 =

8

20

=

2

5

X

(Xn)

Xn+1 Xn

Xn=i Xn+1 {i−1; i+ 1}

n+∞

0,27

θ

e−θ

U100 e−θ

T100 T100 e−θU100

T100

T100 U100 T100

U100

20

X X 20

1/4

X=i Y 20 −i

20 −i1/4

θ0,435

Tn

θ n (Tn)n

+∞

(Tn)

(Tn) 7/16 θ= 7/16

X →B(p)p

(X1, ..., Xn)n X

[Xn−1

√n;Xn+1

√n]p95%

p p

Xnp∈[Xn−1

√n;Xn+1

√n]

p

p= 0.2n= 1000

p∈[Xn−1

√n;Xn+1

√n]

P(p∈[Xn−1

√n;Xn+1

√n]) '0,97

P(p∈[Xn−1

√n;Xn+1

√n]) ≥0,95

95%

6

6

1

/

6

100%

![1 Estimateurs (inspirés de [1]) 2 Estimateurs du maximum de](http://s1.studylibfr.com/store/data/000902399_1-b3fad4126456d0451d3a3a71ba072ca5-300x300.png)