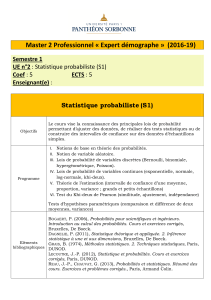

L`essentiel des probabilités

Le formidable développement des outils informatiques et de leur puissance de calcul permet de

traiter de très grands nombres de données, d’obtenir rapidement des résultats et des inter-

prétations et il est peu de domaines aujourd’hui qui ne fassent appel aux statistiques comme sources

d’informations. Que l’on s’intéresse à la physique, fondamentale ou appliquée, que l’on travaille

dans la finance, le commerce, l’assurance, la biologie, dans le monde de la recherche comme dans

celui de l’entreprise, les données sont relevées, analysées, et exploitées.

La première tâche de la statistique consiste à décrire de façon précise et rigoureuse les ensembles

qu’elle étudie sous l’angle particulier qui l’intéresse mais la tâche ne s’arrête pas là. Au-delà des

observations qu’elle peut effectuer, la statistique cherche à construire des modèles, à élaborer

des hypothèses plus ou moins probables concernant certains événements échappant à son

observation directe ; soit parce que ces événements concernent des ensembles plus vastes que ceux

qui ont été observés, soit qu’il s’agisse d’événements à venir.

Cette deuxième phase de l’étude statistique, appelée statistique inductive ou statistique inférentielle

part des résultats obtenus sur les échantillons observés et, connaissant les différents modèles déve-

loppés par la théorie des probabilités, permet d’élaborer des hypothèses valables avec de fortes

probabilités portant sur la population alors même que celle-ci n’aura pas été observée de façon

exhaustive.

Cet ouvrage reprend les bases de la théorie des probabilités et les lois de probabilités per-

mettant la modélisation de situations concrètes. Les méthodes de la statistique inférentielle

sont étudiées dans un deuxième ouvrage avec, d’une part, la résolution de problèmes d’estimations

de paramètres et, d’autre part, avec des problèmes portant sur le contrôle des normes à partir de

l’observation d’échantillons ou enfin le contrôle de la validité des modèles formulés.

PRÉSENTATION

Chapitre 1 -Éléments de probabilités 9

1 - Vocabulaire 9

2 - Algèbre des événements 10

3 - Probabilités 12

■Axiomes de définition 12

■Règles de calcul 13

■Théorèmes des probabilités 13

a) Théorème des probabilités totales 13

b) Théorème des probabilités composées. Probabilités conditionnelles 16

4 - Outils d’aide à la résolution de problèmes avec conditionnement 22

■L’arbre de probabilité 22

■Le tableau de contingence 24

Chapitre 2 -Variables aléatoires et loi de probabilités 33

1 - Variable aléatoire 33

2 - Processus aléatoire 34

3 - Loi de probabilité : fonction de distribution et fonction de répartition 34

■Le cas d’une variable discrète 34

a) Fonction de distribution 34

b) Fonction de répartition d’une variable discrète 36

■Le cas des variables aléatoires continues 37

a) Densité de probabilité, fonction de distribution 38

SOMMAIRE

SOMMAIRE

b) La fonction de répartition 38

4 - Caractéristiques d’une variable aléatoire 42

■L’espérance mathématique E (X) 42

a) Dans le cas discret 43

b) Dans le cas continu 43

■Variance et écart-type 43

a) Dans le cas discret 43

b) Dans le cas continu 43

5 - Propriétés de l’espérance et de l’écart-type d’une variable aléatoire 47

■Changement de variable affine 47

■Somme et différence de variables aléatoires indépendantes 47

Chapitre 3 - Quelques lois de probabilités théoriques

discrètes 57

1 - La loi uniforme 57

2 - Le processus de Bernoulli 58

■La loi de Bernoulli ou loi de l’alternative 58

a) Définition 59

b) Les caractéristiques de la variable de Bernoulli. 59

■La loi binomiale 59

a) Définition 59

b) Les caractéristiques d’une variable binomiale 60

c) Somme de variables aléatoires suivant une loi binomiale 60

■La loi géométrique 63

a) Définition 63

b) Les caractéristiques d’une variable géométrique 63

3 - Le processus de Poisson 64

■La loi de Poisson 65

a) Définition 65

b) Les caractéristiques d’une variable de Poisson 66

■Approximation d’une loi binomiale par une loi de Poisson 69

SOMMAIRE

Chapitre 4 -Quelques lois de probabilités continues 79

1 - La loi exponentielle 79

■Fonction de distribution et fonction de répartition 79

■Les caractéristiques d’une variable exponentielle 80

■La loi sans mémoire 81

2 - La loi normale ou loi de Laplace Gauss 82

■La densité de probabilité 83

■Les caractéristiques d’une variable normale 83

■La courbe densité de la loi normale 83

■La variable normale centrée réduite 84

■Caractéristiques de la variable normale centrée réduite 84

■Fonction de répartition de la variable normale centrée réduite U 85

■Calculs de probabilités 85

a) Calcul de la probabilité, connaissant la borne 86

On peut suivre les étapes suivantes : 86

b) Calcul de la borne, connaissant la probabilité 90

c) Calcul des bornes d’un intervalle centré autour de la moyenne,

connaissant sa probabilité 91

■Intervalles caractéristiques 92

■Fonction affine d’une variable normale 92

■Somme et différence de variables aléatoires normales indépendantes 92

■Approximation des lois de Poisson et binomiale par une loi normale 97

a) Approximation de la loi binomiale par une loi normale 97

b) Approximation d’une loi de Poisson par une loi normale 97

c) La correction de continuité 97

3 - La loi du khi-deux 99

■Définition 99

■La courbe densité de la loi du khi-deux 100

■Les caractéristiques d’une variable du khi-deux 100

■Somme de deux variables du khi-deux indépendantes 101

■Approximation de la loi du khi deux par une loi normale 101

4 - La loi de Student 102

6

6

1

/

6

100%