Aide Mémoire de Probabilité

Aide Mémoire de Probabilité

1 Probabilités ensemblistes

•Ωensemble des résultats possibles

• A tribu : stable par union et stable par complémentaire

–si Ωdénombrable alors A=P(Ω) ensemble des parties de Ω

–si Ωnon dénombrable ⊂Rkalors A=B(Rk)tribu de Borel de Rk

•Pfonction probabilité : P:A → [0,1]

A7→ P(A)

•(Ω,A,P)espace de probabilité

•Probabilité uniforme (cas fini) : P:P(Ω) →[0,1]

A7→ P(A) = Card(A)

Card(Ω)

•Axiomatique de Kolmogorov :

1. P(Ω) = 1

2. P(∪i∈IAi) = Pi∈IP(Ai)si les Aisont disjoints deux à deux.

en particulier P(A∪B) = P(A) + P(B)si Aet Bsont disjoints

⇒raisonnement sur les ensembles disjoints (notamment partition) puis pas-

sage aux probabilités

•Dénombrement :

–Nombre d’arrangements de kéléments parmi N

∗Ak

N= (N)k=N!

(N−k)! =N×(N−1) ×... ×(N−k+ 1)

∗tous différents = sans remise

∗ordre est important

∗ex: tiercé

–Nombre de combinaisons de kéléments parmi N

∗Ck

N=N

k=Ak

N

k!=N!

k!(N−k)!

∗tous différents = sans remise

∗ordre n’est pas important

∗ex: loto

–Nombre de permutations de kéléments : n! = Ak

k

1

•Reconnaître le modèle avec ou sans remise

–Modèle avec remise (multi-nominal)

∗Ω = {suites ordonnées de kboules parmi Navec répétition (avec

remise)}={(x1, ..., xk)∈ {1, ..., N}k}

∗Card(Ω) = Nk

∗La probabilité à chaque tirage/lancé est toujours la même entre les N

possibilités : pi,∀i∈N

∗ex1: klancées d’une pièce truquée N= 2 avec p1=pet p2= 1 −p

⇒loi Binomial de paramètres ket p.

∗ex2 : klancées de dés de Nfaces avec p=1

Nsi équilibré

–Modèle sans remise = tous différents

∗Ω = {suites ordonnées de kboules parmi Nsans répétition (tous

différents)}={(x1, ..., xk)∈ {1, ..., N}k| ∀i6=j, xi6=xj}

∗Card(Ω) = Ak

N

∗La probabilité change à chaque tirage/lancé étant donné qu’il n’y a pas

de remise =⇒modèle plus complexe.

∗ex: tirer kcartes sans remise dans un jeu de Ncartes; sélectionner k

étudiants dans une promo de N

∗ex: N= 2 : loi hypergéométrique

∗Si Nest très grand : modèle sans remise = modèle avec remise (la non

remise ne modifie quasiment pas la probabilité)

La définition de Ωest un point critique des problèmes :

•Souvent considérer un ordre dans les tirages, les lancées alors qu’il n’en existe

pas forcément et ensuite considérer les différents cas (permutations,....).

•Souvent ne pas considérer la couleur des boules ou d’autres caractéristiques dans

Ωet les considérer toutes distinctes (même si elles ont la même couleur) pour

obtenir une loi de probabilité uniforme : P(A) = Card(A)

Card(Ω) . Dans un second

temps, on dénombre les combinaisons, arrangements ou permutations.

2 Probabilités conditionnelles

•P(A|B) = P(A∩B)

P(B)

⇒P(A|B)P(B) = P(B|A)P(A)

•Probabilités totales : si Bipartition de Ω

P(A) = X

i∈I

P(A|Bi)P(Bi)

=X

i∈I

P(A∩Bi)

•Aet Bsont indépendants ⇐⇒ P(A∩B) = P(A)×P(B)

P(B)6=0

⇐⇒ P(A|B) = P(A)

•(Ai)i∈Imutuellement indépendants ⇐⇒ ∀J⊂I,P(∩i∈JAi) = Qi∈JP(Ai)

•mutuellement indépendants =⇒deux à deux indépendants (réciproque fausse)

2

3 Variables aléatoires réelles

Ajout d’une notion d’ordre (d’une mesure) dans Ω

X: Ω →R

ω7→ X(ω) = x

(Ω,A,P)avec X=⇒(R,B(R),PX)

4 façon différentes et équivalentes de définir une variable aléatoire réelle X:

1. Fonction densité de X

•discret : n’admet pas de densité.

On définit la loi en donnant la valeur de la probabilité en chaque point :

{(xi,P(X=xi))}i∈I

=⇒diagramme en bâtons.

•continu : fX:R→R+

x7→ fX(x)fonction intégrable : ZR

fX(x)dx = 1

•Support de la loi de X: ensemble des valeurs de Rsur lesquelles fXest

non nulle : DX=Supp(X) = {x∈R, fX(x)>0}.

On note 1DX(x)=1si x∈ DXet = 0 sinon, la fonction support.

•on note : X∈ DXpresque sûrement (p.s.) ou presque partout (p.p.) si

P(X∈ DX)=1.

2. Fonction de répartition de X:FX:R→[0,1]

x7→ FX(x) = PX(] − ∞;x]) = P(X6x)

•discret : FX(x) = X

xi6x

P(X=xi).

•continu : FX(x) = Zx

−∞

fX(x)dx =Zx

−∞

fX(x)1DX(x)dx =Z]−∞,x]∩DX

fX(x)dx

c’est l’intégrale de fX, elle est croissante.

⇒P(a6X6b) = FX(b)−FX(a)

⇒P(X=a)=0,∀a∈R

⇒FX(−∞)=0et FX(+∞)=1

3. Fonction quantile de X:

←−

FX:]0,1[ →R

p7→ ←−

FX(p) = inf{x∈R|FX(x)> p}

c’est grosso-modo l’inverse de la fonction de répartition, F−1

Xquand celle-ci ex-

iste.

=⇒la médiane est la valeur de xtelle que F(x)=1/2.

4. Fonction caractéristique de X:ϕX:R→C

t7→ ϕX(t) = E(eitX )

=⇒ϕ(k)

X(0) = ikE(Xk)

•Espérance de X= moyenne de X; c’est un réel: E(X)∈R

–discret : E(X) = Pi∈IxiP(X=xi)

–continue: E(X) = RRxfX(x)dx

–P(A) = E(1A) =⇒P(X > t) = E(1]t;+∞[)

3

•Linéarité sur les intégrales =⇒linéarité sur les espérance :

–E(aX +b) = aE(X) + b

–E(X+Y) = E(X) + E(Y)

•Changement de variable : Y=g(X)

–E(Y) = ZR

g(x)fX(x)dx

–Si gconvexe alors g(E(X)) 6E(g(X))

–∀y∈R, FY(y) = P(X∈g−1(] − ∞;y]))

–Si gbijective telle que g0(x)6= 0 alors ∀y∈R, fY(y) = |(g−1)0(y)|fX(g−1(y))

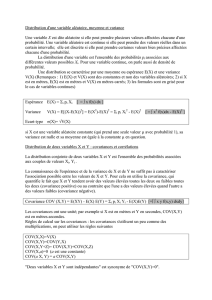

•Variance de X: moyenne de l’écart à la moyenne au carré; c’est un réel positif :

V ar(X)∈R+

V ar(X) = E((X−E(X))2) = E(X2)−(E(X))2=−ϕ00

X(0) + (ϕ0

X(0))2

Si V ar(X)=0alors Xest un variable aléatoire constante.

•Écart type de X:σX=pV ar(X)⇒mêmes unité que les valeurs de X.

•Moment non centré d’ordre pde X:mp=E(Xp) = ϕ(p)

X(0)

ip∈R

•Moment centré d’ordre pde X:µp=E((X−E(X))p)∈R

•Inégalité de Tchebychev : P(|X−E(X)|>a)6V ar(X)

a2

Lois classiques à connaître et reconnaître :

•Lois discrètes :

–Loi Uniforme sur {1, ..., n}

–Loi de Bernoulli de paramètre p∈[0,1] (1 lancé à pile ou face)

–Loi Binomiale de paramètres n∈N∗et p∈]0,1[ (nlancés à pile ou face)

–Loi Géométrique de paramètre p∈]0,1[

–Loi de Poisson de paramètre λ > 0

•Lois continues :

–Loi Uniforme sur l’intervalle [a, b]

–Loi Exponentielle de paramètre λ > 0

–Loi Normale (loi Gaussienne) de paramètres (µ, σ2)

4

4 Vecteurs aléatoires réelles

Simple généralisation des définitions pour dvariables aléatoires réelles.

Notions nouvelles uniquement à propos de la (in)dépendance entre lois : covariance...

X= (X1, ..., Xd) : (Ω,A)→(Rd,B(Rd))

ω7→ X(ω)=(X1(ω), ..., Xd(ω)) loi jointe

Simple généralisation des définitions :

•Probabilité d’un événement :

PX(A) = P(X1,...,Xd)(A1×... ×Ad) = P(X1∈A1, ..., Xd∈Ad)

•Fonction de répartition de X:

FX:Rd→[0,1]

t7→ FX(t) = F(X1,...,Xd)(t1, ..., td) = P(X16t1, ..., Xd6td)

•Fonction de densité de X:

fX:Rd→R+

t7→ fX(t1, ..., td) = ∂d

∂t1...∂td

FX(t1, ..., td)

avec ZRd

fX(t1, ..., td)dt1...dtd=ZDX

fX(t)dt=1

et DXsupport de X.

FX(t1, ..., td) = Zt1

−∞

... Ztd

−∞

fX(t1, ..., td)dt1...dtd

PX(A) = ZA

fX(t)dt=ZA

fX(t)1DXdt=ZA∩DX

fX(t)dt

•Fonction caractéristique de X:

φX:Rd→C

t7→ φX(t1, ..., td) = E(eiht,Xi)

•Espérance de X:E(X)=(E(X1), ..., E(Xd)) ∈Rd

•i-ème loi marginale de X: projection/intégration de Xsur sa i-ème composante :

–fXi(x) = ZRd−1

fX(x1, ..., xi−1, x, xi+1, ...xd)dx1...dxi−1dxi+1...dxd

Dans R2:fX(x) = ZR

f(X,Y )(x, y)dy

–FXi(ti) = FX(+∞, ..., ti, ..., +∞)(écriture non formelle)

–ϕXi(ti) = φX(0, ..., 0, ti,0..., 0)

•Xet Ysont indépendantes ⇐⇒ P(X∈A, Y ∈B) = P(X∈A)×P(Y∈B),∀A, B

continue

⇐⇒ f(X,Y )(x, y) = fX(x)fY(y),∀(x, y)∈R2

discret

⇐⇒ P(X=xi, Y =yi) = P(X=xi)P(Y=yi),∀(xi, yj)

Xet Ysont des v.a.r. indépendantes =⇒

E(XY ) = E(X)E(Y)

V ar(X+Y) = V ar(X) + V ar(Y)

∀t∈R, ϕX+Y(t) = ϕX(t)ϕY(t)

∀t, s ∈R, ϕ(X,Y )(t, s) = ϕX(t)ϕY(s)

=⇒généralisation au vecteur de dimension d.

5

6

6

7

7

8

8

9

9

1

/

9

100%