support au formet powerpoint.

DEA Perception et Traitement de

l’Information

Reconnaissance des formes

Règle de Bayes

S. Canu

http://psichaud.insa-rouen.fr/~scanu/RdF

Buts de la RdF

D: Algorithme

de

Reconnaissance

des Formes

Une forme x

(vecteur forme

des caractéristiques)

C’est

la forme

«y=D(x) »

classe" vraiela" ,

)( ,...,,...,1 : RdF

décisions des ensemble ,...,2,1 tiquescaractéris des espace

D(x)Rx

xDx LlRD

Ly Rx

d

d

d

Nous voulons un algorithme de RdF performant

K

kkXk

D

sSPdxkxfxDsCXDSCEDJ

DJD

1 ,)(,)(,)(

)(min décision de règle uned'Cout D

K

kkXk

D

sSPdxkxfxDsCXDSCEDJ

DJD

1 ,)(,)(,)(

)(min décision de règle uned'Cout D

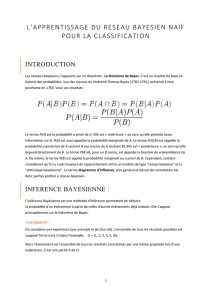

Théorème de Bayes (et non la règle)

)(

),(

: ème théor

),(,

)(,

, jointe loi

),()( ns"observatio" des loi

à (analogue ),( ncevraisembla

posteriori à loi

priori à loi

xf sSPkxf

xsSP

sSPkxfxsSP

xfxsSPxsSP

xsSP

sSPkxfxf

sSxPkxf

xsSP

sSP

X

kX

k

kXk

Xkk

k

k

kXX

kX

k

k

Ex : en français P(e) = 0,12

On choisi la source, et on émet

On choisi une observation, et on décide

Ex : après avoir observé x

quelle est P(e|x) ?

Attention à la confusion

source - action

10 20 30 40 50 60 70 80 90 100

10

20

30

40

50

60

70

80

90

100

illustration

source 1

source 2

sans autre information

on décide toujours

qu’un pixel

vient de la zone

(source 1)

car P(S1) > P(S2)

A PRIORI

que se passe t’il

si l’on connaît

un caratéristique : x

l’intensité

-50 0 50 100

0

500

1000

1500

2000

10 20 30 40 50 60 70 80 90 100

10

20

30

40

50

60

70

80

90

100

illustration

source 1

source 2

Caractéristique : x

l’intensité

on décide

l’action qui « coûte »

le moins cher

en cout 0-1

c’est la classe max

A POSTERIORI

x

f(x|s1)

f(x|s2)

Les vraisemblances

111 ,SPSxfxaP

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

1

/

27

100%