Université Mentouri Constantine Département de Mathématique

Université Mentouri Constantine

Département de Mathématique

Ecole Doctorale de Mathématique

"Lois normales multidimentionnelles"

Dr. Meghlaoui Dakhmouche

Table des matières

1 Introduction 2

1.1 Loi de Gauss à une dimension . . . . . . . . . . . . . . . . . . 2

1.1.1 Propriétés......................... 3

1.1.2 Moments particuliers . . . . . . . . . . . . . . . . . . . 3

1.1.3 Fonction caractéristique . . . . . . . . . . . . . . . . . 4

1.1.4 Loi normale quelconque . . . . . . . . . . . . . . . . . 5

2 Lois de Gauss bidimensionnelles 7

2.1 Loi de Gauss bidimensionnelle centrée . . . . . . . . . . . . . . 7

2.2 Propriétés ............................. 9

2.2.1 Lois marginales des variables aléatoires X1et X2. . . 10

2.2.2 Covariance entre X1et X2................ 11

2.2.3 Matrice de covariances du couple (X1; X2)....... 12

2.3 Loi gaussienne bidimensionnelle centrée et réduite . . . . . . . 12

2.4 Lois gaussiennes conditionnelles . . . . . . . . . . . . . . . . . 14

2.5 Lois gaussiennes bidimensionnelles quelconques . . . . . . . . 15

3 Lois de Gauss de dimension p16

3.1 Casgénéral ............................ 17

4 Régression et prédiction dans les espaces gaussiens 23

4.1 Cas bidiemensionnel . . . . . . . . . . . . . . . . . . . . . . . 23

4.1.1 Principe de régression . . . . . . . . . . . . . . . . . . 24

4.1.2 Commentaire 1...................... 24

4.1.3 Commentaire 2...................... 26

4.2 Cas de dimension p........................ 27

5 Exemple : Loi des vitesses de Maxwell 28

1

6 Exercices 30

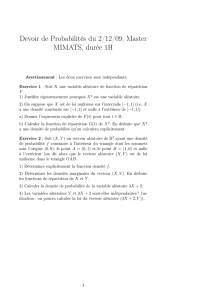

6.1 Exercice1 ............................. 30

6.2 Exercice2 ............................. 30

6.3 Exercice3 ............................. 30

6.4 Exercice4 ............................. 31

6.5 Exercice5 ............................. 31

6.6 Exercice6 ............................. 31

6.7 Exercice7 ............................. 31

2

Chapitre 1

Introduction

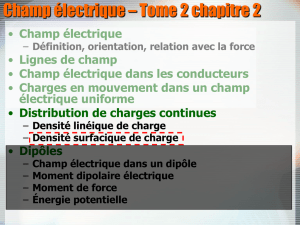

1.1 Loi de Gauss à une dimension

La loi normale ou la loi de Gauss a été précédemment introduite comme

limite de certaines lois discrètes, comme par exemple la loi Binomiale. En

physique elle intervient dans de nombreux modèles (mouvement brownien,

loi des vitesses de Maxwell, par exemple). Il a été déjà établi que la loi de

la somme d’un grand nombre de variables aléatoires indépendantes, sous des

conditions très générales, peut être approchée par la loi de Gauss, ce qui

justi…era l’introduction ou l’utilisation de cette loi en théorie des erreurs

d’observation et de mesure. Historiquement, c’est en ré‡échissant au pro-

blème des erreurs de mesure des constantes physiques (en astronomie plus

précisément) que Gauss reconnut l’importance de la loi qui porte son nom ;

les erreurs de mesure sont dues à l’addition d’un très grand nombre de petites

causes (variables aléatoires) indépendantes. Cette loi joue un rôle capital en

probabilité et en statistique.

De…nition 1 On appelle loi de Gauss (ou loi normale, loi de Laplace-Gauss)

centrée et réduite, une loi de probabilité de densité dé…nie sur Rtelle que :

f(x) = 1

p2ex2

2

3

1.1.1 Propriétés

La fonction f(x)est bien une densité de probabilité. Elle est positive et

de plus : Z+1

1

1

p2ex2

2dx = 1

En e¤et, considérons l’intégrale double R+1

1 R+1

1 e1

2(x2+y2)dxdy. Par ailleurs,

en utilisant le changement des coordonnées cartésiennes en coordonnées po-

laires, on a :

Z+1

1 Z+1

1

e1

2(x2+y2)dxdy =Z2

0

d Z+1

0

e1

22d = 2

De plus, en utilisant Fubini, on a :

Z+1

1 Z+1

1

e1

2(x2+y2)dxdy =Z+1

1

e1

2x2dxZ+1

1

e1

2y2dy= 2

En posant I=R+1

1 e1

2x2dx, on aura alors I2= 2. D’où le résultat :

1

p2Z+1

1

ex2

2dx = 1

1.1.2 Moments particuliers

Moyenne

La loi de probabilité de Gauss est dite centrée si elle est de moyenne nulle.

Z+1

1

x

p2ex2

2dx = 0

En e¤et : Z+1

1

xex2

2dx = lim

A!1 Z+A

A

xex2

2dx = 0

car c’est l’intégrale d’une fonction impaire sur un intervalle symétrique.

4

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

1

/

33

100%