Couples de variables aléatoires

(X, Y )

Ω

(X, Y ) : Ω →R2

X

Y

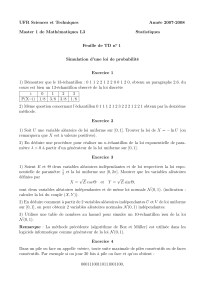

3 4 5 3

X Y

3

4

1

4X

Y

PPPPFFP X = 4 Y= 2

(X, Y )P((X=

i)∩(Y=j)) i∈X(Ω) j∈Y(Ω) (X, Y )

P((X=i)∩(Y=j)) P(X=i)

P(Y=j)

X Y

X(Ω) = {1; 2; 3; 4; 5; 6}Y(Ω) = {1; 2; 3; 4; 5; 6}

P((X=i)∩(Y=j)) = 0 i < j

P((X=i)∩(Y=yj)) = 1

36 i=j36

(i, i)P((X=i)∩(Y=yj)) = 1

18 i > j (i, j) (j, i)

X Y

123456

11

36

1

18

1

18

1

18

1

18

1

18

2 0 1

36

1

18

1

18

1

18

1

18

3 0 0 1

36

1

18

1

18

1

18

4 0 0 0 1

36

1

18

1

18

500001

36

1

18

6000001

36

X(Ω) = {0; 1; 2; 3}Y(Ω) = {0; 1; 2; 3}X+Y > 3

P((X=i)∩(Y=j)) = 3

i4

j 5

3−i−j

12

3

0123

01

22

3

22

3

44

1

220

14

22

6

22

3

55 0

23

22

9

110 0 0

31

55 000

(X=i)∩(Y=j) (X, Y ) = (i, j)

(X=i)∩(Y=j)i X(Ω) j Y (Ω)

X

i∈X(Ω);j∈Y(Ω)

P((X=i)∩(Y=j)) = 1

Ω

(X, Y )X Y

(X, Y )

∀i∈X(Ω) P(X=i) = X

j∈Y(Ω)

P((X=i)∩(Y=j))

Y

Y=j

Y

X

123456P(Y=j)

11

36

1

18

1

18

1

18

1

18

1

18

11

36

2 0 1

36

1

18

1

18

1

18

1

18

9

36

3 0 0 1

36

1

18

1

18

1

18

7

36

4 0 0 0 1

36

1

18

1

18

5

36

5 00001

36

1

18

3

36

6 000001

36

1

36

P(X=i)1

36

3

36

5

36

7

36

9

36

11

36

X

Y

0 1 2 3 P(Y=j)

01

22

3

22

3

44

1

220

14

55

14

22

6

22

3

55 028

55

23

22

9

110 0 0 12

55

31

55 0 0 0 1

55

P(X=i)21

55

27

55

27

220

1

220

X Y =j Z

∀i∈X(Ω) P(Z=i) = PY=j(X=i)Y

X=i

X X(Ω) = N∗X=k

k k P (X=k) =

3

4k

×1

4+1

4k

×3

4=3k+ 3

4k+1

Y(X, Y ) = (i, j)

i j i j

P((X=i)∩(Y=j)) = 3

4i1

4j

×3

4+1

4i3

4j

×1

4=3i+1 + 3j

4i+j+1

Y

(X=i)i>1P(Y=j) =

+∞

X

i=1

P(X=i)×PX=i(Y=j) =

+∞

X

i=1

P((X=i)∩(Y=j)) =

+∞

X

i=1

3i+1 + 3j

4i+j+1 =1

4j

+∞

X

i=1 3

4i+1

+3

4j+∞

X

i=1

1

4i+1 =1

4j3

421

1−3

4

+3

4j1

42

1

1−1

4

=32+ 3j−1

4j+1

Y X

Y=j PY=i(X=i) = P((X=i)∩(Y=j)

P(Y=j)=3i+1 + 3j

4i+j+1 ×4j+1

32+ 3j−1=3i+1 + 3j

4i(32+ 3j−1)

X=i Y =j∀i∈X(Ω) ∀j∈Y(Ω) P((X=i)∩(Y=j)) =

P(X=i)P(Y=j)

X

Y X Y

P((X=i)∩(Y=j)) = 1

36 16i66 1 6j66

X

Y

P(X= 8) = 5

36 P(Y= 15) = 1

18 P((X= 8) ∩(Y= 15)) = 1

18

X Y =j X

X Y

(X, Y )

X Y 0

X

X=i Y =j

P(X= 1) = 3+3

42=3

8P(Y= 1) = 32+ 1

42=5

8P((X= 1) ∩(Y= 1)) =

32+ 3

43=3

16 6=3

8×5

8

X Y

E(X) =

+∞

X

k=1

k×3k+ 3

4k+1 =3

42

+∞

X

k=1

k3

4k−1

+3

42

+∞

X

k=1

k1

4k−1

=3

42 1

(1 −3

4)2+1

(1 −1

4)2!=

3 + 1

3=10

3

Y E(Y) =

+∞

X

k=1

k×32+ 3k−1

4k+1 =32

42

+∞

X

k=1

k1

4k−1

+1

42

+∞

X

k=1

k3

4k−1

=32

42×1

(1 −1

4)2+

1

42×1

(1 −3

4)2= 1 + 1 = 2

2

X Y V (X+Y) = V(X) +

V(Y)

(n, p)n

p p(1 −p)

np(1−p)

X Y X +Y

P(X+Y=k) = XP(X=i)P(Y=k−i)i

P(X=i)P(Y=k−i)

P(X+Y=k) = XP(X=i)i∈X(Ω)PX=i(X+

Y=k)PX=i(X+Y=k) = PX=i(Y=k−i)P(X+Y=k) = PPi∈X(Ω)((X=i)∩(Y=

k−i))

X Y {1; 2; . . . ; 6}

{1; 2; 3; 4}

X+Y

i2 3 4 5 6 7 8 9 10

P(X+Y=i)1

24

1

12

1

8

1

6

1

6

1

6

1

8

1

12

1

24

X Y

Bm,p Bn,p X+YBm+n,p

P(X+Y=k) =

i=k

X

i=0

P(X=i)P(Y=k−i) =

i=k

X

i=0 n

ipi(1 −p)n−im

k−ipk−i(1 −p)m−k+i=pk(1 −p)n+m−k

i=k

X

i=0 n

i m

k−i=n+m

kpk(1 −

p)n+m−k

(n+m, p)

X Y

λ µ X +Y λ +µ

P(X+Y=k) =

i=k

X

i=0

P(X=i)P(Y=k−i) =

i=k

X

i=0

e−λλi

i!×e−µµk−i

(k−i)! =e−(λ+µ)

i=k

X

i=0

1

i!(k−i)!λiµk−i=e−(λ+µ)

k!

i=k

X

i=0 k

iλiµk−i=e−(λ+µ)(λ+µ)k

k!

λ+µ

X Y

FXFYZ= max(X, Y )

FZ=FXFY

FZ(x) = P(Z>x) max(X, Y )6x

X6x Y 6x FZ(x) = P((X6x)∩(Y6x)) = P(X6x)×P(Y6x) =

FX(x)FY(x)

X

Y FXFY

[−∞; 1[ FX(x) = 0 [1; 2[ FX(x) = 1

6[2; 3[ FX(x) = 2

6Z= max(X, Y )

Z[1; 2[ FZ(x) = 1

36 [2; 3[ FZ(x) = 4

36

P(Z=i) = FZ(i)−FZ(i−1)

i123456

P(Z=i)1

36

3

36

5

36

7

36

9

36

11

36

X+Y= min(X+Y)+max(X+Y)

GX(x) = 1 −FX(x) = P(X > x)U= min(X, Y )

GU(x) = GX(x)GY(x)

1

/

5

100%