Algorithmique Diviser et conquérir - (CUI) - UNIGE

G. Falquet, CUI, Université de Genève 1 de 22

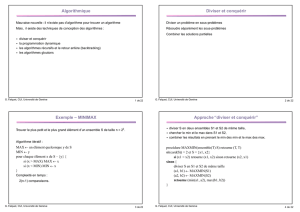

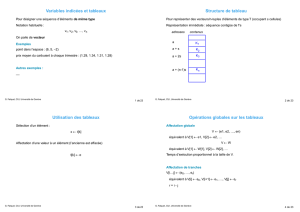

Algorithmique

Mauvaise nouvelle : il n’existe pas d’algorithme pour trouver un algorithme

Mais, il existe des techniques de conception des algorithmes :

•diviser et conquérir

•la programmation dynamique

•les algorithmes récursifs et le retour arrière (backtracking)

•les algorithmes gloutons

G. Falquet, CUI, Université de Genève 2 de 22

Diviser et conquérir

Diviser un problème en sous-problèmes

Résoudre séparément les sous-problèmes

Combiner les solutions partielles

G. Falquet, CUI, Université de Genève 3 de 22

Exemple – MINIMAX

Trouver le plus petit et le plus grand élément d’un ensemble S de taille n = 2k.

Algorithme itératif :

MAX ← un élément quelconque y de S

MIN ← y

pour chaque élément x de S – {y} {

si (x > MAX) MAX ← x

si (x < MIN) MIN ← x

}

Complexité en temps :

2(n-1) comparaisons.

G. Falquet, CUI, Université de Genève 4 de 22

Approche “diviser et conquérir”

•diviser S en deux ensembles S1 et S2 de même taille,

•chercher le min et le max dans S1 et S2,

•combiner les résultats en prenant le min des min et le max des max.

procédure MAXMIN(ensemble(T) S) retourne (T, T)

si (card(S)) = 2 et S = {x1, x2}

si (x1 < x2) retourne (x1, x2) sinon retourne (x2, x1)

sinon {

diviser S en S1 et S2 de même taille

(a1, b1) ← MAXMIN(S1)

(a2, b2) ← MAXMIN(S2)

retourne (min(a1, a2), max(b1, b2))

}

G. Falquet, CUI, Université de Genève 5 de 22

Complexité

Nombre de comparaison en fonction de la taille n de S

T(n) = 1 si n = 2

= 2T(n/2) + 2 si n > 2

Cette équation a pour solution la fonction

T: n → 3n/2 - 2

Algorithme est 25% meilleur que le précédent.

G. Falquet, CUI, Université de Genève 6 de 22

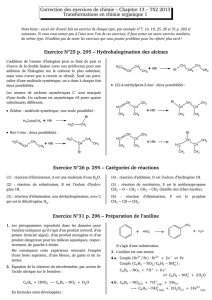

Exemple-2 : SOUS-SUITES MAXIMALES

Etant donné une suite de nombres positifs, nuls ou négatifs

S = <s1, s2, …, sn>

trouver i et j (i≤j) tels que si + si+1 +si+2 + … + sj soit la plus grande possible.

S = <1, -2, 5, -3, -1, 2, -1, 9, -8, 7, 1>

sous-suite max :

Algorithme exhaustif

essayer toutes les valeurs possibles de i et j,

donc n + (n-1) + (n-2) + … + 2 + 1 = (n (n+1))/2 sommes à calculer.

Chaque somme peut se calculer en une opération à partir de la somme précédente.

Donc effectuer (n (n+1))/2 additions et comparaisons.

G. Falquet, CUI, Université de Genève 7 de 22

Diviser

On divise S en deux parties S1 = <s1, …, sn/2> et S2 = <sn/2+1, …, sn>

Trois cas possibles

•la sous-suite max. se trouve entièrement dans S1;

•elle se trouve entièrement dans S2;

•elle commence dans S1 et finit dans S2.

Dans ce dernier cas les éléments sn/2 et sn/2+1 appartiennent à la sous-suite.

< s1 ……………………………sn >

G. Falquet, CUI, Université de Genève 8 de 22

Algorithme

procedure MAXSOM(a, b)

si (a = b) retourne s[a]

sinon {

d = (a+b)/2; max1 ← MAXSOM(a, d); max2 ← MAXSOM(d+1, b)

// la plus grande somme qui commence en S1 et finit à d

m1 ← s[d]; somme ← s[d];

pour i de d-1 à a {

somme ← somme + s[i]

si (somme > m1) m1 ← t }

//. la plus grande somme qui commence en d+1 et finit dans S2

m2 ← s[d+1]; somme ← s[d+1];

pour i de d+1 à b {

somme ← somme + s[i]

si (somme > m2) m2 ← t }

retourner max(max1, max2, m1+m2)

G. Falquet, CUI, Université de Genève 9 de 22

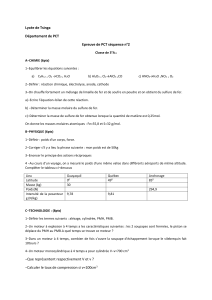

Complexité

Le nombre de sommes et comparaisons est

T(n) = 1 si n = 1

= 2T(n/2) + 2n si n>1

Calcul

T(2k) = 2T(2k-1) + 2k+1

= 2(2T(2k-2)+2k)+2k+1 = 22T(2k-2) + 2k+1 + 2k+1

= 22T(2T(2k-3)+2k-1) + 2k+1 + 2k+1 = 23T(2k-3)+2k+1 + 2k+1 + 2k+1

=…

= 2kT(1) + k(2k+1) = 2k + 2k2k = n + 2log(n) n ∈ O(n log n)

G. Falquet, CUI, Université de Genève 10 de 22

Equilibrage des partitions

Tri de n nombres par recherche du plus petit

•trouver le plus petit élément du tableau

•échanger le 1er avec le plus petit

•trier les n-1 éléments restants

Complexité O(n2)

1n – 1

6

6

7

7

8

8

9

9

10

10

11

11

1

/

11

100%