2. La production de statistiques internationales de l`éducation

1

Séminaire international « La mesure en éducation »

FOREDUC, EHESS, IRD

18-19 juin 2004

Vers une comparabilité plus normative des statistiques internationales de l’éducation :

du droit à l’éducation aux compétences

Roser Cussó et Sabrina D’Amico

1

Résumé : La comparabilité des statistiques internationales de l’éducation –telle que définie par

l’UNESCO– a été défiée depuis la fin des années 1980, lorsque d’autres agences internationales

commencent à produire leurs propres statistiques éducatives. Cette évolution est parallèle à la nouvelle

importance stratégique que l’éducation prend dans les programmes économiques nationaux et

internationaux. L’éducation et la formation contribueraient à faire face à la concurrence entre les nations

sur le marché international (employabilité, flexibilité). La comparabilité des statistiques de l’éducation

devrait, de ce fait, être plus poussée par rapport à celle attachée au « droit à l’éducation ». Les indicateurs

doivent servir à comparer non seulement les caractéristiques du système éducatif, mais aussi les

décisions politiques qui les sous-tendent. Ces dernières doivent, en outre, être évaluées selon des

critères de performance établis par des observateurs extérieurs (compétences des élèves, efficacité de la

dépense…). Paradoxalement, cette nouvelle comparabilité internationale est, quelque part, moins

consistante du point de vue statistique (« régionalisation », critères méthodologiques hétérogènes, rupture

des séries temporelles), mais beaucoup plus poussée dans ses objectifs (mesure de la performance du

système scolaire et des élèves) et dans ses conséquences (réforme scolaire, conditionnalités des prêts).

1. Vers quelle comparabilité internationale ? .................................................................................................... 1

2. La production de statistiques internationales de l’éducation : l’UNESCO ............................................ 3

3. La qualité des données internationales de l’éducation jusqu’aux années 1990 .................................. 6

4. Le tournant des années 1990 : critique et diversification de la production statistique ..................... 8

5. Education pour tous, révision de la CITE et restructuration des services statistiques ................... 10

6. Des comparaisons statistiques plus « normatives » et « fragmentées » ............................................ 12

7. Conclusion : nouvelle politique d’éducation, nouvelle comparaison internationale........................ 15

Références bibliographiques ............................................................................................................................... 16

Annexe ....................................................................................................................................................................... 18

1. Vers quelle comparabilité internationale ?

Les statistiques internationales de l’éducation font, depuis quelques années, l’objet d’un intérêt croissant

de la part des agences internationales, des chercheurs et du public en général. Cet intérêt est parallèle à

la nouvelle importance stratégique que l’éducation a prise dans les programmes économiques nationaux

et internationaux

2

. Depuis la fin des années 1970, dans le contexte du renouveau libéral, les évolutions du

1

Les auteurs ont travaillé plusieurs années dans les services statistiques de l’UNESCO, notamment entre 1994 et

2001. Sabrina D’Amico, statisticienne de formation, est actuellement fonctionnaire au secteur des Ressources

humaines de l’UNESCO. Roser Cussó réalise, avec le financement du FNRS, un post-doctorat sur les politiques

d’éducation de l’Union européenne au sein du GRAID, Institut de Sociologie de l’Université Libre de Bruxelles.

2

Il importe de rappeler que, bien que sur un autre plan, l’éducation était, depuis bien avant, perçue comme un facteur

de productivité et de transformation sociale et culturelle (Cussó, 2002) : « La Banque [mondiale] est convaincue que

le progrès économique des pays moins développés dépend pour beaucoup de la mesure dans laquelle ils

parviendront à créer les compétences nécessaires parmi leurs populations et à ouvrir à leur esprit un plus large

horizon, et que le succès des efforts qu’ils déploieront en ce sens ne peut être assuré que s’ils disposent de systèmes

d’éducation efficaces et adéquats. » (Banque mondiale, 1963 : p8).

2

contexte socioéconomique (crise du pétrole, transformation du mode de production) s’accompagnent

d’une nouvelle façon de concevoir la politique économique et de rendre compte des problèmes qui y sont

liés (régulation par le marché, restructuration, privatisation, plus grande libéralisation des échanges…).

Basé essentiellement sur la formation et l’éducation des individus, le capital humain (Becker, 1993) re-

devient une variable stratégique centrale pour, en principe, faire face à la concurrence croissante entre les

nations sur le marché économique international. Un pays disposant d’une population active formée et

flexible est supposé pouvoir mieux s’ajuster aux évolutions du marché et de la demande de compétences

qui s’ensuit. C’est dans ce contexte que la comparabilité des statistiques internationales de l’éducation

prend une nouvelle dimension.

Les activités statistiques internationales sont du début, marquées par la recherche de la comparabilité

entre les pays dans le contexte des politiques de « développement ». En effet, depuis leur création, les

Nations Unies (NU) –via leurs agences et leurs commissions spécialisées– encouragent l’extension et la

standardisation des statistiques nationales (enquêtes de ménages, recensements démographiques…)

avec, entre autres, la définition de méthodologies et de catégories statistiques communes (catégories

socioprofessionnelles, rural, urbain…). Les systèmes éducatifs nationaux ne font pas exception. La

responsabilité de leur étude comparative revient à l’Organisation des Nations Unies pour l’éducation, la

science et la culture (UNESCO).

Restée assez « descriptive », la comparabilité mise en œuvre par l’UNESCO sera critiquée à partir des

années 1980. Dans le but, entre autres, de tenir compte de la diversité des systèmes éducatifs nationaux,

les traits communs de cette diversité –représentés par les indicateurs statistiques–, tout étant

techniquement comparables, n’étaient pas traitées comme immédiatement équivalents –sur un

classement, par exemple. La critique de cette démarche et la demande d’une nouvelle comparabilité

statistique proviendront notamment de la Banque mondiale et de l’Organisation de coopération et de

développement économiques (OCDE)

3

. L’établissement de classements hiérarchisés des pays,

notamment concernant les acquis scolaires des élèves, est vivement souhaité (Puryear, 1995). Il ne suffit

plus de savoir combien de diplômés produit un système éducatif par rapport à ceux d’autres pays, mais

aussi à quel coût, dans quel but, avec quelles connaissances et compétences précises des élèves.

Autrement dit, il ne s’agira plus seulement de comparer les caractéristiques du système éducatif, mais

aussi les décisions politiques nationales qui les sous-tendent. Ces dernières ne doivent pas être

uniquement évaluées selon leurs propres objectifs, mais également par rapport à des critères de

performance établis par des observateurs extérieurs (efficacité du système éducatif, développement de

compétences…).

Malgré ces critiques, le programme statistique de l’UNESCO restera, du moins jusque la restructuration

des services statistiques en 1999, essentiellement destiné à mettre à disposition des Etats membres des

données internationalement standardisées dans le cadre de l’extension et de la planification de

l’éducation de masse. Les publications continuent à n’inclure que rarement des classements des pays ou

des analyses statistiques complexes (des corrélations entre le salaire des enseignants et le nombre de

diplômés, par exemple, ne sont guère calculées bien que les données nécessaires soient collectées).

C’est ainsi que, surtout depuis les années 1990, l’OCDE, Eurostat ou la Banque mondiale commencent à

collecter, analyser et publier leurs propres données de l’éducation. Ces entités développent également

3

La demande d’une nouvelle comparabilité statistique internationale coïncide également avec le débat sur la school

effectiveness développé notamment aux Etats-Unis et au Royaume-Uni (Normand, 2003).

3

des études statistiques et produisent des recommandations sur la politique éducative. Cette nouvelle

production permettra de réaliser, enfin, la nouvelle comparabilité internationale revendiquée depuis une

dizaine d’années.

Dans un premier temps, nous explorerons les enjeux de la collecte, de l’analyse et de la diffusion des

données internationales de l’éducation. Nous nous centrerons sur les activités des services statistiques de

l’UNESCO, notamment la méthode et les particularités techniques qui ont marqué les critères de

comparabilité –et de qualité– des données internationales de l’éducation jusqu’aux années 1990. Le

tournant des années 1990 verra la production statistique et les critères de comparabilité des données se

diversifier. Nous analyserons ces évolutions méthodologiques et leurs conséquences techniques, mais

aussi le lien entre la multiplication d’études statistiques et de recommandations qui accompagnent cette

nouvelle comparabilité des données et les programmes de réforme et/ou de révision des systèmes

éducatifs nationaux.

Enfin, avec cet article, nous voudrions contribuer à garder trace de la façon de concevoir la comparabilité

et la qualité des statistiques internationales de l’éducation qui a prévalu au cours de quatre décennies au

sein de l’UNESCO. Cette perception de la comparabilité a, en principe, correspondu à une façon

particulière d’envisager le dialogue entre les nations dans le cadre du droit à l’éducation et du respect de

la diversité, non sans contradiction entre ces deux notions, respectivement « modernisatrice » et

« traditionnelle » (Cussó, 2003). Selon cette perspective, les pays nécessitaient des comparaisons

statistiques et des objectifs communs pour, par exemple, mieux identifier les points faibles de leurs

systèmes éducatifs (« coopération technique »). Les politiques d’éducation –leur évolution ou réforme–

étaient définies en dernière instance par les responsables politiques et sociaux de chaque pays selon

leurs propres objectifs. Comparer était examiner et échanger, mais pas toujours –ou pas forcément–

déterminer des modèles communs et univoques à partir de l’analyse des indicateurs internationaux, aussi

rigoureuse soit-elle. C’est cette distance critique qui avait permis une comparabilité internationale solide et

souple à la fois, aujourd’hui défiée par les nouvelles demandes d’information.

2. La production de statistiques internationales de l’éducation : l’UNESCO

La définition, la collecte et la diffusion des statistiques internationales de l’éducation sont des activités

cruciales qui supposent l’endossement d’une grande responsabilité et le privilège d’une influence

considérable sur les rapports et les études statistiques qui en sont dérivés. Le dessin d’un questionnaire

(ou d’une enquête) international détermine le type, la couverture et le niveau de détail des données

demandées aux responsables nationaux autant qu’il fixe l’éventail d’indicateurs qu’il sera ensuite possible

de calculer. La conception de la base de données, la méthode de vérification ou la définition de la

comparabilité pèsent énormément sur les caractéristiques des statistiques. Les décisions concernant

l’analyse et la publication des statistiques délimitent la sélection de données et d’indicateurs disponibles

pour les praticiens et les chercheurs. Pendant plusieurs décennies, c’est l’UNESCO qui a eu la

responsabilité principale de la production des statistiques internationales de l’éducation. Cette

responsabilité découlait de sa mission au sein du système des NU et de la représentativité

intergouvernementale de sa Conférence générale

4

.

4

La Conférence générale réunit tous les Etats membres de l’UNESCO tous les deux ans. Le Conseil exécutif, où sont

représentés cinquante-huit Etats membres, se réunit deux fois par an. Il veille à l’exécution des décisions de la

Conférence générale et prépare les travaux de la session suivante. Après consultation avec les Etats membres et en

interaction avec la Direction générale, les différents secteurs et unités du Secrétariat (Education, Sciences, Culture,

4

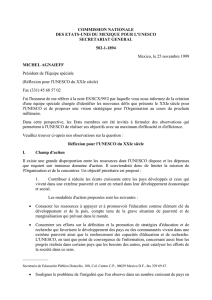

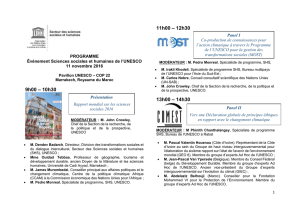

La Division des statistiques de l’UNESCO

5

a conçu et a mis en œuvre un programme statistique

international sur l’éducation –ainsi que sur la science et la technologie, la culture et la communication–

couvrant tous les pays du monde. Le schéma suivant synthétise les grands traits du programme de travail

qui a permis d’assurer la comparabilité internationale des statistiques de l’éducation –et leur « qualité »

telle que définie aujourd’hui par la plupart des agences internationales (Eurostat, 2002 ; Carson et al.,

2001)– aussi bien que le maintien d’un certain nombre de particularités nationales jusqu’aux années

1990.

La production de données internationales de

l’éducation (UNESCO)

OBJECTIFS

(GENERAUX et SPECIFIQUES)

BASE DE

DONNEES

DEFINITION DES INDICATEURS

DEFINITION D’OUTILS DE

CLASSIFICATION (CITE)

ELABORATION D’OUTILS DE

RECUEIL DE DONNEES

(questionnaires, enquêtes…) FOURNISSEURS de DONNEES

(PAYS)

DONNEES

ANALYSE ET

VERIFICATION

Répercussions

Vérifications

approfondies

FORMATIONS,

MANUELS

Diffusion

Statistiques

Publications

Analyses

Recherche

Tout d’abord, tout programme de production de données s’appuie sur la définition de ses objectifs (qu’est-

ce qu’on veut mesurer et pourquoi). Le programme statistique de l’UNESCO a été long temps encadré

dans l’objectif général du droit à l’éducation (UNESCO, 2000). Le principal objectif spécifique a été de

mettre à la disposition des Etats membres des données comparables pour les aider dans leur prise de

décision (planification) et dans leur cheminement vers l’extension de l’éducation et de l’alphabétisation.

Ces objectifs se sont appuyés sur les politiques post-keynésiennes des années 1950 et 1960, axées,

entre autres, sur le rôle de l’Etat comme fournisseur des services éducatifs. L’école dans les pays

industrialisés avait correspondu au développement du salariat et à la conséquente mise en place d’« un

système collectif de reproduction socialisée hors travail dans le cadre politique de la nation » (Vinokur,

2002 : p4). Le modèle scolaire des pays du Nord devait être exporté et répandu au reste du monde dans

le contexte des politiques de « développement »

6

. La « tradition » structuraliste (un certain relativisme

Bureau du budget, etc.) préparent et proposent les programmes et les résolutions à la Conférence générale pour être

discutés et adoptés.

5

L’unité chargée des statistiques était au début l’Office des statistiques, rattaché au Secteur de la communication. En

1977, l’Office est transféré au Secteur du soutien du programme. L’Office des statistiques devient la Division des

statistiques en 1991 et, en 1992, la Division est intégrée au Bureau d’études, de programmation et d’évaluation.

6

La reproduction du modèle qu’on peut appeler occidental n’a pas été forcément un but « réel » de la modernisation

sociale et économique promue par les programmes de développement. Ainsi, par exemple, du point de vue

5

culturel) qui a marqué l’origine de l’UNESCO (Lévi-Strauss, 1952) rendait l’Organisation réticente à

l’adoption complète de ce but international. Il était certainement touché d’ethnocentrisme et ne prenait pas

en compte que, par exemple, dans beaucoup de pays du Sud, le salariat n’était pas généralisé. Cette

relative appréhension et le caractère intergouvernemental de l’UNESCO ont favorisé, en outre, l’origine

toujours officielle des sources des données. Les classements des Etats membres étaient également

évités.

Les principaux outils de standardisation des données ont été, et sont toujours, les questionnaires

statistiques, les systèmes de classification des programmes éducatifs et les méthodologies de calcul

d’indicateurs. Les données sont majoritairement recueillies à travers trois questionnaires standardisés

concernant les enseignements pré-primaire, primaire et secondaire, l’enseignement supérieur et le

financement public et privé de l’éducation

7

. Les questionnaires sont envoyés aux Commissions nationales

pour l’UNESCO d’environ 200 pays, qui les font parvenir aux autorités nationales compétences telles que

le ministère de l’Éducation, le ministère des Finances ou les universités (parfois, les questionnaires sont

directement adressés à ces institutions). Pour assurer la comparabilité internationale des données, les

questionnaires doivent être remplis en suivant la Classification internationale type de l’éducation (CITE).

Cette classification a été approuvée par la Conférence générale de l’UNESCO en 1978

8

. Les

responsables des Etats membres utilisent la définition des différents niveaux d’enseignement de la CITE

pour classer leurs programmes éducatifs et pouvoir ainsi regrouper ou dissocier les données

correspondantes à chaque niveau et à chaque rubrique des questionnaires. Des formations (ateliers,

séminaires) et des manuels sont réalisés dans l’objectif de familiariser les responsables nationaux aux

questionnaires et aux classements internationaux des programmes éducatifs.

Les données recueillies dans les questionnaires sont rentrées dans la base des services statistiques de

l’UNESCO. Celle-ci permet l’archivage, le calcul, la vérification, la correction, l’estimation et la diffusion

des indicateurs et des statistiques. Les données sont vérifiées et analysées en les confrontant à d’autres

sources de données officielles telles que les annuaires statistiques nationaux, mais surtout en testant leur

cohérence avec les séries temporelles et les données démographiques et économiques. Si des

incohérences sont relevées dans les données soumises, les responsables des pays concernés sont

contactés pour obtenir des précisions complémentaires.

Enfin, le principal moyen de diffusion des statistiques ont été les publications de la Division des

statistiques et des fichiers électroniques ainsi que, plus récemment, le site Internet et des CD-Roms. Les

principales publications statistiques de l’UNESCO ont été l’Annuaire statistique (1963-1999), des séries

telles que les Notes statistiques STE, et d’autres études spécifiques ponctuelles. La section suivante

analyse avec plus de détail la question de la « qualité » des données internationales dans le contexte des

services statistiques de l’UNESCO.

économique, il a souvent été question d’une spécialisation dans la production des matières premières et non pas du

développement d’économies diversifiées et complexes comme celles des pays du Nord.

7

Les indicateurs sur l’alphabétisme étaient basés sur des estimations à partir des recensements nationaux et d’autres

données scolaires et démographiques complémentaires.

8

La CITE a été conçue par l’UNESCO au début des années 1970 et elle a été approuvée par la Conférence

internationale de l'éducation lors de sa trente-cinquième session (Genève, 1975), puis par la Conférence générale de

l'UNESCO lors de sa vingtième session en 1978.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

1

/

18

100%