Algorithmique algébrique MHT 631

Algorithmique algébrique

MHT 631

Jean-Paul Cerri

2008-2009

2

Table des matières

1 Algèbre linéaire, préliminaires 5

1.1 Gerschgörin-Hadamard . . . . . . . . . . . . . . . . . . . . . . 6

1.2 Normes sur Mn,n(K)....................... 9

1.3 Suites de matrices, convergence . . . . . . . . . . . . . . . . . 14

1.3.1 Généralités . . . . . . . . . . . . . . . . . . . . . . . . 14

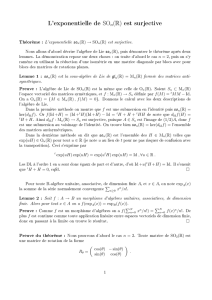

1.3.2 Exponentielle de matrices . . . . . . . . . . . . . . . . 17

1.3.3 Généralisation. Autres exemples . . . . . . . . . . . . . 19

1.3.4 Application aux systèmes différentiels . . . . . . . . . . 22

2 Le pivot de Gauss 27

2.1 Rappels sur les matrices de permutations . . . . . . . . . . . . 27

2.2 Exemples concrets, le principe . . . . . . . . . . . . . . . . . . 28

2.3 Le théorème principal . . . . . . . . . . . . . . . . . . . . . . . 33

2.4 Lecoût............................... 33

2.5 Mise en oeuvre effective et variantes . . . . . . . . . . . . . . . 34

3 Conditionnement 37

3.1 Définition ............................. 37

3.2 Erreurs relatives . . . . . . . . . . . . . . . . . . . . . . . . . . 38

3.3 Propriétés élémentaires . . . . . . . . . . . . . . . . . . . . . . 40

4 Méthodes itératives 43

4.1 Le lemme fondamental . . . . . . . . . . . . . . . . . . . . . . 43

4.2 La méthode de Jacobi . . . . . . . . . . . . . . . . . . . . . . 44

4.3 La méthode de Gauss-Seidel . . . . . . . . . . . . . . . . . . . 45

4.4 Relaxation............................. 48

4.5 Programmation .......................... 48

4.5.1 Jacobi ........................... 49

4.5.2 Gauss-Seidel . . . . . . . . . . . . . . . . . . . . . . . . 49

4.5.3 Relaxation avec Gauss-Seidel . . . . . . . . . . . . . . 50

3

4TABLE DES MATIÈRES

5 Calculs effectifs divers 51

5.1 Polynôme caractéristique . . . . . . . . . . . . . . . . . . . . . 51

5.2 Valeurspropres .......................... 54

5.2.1 Méthode des puissances . . . . . . . . . . . . . . . . . 54

5.2.2 Méthode de la déflation . . . . . . . . . . . . . . . . . 56

5.2.3 Méthode QR ....................... 57

6 Espaces euclidiens 59

6.1 introduction............................ 59

6.2 Orthogonalisation de Schmidt . . . . . . . . . . . . . . . . . . 64

7 Décompositions 67

7.1 Décomposition QR ........................ 67

7.2 Décomposition de Cholesky . . . . . . . . . . . . . . . . . . . 69

7.3 La méthode QR .......................... 71

8 Méthodes de calcul 73

8.1 Cholesky pratique . . . . . . . . . . . . . . . . . . . . . . . . . 73

8.1.1 Gram-Schmidt . . . . . . . . . . . . . . . . . . . . . . 73

8.1.2 Identification . . . . . . . . . . . . . . . . . . . . . . . 74

8.1.3 Variante.......................... 75

8.1.4 Méthode de Gauss . . . . . . . . . . . . . . . . . . . . 76

8.2 Moindrescarrés.......................... 77

8.3 La méthode de Householder . . . . . . . . . . . . . . . . . . . 79

8.3.1 Préliminaires . . . . . . . . . . . . . . . . . . . . . . . 80

8.3.2 Laméthode ........................ 81

9 Polynômes orthogonaux 85

9.1 Généralités ............................ 85

9.2 Un cas particulier . . . . . . . . . . . . . . . . . . . . . . . . . 86

9.3 Exemples ............................. 88

9.3.1 Polynômes de Tchebycheff . . . . . . . . . . . . . . . . 88

9.3.2 Polynômes de Legendre . . . . . . . . . . . . . . . . . . 91

9.3.3 Polynômes de Hermite . . . . . . . . . . . . . . . . . . 91

10 Compléments 93

10.1 Extensions de certains résultats aux matrices “quelconques” . . 93

10.2 Décomposition en valeur singulière (SVD) . . . . . . . . . . . 93

10.3Pseudo-inverse........................... 93

Chapitre 1

Algèbre linéaire, préliminaires

Éléments supposés connus en algèbre linéaire

•Corps commutatif K: ici, sauf mention explicite, K=Rou C;

•K-espace vectoriel, sous-espace vectoriel, familles libres, familles géné-

ratrices, bases ;

•Kespace vectoriel de dimension finie n, sous-espaces, bases ;

•Déterminant d’une famille de vecteurs d’un K-espace vectoriel (suivant

une base), propriétés du déterminant ;

• L(E, F )où Eet Fsont deux K-ev, propriétés de L(E, F );

–L(E, F )est un K-ev ;

– Noyau Kerfet image Imfd’un élément fde L(E, F );

– Propriétés et lien avec surjectivité et injectivité de f;

– Théorème du rang en dimension finie ;

• L(E)où Eest un K-ev, propriétés de L(E);

–L(E)est une algèbre en général non commutative ;

– Éléments inversibles : GL(E);

– Cas de la dimension finie : lien avec image, noyau (une condition

suffit) ;

– Déterminant d’un élément de L(E)et lien avec l’inversibilité ;

– Valeur propre et vecteur propre d’un élément de L(E);

– Polynômes minimal et caractéristique d’un élément de L(E);

– Théorème de Cayley-Hamilton ;

– Critères de diagonalisabilité ;

•Matrices associées aux éléments de L(E, F )(si Eet Fsont de dimen-

sions finies et si une base de Eet une base de Fsont fixées) ;

•Notations Mp,q(K), et isomorphismes standards, opérations dans les

espaces de matrices ;

5

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

84

84

85

85

86

86

87

87

88

88

89

89

90

90

91

91

92

92

93

93

1

/

93

100%