Vecteurs propres et valeurs propres - Algèbre Linéaire

Universit´

e de Nice SL2SF

2012-13 Alg`

ebre 2

Vecteurs propres et valeurs propres.

On travaille sur le corps Rdes r´eels.

On pourrait ´egalement utiliser le corps des complexes C. La plupart des r´esultats sont en fait

valables sur un corps quelconque.

Un r´esultat essentiel du cours de premi`ere ann´ee est le suivant : on consid`ere un syst`eme lin´eaire

homog`ene (i.e. sans second membre) de p´equations `a ninconnues

a1,1x1+. . . +a1,nxn= 0

.

.

.

ap,1x1+. . . +ap,nxn= 0.

La matrice p×nde coefficients ai,j pour ide 1 `a pet jde 1 `a nest la matrice du syst`eme. On la

d´esigne par A.

On ´echelonne les lignes de la matrice A. Le rang des lignes de Aest le nombre de pivots obtenu dans

la proc´edure d’´echelonnage. Il ne d´epend pas du proc´ed´e choisi. C’est le nombre de variables

li´ees du syst`eme. On l’appelle le rang du syst`eme (ou rang des lignes de A). L’espace des solutions

du syst`eme a pour dimension le nombre de variables libres et, bien sˆur, le nombre de variables

est ´egal `a la somme du nombre de variables li´ees et du nombre de variables libres. C’est la premi`ere

forme du th´eor`eme du rang.

1. Applications lin´

eaires

Dans tout ce paragraphe, on consid`ere deux espaces vectoriels Eet Fsur Ret une application

f:E−→ F.

Pour les d´efinitions aller au paragraphe 10.

1.1. Matrice d’une application lin´eaire. On suppose ici que Eet Fsont de dimension finie.

On note nla dimension de Eet pla dimension de F. On se donne des bases B= (e1, . . . ,en) de

Eet C= (1, . . . ,p) de F.

On consid`ere une application lin´eaire f:E−→ F.La matrice de fdans les bases (B,C) est

un tableau `a plignes et ncolonnes. Sur la j-`eme colonne on dispose les coordonn´ees dans la base

Cde l’image par fdu j-`eme vecteur de B, de sorte que le coefficient ai,j de la matrice, situ´e sur

la ligne de num´ero iet la colonne de num´ero jest la i-`eme coordonn´ee du vecteur f(ej). On note

Mp,n(R) l’ensemble des matrices `a plignes et ncolonnes.

Aux op´erations sur les applications lin´eaires, correspondent les op´erations sur les matrices : produit

par un scalaire, somme, produit de matrices.

Noter que le produit AB de deux matrices n’a de sens que si le nombre de lignes de Best ´egal

au nombre de colonnes de A. La matrice AB a alors le nombre de lignes de Aet le nombre de

colonnes de B. En particulier, si Aest dans Mp,n(R) et Xune matrice colonne de Mn,1(R), alors

le produit AX est une matrice colonne de Mp,1(R).

2

Comment disposer le produit de deux matrices : ci-dessous le calcul du coefficient ci,j du produit

AB. Il ne fait intervenir que la i-`eme ligne de Aet la j-`eme colonne de B.

b1,j

b2,j

.

.

.

bn,j

ai,1ai,2. . . ai,n

.

.

.

. . . ci,j

ci,j =ai,1b1,j +ai,2b2,j +. . . +ai,nbn,j

=

n

X

`=1

ai,`b`,j .

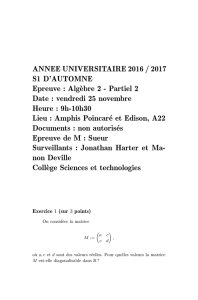

1.1.1. Exercice. On consid`ere un entier n,n≥2, deux entiers iet j,1≤i6=j≤n, une

matrice carr´ee Li,j (λ)de taille n×ndont les coefficients diagonaux sont tous ´egaux `a 1, dont le

coefficient i,j vaut λet dont tous les autres coefficients sont nuls.

On consid`ere ´egalement une matrice A`a nlignes et pcolonnes. On d´esigne par Lila ligne de

num´ero i, pour ide 1 `a n. Montrer que le produit Li,j (λ)Aest une matrice A0qui a les mˆemes

lignes que Asauf la ligne de num´ero iqui vaut Li+λLj.

1.1.2. Exercice. Montrer que Mp,n(R)est un espace vectoriel sur R. En donner une base.

Quelle est sa dimension ? Montrer que Mn,n(R), que l’on notera d´esormais Mn(R), est stable par

la multiplication des matrices. Montrer que ce produit n’est pas commutatif si n > 1.

Comment calculer avec la matrice de f? Notons Ala matrice de fdans les bases (B,C).

Un vecteur x de Eest un ´el´ement de ker fsi f(x) =

0. Ses coordonn´ees (x1, . . . , xn) dans Bsont

solutions du syst`eme lin´eaire homog`ene de matrice A. Ce syst`eme a p´equations `a ninconnues. Il a

pour rang le rang de A(nombre de variables li´ees) et l’ensemble de ses solutions est de dimension

d−rg(A) (nombre de variables libres). On a donc dim ker f= dim E−rg(A). Comme le sous-

espace ker fest ind´ependant de la base choisie, le rang de la matrice de fdans une base Bne

d´epend pas du choix de cette base.

Un vecteur y de Fest un ´el´ement de Im(f) s’il existe un vecteur x de Etel que f(x) = y. Le

sous-espace vectoriel Imfest engendr´e par les images des vecteurs de B. Sa dimension est le rang

des colonnes de A. On d´emontre que le rang des colonnes de Aest ´egal au rang des lignes de A.

1.2. Th´eor`eme (du rang).On consid`ere une application lin´eaire f:E−→ Fentre deux espaces

vectoriels de dimension finie sur R. Le rang de fest ´egal `a la dimension de Im(f)et on a la

formule

dim ker f= dim E−dim Im(f).

2. Vecteurs propres et valeurs propres d’une application lin´

eaire

Dans tout ce paragraphe, on consid`ere un entier d, un espace vectoriel Ede dimension dsur Ret

une application lin´eaire f:E−→ E.

2.1. D´efinition. On dit qu’un vecteur v de Eest un vecteur propre de fsi

–v n’est pas nul

–f(v)est un vecteur proportionnel `a v.

Lorsque v est un vecteur propre de f, le coefficient de proportionnalit´e de f(v)sur v est la valeur

propre associ´ee `a v.

3

Si v est un vecteur propre de f, il existe un scalaire λtel que

f(v) = λv.

On dit que v est un vecteur propre de fde valeur propre λ.

2.1.1. Exemple. On consid`ere l’application g:R2−→ R2dont la matrice dans la base canonique

de R2est la suivante

A:= 1 6

5 2

et les deux vecteurs

u := 3

−2et v := 6

−5

On v´erifie que

g(u) = −9

11 et g(v) := −24

20 .

On en d´eduit que u n’est pas un vecteur propre de g, tandis que v est un vecteur propre de valeur

propre −4.

2.1.2. Exemple. [plus g´en´eral : on ne suppose pas que Eest de dimension finie] On consid`ere

l’espace vectoriel des polynˆomes d’une variable `a coefficients r´eels not´e R[X] et l’application

d´erivation

D:R[X]−→ R[X]

P7−→ P0.

Un vecteur propre de Pest un polynˆome non nul Pdont la d´eriv´ee P0lui est proportionnelle.

Si le degr´e de Pest au moins 1, alors la d´eriv´ee P0est de degr´e strictement inf´erieur et ne peut

donc pas ˆetre proportionnelle `a P. Si Pest de degr´e 0, c’est une constante non nulle et sa d´eriv´ee

est nulle. On voit donc que les seuls vecteurs propres de Dsont les constantes non nulles, tous

associ´es `a la seule valeur propre 0.

Noter qu’une base de R[X] est la famille des monˆomes (1, X, X2, . . .) qui est infinie d´enombrable.

L’espace vectoriel R[X] n’est donc pas de dimension finie.

2.2. D´efinition. On consid`ere une valeur propre λde l’application f. Le sous-espace propre

de fassoci´e `a λest l’ensemble des vecteurs de Esolutions du syst`eme lin´eaire f(v) = λv. C’est

un sous-espace vectoriel de E. On le note Eλ(f).

Comme λest une valeur propre de f, le sous-espace Eλ(f) contient au moins un vecteur non nul. Il

est donc de dimension strictement positive. L’ensemble des vecteurs propres de fde valeur propre

λest l’ensemble des vecteurs non nuls de Eλ(f).

On remarque que le syst`eme lin´eaire f(v) = λv s’´ecrit

(f−λId)(v) =

0.

2.2.1. Exemple. On consid`ere l’application g:R3−→ R3dont la matrice dans la base canonique

de R3est la suivante

A:=

4−1 6

2 1 6

2−1 8

.

4

Le scalaire 2 est une valeur propre de g. En effet, l’application g−2Id a pour matrice

A−2I3=

2−1 6

2−1 6

2−1 6

qui est de rang 1. Le syst`eme lin´eaire g(v)−2v =

0 se r´eduit `a la seule ´equation 2v1−v2+6v3= 0.

Ses solutions forment un sous-espace vectoriel E2(g) de dimension 2 dans R3dont une base est

1

2

0

,

−3

0

1

.

2.3. Th´eor`eme. On consid`ere un scalaire λ. Les assertions suivantes sont ´equivalentes

(1) λest une valeur propre de f.

(2) Il existe un vecteur propre de fde valeur propre λ.

(3) Le syst`eme lin´eaire (f−λId)(v) =

0a au moins une solution non nulle (on dit aussi non

triviale, puisque le vecteur nul est toujours solution).

(4) Le noyau de f−λId n’est pas r´eduit au seul vecteur nul.

(5) Le rang de f−λId n’est pas maximum (autrement dit strictement inf´erieur `a la dimension

dde E.

La seule chose qui ne d´ecoule pas des d´efinitions est l’´equivalence de (3) et (4). C’est le th´eor`eme

du rang, appliqu´e `a f−λId qui fournit la r´eponse, puisque

dim ker(f−λId) + rg(f−λId) = d.

2.3.1. Exemple. Cherchons `a d´eterminer toutes les valeurs propres de l’application g´etudi´ee

dans l’exemple 2.1.1. On consid`ere la matrice de g−λId

A−λI2:= 1−λ6

5 2 −λ.

Elle n’est pas de rang maximum si et seulement si les deux lignes sont proportionnelles, autrement

dit si (1 −λ)(2 −λ) = 30. Les valeurs convenables de λsont les solutions de l’´equation du second

degr´e

λ2−3λ−28 = 0.

Ces solutions sont −4 et 7.

Calculons le sous-espace propre E−4(g). C’est l’ensemble des solutions du syst`eme de matrice

A−(−4)I2. Cette matrice est de rang 1, donc E−4(g) est une droite vectorielle engendr´ee par un

de ses vecteurs non nul, par exemple v trouv´e en 2.1.1.

Pour le calcul de E7(g), on r´esout le syst`eme de matrice A−7I2qui est ´egalement de rang 1. Le

sous-espace propre E7(g) est une droite vectorielle engendr´ee par un de ses vecteurs non nul, par

exemple w de coordonn´ees (1,1).

On constate que la famille (v, w) est une base de R2form´ee de vecteurs propres de g.

Dans le cas g´en´eral le calcul du d´eterminant fournit un crit`ere pour d´ecider qu’une matrice carr´ee

est de rang maximum ou pas.

5

2.4. Syst`emes dynamiques lin´eaires discrets.

2.4.1. Exemple. (Voir D. Lay, Alg`ebre lin´eaire et applications). On fait des statistiques sur une

population de chouettes : l’ann´ee n, les populations des femelles poussins, jeunes et adultes, sont

d´esign´ees respectivement par xn,ynet zn. On ´etablit exp´erimentalement les relations suivantes :

xn+1 = 0,33zn(taux de fertilit´e des adultes), yn+1 = 0,18xn(capacit´e `a nicher) et zn+1 = 0,71yn+

0,99zn(les adultes de l’ann´ee n+ 1 sont ceux de l’ann´ee nqui ont surv´ecu et les jeunes de l’ann´ee

nqui sont devenus adultes). On souhaite pr´evoir l’´evolution de la population de chouettes adultes

`a long terme si les param`etres de f´econdit´e, survie, etc. restent les mˆemes.

Si on traite (xn, yn, zn) comme un vecteur de R3on voit que

xn+1

yn+1

zn+1

=

000,33

0,18 0 0

0 0,71 0,99

xn

yn

zn

.

Le probl`eme revient `a calculer les puissances de la matrice

A:=

000,33

0,18 0 0

0 0,71 0,99

.

2.4.2. Exemple. L’exemple le plus c´el`ebre est sans doute celui de Fibonacci (voir Wikipedia :

comparer les articles en anglais et en fran¸cais).

On ´etudie les suites donn´ees par leurs deux premiers termes u0,u1et pour n≥0 par la formule

de r´ecurrence

un+2 =un+1 +un.

On fait une r´eduction classique mais importante. On consid`ere le vecteur

Un=un

un+1

qui est donc d´efini par

U0=u0

u1et, pour n≥0, Un+1 =0 1

1 1 Un.

Il s’agit alors d’´etudier les puissances de la matrice

F:= 0 1

1 1 .

On reviendra sur ces exemples plus tard.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

1

/

27

100%