Algèbres de matrices

LE SÉMINAIRE DE MATHÉMATIQUES

1933–1939

édition réalisée et annotée par

Michèle Audin

1. Année 1933-1934

Théorie des groupes et des algèbres

Jean Dieudonné

Algèbres de matrices

Séminaire de mathématiques (1933-1934), Exposé 1-D, 14 p.

<http://books.cedram.org/MALSM/SMA_1933-1934__1__D_0.pdf>

Cet article est mis à disposition selon les termes de la licence

Creative Commons attribution – pas de modification 3.0 France.

http://creativecommons.org/licenses/by-nd/3.0/fr/

cedram

Exposé mis en ligne dans le cadre du

Centre de diffusion des revues académiques de mathématiques

http://www.cedram.org/

Séminaire de mathématiques 15 janvier 1934

Exposé 1-D, p. 1 à 14

ALGÈBRES DE MATRICES

par Jean Dieudonné

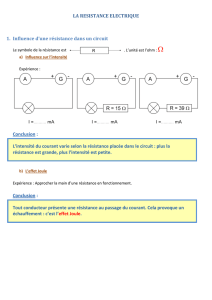

A. Définitions. Anneaux de matrices

1.– Matrices. Soit oun anneau[1] ayant un élément unité. Une matrice de cet anneau

est un tableau de mn éléments de l’anneau :

A=

α11 α12 . . . α1,m

α2,1α2,2. . . α2,m

. . . . . . . . . . . .

αn1αn2. . . αnm

= (αij )

Une matrice est nulle si tous ses éléments sont nuls.

Soient deux matrices Aet Bayant chacune le même nombre de lignes et de co-

lonnes. On pose :

A+B= (αij +βij )

Si λest un nombre de o, le produit λA est défini par :

λA = (λαij )et de même Aλ = (αij λ)

Enfin, soient Aet Bdeux matrices telles que le nombre des colonnes de Asoit égal

au nombre de lignes de B. On appelle alors produit AB la matrice

C= (γhk)où γhk =X

i

αhiβik

Toutes ces définitions s’expliquent d’elles-mêmes quand on considère une matrice

Acomme définissant une substitution linéaire :

U=

m

X

j=1

αij vj(i= 1, . . . , n)

Une telle substitution peut d’ailleurs elle-même s’écrire 1/2

2J. DIEUDONNÉ

U=AVoù U=

u1

u2

.

.

.

un

V=

v1

v2

.

.

.

vn

On déduit immédiatement des définitions les règles suivantes :

A+ 0 = A

A+ (B+C)=(A+B) + C

λ(A+B) = λA +λB

(A+B)λ=Aλ +Bλ

A·BC =AB ·C

A(B+C) = AB +AC

(B+C)A=BA +CA

lorsque les opérations effectuées ont un sens.

Dans la suite de cette conférence, nous ne considérerons plus que des matrices[2]

carrées d’ordre n.

2.–.Toutes les matrices carrées d’ordre ndans un anneau oforment un anneau, l’an-

neau de matrices complet (ou total) sur o.

Cet anneau admet ocomme domaine d’opérateurs à droite et à gauche. Posons :

eij =

0. . . 0

. . . 1. . .

0. . . 0

[le 1 est sur la ième ligne et la jème colonne]

On peut écrire toute matrice sous la forme :

A= (αij ) = Xαij eij =Xeij αij

et inversement. On n’a A= 0 que si αij = 0 quelque soient i,j. Les eij sont dits2/3

éléments de base de l’anneau de matrices par rapport à o.

D’après la règle de multiplication des matrices, on a :

eij ehk = 0 si j6=h

eij ejk =eik

L’anneau de matrices admet un élément unité, la matrice :

1 =

1 0 . . . 0 0

0 1 . . . . . . . . .

0. . . . . . . . . 1

=e11 +e22 +· · · +enn

(1-D) ALGÈBRES DE MATRICES 3

3.–. Supposons maintenant que osoit un corps K. On désigne alors l’anneau de

matrices d’ordre nsur Kpar Kn.

Théorème I. Knest un anneau simple, c’est dire qu’il n’existe pas d’autres idéaux

bilatères que (0) et Knlui-même.[3]

En effet, si aest un tel idéal et aun élément 6= 0 de aon a :

a=X

ij

αij eij

soit maintenant αλµ 6= 0,acontient aussi :

α−1

λµ ehλaeµk =ehk

quels que soient het k, donc a=Kn

Montrons que Knpeut être décomposé en une somme directe d’idéaux à gauche

minima. Il est facile d’avoir ici une telle décomposition :

`1= (e11 +e21 +· · · +en1)est un tel idéal.

3/4

En effet :

ehkei1=(0si k6=i

eh1si k=idonc ehkei1∈`1

par suite aussi :

x`1⊂`1quel que soit x∈Kn

D’autre part `1est minimum, car si a∈`1et a6= 0 soit a=X

i

αiei1et si αλ6= 0,`1

contient aussi

α−1

λehλa=eh1quel que soit h.

Donc tout élément ade `1engendre tout l’idéal, ce qui montre que `1est minima.

Même raisonnement pour :

`k= (e1k[+]e2k[+] · · · [+]enk )

d’où il suit que :

Kn=`1⊕`2⊕ · · · ⊕ `n

somme directe de nidéaux à gauche.

4J. DIEUDONNÉ

B. Théorème fondamental de Macclagan [Maclagen]-Wedderburn

4.–. L’intérêt des anneaux de matrices réside dans le théorème fondamental de

Macclagan-Wedderburn : Toute algèbre simple est isomorphe à un anneau de

matrices sur un corps.

(Rappel de la définition d’une algèbre simple : anneau sans radical satisfaisant à

la condition minimale pour les idéaux à gauche, et n’ayant pas d’autre idéal bilatère

que 0et l’anneau lui-même).

La démonstration que nous allons donner, dûe [sic] à Artin et non publiée, se fait

en deux étapes.4/5

5.– Première partie de la démonstration.

Définition. Un anneau oavec élément unité est dit posséder un système d’unités

matricielles eij (i, j = 1,2, . . . , n)si les eij sont dans oet satisfont aux conditions :

(I)

eij ek` = 0 si j6=k

eij ejk =eik

1 = e11 +e22 +· · · +enn

Théorème. Si un anneau possède un système d’unités matricielles eij il est isomorphe

à l’anneau des matrices d’ordre nà coefficients dans le sous-anneau Kde ocomposé

des éléments de opermutables avec tous les eij .[4]

Formons les éléments de K. Soit x∈o. Posons :

y(x) = X

i

ei1xe1i

yejk =ej1xe1k=ejky

Donc y∈K. Inversement, si y∈Kon a :

X

i

ei1ye1i=X

i

eiiy=y

Ceci posé, à x∈ofaisons correspondre la matrice à coefficients dans K

x= (aij )où aij =y(e1ixej1)

on a x+x0=x+x0

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

1

/

15

100%