La notation de Rogers

UNIVERSITÉ PARIS OUEST NANTERRE LA DÉFENSE

U.F.R. SJAP Année universitaire 2013 – 2014

Master Droit-Éco Cours de M. Desgraupes

Cours de Statistiques et Économétrie

Notation de Rogers-Wilkinson

1 Formule y∼x1+x2+. . . 3

2 Fonction des variables avec la lettre I 3

3 Formule y∼a4

3.1 Variablesfictives .................................. 5

3.2 Casdeplusieursfacteurs .............................. 6

4 Formule y∼a+x7

5 Formule y∼a:x8

6 Formule y∼a∗x9

7 Formule y∼a∗b10

8 Formule y∼a/x 11

9 Formule y∼(a+b)212

10 Compléments 13

Ce document est une présentation des divers aspects de la notation de Rogers et Wilkinson

utilisée pour exprimer des formules de modèles linéaires. C’est la notation utilisée par la fonction

lm de R.

Pour illustrer cette notation par des exemples, on utilise, dans ce document, le jeu de données

appelé CPS1985, disponible dans le package AER de R : il comporte des données recueillies

aux USA lors d’un recensement effectué en 1985 (May 1985 Current Population Survey). Il est

étudié dans : Berndt, E.R. (1991), The Practice of Econometrics, New York, Addison-Wesley.

En supposant que ce package est installé, on charge les données de la manière suivante :

> library(AER)

> data(CPS1985)

> attach(CPS1985)

Il s’agit d’un dataframe comportant 11 variables :

> names(CPS1985)

[1] "wage" "education" "experience" "age"

[5] "ethnicity" "region" "gender" "occupation"

[9] "sector" "union" "married"

1

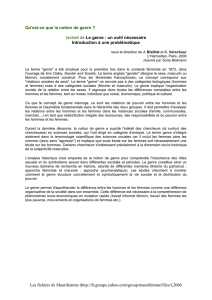

Histogram of wage

wage

Density

0 10 20 30 40

0.00 0.06

Histogram of log(wage)

log(wage)

Density

0 1 2 3

0.0 0.4

FIGURE 1 – Graphique histWage.

Il y a 534 observations et les 11 variables sont toutes de type numérique ou facteur comme on

peut le voir avec la fonction str :

> str(CPS1985)

'data.frame': 534 obs. of 11 variables:

$ wage : num 5.1 4.95 6.67 4 7.5 ...

$ education : num 8 9 12 12 12 13 10 12 16 12 ...

$ experience: num 21 42 1 4 17 9 27 9 11 9 ...

$ age : num 35 57 19 22 35 28 43 27 33 27 ...

$ ethnicity : Factor w/ 3 levels "cauc","hispanic",..: 2 1 1 1 1 1 1 1 1 1 ...

$ region : Factor w/ 2 levels "south","other": 2 2 2 2 2 2 1 2 2 2 ...

$ gender : Factor w/ 2 levels "male","female": 2 2 1 1 1 1 1 1 1 1 ...

$ occupation: Factor w/ 6 levels "worker","technical",..: 1 1 1 1 1 1 1 1 1 1 ...

$ sector : Factor w/ 3 levels "manufacturing",..: 1 1 1 3 3 3 3 3 1 3 ...

$ union : Factor w/ 2 levels "no","yes": 1 1 1 1 1 2 1 1 1 1 ...

$ married : Factor w/ 2 levels "no","yes": 2 2 1 1 2 1 1 1 2 1 ...

NULL

> layout(1:2)

> hist(wage,20, prob=T)

2

> hist(log(wage),20, prob=T)

> lines(density(log(wage)))

> layout(1)

Le graphe représenté sur la figure 1 suggère qu’on obtient une répartition plus proche d’une

distribution normale si on travaille avec le logarithme de la variable wage (salaire).

La notation de Rogers-Wilkinson est utilisée pour spécifier des formules décrivant le type de

modèle recherché. Cette notation a été introduite dans un article de 1973 :

G. N. Wilkinson et C. E. Rogers, Symbolic description of factorial models for analysis of va-

riance, Applied Statistics, 22, p. 392–399.

On a déjà rencontré des exemples du type Y∼Xou Y∼X1+X2+. . . qui correspondent

au modèle ordinaire de régression linéaire univariée ou multivariée entre variables numériques.

Le signe +, comme on l’a déjà vu, a une signification particulière dans cette notation. Il existe

d’autres symboles qui permettent de décrire des situations variées. D’autre part, la régression ne

se limite pas seulement aux variables numériques et peut être étendue aux variables qualitatives,

c’est-à-dire aux facteurs.

Dans les sections qui suivent, les lettres x,y, etc. désignent des variables numériques, les

lettres a,b, etc. désignent des variables de type factor.

1 Formule y∼x1+x2+. . .

C’est la notation du modèle linéaire multivarié qui calcule une relation de la forme :

y=β0+β1x1+β2x2+· · · +ε

et conduit à l’estimation de coefficients de régressions ˆ

βi.

On obtient un terme ˆ

β0(ordonnée à l’origine ou intercept) et un coefficient ˆ

βipour chaque

variable explicative xi.

Par exemple, cherchons à expliquer le log du salaire au moyen de l’éducation et de l’expé-

rience :

> reg <- lm(log(wage) ~ education + experience)

> summary(reg)

Call:

lm(formula = log(wage) ~ education + experience)

Residuals:

Min 1Q Median 3Q Max

-2.03371 -0.33057 0.04223 0.31897 1.83976

Coefficients:

Estimate Std. Error t value Pr(>|t|)

(Intercept) 0.594169 0.124428 4.775 2.33e-06 ***

education 0.096414 0.008310 11.603 < 2e-16 ***

experience 0.011774 0.001756 6.707 5.10e-11 ***

---

Signif. codes: 0 ‘***’ 0.001 ‘**’ 0.01 ‘*’ 0.05 ‘.’ 0.1 ‘ ’ 1

Residual standard error: 0.4695 on 531 degrees of freedom

3

Multiple R-squared: 0.2115, Adjusted R-squared: 0.2085

F-statistic: 71.21 on 2 and 531 DF, p-value: < 2.2e-16

2 Fonction des variables avec la lettre I

Très souvent on obtient de meilleurs résultats en introduisant le carré de l’expérience : on ne

peut pas l’écrire simplement experience^2 car cela a une autre signification dans la notation

de Rogers-Wilkinson (voir plus loin). Pour exprimer une fonction à appliquer à une variable, la

notation introduit la lettre I (i majuscule). On écrira donc le modèle comme ceci :

> reg <- lm(log(wage) ~ education + experience + I(experience^2))

> summary(reg)

Call:

lm(formula = log(wage) ~ education + experience + I(experience^2))

Residuals:

Min 1Q Median 3Q Max

-2.12709 -0.31543 0.00671 0.31170 1.98418

Coefficients:

Estimate Std. Error t value Pr(>|t|)

(Intercept) 0.5203218 0.1236163 4.209 3.01e-05 ***

education 0.0897561 0.0083205 10.787 < 2e-16 ***

experience 0.0349403 0.0056492 6.185 1.24e-09 ***

I(experience^2) -0.0005362 0.0001245 -4.307 1.97e-05 ***

---

Signif. codes: 0 ‘***’ 0.001 ‘**’ 0.01 ‘*’ 0.05 ‘.’ 0.1 ‘ ’ 1

Residual standard error: 0.4619 on 530 degrees of freedom

Multiple R-squared: 0.2382, Adjusted R-squared: 0.2339

F-statistic: 55.23 on 3 and 530 DF, p-value: < 2.2e-16

Le coefficient de détermination ajusté R2

aest meilleur.

3 Formule y∼a

Lorsqu’on explique une variable yau moyen d’un facteur, le modèle linéaire ajuste les valeurs

sur l’espérance dans chaque niveau du facteur. Ces valeurs sont des constantes et le terme β0sert

en fait à décrire l’espérance pour le premier niveau du facteur : tous les niveaux suivants sont

calculés par référence à ce premier niveau.

Par exemple :

> reg <- lm(log(wage) ~ gender)

> summary(reg)

Call:

lm(formula = log(wage) ~ gender)

Residuals:

4

Min 1Q Median 3Q Max

-2.16529 -0.37589 0.00662 0.36855 1.86145

Coefficients:

Estimate Std. Error t value Pr(>|t|)

(Intercept) 2.16529 0.03032 71.411 < 2e-16 ***

genderfemale -0.23125 0.04477 -5.166 3.39e-07 ***

---

Signif. codes: 0 ‘***’ 0.001 ‘**’ 0.01 ‘*’ 0.05 ‘.’ 0.1 ‘ ’ 1

Residual standard error: 0.5155 on 532 degrees of freedom

Multiple R-squared: 0.04776, Adjusted R-squared: 0.04597

F-statistic: 26.69 on 1 and 532 DF, p-value: 3.39e-07

> coefs <- coef(reg)

Ici l’intercept 2.16529 est la moyenne des log des salaires dans la catégorie male tandis que

le coefficient -0.23125 représente la différence du salaire de la catégorie female par rapport à la

valeur précédente : le log des salaires des femmes en espérance est donc calculé comme 2.16529+

−0.23125 = 1.93404.

On retrouve ces résultats avec la fonction by :

> by(log(wage),gender,mean)

gender: male

[1] 2.165286

---------------------------------------------

gender: female

[1] 1.934037

Le niveau de référence est, par défaut, le premier niveau du facteur :

> levels(gender)

[1] "male" "female"

Les facteurs peuvent avoir plus de deux niveaux. On peut, par exemple, effectuer une régres-

sion par rapport aux facteurs sector (3 niveaux) ou occupation (6 niveaux).

Exercice : le faire et expliquer les résultats !

3.1 Variables fictives

Le modèle adopté pour des variables de type factor pourrait s’écrire :

y=β0+δ2x2+δ3x3+· · · +δlxl+ε

où lest le nombre de niveaux du facteur et où les coefficients δ2sont des différences (des deltas)

avec le premier coefficient β0(intercept).

R réalise cela en introduisant des variables fictives xi(dites dummy variables en anglais) où i

varie de 2 à l. Il construit une matrice Bservant de matrice de design pour le modèle. On peut la

visualiser au moyen de la fonction model.matrix :

model.matrix(log(wage) ~ gender)

5

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

1

/

14

100%