Classification d`objets 3D par extraction aléatoire de

Classification d’objets 3D par extraction aléatoire de

sous-parties discriminantes

pour l’étude du sous-sol en prospection pétrolière

François Meunier∗,∗∗ Christophe Marsala∗Laurent Castanié∗∗ Bruno Conche∗∗

∗Sorbonne Universités, UPMC Univ Paris 06,

CNRS, LIP6 UMR 7606, 4 place Jussieu 75005 Paris

∗∗Total Exploration-Production,

Tour Coupole, La Défense, 2 Place Jean Millier, 92078 Paris

Résumé. Dans cet article, nous proposons une nouvelle approche de classifi-

cation d’objets 3D inspirée des Time Series Shapelets de Ye et Keogh (2009).

L’idée est d’utiliser des sous-surfaces discriminantes pour la classification concer-

née afin de prendre en compte la nature locale des éléments pertinents. Cela

permet à l’utilisateur d’avoir connaissance des sous-parties qui ont été utiles

pour déterminer l’appartenance d’un objet à une classe. Les résultats obtenus

confirment l’intérêt de la sélection aléatoire de caractéristiques candidates pour

la pré-sélection d’attributs en classification supervisée.

1 Introduction

Lors du traitement d’éléments complexes, les classifieurs ne donnent généralement pas

de justification permettant de comprendre leurs résultats. Dans le cadre de la classification

supervisée d’objets 3D, cette dernière est très souvent réalisée manuellement par les industriels,

soucieux de comprendre les tenants et aboutissants de leurs études. Cela représente une charge

de travail conséquente, qu’une automatisation de la classification de ces objets 3D faciliterait

grandement, à condition de remplir les contraintes posées par les industriels en termes de

compréhensibilité.

Notre travail se propose de mettre en place un système de classification supervisée d’objets

3D avec justification explicite du résultat fourni. Au sein de ce domaine, les méthodes actuelles

ne permettent pas, sans connaissance préalable, de comprendre quelles sous-parties d’un objet

pourraient être discriminantes dans le cadre de la présence du phénomène étudié, et pourquoi

elles le seraient. Ce problème revient fréquemment en apprentissage, pour lequel la résolution

est perçue du point de vue de l’utilisateur comme une "boite noire" dans laquelle la confiance

ne peut être attribuée que selon ses performances passées. L’intérêt est donc de chercher à

expliquer le résultat de la classification à l’utilisateur afin que celui-ci puisse réellement valider

le modèle et donc l’apport de ce dernier.

Les contraintes du système et donc les conditions d’application de la méthode proposée

sont triples : les éléments d’apprentissage sont des surfaces 3D de maillages triangulaires irré-

guliers ; la classification est basée sur la présence de phénomènes / ensembles de phénomènes

- 225 -

Classification d’objets 3D par extraction de sous-parties discriminantes

locaux ; on se place en apprentissage supervisé dit traditionnel, sans changement de loi de

répartition des classes dans l’ensemble étudié.

Dans cet article, après un état de l’art présenté en Section 2, la méthode proposée est décrite

en Section 3, avant que la Section 4 ne donne les expérimentations réalisées et la Section 5 les

perspectives de cette méthode.

2 Etat de l’art

Avec les méthodes existantes en classification supervisée d’objets 3D, il n’est aujourd’hui

pas possible de catégoriser des objets 3D sur la présence de phénomènes locaux, tout en justi-

fiant le processus et les prédictions.

Des méthodes issues de domaines aussi variés que le traitement d’images ou de séries tempo-

relles présentent des possibilités encore inexploitées dans l’extraction de sous-parties discrimi-

nantes, en utilisant des descripteurs d’objets 3D de la littérature permettant de les caractériser.

2.1 Les descripteurs d’objets 3D

Dans le cas de séries temporelles ou d’images, il est possible de comparer directement

les données des sous-parties extraites (avec la distance euclidienne, par exemple). Pour ce qui

est des objets 3D, comparer directement 2 entités de ce type n’est pas envisageable car, en

plus de devoir établir un alignement selon la translation, la rotation, l’échelle et la réflexion,

il est indispensable de prendre en compte le fait que l’échantillonnage ne correspond pas for-

cément d’un extrait à l’autre. Le calcul de la distance minimale entre chaque point du premier

extrait avec la structure du second n’est possible qu’en présence d’éléments de mêmes éten-

dues. L’étude d’objets 3D, décrits par des maillages non réguliers, nécessite donc d’extraire

d’abord des descripteurs qui ont pour but de convertir les données en une forme exploitable

pour l’apprentissage et la comparaison. Les approches à base de descripteurs de volumes ou

de squelettes d’objets ne s’appliquent pas aux surfaces non fermées (Alexandre (2012)).

Il existe à l’heure actuelle de nombreuses méthodes visant à extraire des descripteurs d’ob-

jets 3D (Dang (2014)). Outre celles de passage de la 3D à la 2D par coupe ou projection,

qui ne s’adaptent pas à notre problème à cause de la trop grande perte de données qui en

découle, la distinction se fait généralement entre les descripteurs locaux et globaux. Les des-

cripteurs globaux ne sont pas adaptés à notre étude, car sur l’ensemble de la structure, ils

perdent les caractéristiques purement locales des sous-parties que Tabia (2011) résume. Les

descripteurs locaux, quant à eux, peuvent être de bons moyens de comparaison entre différents

extraits récupérés car ils s’appliquent à de petites surfaces qui correspondent potentiellement

aux sous-parties discriminantes décrites dans la Section 1. En effet, on ne considère alors que

les tendances dans le voisinage d’un point du maillage, ce qui qui pousse généralement à utili-

ser un histogramme de répartition de valeurs comme Dang (2014) si l’on souhaite décrire toute

une surface comme ont pu le faire Ankerst et al. (1999) avec le Shape Histogram, et Rusu et al.

(2008) avec le PFH (Point Feature Histogram).

Bien que différentes, ces deux ensembles de méthodes, globales et locales, peuvent servir à

définir une surface 3D non fermée, et pour notre étude, elles doivent respecter les conditions

suivantes : une bonne capacité à représenter un prototype de la classe concernée (donc du

- 226 -

François Meunier et al.

phénomène local détécté) ; une robustesse par rapport aux principales transformations géo-

métriques (rotation, translation, passage à l’échelle, ...) ; permettre de caractériser une zone

particulière au sein de l’objet 3D, et de s’en servir pour justifier la classification finale.

2.2 La distance / similarité entre histogrammes de répartition de valeurs

Afin de comparer deux sous-surfaces extraites, l’utilisation d’un descripteur local requiert

l’utilisation d’une distance. Le calcul du descripteur fournit un ensemble de données rassem-

blées dans un histogramme de répartition de valeurs correspondant à chaque point de la surface

retenue. Plusieurs types de distances entre histogrammes peuvent alors être utilisées : la me-

sure de Bhattacharyya (1943), la distance de Matusita (1955), la mesure de Hellinger, du chi2,

ou la divergence de Kullback et Leibler (1951).

2.3 Les "time series shapelets"

Proposée par Refregier (2001), la notion de "shapelets" était initialement appliquée aux

images. La méthode est alors basée sur une décomposition linéaire de chaque image en une

série de fonctions élémentaires décrivant des sous-parties forcément locales ; ces fonctions sont

appelées "shapelets". Concrètement, cela permet, à partir de données complexes, d’obtenir une

version simplifiée de ces données en les décomposant en entités plus simples à étudier.

Cette méthode a par la suite été adaptée aux séries temporelles pour la classification super-

visée par Ye et Keogh (2009). Le principe est d’extraire l’ensemble des sous-parties possibles

de chaque élément de l’ensemble d’apprentissage, puis de déterminer lesquelles scindent le

mieux l’ensemble des éléments, dans le but de maximiser un certain indicateur permettant de

juger de la capacité de discrimination. La méthode classique de maximisation d’entropie re-

tenue par Ye et Keogh (2009), consiste à calculer la distance minimale entre chaque attribut

candidat et chaque objet ; puis, pour chaque candidat, ordonner les objets selon la distance les

séparant de ce dernier ; enfin, évaluer la capacité de discrimination du candidat dont les plus

discriminants servent à scinder l’ensemble des séries temporelles entre les classes.

Cet indicateur, issu des méthodes de selection d’attributs dont Chandrashekar et Sahin (2014)

étudie le domaine et Renard et al. (2016) en applique certaines méthodes aux séries tempo-

relles, permet de déterminer les plus pertinentes des sous-parties. Cette évaluation est réalisée

par le gain d’information (Mutual Information) qui vise à mesurer la dépendance entre 2 va-

riables. Lines et al. (2012) et Hills et al. (2014) utilisent les shapelets (les plus discriminantes)

en calculant la distance minimale qui permet de correspondre au mieux avec les nouveaux élé-

ments à classifier, c’est-à-dire les séries temporelles encore non labellisées. Par la suite, ces

distances deviennent les attributs utilisés pour l’apprentissage et non plus l’arbre de décision

directement. Il devient ainsi possible de ramener le problème à de l’apprentissage supervisé

classique, et donc utiliser d’autres méthodes plus efficaces que les arbres de décision d’ori-

gine. L’avantage évident de la méthode des shapelets appliquée aux séries temporelles est de

pouvoir comparer des éléments de tailles très variées et dont on ne possède pas de connais-

sance a priori (comme le seraient les fonctions élémentaires de la méthode d’origine). Ce ne

sont en effet plus les éléments dans leur globalité qui peuvent être utiles, mais la juxtaposition

de certaines des sous-parties de ces derniers, aux caractéristiques diverses, qui mises ensemble

permettent de déduire les classes d’appartenance.

Parmi les nombreuses optimisations en terme de temps de calcul réalisées dans ce domaine,

- 227 -

Classification d’objets 3D par extraction de sous-parties discriminantes

Renard et al. (2015) utilise une extraction aléatoire de ces sous-parties dans le cadre de la

classification de séries temporelles. En raison de la redondance des sous-parties discriminantes

dans les données ciblées, les performances en termes de classification restent très bonnes.

3 Méthode proposée

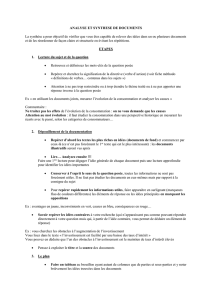

La méthode proposée pour la classification d’objets 3D est à la croisée des différents do-

maines présentés dans la section précédente :

1. les shapelets, notamment la classification supervisée de séries temporelles de Ye et

Keogh (2009) ;

2. les calculs de similarité de surfaces 3D par l’extraction de descripteurs d’objets 3D.

Ces techniques apparaissent comme étant potentiellement complémentaires. En effet, le ba-

layage par fenêtrage de Lozano Vega (2015) d’une image (sous forme d’un rectangle ou d’un

carré extrait de cette image) permet de déterminer quelle partie est la plus intéressante à relever

dans le cadre d’une classification particulière. L’idée initiale de Refregier (2001) permet elle

aussi de tester puis d’extraire les sous-parties les plus discriminantes d’un ensemble cohérent

de données, dans le cadre de la classification souhaitée. Néanmoins, ce qui est envisageable

face à un maillage dont on pouvait établir la liste exhaustive des candidats possibles, car de

forme rectangulaire, et dans un ensemble de tailles possibles prédéfini, pose problème pour

des maillages 3D irréguliers. En effet, nous sommes confrontés à une explosion du temps de

calcul nécessaire à l’extraction et l’évaluation des très nombreux candidats.

Lorsque Renard et al. (2015) propose une recherche aléatoire de sous-parties potentiellement

discriminantes pour la classification de séries temporelles, ses résultats ne sont quasiment pas

dégradés. En effet, en raison de grandes quantités de données, la redondance des extraits dis-

criminants permet de ne pas diminuer la performance de la prédiction, si on la compare au

modèle exhaustif. Cette idée a été adaptée à notre problème, même si dans notre cas une bien

plus faible part des candidats au titre de sous-partie discriminante (l’ordre de grandeur est d’en-

viron 10−6%de l’ensemble, contre 10−1%pour les séries temporelles de Renard et al. (2015))

a été conservée.

Ainsi, nous proposons d’adapter aux objets 3D ce qui a été fait avec les séries temporelles

en classification supervisée, la sélection des sous-parties discriminantes utilisées pour calculer

les attributs d’apprentissage étant réalisée aléatoirement en ne sélectionnant qu’un extrait de

l’ensemble des possibilités.

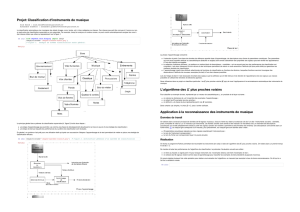

Soient O1, ..., Onl’ensemble des objets labellisés qui constitue la base d’apprentissage.

—∀Oi=1,...,n, on extrait aléatoirement msous-surfaces (pour chaque objet Oi) que sont

Si,1, ...Si,m.

— On considère un descripteur d’objet 3D particulier Desc, et une distance Dist.∀i∈

(1, ..., n)et ∀j∈(1, ..., m), on calcule le descripteur Desc(Si,j )de la sous-surface

Si,j .

Puis, pour chaque sous-surface Si,j à évaluer :

—∀i′∈(1, ..., n)\iet ∀j′∈(1, ..., m), on calcule la proximité P rox(Si,j , Si′,j′) =

Dist(Desc(Si,j ), Desc(Si′,j′)).

- 228 -

François Meunier et al.

— Les degrés correspondant à ses valeurs d’imbrication dans chacun des objets O1, ..., On

valent : ∀i′∈(1, ..., n),

Degre(Si,j , Oi′) = inf

l=1,...,m(P rox(Si,j , Si′,l))

.

Ce degré de matchage ou d’appartenance d’une sous-surface à un objet permet d’établir une

forme de proximité entre la sous-surface étudiée et chaque objet. C’est à partir de ces valeurs

que le score de pertinence de chacune des sous-surfaces est évalué, afin de ne sélectionner que

les plus discriminantes.

Pour l’évaluation de la pertinence de la sous-surface à partir des degrés, et bien que Ye et

Keogh (2009) utilise la méthode du gain d’information pour évaluer les shapelets candidats, il

s’avère qu’une autre méthode de selection d’attributs soit mieux adaptée.

Lines et al. (2012) propose l’utilisation de la formule f-stat, plus performante pour évaluer

le caractère discriminant d’une sous-partie que la méthode classique. Si l’on ajoute à cela un

temps de calcul plus faible, cette formule semble être plus appropriée. Pour une certaine sous-

surface Si,j , dans un problème à Cclasses, on a :

f-stat(Si,j )=

1

C−1

C

X

cl=1

(¯

Dcl −¯

D)2

1

m−C

C

X

cl=1

X

d∈Dcl

(d−¯

Dcl)2

(1)

avec C > 1le nombre de classes, mle nombre de sous-parties (m > C), ¯

Dila moyenne des

degrés entre les surfaces de classe cl et Si,j , et ¯

Dla moyenne des degrés entre les objets 3D de

toutes les classes et Si,j .

Par la suite, les kpremiers candidats selon ce critère seront utilisés pour le calcul des attributs,

k valant expérimentalement environ 10% du nombre total d’extraits.

Il est logique (et les résultats le confirment) de ne pas mettre plus d’attributs que la moitié du

nombre de sous-parties extraites par objet 3D. Cela peut s’expliquer assez aisément par le fait

que si l’on met autant de sous-parties attributs que d’extraits d’un objet 3D, alors les attributs

manqueront de choix dans la sélection de l’extrait le plus proche lors du calcul de distance

entre objet et shapelet candidat.

Une fois les sous-surfaces les plus pertinentes extraites, elles sont utilisées pour, d’une part,

réaliser l’apprentissage sur un modèle de classification supervisé traditionnel (les degrés entre

l’élément d’apprentissage, et chacune des sous-surfaces donnent le vecteur d’attributs), et

d’autre part réaliser le même procédé pour la prédiction de nouveaux objets.

4 Expérimentations

L’algorithme étant adapté à un contexte de classification de grandes structures 3D dont

les éléments permettant cette dernière ne sont que des sous-parties, il est assez compliqué de

trouver un jeu de données correspondant à nos besoins. En effet, la classification supervisée

d’objets 3D répond généralement au besoin de classifier des objets fermés dont l’objet dans son

- 229 -

6

6

7

7

8

8

9

9

10

10

11

11

12

12

1

/

12

100%