Document

Régression linéaire

Nicolas Turenne

INRA

nicolas.turenne@jouy.inra.fr

2005

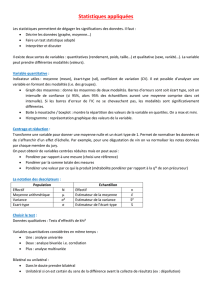

Plan

●Régression linéaire simple

●Régression multiple

●Compréhension de la sortie de la régression

●Coefficient de détermination R2

●Validation du modèle de régression

Un exemple

Questions :

comment relier les dépenses publicitaires aux ventes ?

Quelles sont les ventes espérées si le coût en frais de publicité sont de 2.2 millions ?

Quelle confiance apporter à l'estimation ?

Quel est la qualité de l'ajustement ?

Le modèle fondamental : régression linéaire

Données: (x1,y1),(x2,y2),...,(xn,yn)

Modèle de population: yi = β0 + β1 . xi + εi

ε1, ε2,..., εn sont des variables aléatoires indépendantes, de

distribution normale N(0,σ). Ceci est la vraie relation entre x et y

mais nous ne connaissons pas les paramètres β0 et β1 que nous

devons estimer à partir des données.

Commentaires:

E(yi|xi) = β0 + β1 . xi

SD(yi|xi) = σ

La relation est linéaire – décrite par une droite

β0 = valeur « baseline » de y (quand x vaut 0)

β1 = pente de x (variation de y par rapport à une variation de x)

Comment choisir la ligne qui s'ajuste le mieux aux données ?

Meilleurs choix:

b0=13.82

b1=48.60

Coefficients de régression : b0 et b1 sont des estimations de β0 et β1

Estimation de la régression pour Y à xi:

erreur résiduelle :

La « meilleure » ligne de régression est celle qui choisit b0 et b1 pour

minimiser les erreurs totales (somme des résidus au carré):

yi=b0b1.xi

ei=yi−

yi

SCR=∑

i=1

n

ei

2=∑

i=1

n

yi−

yi2

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

1

/

33

100%