Optimisation de formes par analyse de sensibilité topologique

Introduction et notations

Nous cherchons à résoudre

inf

Ω∈E J(Ω)

où

IEest un ensemble de domaines admissibles (de R2ou R3),

IJ(Ω) est une fonctionnelle de formes.

En optimisation de formes classique,Eest un ensemble de

domaines de même topologie.

En optimisation de formes topologique, la topologie du domaine

n’est pas imposée.

Les problèmes d’optimisation topologique sont en général mal posés

(absence de minimum global).

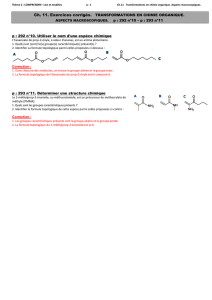

Analyse de sensibillité topologique : savoir où placer des trous.

2 / 34

ANALYSE DE SENSIBILITÉ TOPOLOGIQUE

IΩ⊂Rd,d=2,3

Iω⊂Rd

Iz∈Ω

Iωρ=z+ρω

IΩρ= Ω \ωρ

On cherche un développement asymptotique de la forme

J(Ωρ)− J (Ω) = f(ρ)gΩ(z) + o(f(ρ)).

La fonction gΩest appelée gradient topologique et f(ρ)≥0 est

généralement donnée pour une e.d.p. par les relations suivantes.

CL au bord du trou 2D 3D

Neumann ou transmission ρ2ρ3

Dirichlet −1

ln ρρ

3 / 34

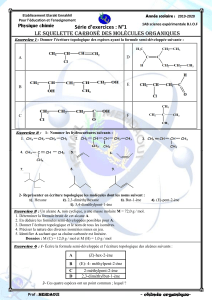

Problème elliptique pour une inclusion

On considère une fonction coût de la forme

J(Ωρ) = Jρ(uρ) =: j(ρ)

où uρest solution de

−div (αρA∇uρ) = σdans Ω

uρ=0 sur ∂Ω

avec Aune matrice SDP et

αρ=α0dans Ω\ωρ

α1dans ωρ

α0, α1>0,constants au voisinage de z.

Pour simplifier la présentation, on suppose α0, α1constants.

4 / 34

On obtient le développement asymptotique

j(ρ)−j(0) = ρdhα0∇u0(z)TPω,r∇v0(z) + δJi+o(ρd).

Les fonctions u0et v0sont les états directs et adjoints pour le

problème non perturbé.

La matrice de polarisation Pω,rest définie par

(Pω,r)ij =Z∂ω

pixjds,

où pi∈H1/2(∂ω)est solution de

r+1

r−1

pi(x)

2+Z∂ω

pi(y)A∇E(x−y).n(x)ds(y) = Aei.n∀x∈∂ω,

avec r=α1

α0

,eile i-ème vecteur de base de Rd,

Ela solution élémentaire de u7→ −div (A∇u).

Le terme complémentaire δJdépend de la fonction coût. 5 / 34

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

1

/

34

100%