Cours8 Fichier

Probabilités Elémentaires – Licence

Chapitre 8 : Intervalles de confiance et tests

Dans le chapitre précédent, nous avons vu comment estimer les paramètres d’une loi de probabilité à

partir d’un échantillon. Malheureusement, cette estimation des paramètres est fortement variable et

il est parfois nécessaire de prendre en compte cette variablilité à travers la construction d’intervalles

de confiance ou de tests statistiques.

1 Intervalles de confiance

Au lieu de se donner une fonction (estimateur) qui donne une estimation ponctuelle d’un paramètre

réel, on cherche un intervalle dans lequel se trouve le paramètre étudié avec une probabilité contrôlée

(et généralement grande).

Définition 1. Soit (X1,··· , Xn)un échantillon aléatoire dont la loi de probabilité dépend du para-

mètre θ∈R. Soit α∈[0,1]. Un intervalle [Φ1(X1,··· , Xn),Φ2(X1,··· , Xn)] est un intervalle de

confiance de θde niveau 1−αsi, pour tout θ∈R,

P(θ∈[Φ1(X1,··· , Xn),Φ2(X1,··· , Xn)]) = 1 −α.

1.1 Méthode de construction

Un principe de construction d’intervalle de confiance consiste à utiliser une statistique pivotale

Tpiv qui dépend à la fois de l’échantillon (X1,··· , Xn)et de θ, mais dont la loi de probabilité est

indépendante de θ. Notons tαle quantile de la loi de Tpiv, i.e. le réel tel que

P(Tpiv ≤tα) = α.

On peut alors écrire

P(tα/2≤Tpiv ≤t1−α/2) = 1 −α

d’où on déduit un intervalle de confiance 1−αpour θpuisque Tpiv est une fonction de θ.

Exemple : On considère le cas où les v.a X1,··· , Xnsont de loi N(µ, σ2), où µest inconnue et σ2

connue. On cherche un intervalle de confiance de niveau 1−αpour µ. On utilise le fait que

¯

X∼ N(µ, σ2/n)et donc Z=¯

X−µ

σ/√n∼ N(0,1).

Si on note Nαle quantile d’ordre αde la loi N(0,1), on peut donc écrire

1−α=P(−N1−α/2≤Z≤N1−α/2) = P(−N1−α/2≤¯

X−µ

σ/√n≤N1−α/2)

=P(−N1−α/2≤µ−¯

X

σ/√n≤N1−α/2) = P(−N1−α/2σ

√n≤µ−¯

X≤N1−α/2σ

√n)

=P(¯

X−N1−α/2σ

√n≤µ≤¯

X+N1−α/2σ

√n).

Un intervalle de confiance de niveau 1−αpour µest :

[BI, BS] = h¯

X−N1−α/2

σ

√n,¯

X+N1−α/2

σ

√ni.

On remarque que la largeur de l’intervalle est une fonction décroissante de αet de n. Si on veut

un intervalle de niveau 1, il nous faut prendre ]− ∞,+∞[, ce qui n’apporte aucune information

sur la valeur du paramètre. Inversement, si on souhaite obtenir un intervalle réduit, il faut accepter

d’augmenter α, le risque que l’intervalle ne contienne pas la paramètre (risque de non recouvrement),

ou bien augmenter n, la taille de l’échantillon.

1

1.2 Intervalle de confiance pour une espérance

On vient de voir comment construire un intervalle de confiance pour l’espérance dans le cas gaussien,

lorsque la variance σ2est connue. Qu’en est-il lorsque celle-ci est inconnue, ce qui est généralement

le cas ?

Définition 2. Soit (X1,··· , Xn)un échantillon aléatoire de loi N(µ, σ2). La loi de probabilité de

la statistique

T=¯

X−µ

S∗/√n

est indépendante de µet de σ2. On la nomme loi de Student à n−1degrés de liberté et on note

T∼tn−1.

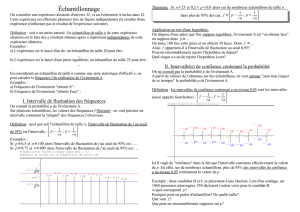

Cette loi de probabilité continue, généralisant la loi normale standard, a été introduite par William

Gosset, chef brasseur de Guinness, ayant pris pour pseudonyme Student. La loi de Student à νdegrés

de liberté est une loi dont la densité est symétrique autour de 0, en forme de cloche et ressemble

à celle d’une N(0,1) un peu "écrasée". Pour de grandes valeurs de ν, la différence entre les deux

densités est négligeable.

Figure 1 – Densités t1,t3,t7,t10,t15,t30 et N(0,1)

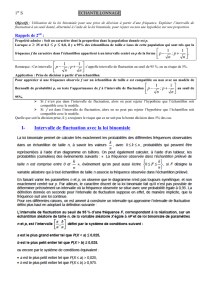

On aura besoin par la suite des quantiles de la loi de Student. Notons tα(ν)le quantile d’ordre αde

la loi de Student à νdegrés de liberté. Par symétrie, t0.5(ν)=0et si 0< α < 1,tα(ν) = −t1−α(ν).

Ces quantiles s’obtiennent dans des tables comme celle-ci.

Pr[T≤x]

ν0.90 0.95 0.975 0.99 0.995

1 3.078 6.314 12.706 31.821 63.657

2 1.886 2.920 4.303 6.965 9.925

3 1.638 2.353 3.182 4.541 5.841

4 1.533 2.132 2.776 3.747 4.604

5 1.476 2.015 2.571 3.365 4.032

6 1.440 1.943 2.447 3.143 3.707

7 1.415 1.895 2.365 2.998 3.499

8 1.397 1.860 2.306 2.896 3.355

9 1.383 1.833 2.262 2.821 3.250

10 1.372 1.812 2.228 2.764 3.169

11 1.363 1.796 2.201 2.718 3.106

12 1.356 1.782 2.179 2.681 3.055

13 1.350 1.771 2.160 2.650 3.012

14 1.345 1.761 2.145 2.624 2.977

15 1.341 1.753 2.131 2.602 2.947

16 1.337 1.746 2.120 2.583 2.921

17 1.333 1.740 2.110 2.567 2.898

18 1.330 1.734 2.101 2.552 2.878

19 1.328 1.729 2.093 2.539 2.861

20 1.325 1.725 2.086 2.528 2.845

21 1.323 1.721 2.080 2.518 2.831

22 1.321 1.717 2.074 2.508 2.819

23 1.319 1.714 2.069 2.500 2.807

24 1.318 1.711 2.064 2.492 2.797

25 1.316 1.708 2.060 2.485 2.787

26 1.315 1.706 2.056 2.479 2.779

27 1.314 1.703 2.052 2.473 2.771

28 1.313 1.701 2.048 2.467 2.763

29 1.311 1.699 2.045 2.462 2.756

30 1.310 1.697 2.042 2.457 2.750

∞1.282 1.645 1.960 2.326 2.576

On peut donc écrire

P−t1−α/2(n−1) ≤¯

X−µ

S∗/√n≤t1−α/2(n−1)= 1 −α

2

et on en déduit, de la même manière que précédemment, qu’un intervalle de confiance de niveau

1−αpour µ(quand σ2est inconnue) est donné par :

[BI, BS] = h¯

X−t1−α/2(n−1) S∗

√n,¯

X+t1−α/2(n−1) S∗

√ni.

Remarque : Si la loi des Xin’est pas gaussienne, les intervalles précédents restent approximativement

corrects grâce au théorème limite central. Cette approximation est d’autant meilleure que nest grand

et que la loi des Xiest proche de la loi normale.

1.3 Intervalle de confiance pour une variance

On se place à nouveau dans le cadre gaussien et on cherche un intervalle de confiance pour σ2.

Considérons d’abord le cas où l’espérance µest connue.

Proposition 1. Soit (X1,··· , Xn)un échantillon aléatoire de loi N(µ, σ2). La statistique

Pn

i=1(Xi−µ)2

σ2

suit une loi du chi-deux à ndegrés de liberté.

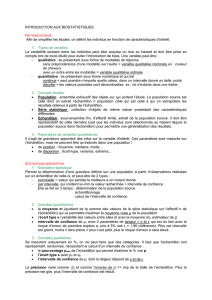

On aura besoin par la suite des quantiles de la loi du chi-deux. Notons χα(ν)le quantile d’ordre α

de la loi du chi-deux à νdegrés de liberté. Ces quantiles s’obtiennent dans des tables comme celle-ci.

P(χ2≤x)

ν0.01 0.025 0.05 0.95 0.975 0.99

1 0.000 0.001 0.004 3.841 5.024 6.635

2 0.020 0.051 0.103 5.991 7.378 9.210

3 0.115 0.216 0.352 7.815 9.348 11.345

4 0.297 0.484 0.711 9.488 11.143 13.277

5 0.554 0.831 1.145 11.070 12.833 15.086

6 0.872 1.237 1.635 12.592 14.449 16.812

7 1.239 1.690 2.167 14.067 16.013 18.475

8 1.646 2.180 2.733 15.507 17.535 20.090

9 2.088 2.700 3.325 16.919 19.023 21.666

10 2.558 3.247 3.940 18.307 20.483 23.209

11 3.053 3.816 4.575 19.675 21.920 24.725

12 3.571 4.404 5.226 21.026 23.337 26.217

13 4.107 5.009 5.892 22.362 24.736 27.688

14 4.660 5.629 6.571 23.685 26.119 29.141

15 5.229 6.262 7.261 24.996 27.488 30.578

16 5.812 6.908 7.962 26.296 28.845 32.000

17 6.408 7.564 8.672 27.587 30.191 33.409

18 7.015 8.231 9.390 28.869 31.526 34.805

19 7.633 8.907 10.117 30.144 32.852 36.191

20 8.260 9.591 10.851 31.410 34.170 37.566

21 8.897 10.283 11.591 32.671 35.479 38.932

22 9.542 10.982 12.338 33.924 36.781 40.289

23 10.196 11.689 13.091 35.172 38.076 41.638

24 10.856 12.401 13.848 36.415 39.364 42.980

25 11.524 13.120 14.611 37.652 40.646 44.314

26 12.198 13.844 15.379 38.885 41.923 45.642

27 12.879 14.573 16.151 40.113 43.195 46.963

28 13.565 15.308 16.928 41.337 44.461 48.278

29 14.256 16.047 17.708 42.557 45.722 49.588

30 14.953 16.791 18.493 43.773 46.979 50.892

On peut donc écrire

Pχα/2(n)≤Pn

i=1(Xi−µ)2

σ2≤χ1−α/2(n)= 1 −α

et on en déduit, de la même manière que précédemment, qu’un intervalle de confiance de niveau

1−αpour σ2(quand µest connue) est donné par :

[BI, BS] = hPn

i=1(Xi−µ)2

χ1−α/2(n),Pn

i=1(Xi−µ)2

χα/2(n)i.

Lorsque l’espérance µn’est pas connue, on utilise la propriété suivante, que nous admettrons.

Proposition 2. Soit (X1,··· , Xn)un échantillon aléatoire de loi N(µ, σ2). La statistique

Pn

i=1(Xi−¯

X)2

σ2=(n−1)S∗2

σ2

suit une loi du chi-deux à n−1degrés de liberté.

3

On peut donc écrire

Pχα/2(n−1) ≤(n−1)S∗2

σ2≤χ1−α/2(n−1)= 1 −α

et on en déduit, de la même manière que précédemment, qu’un intervalle de confiance de niveau

1−αpour σ2(quand µest inconnue) est donné par :

[BI, BS] = h(n−1)S∗2

χ1−α/2(n−1),(n−1)S∗2

χα/2(n−1)i.

Remarque : Contrairement aux intervalles de confiance précédemment construits pour l’espérance,

ceux pour la variance ne sont pas symétriques par rapport à l’estimateur ponctuel, S∗2. Cela provient

du fait que la loi du χ2n’a pas une densité symétrique.

1.4 Intervalles de confiance unilatéraux

Jusqu’à présent, nous avons construit uniquement des intervalles de confiance bilatéraux et symé-

triques, c’est-à-dire que l’on a "raboté" α/2à gauche et à droite pour obtenir une probabilité de

recouvrement égale à 1−α. Néanmoins, il est possible de construire des intervalles de confiance

asymétriques, voire unilatéraux. Si on reprend le premier exemple traité, celui de l’espérance d’une

loi normale de variance connue, on peut écrire

1−α=P(Z≤N1−α) = P(¯

X−µ

σ/√n≤N1−α)

=P(−N1−α≤µ−¯

X

σ/√n) = P(−N1−ασ

√n≤µ−¯

X)

=P(¯

X−N1−ασ

√n≤µ).

Un intervalle de confiance unilatéral de niveau 1−αpour µest :

[BI, BS] = h¯

X−N1−α

σ

√n,+∞i.

2 Décision statistique

2.1 Généralités

La théorie de l’estimation permet d’obtenir des estimations ponctuelles ou par intervalle qui affinent

l’information tirée de l’échantillon concernant la valeur de la caractéristique d’intérêt de la popula-

tion. La théorie de la décision statistique aide à la prise de décision dans un contexte aléatoire. Le

cadre de travail suppose que cette décision dépend de la valeur d’une caractéristique d’intérêt de la

population. Or on ne dispose que de l’information incertaine obtenue d’un échantillon. On va voir

que cet échantillon peut être utilisé pour "tester" la valeur de la caractéristique de la population. Le

résultat de cette action indique la décision à prendre, tout en contrôlant les risques d’une mauvaise

décision.

2.2 Hypothèses statistiques

Dans la vie courante, la prise de décisions se base sur des conjectures faites par un décideur sur la

réalité d’une situation qu’il ne connaît pas complètement. En Statistique, ces conjectures sont des

hypothèses sur la loi de v.a {X1,··· , Xn}devant être mesurées sur les individus d’un échantillon issu

d’une population. Au départ, le décideur entretient une conjecture privilégiée concernant cette loi.

L’hypothèse nulle est cette conjecture privilégiée. C’est celle que le décideur ne lâchera pas sans

un sérieux doute sur sa validité. On la note H0. L’hypothèse nulle est confrontée à une conjecture qui

la contredit, appelée hypothèse alternative. On la note H1. Le décideur fera sienne l’hypothèse

H1s’il réussit à sérieusement mettre en doute la validité de H0.

Dans ce cours, on se contentera d’étudier des tests dont les hypothèses considérées se rapportent

aux paramètres : on parle de tests paramétriques.

Exemple : Une usine fabrique des boulons, dont le diamètre théorique est 10mm. En réalité, on

considère que X, la v.a. représentant le diamètre d’un boulon pris au hasard, suit une loi N(µ, σ2),

4

où µ=µ0= 10mm si la ligne de production est bien réglée. Pour vérifier que ces réglages sont

bons, l’industriel prélève nboulons au hasard et mesure leur diamètre X1,··· , Xn. Son hypothèse

nulle, H0, est que tout va bien : "µ=µ0". Son hypothèse alternative est qu’il y a un problème :

"µ=µ16=µ0".

2.3 Risques d’erreurs

Un test d’hypothèses (ou simplement un test) est une procédure consistant, au vu d’un échantillon,

à rejeter ou non H0. On rejette H0(au profit de H1) si les données mettent en doute H0. Ce faisant,

on peut se tromper de deux façons :

– Rejeter H0alors que H0est vraie : c’est l’erreur de première espèce.

– Ne pas rejeter H0alors que H0est fausse : c’est l’erreur de seconde espèce.

La probabilité de commettre ces erreurs s’appelle le risque. Il y 2 risques :

– Le risque de première espèce = probabilité de commettre une erreur de 1ère espèce.

– Le risque de seconde espèce = probabilité de commettre une erreur de 2ème espèce.

Un bon test d’hypothèses doit minimiser ces 2 risques. Malheureusement, les risques de première

et de seconde espèce sont antagonistes : on ne peut pas les minimiser simultanément. La stratégie

consiste alors à fixer une borne supérieure α, appelée le niveau, au risque de première espèce (souvent

le plus lourd de conséquences), puis à minimiser le risque de seconde espèce, noté β. De manière

équivalente, on cherchera à maximiser la puissance du test, 1−β.

Un test est de niveau αsi la procédure qui le définit assure que la probabilité de rejeter H0alors

que H0est vraie (risque de première espèce) ne dépasse pas α. Cette stratégie offre parfois une façon

de poser en pratique H0et H1puisque rejeter H0à tort est l’erreur dont on veut contrôler le risque.

Le risque de seconde espèce (= probabilité que le test ne rejette pas H0alors que H0est fausse) est

une quantité souvent plus complexe à calculer (et dont les conséquences sont souvent moindres que

le risque de première espèce).

Exemple : Reprenons l’exemple précédent. L’industriel n’a aucune raison a priori de supposer que

sa ligne de production est mal réglée. De plus, s’il arrête la production alors que sa machine est bien

réglée, cela lui coûtera beaucoup d’argent. Il veut donc limiter le risque que cela arrive à une valeur

très faible, par exemple α= 1%.

Pour décider de rejeter ou non H0, on va se baser sur une statistique de test Wqui dépend bien

sûr de l’échantillon X1,··· , Xn. La règle de décision est la suivante : si la valeur observée de W

appartient à la zone de rejet, qui dépend de α, on rejettera H0.

2.4 Tests concernant l’espérance

2.4.1 Variance connue

On rappelle que si ¯

Xest la moyenne d’un échantillon de nv.a. {X1,··· , Xn}indépendantes de loi

N(µ, σ2)alors

¯

X∼ N(µ, σ2/n)et Z=√n¯

X−µ

σ∼ N(0,1).

Considérons le problème de tester au niveau αl’hypothèse H0:µ=µ0contre l’hypothèse H1:µ6=

µ0. Pour construire le test, on raisonne comme suit : si H0est vraie, ¯

Xa pour espérance µ0et on

serait surpris d’observer une valeur ¯xtrès différente de µ0. On choisit donc comme statistique de

test

W=√n¯

X−µ0

σ

qui, sous l’hypothèse H0suit une loi N(0,1). L’échantillon met en doute H0si w=√n¯x−µ0

σ<−c

ou w > c, où cest une borne à déterminer. En prenant c=N1−α/2, on définit un test de niveau α.

En effet, si H0est vraie,

P(rejeter H0à tort) = P(Z < −N1−α/2ou Z > N1−α/2)

=P(Z < −N1−α/2) + P(Z > N1−α/2) = α/2 + α/2 = α.

5

6

6

7

7

8

8

1

/

8

100%