CM 1 à 4

L

Li

ic

ce

en

nc

ce

e

2

2

C

Co

og

gn

ni

it

ti

io

on

n

&

&

m

mo

ot

tr

ri

ic

ci

it

té

é

_

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

__

_

2

20

00

04

4

–

–

2

20

00

05

5

Y

Yv

ve

es

s

K

Ke

er

rl

li

ir

rz

zi

in

n

Plan du cours

********

I

In

nt

tr

ro

od

du

uc

ct

ti

io

on

n,

,

d

dé

éf

fi

in

ni

it

ti

io

on

ns

s

I

I-

-

R

Ra

ap

pp

pe

el

ls

s

s

su

ur

r

l

le

e

c

ce

er

rv

ve

ea

au

u

A

A-

-

C

Ca

ar

ra

ac

ct

té

ér

ri

is

st

ti

iq

qu

ue

es

s

B

B-

-

L

L'

'e

ex

xi

is

st

te

en

nc

ce

e

d

d'

'u

un

ne

e

n

ne

eu

ur

ro

og

ge

en

nè

ès

se

e

C

C-

-

D

Dé

ét

te

er

rm

mi

in

ni

is

sm

me

e

g

gé

én

né

ét

ti

iq

qu

ue

e

e

et

t

é

ép

pi

ig

ge

en

nè

ès

se

e

D

D-

-

L

La

a

t

th

hé

éo

or

ri

ie

e

d

du

u

d

dé

év

ve

el

lo

op

pp

pe

em

me

en

nt

t

d

du

u

s

sy

ys

st

tè

èm

me

e

n

ne

er

rv

ve

eu

ux

x

p

pa

ar

r

é

ép

pi

ig

ge

en

nè

ès

se

e

E

E-

-

L

La

ab

bi

il

li

it

té

é

e

et

t

d

dé

ég

gé

én

né

ér

re

es

sc

ce

en

nc

ce

e

s

sy

yn

na

ap

pt

ti

iq

qu

ue

es

s

F

F-

-

P

Pl

la

as

st

ti

ic

ci

it

té

é

d

du

u

s

sy

ys

st

tè

èm

me

e

n

ne

er

rv

ve

eu

ux

x

e

et

t

p

pé

ér

ri

io

od

de

es

s

c

cr

ri

it

ti

iq

qu

ue

es

s

I

II

I-

-

C

Co

on

nn

na

ai

is

ss

sa

an

nc

ce

e

d

du

u

c

ce

er

rv

ve

ea

au

u

U

Un

n

p

pe

eu

u

d

d'

'h

hi

is

st

to

oi

ir

re

e

A

A)

)-

-

U

Un

ne

e

a

ap

pp

pr

ro

oc

ch

he

e

i

in

nt

tu

ui

it

ti

iv

ve

e

B

B)

)-

-

A

Ap

pp

pr

ro

oc

ch

he

e

e

ex

xp

pé

ér

ri

im

me

en

nt

ta

al

le

e

C

C)

)-

-

I

Im

ma

ag

ge

er

ri

ie

e

c

cé

ér

ré

éb

br

ra

al

le

e

c1)- La tomographie par émission de positons

Intérêt médical de la Tomographie par émission de positons

c2) L'imagerie par résonance magnétique

Imagerie par résonance magnétique fonctionnelle

c3) L'électroencéphalographie

c4) La magnétoencéphalographie

c5) Bilan et conclusion

I

II

II

I-

-

L

L'

'a

at

tt

te

en

nt

ti

io

on

n

I

In

nt

tr

ro

od

du

uc

ct

ti

io

on

n,

,

d

dé

éf

fi

in

ni

it

ti

io

on

ns

s

A

A-

-

A

At

tt

te

en

nt

ti

io

on

n

e

et

t

v

vi

ig

gi

il

la

an

nc

ce

e

B

B-

-

D

Dé

ét

te

ec

ct

ti

io

on

n

e

et

t

d

di

is

sc

cr

ri

im

mi

in

na

at

ti

io

on

n

d

d'

'u

un

n

s

si

ig

gn

na

al

l

C

C-

-

T

Th

hé

éo

or

ri

ie

e

d

de

e

l

la

a

d

dé

ét

te

ec

ct

ti

io

on

n

d

du

u

s

si

ig

gn

na

al

l

e

et

t

p

pr

ra

at

ti

iq

qu

ue

e

s

sp

po

or

rt

ti

iv

ve

e

D

D-

-

L

Le

es

s

t

th

hé

éo

or

ri

ie

es

s

c

co

og

gn

ni

it

ti

iv

ve

es

s

d

de

e

l

l'

'a

at

tt

te

en

nt

ti

io

on

n

a) L'hypothèse du canal unique de traitement

b) Théorie du filtrage

c) Filtre sélectif précoce de Broadbent

d) D'autres filtres sélectifs plus tardifs

e) Des ressources multiples

f) Le paradigme de la double tâche

E

E-

-

O

Or

ri

ie

en

nt

ta

at

ti

io

on

n

v

vi

is

su

ue

el

ll

le

e

e

en

n

s

sp

po

or

rt

t

Emprunts, références, sources

Cognition & Motricité -1- Yves Kerlirzin

__________________________________________________________________________________________

I

In

nt

tr

ro

od

du

uc

ct

ti

io

on

n,

,

d

dé

éf

fi

in

ni

it

ti

io

on

ns

s

La cognition peut se définir par l'ensemble de processus mentaux comprenant l'acquisition, le

stockage, la transformation et l'utilisation des connaissances. Ces processus mentaux sont par

exemple la perception, la mémorisation, le raisonnement, le traitement de l'information, la

résolution de problèmes, la prise de décision, etc.

Ces processus mentaux sous-tendent la réalisation d'habiletés motrices complexes et

notamment les habiletés motrices sportives. Cognition et motricité sont donc intimement liées,

que ce soit dans la vie au quotidien ou lors de la pratique d'activités physiques et sportives, et le

cerveau joue un rôle tout à fait central et essentiel dans le déroulement de ces activités

cognitives et motrices. Il assure au quotidien les différentes fonctions permettant l'adaptation

de l'individu à son environnement, que cet individu soit sédentaire ou très actif, sportif.

I

I-

-

R

Ra

ap

pp

pe

el

ls

s

s

su

ur

r

l

le

e

c

ce

er

rv

ve

ea

au

u

A

A-

-

C

Ca

ar

ra

ac

ct

té

ér

ri

is

st

ti

iq

qu

ue

es

s

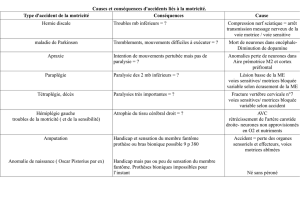

Le cerveau se caractérise par son extrême complexité. Il comprend environ 1012, soit cent

milliards de cellules nerveuses (les cellules gliales, terme qui pourrait se traduire par l'idée de

glu, et les neurones), pèse chez l'adulte environ 1400g (300g à la naissance environ) pour un

volume d'environ 1200 cm3.

L'unité fonctionnelle du système nerveux, le neurone, assure l'émission et la propagation du

message nerveux sous forme de signaux électriques (potentiels d'action). De ces neurones

partent deux types de prolongements, l'axone et les dendrites.

Cognition & Motricité -2- Yves Kerlirzin

__________________________________________________________________________________________

Neurone complet - Otto Deiters - 1865 Structure du neurone. D'après Bear et al., 2002

L'accroissement de masse du cerveau coïncide avec la poussée des axones et des dendrites.

Le corps cellulaire reçoit un ou plusieurs prolongements assez courts appelés "dendrites". Ces

dendrites sont les organes récepteurs du neurone, ceux qui conduisent l'influx vers le corps

cellulaire. Celui-ci émet par ailleurs un prolongement en général long par où part l'influx : l'axone.

Certains neurones ont des axones de plus de 50 cm.

Les neurones assurent la transmission de l'information (influx nerveux, message nerveux) par

des liaisons (synapses) reliant chacun d'eux à un ou plusieurs autres neurones. Cette transmission

est à la fois électrique (à l'intérieur du neurone) et chimique (à la sortie du neurone) se

traduisant par la libération d'un neurotransmetteur (une substance chimique comme l'adrénaline

par exemple) qui provoque une réaction électrique dans le neurone récepteur.

Le terme synapse fut forgé en 1897 par un helléniste, à la demande de Sherrington,

physiologiste anglais, afin de donner un nom (dont la traduction française pourrait être «agrafe»)

à un concept plus qu’à l’image d’une réalité reconnue. En effet, à cette époque, plus d’un

cytologiste (cyto = cellule) niait l’individualité cellulaire du neurone et croyait à la continuité et

non à la contiguïté des liaisons interneuronales, à l'existence en quelque sorte d'un véritable

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

1

/

75

100%