Guide d`achat sur l`intégration du Big Data

Guide d'achat

sur l'intégration

du Big Data

SEPTEMBRE 2013

Commandité par

CITO Research

Advancing the craft of technology leadership

Sommaire

Introduction 1

Les enjeux de l'intégration du Big Data:

hier et aujourd'hui 1

Fonctionnalités nécessaires à l'intégration

du Big Data 3

Architecture technologique privilégiée 6

Les fruits d'une intégration réussie

du Big Data 7

1

Guide d’achat sur l’intégration du Big Data

CITO Research

Advancing the craft of technology leadership

Introduction

Le phénomène de «Big Data», autrement dit l'émergence de nouveaux types de données

dans des volumes toujours plus impressionnants, pousse les directeurs informatiques et

les dirigeants à repenser leur portefeuille technologique. Plutôt que d'élaborer leur propre

infrastructure, la plupart des entreprises préfèrent l'acheter. Mais comment faire le bon

choix? Et comment obtenir un ensemble cohérent?

La nécessité d'une nouvelle technologie représente le premier dé du Big Data. Cela ne

signie pas que tous les autres types de données et de technologies soient obsolètes.

Hadoop, les bases de données NoSQL, les bases de données analytiques et les entrepôts

de données cohabitent sans problème. Les analystes ne se soucient pas de l'origine des

données: ils les passeront à la moulinette, quelle que soit leur source.

L'intégration des données constitue le second dé. Comment faire en sorte que la nouvelle

technologie de traitement du Big Data utilise les données et les technologies existantes?

Comment améliorer les données et les technologies existantes en y ajoutant le Big Data?

Etcomment permettre aux nouvelles formes d'analytique et aux applications d'exploiter à

la fois les nouvelles et les anciennes données?

D'après CITO Research, les directeurs informatiques et les dirigeants ont tout intérêt à intégrer

le nouvel univers du Big Data avec l'ancien monde de la BI an d'accélérer le progrès. Le présent

guide d'achat vous aidera à acheter la technologie adéquate pour l'intégration du Big Data.

Les enjeux de l'intégration du Big Data:

hier et aujourd'hui

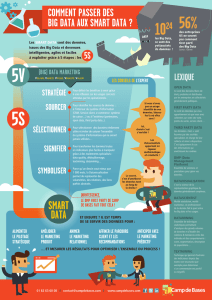

Les passionnés de Big Data sont conscient des diérences entre ce phénomène et les

anciennes générations de données. Elles se résument souvent en trois mots, les «3V»:

volume, variété, vitesse. Ce concept a été introduit par Doug Laney, analyste chez Gartner,

pour décrire le phénomène Big Data.

La diculté consiste à trouver un référentiel capable de traiter d'énormes volumes de données.

L'analyse de ux de données issues de machines, de serveurs et d'appareils mobiles, parfois

appelé « Internet des objets », est problématique. L'écosystème Hadoop a été conçu pour

traiter le volume et la variété de ces données, mais de nombreux produits tels que Splunk sont

également en mesure d'absorber de grandes quantités de Big Data orienté machine.

De plus, les données générées automatiquement exigent souvent de nouvelles techniques

d'exploration et d'analyse, ce qui représente un dé supplémentaire. La majeure partie du

Big Data est non structurée. Par ailleurs, des documents en texte brut et des vidéos s'ajoutent

aux types de données. L'apprentissage automatique, l'analyse de textes ou de vidéos et une

multitude d'autres techniques, appliquées aux données dans Hadoop ou dans des bases de

données NoSQL et analytiques permettent de donner du sens à des données désordonnées.

Une fois ces dés relevés, les tâches liées à l'utilisation du Big Data ressemblent étrangement

à celles qui concernaient les données existantes (voir «Dés communs au Big Data et aux

données existantes»).

2

Guide d’achat sur l’intégration du Big Data

CITO Research

Advancing the craft of technology leadership

Défis communs au Big Data et aux données existantes

Fusion de données provenant de sources distinctes

Prise en charge de l'exploration

Création d'une version unique et réutilisable de la vérité

Structuration d'ensembles de données fusionnées pour une analytique

plus exhaustive

Développement de l'utilisation des données

Création d'environnements analytiques avancés

Prise en charge des applications

Contrôle des accès

Gestion du cycle de vie de l'analytique

Mise en conformité

L'équation applicable à la gestion du Big Data ressemble à ceci:

(Référentiel pour le stockage et le traitement du Big Data) +

(Nouvelles techniques d'analyse du Big Data) + (BI existante)

= Environnement Big Data intégré

S'il est certain que le Big Data révolutionne de nombreux aspects de la BI, celle-ci n'en

devient pas obsolète pour autant. Autrement dit, la voie à suivre pour intégrer le Big Data

consiste sans doute à recourir à des solutions d'intégration de données existantes qui ont

été adaptées en vue d'incorporer le Big Data.

De plus, il convient de diérencier la validation d'un concept et l'opérationnalisation du Big

Data. Une technologie d'intégration du Big Data doit non seulement permettre de réaliser une

expérience scientique, mais elle doit également gérer l'intégralité du cheminement vers la

pleine utilisation du Big Data, conjointement avec les applications et systèmes de BI existants.

3

Guide d’achat sur l’intégration du Big Data

CITO Research

Advancing the craft of technology leadership

Du modèle en étoile à la chaîne d'approvisionnement de données

Le mariage du Big Data avec la BI existante entraînera un changement conceptuel considérable.

L'entrepôt de données ne sera plus au centre de l'univers. De nombreux référentiels spécialisés

prendront en charge les applications ou les nouvelles formes d'analyse. En outre, les données

proviendront de plus en plus souvent de sources externes à l'entreprise par l'intermédiaire d'API.

Au lieu du modèle en étoile, au centre duquel se trouve l'entrepôt de données, l'infrastructure de

traitement des données ressemblera davantage à une chaîne d'approvisionnement distribuée.

Le Big Data est le principal moteur de ce nouveau modèle, et son intégration est la clé de

son fonctionnement. Les directeurs informatiques et les dirigeants soucieux d'exploiter

rapidement le Big Data et la BI existante ont tout intérêt à acquérir les fonctionnalités

suivantes, qui formeront la base d'une nouvelle chaîne d'approvisionnement de données.

Fonctionnalités nécessaires à l'intégration

du Big Data

Pour opérer les bons choix quant à l'assemblage des composants d'un système d'intégration

du Big Data, rééchissez à ce dont vous avez besoin. La plupart des entreprises nécessitent

les fonctionnalités suivantes pour prendre en charge l'intégration du Big Data.

Connexion, transport et transformation

L'accès aux données, leur déplacement et leur transformation sont au cœur de plusieurs

générations de technologies d'intégration des données. L'intégration du Big Data change

la donne.

L'accès aux données via Hadoop ou via des bases de données NoSQL et analytiques doit

être pris en charge. Il est primordial de pouvoir dénir ou découvrir un schéma.

La technologie moderne d'intégration de données doit être déployée à la fois dans des

modèles Cloud et sur site.

La synchronisation des données entre référentiels est indispensable à mesure que la

chaîne d'approvisionnement des données se complexie. La technologie d'intégration

des données devra proposer des mécanismes de transfert capables de gérer les nouveaux

volumes. Les informations issues de l'analyse du Big Data doivent être fournies aux

applications an que des modèles plus détaillés de la réalité soient disponibles. Par exemple,

plutôt que de se limiter aux bases de données SQL, les données seront synchronisées à l'aide

d'une technologie d'analytique en mémoire.

La capacité à transformer les données demeure une fonctionnalité cruciale. Les outils

doivent simplier au maximum la conception et la mise en œuvre des transformations.

Pour pouvoir remplir leurs fonctions, les analystes doivent être en mesure de combiner et

d'extraire des données de sources très variées. Ce travail a lieu en grande partie dans la couche

d'intégration des données. Les transformations doivent pouvoir être réutilisées et partagées.

L'intégration du Big Data implique la possibilité de traiter des ux de données en temps

réel en provenance de systèmes de messagerie, de bus de services d'entreprise et de chiers

journaux de serveurs.

Bien que la

technologie

d'intégration

actuelle propose

de nombreuses

fonctionnalités

permettant d'accéder

aux données, de les

déplacer et de les

transformer, le Big

Data introduit de

nouvelles exigences.

6

6

7

7

8

8

9

9

1

/

9

100%