Syllabus - Département d`informatique et de recherche opérationnelle

Modèles de Recherche Opérationnelle

Fabian Bastin

Département d’Informatique et de Recherche Opérationnelle

Université de Montréal

IFT-1575

Hiver 2010

http://www.iro.umontreal.ca/~bastin

La présente version du syllabus s’inspire des notes de Patrice Marcotte, Bernard Gendron, ainsi que des livres

Introduction to Operational Research [1] et The Basics of Practical Optimization [3].

Le présent document peut être modifié et redistribué à des fins non commerciales, sous conditions d’être diffusé

sous les même conditions.

Photographie de couverture: viaduc de Millau, France.

c

Fabian Bastin, 2006

Table des matières

1 Introduction 1

1.1 Les origines de la recherche opérationnelle . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1

1.2 La nature de la recherche opérationnelle . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1

1.3 Modélisation ................................................. 2

1.4 Algorithmesetlogiciels ........................................... 5

1.4.1 UnexempleavecGAMS....................................... 5

1.5 Notes ..................................................... 6

2 Programmation linéaire 7

2.1 Introduction.................................................. 7

2.2 Modèle général de programmation linéaire . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 9

2.3 Terminologiedebase............................................. 10

2.4 Hypothèses .................................................. 11

2.5 Laméthodedusimplexe........................................... 16

2.5.1 Solutiondebase ........................................... 17

2.5.2 Interprétations ............................................ 19

2.5.3 Critèred’optimalité ......................................... 20

2.5.4 Adaptation à d’autres formes de modèles . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 23

2.5.5 Obtention d’une base admissible initiale . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 23

2.5.6 Variables à valeurs quelconques . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 25

2.6 Dualité .................................................... 25

2.6.1 Motivation .............................................. 25

2.6.2 Analysedesensibilité ........................................ 27

2.7 Notes ..................................................... 29

3 Programmation non linéaire 31

3.1 Fonctionsconvexesetconcaves ....................................... 31

3.1.1 Ensemblesconvexes ......................................... 32

3.2 Algorithmes.................................................. 35

3.2.1 L’algorithme du simplexe dans le cas non-linéaire . . . . . . . . . . . . . . . . . . . . . . . . . 35

3.2.2 Optimisationsanscontrainte .................................... 36

3.2.3 Méthodedelabissection....................................... 36

3.2.4 Méthodedugradient......................................... 37

3.2.5 Optimisation sous contraintes . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 38

3.2.6 Conditionsd’optimalité ....................................... 38

3.3 Notes ..................................................... 40

4 Programmation mixte entière 41

4.1 Présentationgénérale............................................. 41

4.2 Contraintes mutuellement exclusives . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 44

4.2.1 Deuxcontraintes........................................... 44

4.2.2 Kcontraintes parmi N....................................... 45

4.2.3 Fonction ayant Nvaleurspossibles................................. 45

iii

iv TABLE DES MATIÈRES

4.2.4 Objectifaveccoûtsfixes....................................... 46

4.2.5 Variables entières en variables 0–1 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 47

4.2.6 Problèmederecouvrement ..................................... 49

4.3 Stratégiesderésolutions........................................... 50

4.3.1 Relaxationlinéaire.......................................... 50

4.3.2 Approcheparénumération ..................................... 52

4.3.3 Les hyperplans coupants (méthode de coupe) . . . . . . . . . . . . . . . . . . . . . . . . . . . 57

4.4 ModélisationavecGAMS .......................................... 58

4.5 Exercices ................................................... 62

4.6 Notes ..................................................... 62

5 Réseaux 63

5.1 Graphes.................................................... 63

5.1.1 Grapheorienté ............................................ 63

5.1.2 Graphenonorienté.......................................... 63

5.1.3 Transformations ........................................... 64

5.1.4 Cheminsetcircuits.......................................... 64

5.1.5 Connexité............................................... 64

5.2 Problème du chemin le plus court - algorithmes de corrections d’étiquettes . . . . . . . . . . . . . . . 65

5.2.1 AlgorithmedeDijkstra ....................................... 65

5.3 Flotdansunréseau ............................................. 67

5.3.1 Réseau................................................. 67

5.3.2 Modèledeflot ............................................ 67

5.3.3 AlgorithmedeBellman-Ford .................................... 68

5.3.4 Modèle du chemin critique (PERT/CPM) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 68

5.4 Problème de l’arbre partiel minimum . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 69

5.4.1 AlgorithmedePrim(1957) ..................................... 70

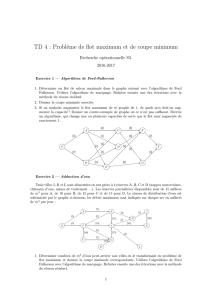

5.5 Problèmeduflotmaximum ......................................... 70

5.5.1 AlgorithmedeFord-Fulkerson.................................... 72

5.5.2 Flotmaximum-Coupeminimum.................................. 74

5.6 Problèmedeflotminimum.......................................... 76

5.7 Notes ..................................................... 76

6 Modèles stochastiques 77

6.1 Conceptsdebase............................................... 77

6.2 Variablealéatoire............................................... 78

6.2.1 Variables aléatoires discrètes . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 79

6.2.2 Variables aléatoires continues . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 79

6.2.3 Espérancemathématique ...................................... 79

6.2.4 Variance................................................ 80

6.3 Loideprobabilité............................................... 80

6.3.1 LoideBernouilli ........................................... 80

6.3.2 Loiuniforme ............................................. 80

6.3.3 LoidePoisson ............................................ 81

6.3.4 Loiexponentielle........................................... 81

6.4 Modèlesstochastiques ............................................ 81

6.4.1 Processusstochastiques ....................................... 81

6.4.2 ChaînesdeMarkov.......................................... 82

6.5 Notes ..................................................... 83

TABLE DES MATIÈRES v

7 Programmation dynamique 85

7.1 Principed’optimalitédeBellman...................................... 85

7.2 Affectationderessources........................................... 88

7.3 Programmation dynamique déterministe et plus court chemin . . . . . . . . . . . . . . . . . . . . . . 90

7.4 Casprobabiliste................................................ 90

7.5 Notes ..................................................... 92

8 Simulation 93

8.1 Introduction.................................................. 93

8.2 Filesd’attente................................................. 93

8.2.1 Conceptsdebase........................................... 93

8.2.2 Modèle M/M/1............................................ 94

8.3 Simulationàévénementsdiscrets ...................................... 96

8.4 Notes ..................................................... 96

Annexe 99

8.5 Logicielsd’optimisation ........................................... 99

8.5.1 IORTutorial ............................................. 99

8.5.2 GAMS................................................. 99

8.5.3 Autreslogiciels............................................105

8.6 Notes .....................................................105

Bibliographie 105

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

84

84

85

85

86

86

87

87

88

88

89

89

90

90

91

91

92

92

93

93

94

94

95

95

96

96

97

97

98

98

99

99

100

100

101

101

102

102

103

103

104

104

105

105

106

106

107

107

108

108

109

109

110

110

111

111

112

112

113

113

1

/

113

100%