TD : Les algorithmes pour le problème des bandits à K

TD : Les algorithmes pour le problème des bandits à

K-bras.

Enseignant: Antoine Bonnefoy

15 janvier 2014

1 Compromis Exploration/Exploitation

Pour un problème de bandit à K bras donné, il existe plusieurs algorithmes pour le résoudre.

Les deux premiers que nous utiliserons sont : l’algorithme -glouton et l’algorithme UCB1.

Nous verrons dans ce premier exercice comment est géré les compromis entre exploration et

exploitation dans ces algorithmes.

1.1 Algorithme -glouton

Question 1 : Rappelez l’algorithme -glouton.

Question 2 : De quel manière le paramètre influe sur le compromis exploration exploi-

tation dans l’algorithme.

Question 3 : Au fur et à mesure de l’avancement de l’algorithme l’estimation des récom-

penses moyennes respectives de chaque bras se précise. Comment faire pour limiter l’exploration

quand l’algorithme est déjà bien avancé ?

Question 4 : Selon vous comment doit évoluer quand le nombre de bras évolue ?

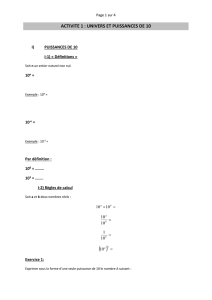

Question 5 : Les graphiques de la figure 1 confirment-ils votre intuition ? Comparer

l’efficacité d’un paramètre par rapport aux autres lorsque le nombre de bras augmente.

1.2 Algorithme UCB1

Notons

–µ∗= maxi(µi)

–∆j=µ∗−µj

–Nj(t)le nombre de fois que l’on a choisit le bras jjusqu’à l’instant t.

–Sj(t)La somme des récompenses obtenues sur le bras jjusqu’à l’instant t.

1

0 500 1000 1500 2000 2500 3000 3500 4000 4500 5000

0

20

40

60

80

100

120

140

Regret

Bandit à 3 bras

epsilon=0.005

epsilon=0.01

epsilon=0.05

epsilon=0.1

0 500 1000 1500 2000 2500 3000 3500 4000 4500 5000

0

20

40

60

80

100

120

140

160

180

Regret

Bandit à 5 bras

epsilon=0.005

epsilon=0.01

epsilon=0.05

epsilon=0.1

0 500 1000 1500 2000 2500 3000 3500 4000 4500 5000

0

50

100

150

200

250

Regret

Bandit à 10 bras

epsilon=0.005

epsilon=0.01

epsilon=0.05

epsilon=0.1

0 500 1000 1500 2000 2500 3000 3500 4000 4500 5000

0

50

100

150

200

250

300

350

400

450

Regret

Bandit à 100 bras

epsilon=0.005

epsilon=0.01

epsilon=0.05

epsilon=0.1

Figure 1 – Ces graphs représentent le regret en fonction du nombre d’iterations de

l’algorithme pour différents nombre de bras, et différents paramètre . Pour chacun des

graphs, les bras suivent tous une loi Bernoulli, un avec p= 0.9et les autres p= 0.5.

2

L’algorithme UCB1 se base sur l’équation suivante.

Lj(t) = Sj(t)

Nj(t)+s2 log n

Nj(t)(1)

Question 1 : Quel bras jchoisit l’algorithme UCB1 ?

Question 2 : Dans l’équation (1) quelle partie correspond à l’exploitation et quelle partie

à l’exploration ? Proposer alors une variante de UCB1 qui permet de régler le compromis

exploration/exploitation.

Question 3 : La borne sur le regret pour UCB1 s’écrit sous la forme :

Rn≤c1Clog n+c2

où C=X

j,µj6=µ∗

1

∆j

Quels sont, d’après cette equation, les problèmes de bandits difficiles à résoudre ?

2 Étude du regret d’une stratégie simple

Nous allons étudier une stratégie simple pour résoudre le problème des bandits à 2-bras.

Chacun des 2 bras suit une loi de Bernoulli de paramètre µ1,µ2avec µ1> µ2>0.

Rappel : Un tirage selon la loi de Bernoulli de paramètre pdonne 1avec une probabilité p

et 0avec une probabilité 1−p. Plus formellement une variable Xaléatoire suivant une loi de

Bernoulli de paramètre pvérifie :

P(X= 1) = p

P(X= 0) = 1 −p

Notations :

–∆ = µ1−µ2>0

–I(t)le numéro du bras choisit au temps t

–Xj(t)la récompense obtenu au temps tsur le bras j. On considère une récompense

nulle si le bras jn’est pas choisit.

–Nj(t)le nombre de fois que l’on a choisit le bras jjusqu’à l’instant t.

La stratégie : Soit m, t ∈Ntels que t≥2m. pour les mpremiers coups on choisit le bras

1, pour les mcoups suivant on prend le bras 2. Cela revient à faire

I(1) =... =I(m) = 1

I(m+ 1) =... =I(2m) = 2

On définit alors ˆµ1,ˆµ2, les moyennes empiriques observées au temps t= 2m.

ˆµ1=P2m

t=1 X1(t)

N1(2m)=P2m

t=1 X1(t)

m

ˆµ2=P2m

t=1 X2(t)

N2(2m)=P2m

t=1 X2(t)

m

Pour les coups restant t≥2mon jouera toujours le bras qui a la plus grande moyenne

empirique.

∀t≥2m, I(t) = (1si ˆµ1≥ˆµ2

2si ˆµ1≤ˆµ2

(2)

3

Question 1 : Rappelez la définition du regret.

Question 2 : Exprimez Rtquand t= 2m.

Question 3 : Utilisez l’inégalité de Chernoff-Hoeffding et ∆pour trouver un majorant

pour la probabilité P(ˆµ1≤ˆµ2), qui représente la probabilité que les moyennes empiriques ne

soient pas dans le même ordre que les vraies moyennes µ1> µ2.

Inégalité de Hoeffding-Chernoff appliqué à notre cas : Pour tout a > 0

(P(ˆµj≥µj+a)≤exp(−2a2m)

P(ˆµj≤µj−a)≤exp(−2a2m)

Question 4 : Trouver un majorant de Rtquand t≥2mà l’aide de la question 2 et de

P(ˆµ1≤ˆµ2)

Question 5 : Supposons à présent qu’il existe c1, c2tel que 2∆2≤c1< c2et

c1log(t)≤m≤c2log(t).

Montrez que le regret verifie : Rt=O(log t)

Question 6 : Que signifie cette borne sur le regret ?

3 Liste chainée et structure

Question 1 : Définissez une structure animal qui contiendra un champ position pos,

position est un type basé sur une structure que vous définirez, et energie un entier entre 0

et 100. Cette structure est destinée à être utilisée sous forme de liste, ajoutez le/les champs

nécessaires dans ce but.

Question 2 : Dessinez une liste d’éléments de cette structure, avec un élément vide que

l’on appelle sentinelle servant uniquement à pointer vers le premier élément de la liste.

Question 3 : Écrire la fonction qui ajoute un élément en tête de liste. La liste contient

au moins la sentinelle. Pensez bien à l’allocation de la mémoire.

Question 4 : Écrire la fonction qui enlève un élément en fin de liste. Attention au cas ou

la liste ne contient que la sentinelle.

Question 5 : Écrire la fonction qui cherche les deux animaux de la liste qui sont les plus

proches l’un de l’autre.

4

1

/

4

100%